前言 本篇文章介绍来自大连理工大学的论文Multi-interactive Feature Learning and a Full-time Multi-modality Benchmark for Image Fusion and Segmentation,收录于 ICCV 2023 Oral,研究用于图像融合和分割的多交互特征学习和全时多模态基准。

来源:我爱计算机视觉

仅用于学术分享,若侵权请联系删除

- 文章链接:https://arxiv.org/pdf/2308.02097.pdf

- 论文作者:Jinyuan Liu, Zhu Liu, Guanyao Wu, Long Ma, Risheng Liu, Wei Zhong, Zhongxuan Luo, and Xin Fan

- 代码链接:https://github.com/JinyuanLiu-CV/SegMiF

引言

实现感知友好的视觉表达和精确的语义理解是多模态图像融合的两大基本目标。现有大部分方法都仅考虑提升融合图像的视觉效果,忽略了对下游高级视觉任务的支持。目前也有一些研究尝试通过级联融合与感知网络设计联合框架,结合加权损失函数实现端到端学习。

本文认为这些方案仍存在两个核心挑战:

- 同时为视觉感知与语义理解任务寻找合适的特征是非常困难的。

- 现有的多模态数据集仅关注图像融合效果,或者缺少与图像对应的分割标签,为融合与分割任务的探索带来阻碍。

为了解决上述问题,我们提出了一个语义特征引导多交互式特征学习架构:SegMiF (Multi-interactive Feature learning architecture for image fusion and Segmentation)。

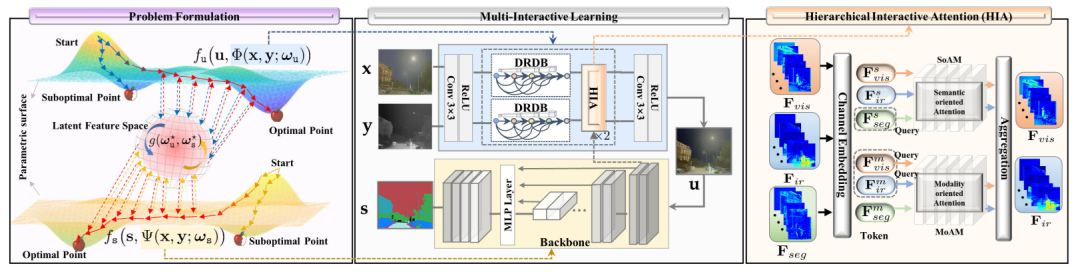

该网络结构包括融合子网络与分割子网络以及分层交互注意力块 Hierarchical Interactive Attention (HIA)。通过引入多任务动态权重因子实现对融合特征自适应学习。

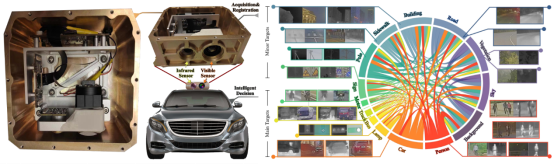

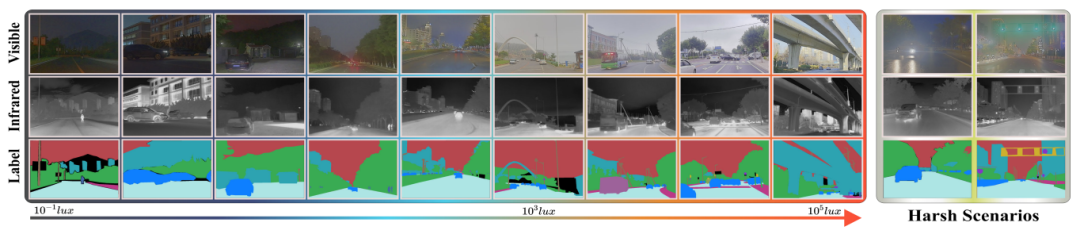

另外,我们还构建了市面上最全标注率(98.16%),高精度配准,15 个类别涵盖多种挑战场景的多模态语义分割数据集 Full-time Multi-modality Benchmark (MFB)。

方法

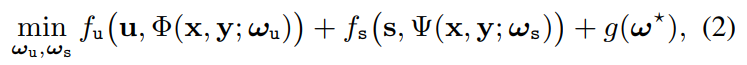

为了实现融合与后续感知任务的统筹兼顾,本文将融合与分割任务的求解联合定制为一个优化目标:

其中 g(·) 是联合优化两个任务约束项,我们通过分层注意力 (HIA) 来实现这一目标。

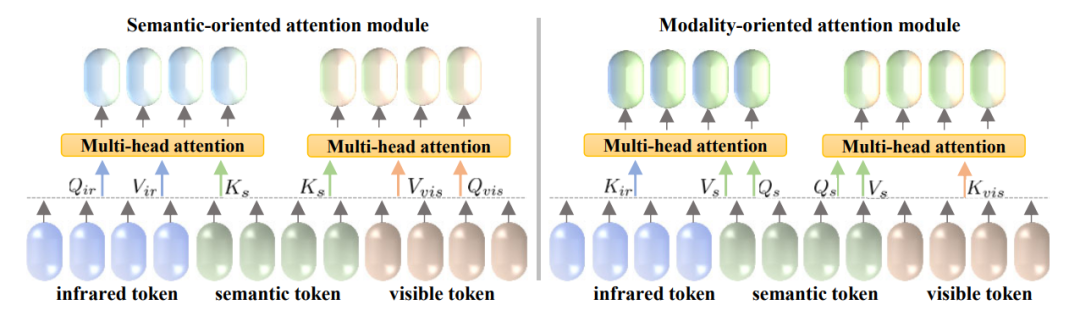

分层注意力机制 HIA 可以构建模态特征 , 和分割特征 的精细映射,从而使模态/语义特征能够完全相互作用,具体如下图所示:

分层注意力机制包括面向语义与面向模态的两类注意力机制,通过引入语义信息,提出机制可以实现融合特征对下游任务的高效表达。

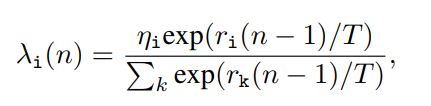

通过观察损失值的下降速率以优化网络的收敛过程,本文引入了任务动态权重因子来自动调整每个任务间相应权重,从而平衡交互特征对应关系,克服了繁琐的手工调整。通过下述公式实现第i个任务的动态权重设置:

此外,我们构建了一个智能多波段双目成像系统,并收集了一个用于融合和分割且内有15个像素级类别注释的多模态场景解析数据集。该数据集标注率高达98.16%,包含在不同光照条件下的各种真实驾驶场景,还包括带有雨、雾、强光等特殊情况的挑战场景。所提出的数据集克服了领域现存数据类别较少、注释稀疏和场景单调的问题,旨在促进实际的自动驾驶和语义理解任务的发展。

实验

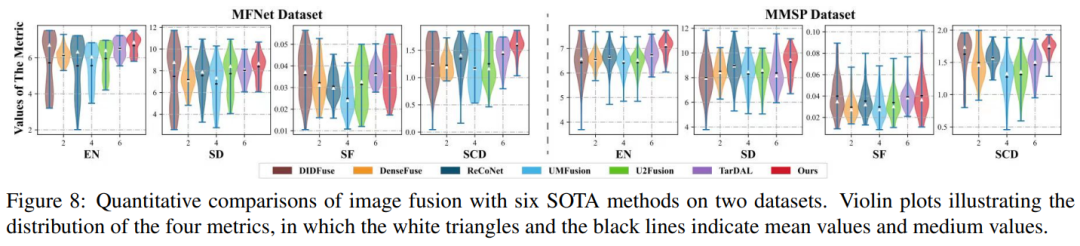

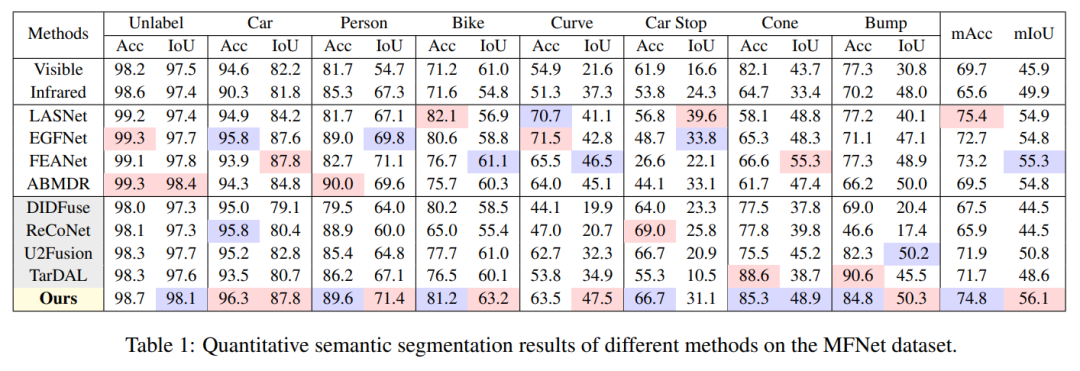

定量实验

我们在四个指标(EN,SD,SF与SCD)取得了一致的优势,其中最高的 EN 和 SD 表明我们的方法能够显著地保留源图像的大量信息,并拥有较高的像素对比度。

我们在 MFNet 和 MFB 数据集上都取得了最高的 mIoU,与第二名相比提高了 7.66%。同时注意到我们的方法对于人和车的优越结果意味着我们的方法在应用于现实世界感知时有更高的性能。

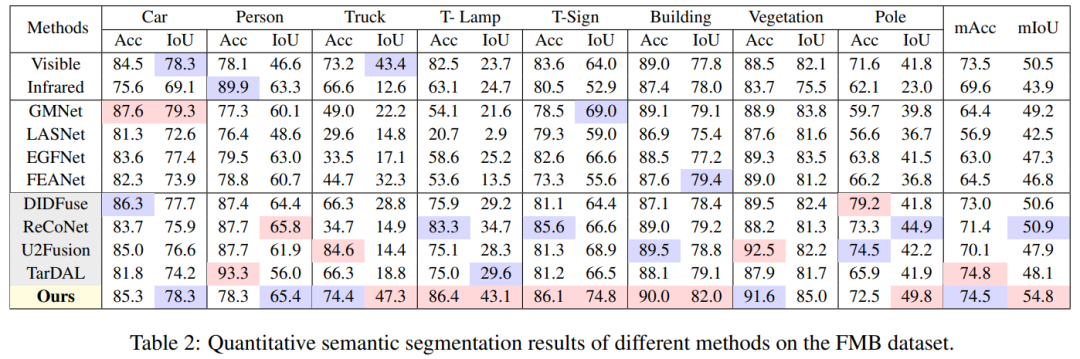

定性实验

在视觉效果上,本文方法可以有效克服各类可见光降质因素的影响,例如强光干扰与极暗成像条件。一方面本文方法有效提取显著红外目标,例如第一行的行人。另一方面,本文方法可以有效保存纹理细节,更有利于后续语义分割任务。

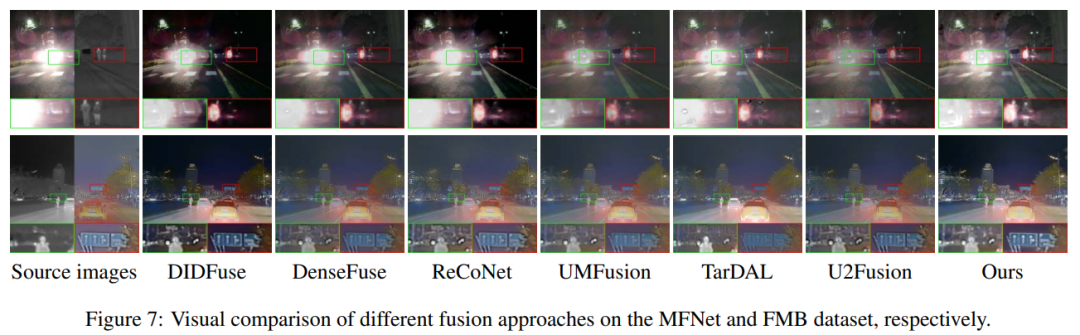

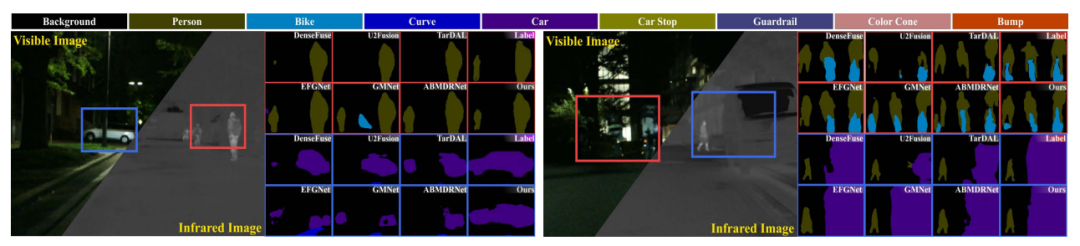

MFNet 和 MFB 数据集上分割的可视化结果如上图所示。本文方法不仅在现有稀疏标注数据集提升明显,也能够有效解决新数据集上各类复杂成像条件的影响。

若觉得还不错的话,请点个 “赞” 或 “在看” 吧

全栈指导班

全栈指导班面向的是真正想从事CV的、想培养自己的能力和知识面的、具备算法工程师思维的朋友。有很多朋友仅仅了解自己的科研方向、仅仅了解YOLO怎么用,做过几个简单的项目,但从没系统地学过CV,也没有重视培养自己的学习能力和思维能力。也有很多朋友想找目标检测的岗位、医学图像的岗位,但实际上哪个企业招聘上写目标检测工程师呢?写的都是算法工程师,一个合格的算法工程师需要能快速上手任意一个新的方向,这意味着需要广泛大知识面、扎实的基础、很强的自学能力。知识面太少,谈何设计模型?不会看论文,谈何学习能力?因此,对于全栈班而言,如何培养上面这三点是非常重要的。这也意味着它与基础入门班不同之处在于全栈班更注重培养方法、能力以及知识面。内容范围:全栈。包括基础、代码能力、模型设计分析、目标检测、数字图像处理、部署等全流程。说明:虽然看起来跟基础入门班内容没什么区别,但实际每个内容涉及更深、范围更广、要求更高,且包含部署方面的学习和能力培养。比如同样的模型设计,基础班只要求掌握十几个模型的设计思路,全栈班会要额外推荐一些重要的论文去学、要求效率更高,且基础班是老师直接讲,而全栈班是学员先自主学再指导,前者是入门、后者是深入学习。如果你本身是一个基础很好的,仅仅想学习部署方面的内容,也可以报名,我们会针对你的个人情况,单独设计部署方面的学习计划,安排有六年部署工作经验的大佬给你指导。课程形式:50%学员自主学习+50%的方法、能力的指导培养。可以理解为报了一个全栈班,就是找了两个大佬对你进行二对一指导,但仍然是你自己自学。

报名请扫描下方二维码,备注:“全栈班报名”

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง