导语

在今天数据驱动的时代,人工智能(AI)已经渗透到了各行各业,包括地理学和城市科学。与之相应的,人们也不断进行着人工智能可解释性的研究,以期望更好地理解人工智能模型在其决策过程中所做出的选择。在地理学和城市科学领域,通过解释和可视化AI模型的工作原理和决策过程,可解释人工智能(XAI)不仅提高了模型的准确性、透明度和可理解性,更帮助我们将人工智能更好地应用于城市管理领域,从而提高城市运营效率和居民的幸福指数。

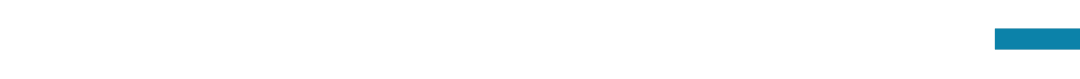

“复杂系统视角下的城市科学”读书会的第十次分享,我们邀请到了佛罗里达州立大学地理系助理教授李子奇老师以《可解释人工智能(XAI)和地理学》为题,深入探讨XAI于地理学的结合,关注XAI的关键技术、挑战和未来发展方向,并讨论其在解决实际问题方面的优势和局限性。通过这些讨论,我们可以更全面地了解XAI在地理学中的应用前景,并探讨其对社会、环境和经济的影响。

集智俱乐部的“城市科学”读书会由北京大学助理教授董磊联合明尼苏达大学助理教授朱递、中南大学地球科学与信息物理学院教授李海峰、北京航空航天大学计算机学院博士寄家豪共同发起,通过对“城市作为复杂系统”的理论、研究方法及应用的分享、讨论和梳理,促进相关领域学者的交流,推动交叉学科间的合作,促进城市科学的发展和研究。本系列读书会线上进行,2023年7月1日开始,每周六晚 20:00-22:00,持续时间预计10周。欢迎对城市科学这一前沿领域有兴趣的朋友报名参与!

分享简介

本期读书会,李子奇老师将在介绍可解释人工智能(XAI)的发展背景和方法的基础上,将XAI与地理学结合,探讨XAI为地理学带来的机遇与挑战。

- 第一部分介绍可解释人工智能(XAI)。人工智能(AI)已经为众多领域带来了巨大的变革,但是AI的决策过程往往难以理解,这使得AI的推广以及在重要领域的应用成为一个严峻的问题,可解释人工智能(Explainable AI, XAI)就是解决这个问题的关键。首先介绍可解释人工智能的概念,并追溯其历史,然后介绍可解释人工智能的重要性及社会意义。

- 第二部分介绍可解释人工智能的方法。第一种常见的分类方法是模型相关/模型无关,即是否依赖并剖析模型内部机制。第二种常见的分类方法是全局/局部方法,即针对模型整体或局部个体的预测进行解释。并将结合实际应用对以上方法进行讲解。

- 第三部分介绍可解释人工智能与地理学。首先介绍地理学对空间和地理位置的关注;之后介绍AI与传统地理模型的统一;最后通过对可解释人工智能在地理学中的应用案例的介绍,说明可解释人工智能可以提高地理学模型的准确性,从而提高预测的准确度。

- 第四部分阐述可解释人工智能带来的机遇与挑战。可解释人工智能可以帮助人们更好地理解和评估GeoAI的性能,提高GeoAI的可信赖度,从而降低人们对GeoAI的担忧,也有助于解决一些应用领域中的偏见问题,从而促进公平性。然而,可解释人工智能也面临着一些挑战,例如,XAI所带来的模型解释的复杂性,对模型描述的准确度,以及可视化等问题。

分享大纲

一、可解释人工智能(XAI)

- 什么是Explainable AI(XAI)

- 历史

- 重要性及社会意义

二、XAI的方法介绍

- 模型相关/无关

- 全局/局部方法

三、XAI与地理学

- 地理学的关注点

- AI与传统地理模型的统一

- XAI在地理学的应用

四、机遇与挑战

- XAI为GeoAI带来的机遇

- XAI的当前挑战与未来发展

核心概念

-

可解释人工智能 Explainable AI:简称XAI,又称可解释的机器学习(Interpretable Machine Learning),是一套流程和方法,让人类用户描述人工智能模型,了解其预期影响和潜在偏差。它有助于理解并敦促人工智能决策模型的准确性、公平性以及透明度。XAI及其应用在科学和实际社会中中有很大的重要意义。

主讲人介绍

李子奇是佛罗里达州立大学(FSU)地理系助理教授,曾任英国格拉斯哥大学助理教授和伊利诺伊大学厄巴纳-香槟分校(UIUC)客座助理教授,是多尺度地理加权回归(MGWR)和Python空间分析库(PySAL)的主要开发人员之一。研究兴趣:空间显式统计和机器学习模型的方法开发及在地理学中的应用,开源软件开发。个人主页https://sites.google.com/view/ziqi-li/home。

李子奇是佛罗里达州立大学(FSU)地理系助理教授,曾任英国格拉斯哥大学助理教授和伊利诺伊大学厄巴纳-香槟分校(UIUC)客座助理教授,是多尺度地理加权回归(MGWR)和Python空间分析库(PySAL)的主要开发人员之一。研究兴趣:空间显式统计和机器学习模型的方法开发及在地理学中的应用,开源软件开发。个人主页https://sites.google.com/view/ziqi-li/home。

直播信息

时间:2023年9月9日(本周六)晚上20:00-22:00

参与方式:

扫码参与复杂系统视角的城市科学读书会,加入群聊,获取系列读书会回看权限,成为城市科学社区的种子用户,与社区的一线科研工作者与企业实践者沟通交流,共同推动城市科学社区的发展。

参考文献

一、可解释人工智能(XAI)

-

Molnar (2020). Interpretable machine learning: a guide for making black box models explainable. https://christophm.github.io/interpretable-ml-book/

-

Royal Society. (2019). “Explainable AI: the basics‐Policy briefing.” https://royalsociety.org/-/media/policy/projects/explainable-ai/AI-and-interpretability-policy-briefing.pdf

-

Gunning, D., & Aha, D. (2019). DARPA’s explainable artificial intelligence (XAI) program. AI magazine, 40(2), 44-58. https://doi.org/10.1609/aimag.v40i2.2850

-

Goodman, B., & Flaxman, S. (2017). European Union regulations on algorithmic decision-making and a “right to explanation”. AI magazine, 38(3), 50-57. https://doi.org/10.1609/aimag.v38i3.2741

-

Murdoch, W. J., Singh, C., Kumbier, K., Abbasi-Asl, R., & Yu, B. (2019). Definitions, methods, and applications in interpretable machine learning. Proceedings of the National Academy of Sciences, 116(44), 22071-22080. https://doi.org/10.1073/pnas.1900654116

-

Das, A., & Rad, P. (2020). Opportunities and challenges in explainable artificial intelligence (xai): A survey. arXiv preprint arXiv:2006.11371. https://doi.org/10.48550/arXiv.2006.11371

-

Arrieta, A. B., Díaz-Rodríguez, N., Del Ser, J., Bennetot, A., Tabik, S., Barbado, A., … & Herrera, F. (2020). Explainable Artificial Intelligence (XAI): Concepts, taxonomies, opportunities and challenges toward responsible AI. Information fusion, 58, 82-115. https://doi.org/10.1016/j.inffus.2019.12.012

二、XAI的方法介绍

-

Lundberg, S. M., & Lee, S. I. (2017). A unified approach to interpreting model predictions. Advances in neural information processing systems, 30. https://doi.org/10.5555/3295222.3295230

-

Lundberg, S. M., Erion, G., Chen, H., DeGrave, A., Prutkin, J. M., Nair, B., … & Lee, S. I. (2020). From local explanations to global understanding with explainable AI for trees. Nature machine intelligence, 2(1), 56-67. https://doi.org/10.1038/s42256-019-0138-9

-

Ribeiro, M. T., Singh, S., & Guestrin, C. (2016, August). ” Why should i trust you?” Explaining the predictions of any classifier. In Proceedings of the 22nd ACM SIGKDD international conference on knowledge discovery and data mining (pp. 1135-1144). https://doi.org/10.1145/2939672.2939778

-

Sundararajan, M., Taly, A., & Yan, Q. (2017, July). Axiomatic attribution for deep networks. In International conference on machine learning (pp. 3319-3328). PMLR. https://doi.org/10.5555/3305890.3306024

-

Selvaraju, R. R., Cogswell, M., Das, A., Vedantam, R., Parikh, D., & Batra, D. (2017). Grad-cam: Visual explanations from deep networks via gradient-based localization. In Proceedings of the IEEE international conference on computer vision (pp. 618-626). https://doi.org/10.1109/ICCV.2017.74

-

Covert, I., Lundberg, S. M., & Lee, S. I. (2020). Understanding global feature contributions with additive importance measures. Advances in Neural Information Processing Systems, 33, 17212-17223. https://doi.org/10.5555/3495724.3497168

三、XAI与地理学 & 四、机遇与挑战

-

Fotheringham, A. S. (1997). Trends in quantitative methods I: stressing the local. Progress in human geography, 21(1), 88-96. https://doi.org/10.1191/030913297676693207

-

Fotheringham, A. S., Brunsdon, C., & Charlton, M. (2003). Geographically weighted regression: the analysis of spatially varying relationships. John Wiley & Sons.

-

Fotheringham, A.S., Oshan, T.M., & Li, Z. (2023). Multiscale Geographically Weighted Regression: Theory and Practice (1st ed.). CRC Press.

-

Li, Z. (2022). Extracting spatial effects from machine learning model using local interpretation method: An example of SHAP and XGBoost. Computers, Environment and Urban Systems, 96, 101845. https://doi.org/10.1016/j.compenvurbsys.2022.101845

-

Parsa, A. B., Movahedi, A., Taghipour, H., Derrible, S., & Mohammadian, A. K. (2020). Toward safer highways, application of XGBoost and SHAP for real-time accident detection and feature analysis. Accident Analysis & Prevention, 136, 105405. https://doi.org/10.1016/j.aap.2019.105405

-

Hsu, C. Y., & Li, W. (2023). Explainable GeoAI: can saliency maps help interpret artificial intelligence’s learning process? An empirical study on natural feature detection. International Journal of Geographical Information Science, 37(5), 963-987. https://doi.org/10.1080/13658816.2023.2191256

-

Xing, J., & Sieber, R. (2023). The challenges of integrating explainable artificial intelligence into GeoAI. Transactions in GIS. https://doi.org/10.1111/tgis.13045

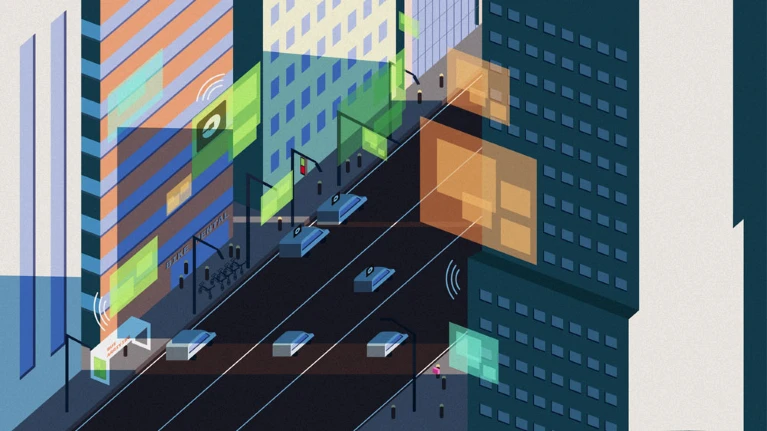

因果科学读书会第一季

由集智俱乐部社区成员龚鹤扬、高亦斌和郭瑞东等人共同发起,从2020年8月26日到2021年1月2日,共有崔鹏、周晓华等老师同学在内的32位讲者,分享了32个不同的主题,B站人气累积10万+,来自海内外不同高校或者企业的一线科研工作者273名,因果读书会借助集体智慧,在100多天的时间里,撬动了数十万人次的共同参与,形成了一场因果科学风暴!

详情请见:

城市科学读书会启动

随着工业化和现代化的发展,世界范围内的城市化率不断提高,越来越多的人口聚集在城市,使得交通拥堵、环境污染、资源短缺等城市问题日益严峻。为了建设一个让人们幸福生活、可持续发展的城市,我们对于城市的基本运行规律迫切需要科学的认知。

近十几年来,数据获取手段的进步及计算技术的发展,为研究城市问题提供了新的机会。智能手机、物联网、卫星遥感使我们可以获取高精度的城市数据,提供了数据基础;机器学习、人工智能的发展,为处理大规模多源异构数据提供了技术手段。

除了数据与方法外,复杂性科学(Complexity)也极大地推动了城市科学的跨学科发展。复杂性科学从演生的视角,在不同的时空尺度上研究城市现象的基础规律,丰富了城市科学的理论框架;同时,基于复杂系统的模拟方法也在实践中有广阔的应用前景。

在这个大背景下,集智俱乐部的“城市科学”读书会由北京大学助理教授董磊联合明尼苏达大学助理教授朱递、中南大学地球科学与信息物理学院教授李海峰、北京航空航天大学计算机学院博士寄家豪共同发起,通过对“城市作为复杂系统”的理论、研究方法及应用的分享、讨论和梳理,促进相关领域学者的交流,推动交叉学科间的合作,促进城市科学的发展和研究。

本系列读书会线上进行,2023年7月1日开始,每周六晚 20:00-22:00,持续时间预计10周。读书会详情及参与方式见后文。

详情请见:城市科学读书会启动:AI与因果交织的城市复杂系统

点击“阅读原文”,报名读书会

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง