Physically Grounded Vision-Language Models for Robotic Manipulation

J Gao, B Sarkar, F Xia, T Xiao, J Wu, B Ichter, A Majumdar, D Sadigh

[Stanford University & Google DeepMind & Princeton University]

面向机器人操纵的物理接地视觉语言模型

-

现有的视觉语言模型在对日常物品进行物理推理方面的能力非常有限,这限制了它们在机器人操纵任务中的应用。

-

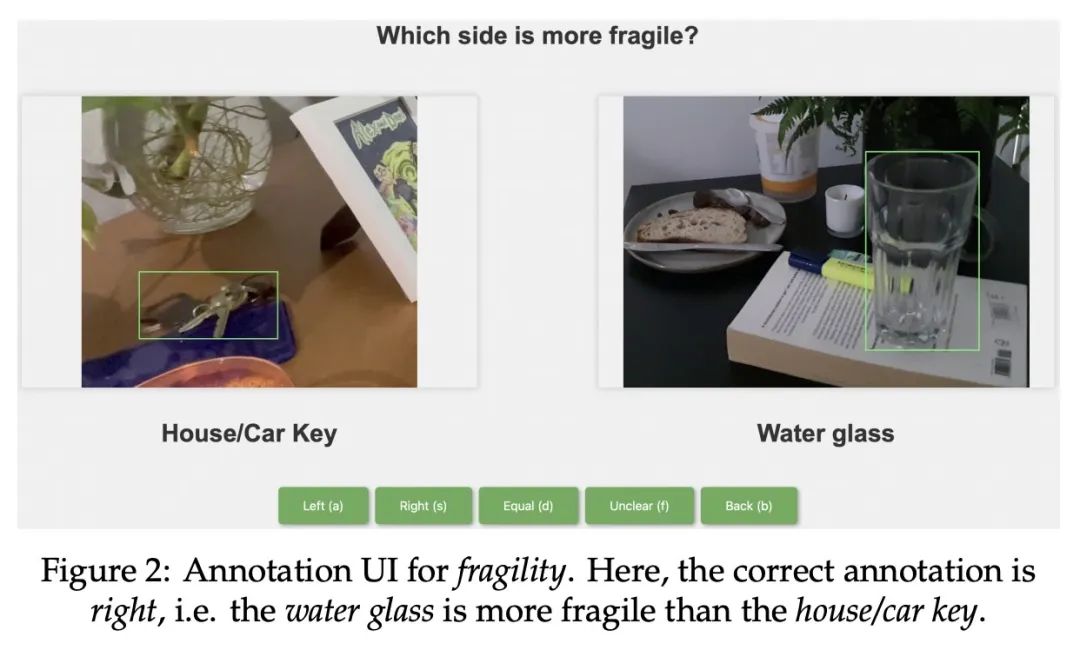

提出PhysObjects数据集,包含36.9万个众包标注和417万个自动标注的家用物品图像及其物理概念标注,概念包括质量、脆性、可变形性、材质等。

-

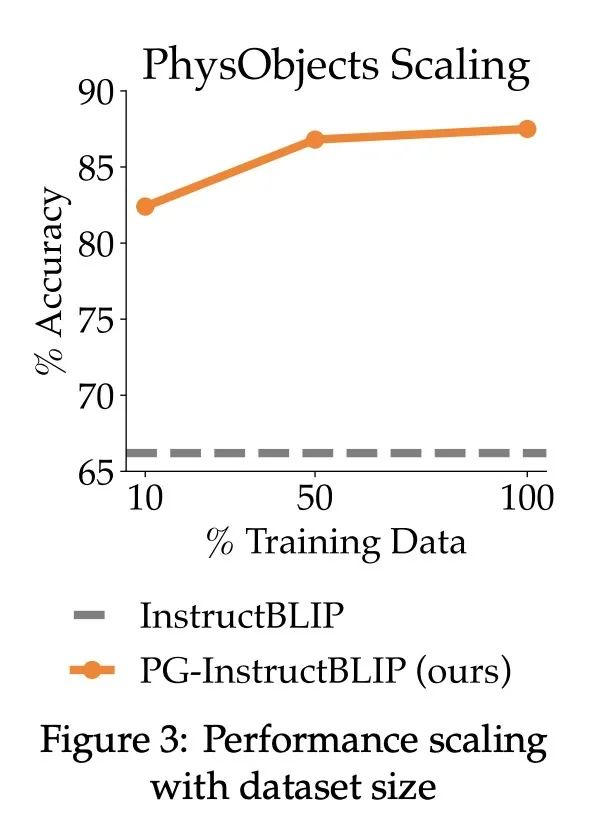

在PhysObjects数据集上微调视觉语言模型可以显著提高其在未见数据上的物理推理能力。

-

将微调过的具有物理知识的视觉语言模型和大型语言模型规划器结合,可以提高实际场景中的物理推理规划任务的性能。

-

在实际机器人上使用微调过的视觉语言模型也可以提高任务成功率。

-

本文工作证明了使用人工标注数据来提高视觉语言模型对物品物理特性的理解,可以显著地提升机器人规划和操作的能力。

动机:针对当前视觉-语言模型(VLM)在物理世界推理方面的限制,尤其是对常见物体的物理概念(如材料、脆性)的理解不足,这限制了它们在涉及与这些对象的交互和物理推理的机器人操作任务中的实用性。因此,研究者提出PhysObjects,这是一个包含36.9K众包和417K自动化物理概念标注的常见家居物品的物体为中心的数据集,以解决这一限制。

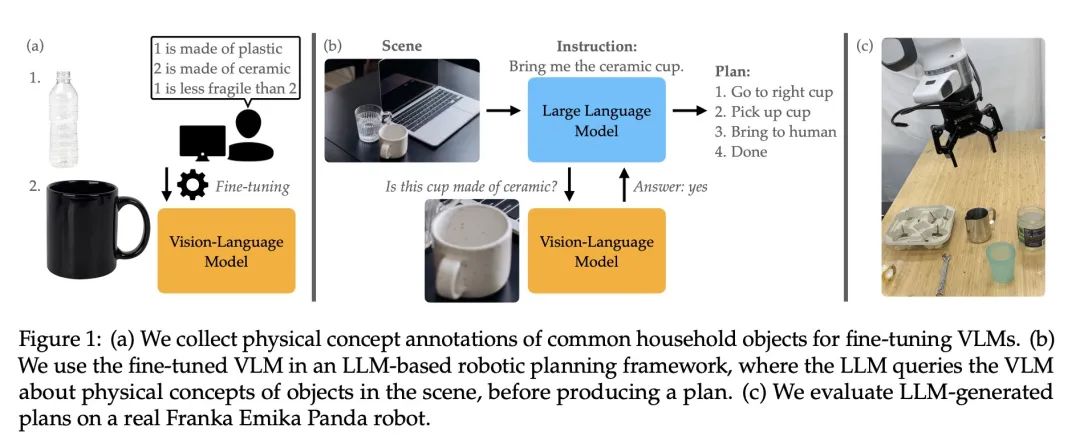

方法:本论文的方法包括使用PhysObjects数据集来对VLM进行微调,从而提高其对物理物体概念的理解,以捕捉这些概念的视觉外观方面的人类先验知识。此外,研究者还将这个物理基础的VLM与基于大型语言模型的机器人规划器相结合,以改进需要推理物理物体概念的任务的规划性能。

优势:通过使用PhysObjects数据集来提高视觉-语言模型的物理推理能力,从而增强了机器人操作任务的规划性能。研究者还展示了在真实机器人上使用物理接地VLM的好处,提高了任务成功率。此外,该方法的通用性和灵活性消除了在物理推理中使用单独的任务特定视觉模型的需要,使其成为为机器人规划赋予物理推理的自然解决方案。

提出PhysObjects数据集,通过微调视觉-语言模型,显著提高了对物理物体概念的理解,进而改进了机器人规划性能,为扩展VLM在机器人领域的应用性取得了进展。

https://iliad.stanford.edu/pg-vlm/

https://arxiv.org/abs/2309.02561

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง