Efficient RL via Disentangled Environment and Agent Representations

K Gmelin, S Bahl, R Mendonca, D Pathak

[CMU]

通过环境和智能体表示的解缠实现高效强化学习

- 提出一种称为SEAR的方法,用于在强化学习中学习区分环境和智能体的解耦表示。

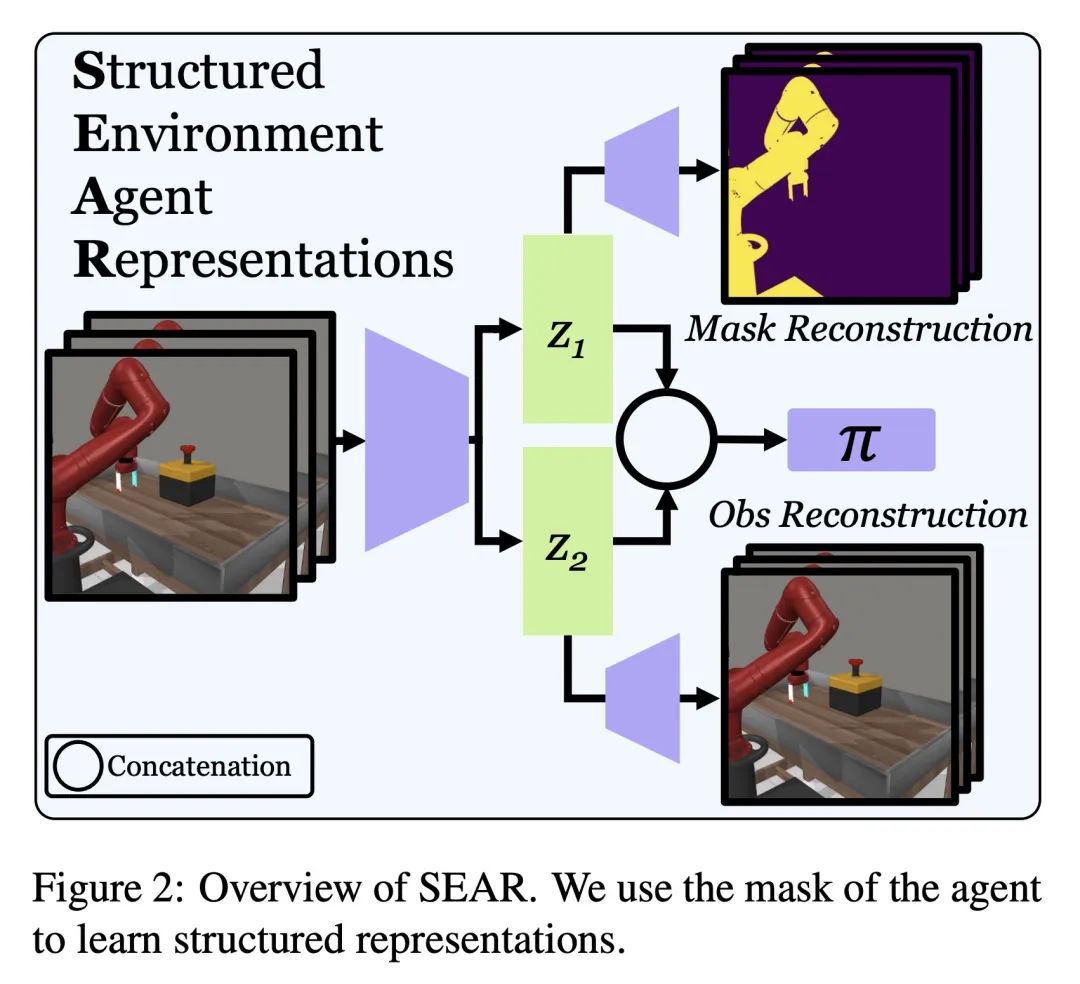

- SEAR利用关于智能体的知识,例如其形状或掩模,通过辅助损失将其融入RL目标中,有助于学习的表示区分智能体相关和环境相关的方面。

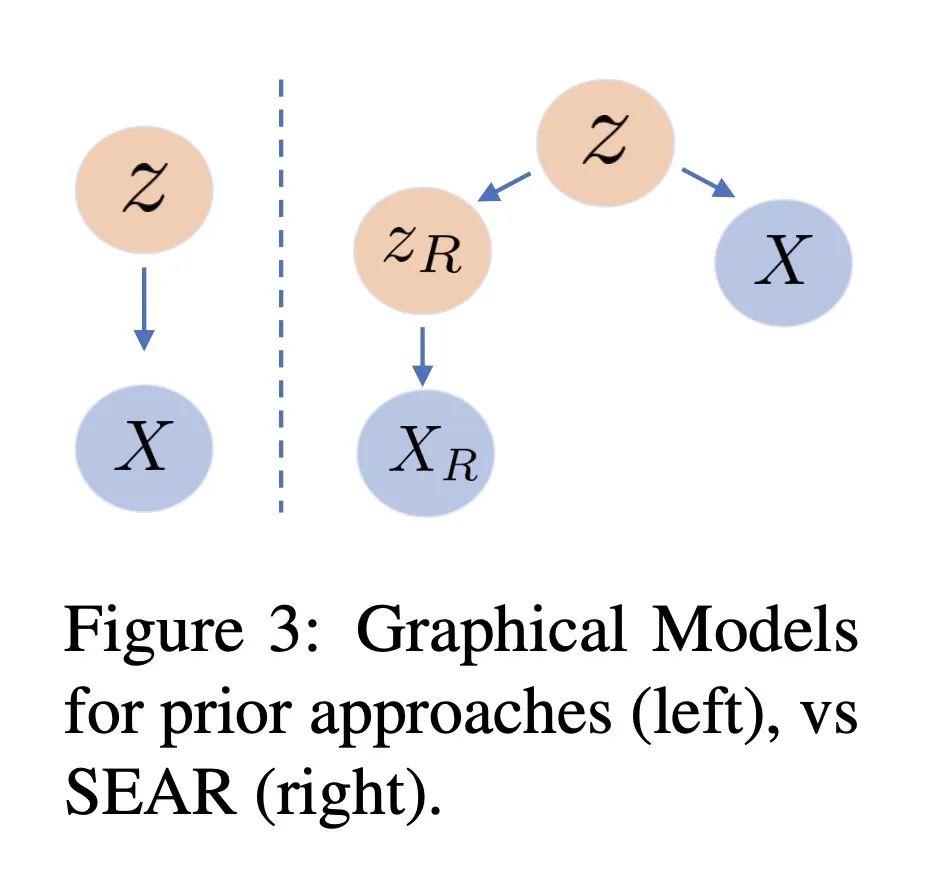

- 在数学上,SEAR将潜在状态z建模为由zR(智能体相关)和zE(环境相关)组成,zR经训练可以重构智能体掩模,而z可以重构整个图像。

- SEAR基于DrQv2 RL算法,修改其编码器并添加掩模和重构解码器。

- SEAR在跨越5种不同机器人的18个模拟机器人环境上进行评估,其中大多数任务上优于之前的无模型强化学习方法,包括DrQv2和SAC-AE。

- SEAR的优势包括改进的样本效率、可解释性和迁移学习能力。

- SEAR展示了在RL中加入关于智能体形态的廉价先验知识的益处。

动机:研究如何通过学习结构化环境和智能体表示来提高强化学习的效率。

方法:提出一种名为结构化环境-智能体表示(SEAR)的方法,通过使用智能体的视觉知识,如其形状或掩膜,将其纳入强化学习目标中。这种方法通过简单的辅助损失将智能体与环境分离,从而实现了结构化表示的学习。

优势:SEAR方法在18个不同的视觉仿真环境和5种不同的机器人上优于现有的无模型方法,提高了强化学习的效果。

提出一种通过学习结构化的环境和智能体表示来提高强化学习效率的方法,取得了显著的性能提升。

https://arxiv.org/abs/2309.02435

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง