Explaining grokking through circuit efficiency

V Varma, R Shah, Z Kenton, J Kramár, R Kumar

[Google DeepMind]

通过回路效率解释grokking现象

-

本文提出,grokking发生在存在两族实现良好训练性能的回路时:一族是记忆化回路Cmem,测试性能差;一族是泛化回路Cgen,测试性能好。

-

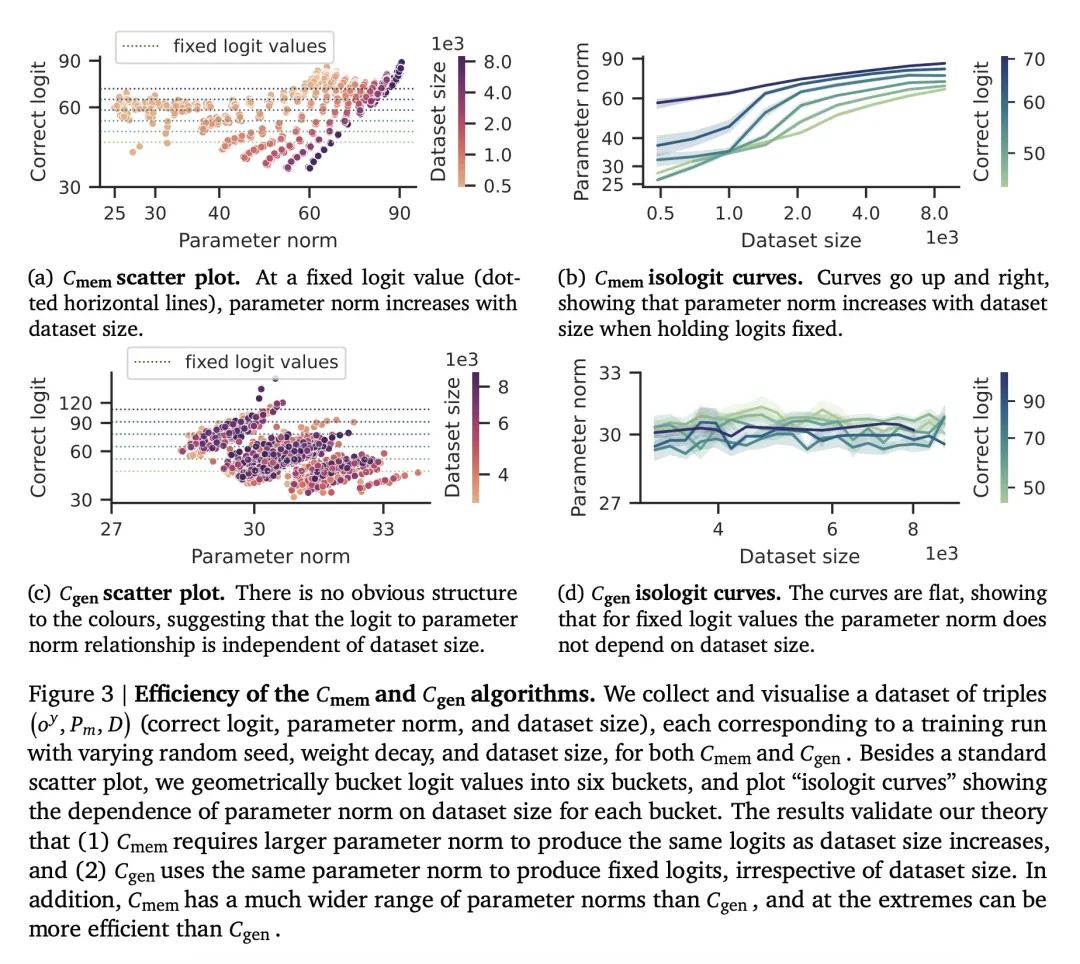

Cgen假设比Cmem更“高效”,意味着它能以更低的参数范数在训练集上产生等效的交叉熵损失,这使得权重衰减更偏爱Cgen而不是Cmem。

-

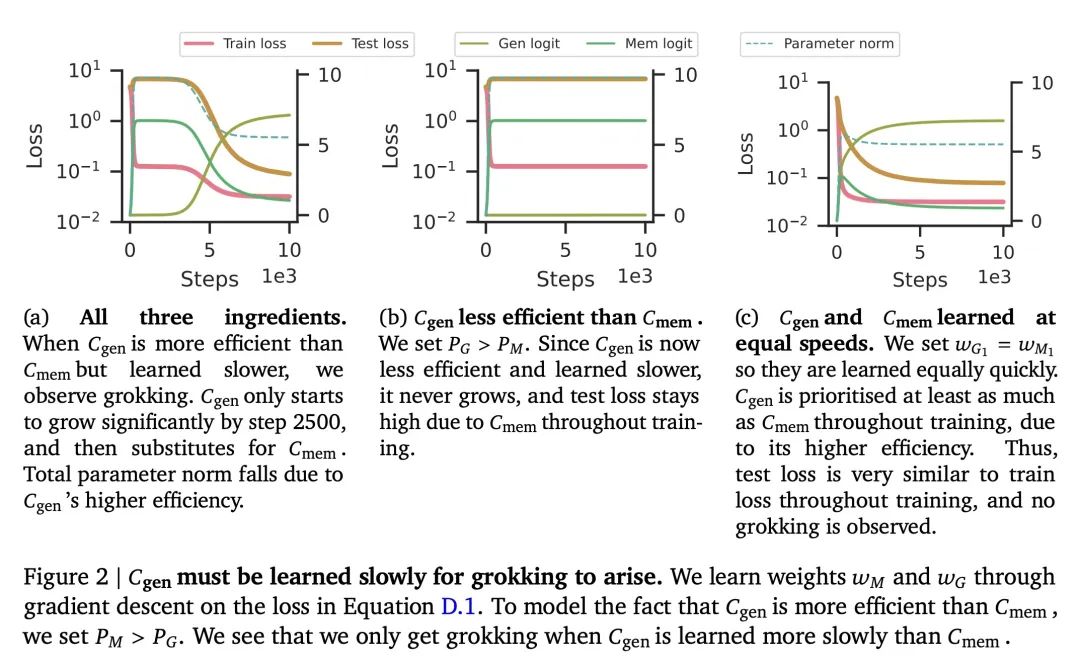

Cgen的学习速度比Cmem慢,在训练的早期阶段Cmem更强,导致最初的记忆化。

-

通过一个最小的模拟显示这3个要素足以产生grokking。

-

本文预测并确认了一个“关键数据集大小”Dcrit,低于它Cmem更高效,高于它Cgen更高效。

-

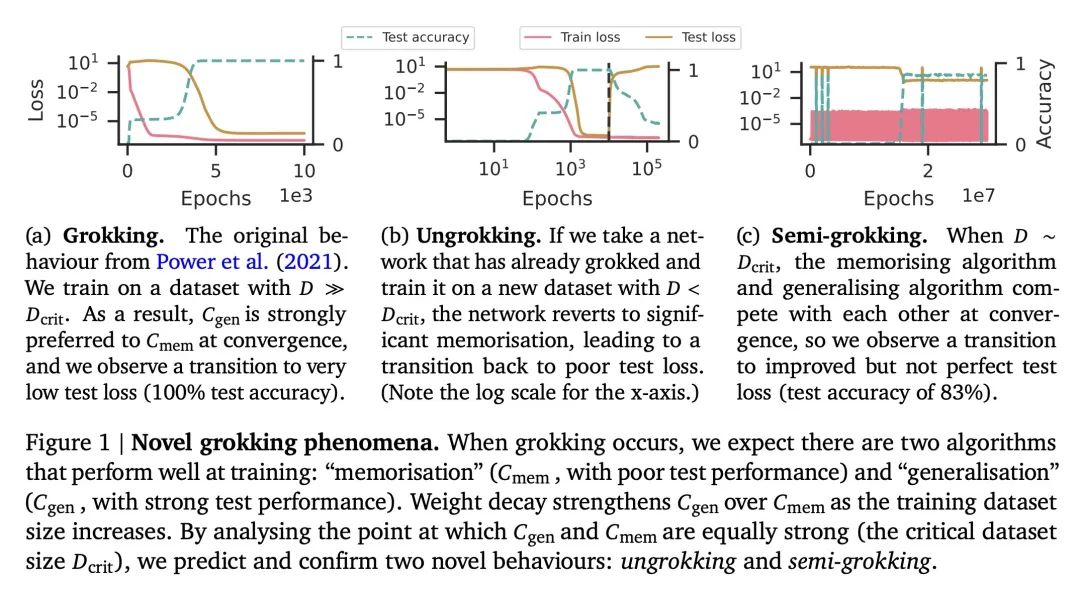

分析Dcrit附近的动态导致了“反悟性”(ungrokking)和“半悟性”(semi-grokking)的新预测,并经实验确认。

-

ungrokking是指一个已经grokking的模型在一个小于Dcrit的数据集上进一步训练时测试性能下降。

-

semi-grokking是在Dcrit大小的数据集上训练时出现的延迟的部分泛化。

动机:解释神经网络在训练过程中的一个奇特现象,即网络在经过进一步训练后,会从完美的训练准确度过渡到完美的泛化能力,这一现象被称为”grokking”。研究人员希望揭示这种现象背后的原因和机制。

方法:论文通过分析神经网络内部机制中的回路效率来解释”grokking”现象。研究人员提出两类电路:一类是能很好地泛化的电路,一类是能记忆训练数据集的电路。研究人员假设,当存在多个能达到良好训练性能的回路时,权重衰减会倾向选择效率更高的回路,即需要更少参数来产生相同输出的电路。

优势:论文通过提出的解释,成功预测和验证了关于”grokking”现象的四种新行为,并提供了对该现象的深入理解。最引人注目的是,论文揭示了两种新的令人惊讶的行为:”ungrokking”和”semi-grokking”。

通过分析回路效率解释了神经网络中的”grokking”现象,并预测和验证了相关行为。

https://arxiv.org/abs/2309.02390

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง