对于大型语言模型而言,更大的模型参数通常意味着更好的性能,这对当前GPU等AI加速器硬件的内存墙提出了挑战。分布式训练是最自然的解决方案,但实现分布式训练,尤其是模型并行性,通常需要计算机系统和架构方面的领域专业知识。对于人工智能研究人员来说,为其模型实施复杂的分布式训练解决方案仍然是一个挑战。

对于大型语言模型而言,更大的模型参数通常意味着更好的性能,这对当前GPU等AI加速器硬件的内存墙提出了挑战。分布式训练是最自然的解决方案,但实现分布式训练,尤其是模型并行性,通常需要计算机系统和架构方面的领域专业知识。对于人工智能研究人员来说,为其模型实施复杂的分布式训练解决方案仍然是一个挑战。

为了解决这个问题,尤洋团队引入了一个统一的并行训练系统,旨在无缝集成不同的并行化技术范式,包括数据并行、管道并行、多张量并行和序列并行。该系统旨在支持人工智能社区以与正常编写模型相同的方式编写分布式模型。这使他们能够专注于开发模型架构,并将分布式训练的关注点与开发过程分开。相比最先进的 GPT 模型训练分布式系统,该系统能够实现 2 倍的加速。

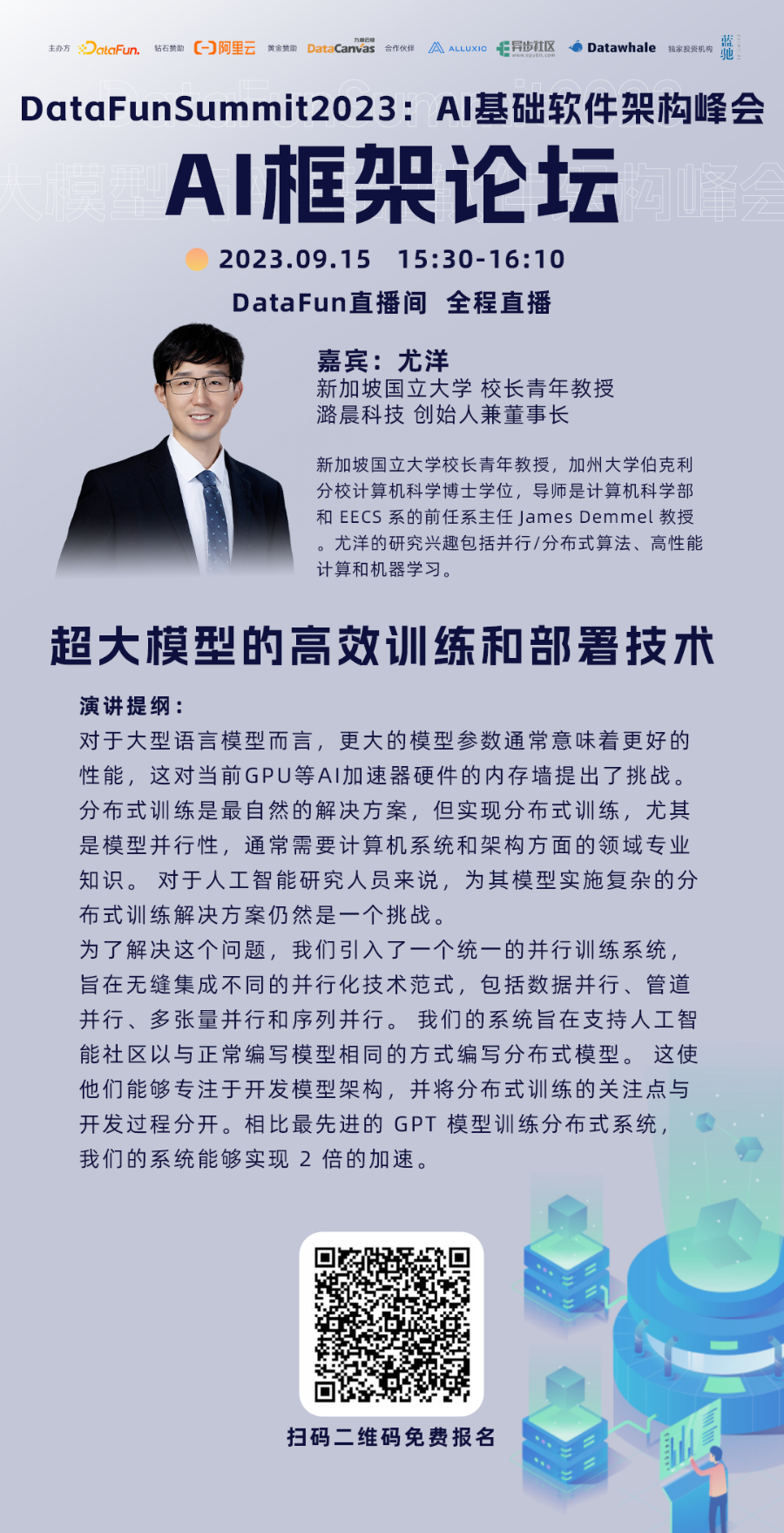

在9月15日9:00-17:00举办的DataFunSummit2023大模型与AI基础软件峰会AI框架论坛上,新加坡国立大学校长青年教授、潞晨科技创始人兼董事长尤洋将对该分布式系统的原理与应用进行详细介绍。

扫码免费报名观看尤洋 新加坡国立大学 校长青年教授、潞晨科技 创始人兼董事长

扫码免费报名观看尤洋 新加坡国立大学 校长青年教授、潞晨科技 创始人兼董事长

个人介绍:尤洋,新加坡国立大学校长青年教授,加州大学伯克利分校计算机科学博士学位,导师是计算机科学部和 EECS 系的前任系主任 James Demmel 教授。尤洋的研究兴趣包括并行/分布式算法、高性能计算和机器学习。他当前研究的重点是扩展分布式系统或超级计算机上的深度神经网络训练。2017年,他的团队打破了ImageNet训练速度的世界纪录,并被NSF、ScienceDaily、Science NewsLine、i-programmer等科技媒体报道。2019年,他的团队打破了BERT训练速度的世界纪录。BERT 训练技术已被 Google、Microsoft、NVIDIA 等众多科技巨头使用。尤洋团队开发的 LARS 和 LAMB 优化器可在行业基准 MLPerf 中使用。他曾获得 IPDPS 2015 最佳论文奖(0.8%)、ICPP 2018 最佳论文奖(0.3%)、AAAI 2023 杰出论文奖(0.14%)、ACL 2023 杰出论文奖(0.8%)和 ACM/IEEE George 迈克尔高性能计算奖学金。他是Siebel学者,Lotfi A. Zadeh奖获得者。尤洋被加州大学伯克利分校提名为 ACM 博士论文奖(2020 年毕业的 81 名伯克利 EECS 博士生中有 2 名)。他还入选了《福布斯》亚洲 30 Under 30 榜单(2021 年),并荣获 IEEE CS TCHPC 早期职业研究人员高性能计算卓越奖。欲了解更多信息,请查看他的实验室主页:NUS HPC-AI Lab

🔥演讲题目:超大模型的高效训练和部署技术

🎁听众收益:

对于大型语言模型而言,更大的模型参数通常意味着更好的性能,这对当前GPU等AI加速器硬件的内存墙提出了挑战。分布式训练是最自然的解决方案,但实现分布式训练,尤其是模型并行性,通常需要计算机系统和架构方面的领域专业知识。对于人工智能研究人员来说,为其模型实施复杂的分布式训练解决方案仍然是一个挑战。

为了解决这个问题,我们引入了一个统一的并行训练系统,旨在无缝集成不同的并行化技术范式,包括数据并行、管道并行、多张量并行和序列并行。我们的系统旨在支持人工智能社区以与正常编写模型相同的方式编写分布式模型。这使他们能够专注于开发模型架构,并将分布式训练的关注点与开发过程分开。相比最先进的 GPT 模型训练分布式系统,我们的系统能够实现 2 倍的加速。

扫码免费报名观看

扫码免费报名观看

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง