编译 | 曾全晨

审稿 | 王建民

今天为大家介绍的是来自Matthew DeCamp 和 Charlotta Lindvall的一篇关于AI应用中医疗歧视问题的论文。《摘要总结》。

人工智能(AI)在改善基础科学、转化科学、医学和公共卫生方面显示出潜力,但其成功并非保证。在医疗保健中,出现了许多关于种族、民族、性别、残疾和其他偏见的AI应用的例子。在伦理学中,偏见通常指的是对人们在待遇或经历结果方面的系统性、不公平的偏袒。科学家、伦理学家和决策者之间已经形成了共识,减少偏见是所有参与AI开发的人的共同责任。例如,确保公平性通过消除AI中的偏见是世界卫生组织治理AI的核心原则之一。但确保公平性需要的不仅仅是无偏的数据和算法,还需要减少临床医生和患者在使用基于AI的算法时的偏见,这可能比减少算法本身的偏见更具挑战性。

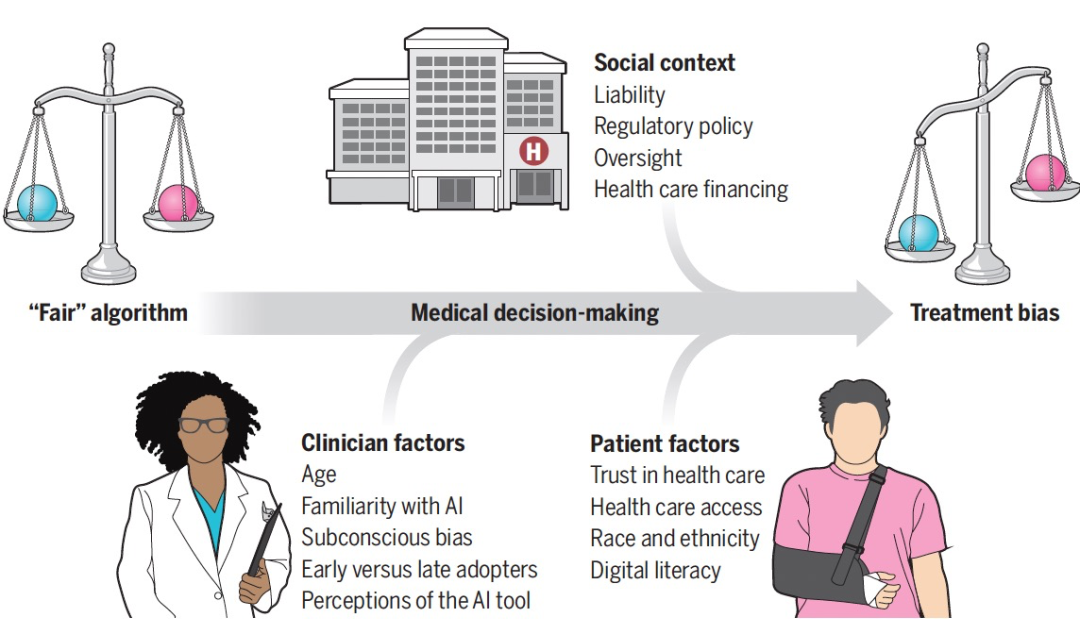

图1 临床医生和患者与基于人工智能(AI)的决策支持进行交互,该决策支持提供关于诊断可能性、治疗效果或预后的信息。即使算法是无偏的,临床医生、患者和社会层面的因素也会影响对建议的解读和实施,从而导致潜在的治疗偏见。

对AI中的偏见进行检查往往倾向于从数据集、分析或AI开发团队中消除偏见。例如,由于招募和注册不平等,肿瘤学数据集显示了种族、民族和全球地理偏见。在另一个例子中,开发人员假设医疗费用是医疗需求的代理,但后来发现即使黑人美国人有更大的需求,他们也经常接受较少的医疗照顾;由此产生的算法将会巩固这种结构性的种族主义。此外,鼓励研究人员的多样性和包容性也是管理AI偏见的另一种方式。

单靠这些努力是不够的。在实施AI时减轻偏见面临着一个更具挑战性的问题:出现性偏见,即不仅因为数据集或算法存在偏见,而且因为实际实施中涉及的因素而出现偏见。即使一个算法被认为是“公平”的,它的好处或伤害很可能在患者之间体验到不平等。这些伤害可以被视为潜在的偏见,而涉及的因素则是潜在条件。临床医生、患者和社会层面的因素可以相互作用产生偏见(见图1)。在决定临床医生是否以及如何使用AI提供的信息时,临床医生层面的因素将发挥复杂的作用。大多数医生不会盲目采用和遵循临床决策支持系统(CDSS)或基于算法的建议。然而,各种因素的影响并不总是明显的。

AI算法通常在数据如何转化为模型输出方面缺乏透明度或可解释性。由于医学重视专家和经验知识,统计或“黑匣子”知识在决策中可能被贬低。临床医生对基于AI的工具的感知,包括建议的呈现方式、AI背后的动机和数据来源的透明度以及可解释性,可能会影响临床医生使用AI的意愿。因此,应该预期在临床医生中会出现对AI的不同使用和接受程度。进一步复杂化问题的是,患者层面的因素将影响患者对AI的体验。首先,由于社会经济地位、种族、族裔、地理位置和其他因素,全球范围内的所有卫生系统都存在访问临床医生、医院和其他服务的不平等问题,这包括对基于AI的技术的不平等访问。此外,一些患者可能对技术的信任程度不同,一些患者可能对技术的了解较少。对于不信任临床医生或卫生系统的患者来说,他们可能不太愿意相信临床医生或卫生系统使用AI,而患者的不信任并不是随机分布的:它与种族、族裔、教育水平和其他因素相关。

患者疾病的严重程度或症状类型可能会影响临床医生遵循基于计算机的建议的意愿。例如,在美国,对于一名身份为黑人并出现疼痛症状的患者,数据显示临床医生可能更有可能忽略基于患者症状的决策支持,并且基于种族的不同会以不同方式解释疼痛报告。因此,根据患者种族的差异性遵循AI推荐的治疗方案可能会对黑人患者产生不同程度的伤害或帮助。

第三个导致新出现偏见的因素来源于社会和政策背景。医疗保健的融资机制差异很大,AI的可负担性和可获得性以及其建议的实施将影响其效果。由于医疗责任是基于目前不涉及AI的现行医疗标准定义的,临床医生使用AI的最安全方式将是作为现有标准医疗的确认依据。因此,AI的早期应用可能受到现状偏见的影响,阻碍了AI在创新或改变患者护理计划方面的潜力。在时间紧迫的临床环境中,临床医生可能会更依赖于技术或完全忽视它。这种自动化偏见可能加剧资源匮乏环境中的不平等,其中时间和财务压力更加严重。在某些情况下,临床医生可能更愿意信任和使用由自己医院或卫生系统开发或认可的AI,而不是商业开发的AI。

在临床实施中,随着潜在偏见的出现,它们将反馈到学习模型中,可能对模型本身的性能产生负面影响。增加临床医生对AI偏见的认识至关重要,但这种愿望可能具有矛盾性:了解AI中的偏见可能导致医生对其判断为“与其他患者不同”的患者不太愿意使用基于AI的建议。存在多种策略来识别和解决潜在偏见。其中一种策略可能涉及向临床医生提供与模型特定、个体水平性能相关的反馈,以确定他们是否在性能上超过或不及格,或者是否系统地只针对特定患者群体遵循或忽略模型的建议。个性化的反馈有潜力提高临床医生的表现。然而,评估偏见的一个挑战是临床医生可能没有足够多的不同群体的患者来进行严格的分层比较。

作为尊重患者的问题,应该向患者提供有关在其临床护理中使用AI的信息。这包括关于使用预测算法、聊天机器人和其他基于AI的技术的一般信息,以及在其个人护理中使用新的基于AI的技术时的具体通知。这样做可以提高对AI的认识,促进与临床医生的交流,并支持对AI使用的更大透明度。

确切需要披露多少信息,以及以何种格式进行披露,这些问题需要进一步研究来回答。我们需要避免AI例外主义的观点,即认为AI更具风险或需要更大程度的保护,仅仅因为它是AI,而目前患者希望了解更多而不是更少。其他依赖算法的决策,如临床风险计算器或计算机辅助放射学或心电图解读,可能不会被常规告知患者,但这并不是支持保密的理由。偏见在药物和设备监管中并不是一个主要方面,监管主要关注整体的安全性和有效性。最近的美国提议可能会将法律责任扩展到医生和医院,这意味着他们可能需要向患者提供赔偿或面临使用有偏见的临床算法的处罚;这些规定也适用于AI算法。然而,AI算法的复杂性以及关于种族或民族是否存在真正偏见的差异性能的伦理争议,使责任提议变得复杂。药物和设备监管机构可能考虑在批准过程和其他论坛中要求进行不同现实假设下的性能差异和偏见评估,例如在AI研究的期刊报告中。

此外,AI应该对自身进行审视。这需要积极、有意识地开发AI工具来识别AI中的偏见以及其临床实施中的偏见。AI可能会导致偏见的出现,但它也有发现偏见的潜力,从而促进克服偏见的新方法。开源工具在帮助研究人员评估机器学习数据和算法中的公平性方面显示出潜力。这些工具可以评估数据集、预测输出中的偏见,甚至可以根据不同的公平度指标评估用于减少偏见的不同技术。它们在医疗数据和算法中的应用值得进行严格的科学研究。亟需实施研究来更好地了解不同背景因素和潜在条件在偏见出现中的作用。在什么情况下可能出现偏见需要进行持续的严格研究。在AI中,有偏见的数据和有偏见的算法会导致患者遭受偏见的结果,但是当它们进入一个有偏见的世界时,无偏见的数据和算法也会产生偏见的结果。所有患者都应该从公平的算法和公平的实施中受益。

参考资料

Matthew DeCamp Charlotta Lindvall ,Mitigating bias in AI at the point of care.Science381,150-152(2023).

DOI:10.1126/science.adh2713

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง