今天是2023年9月13日,星期三,我们继续来聊聊一些话题。

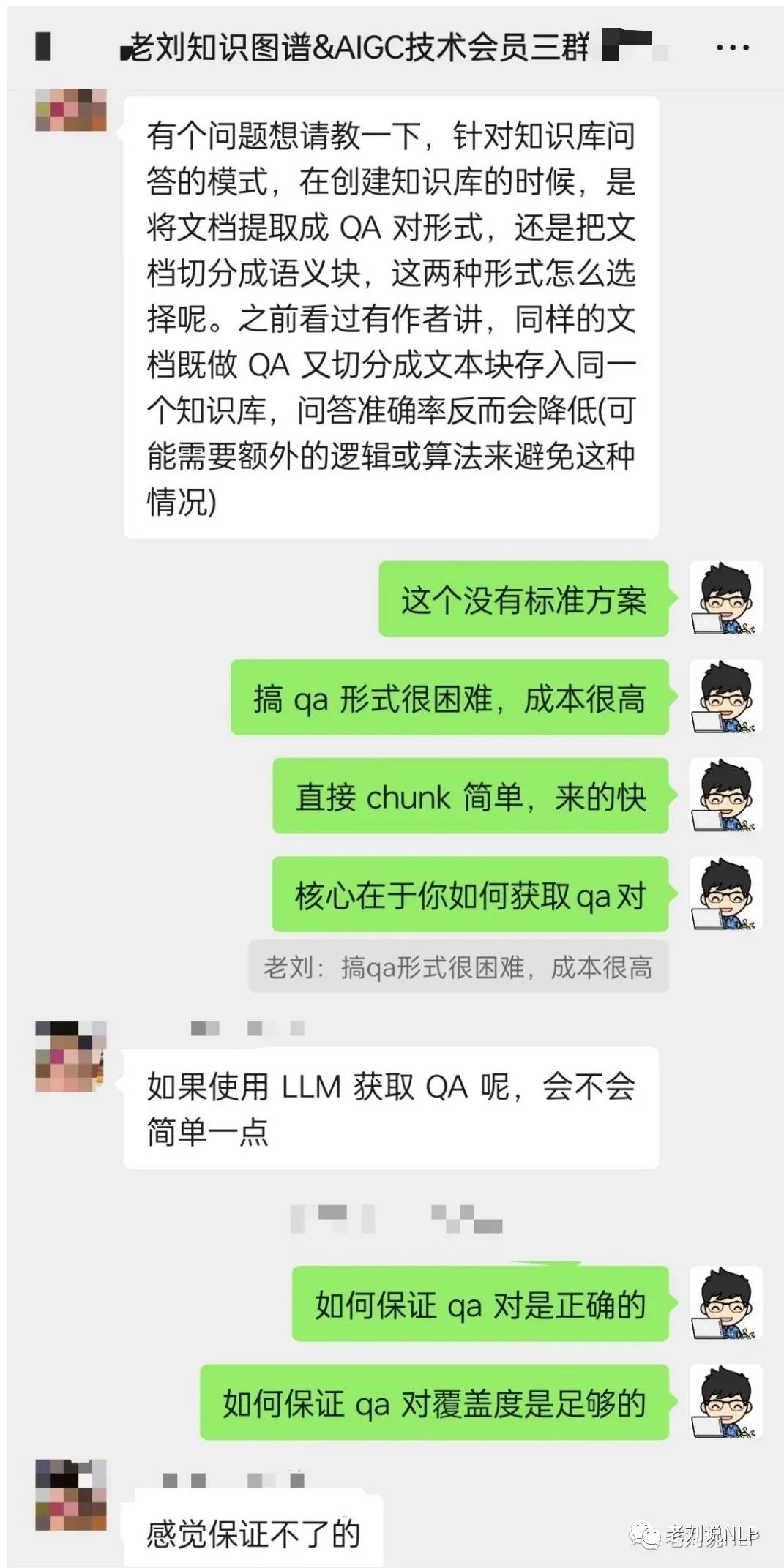

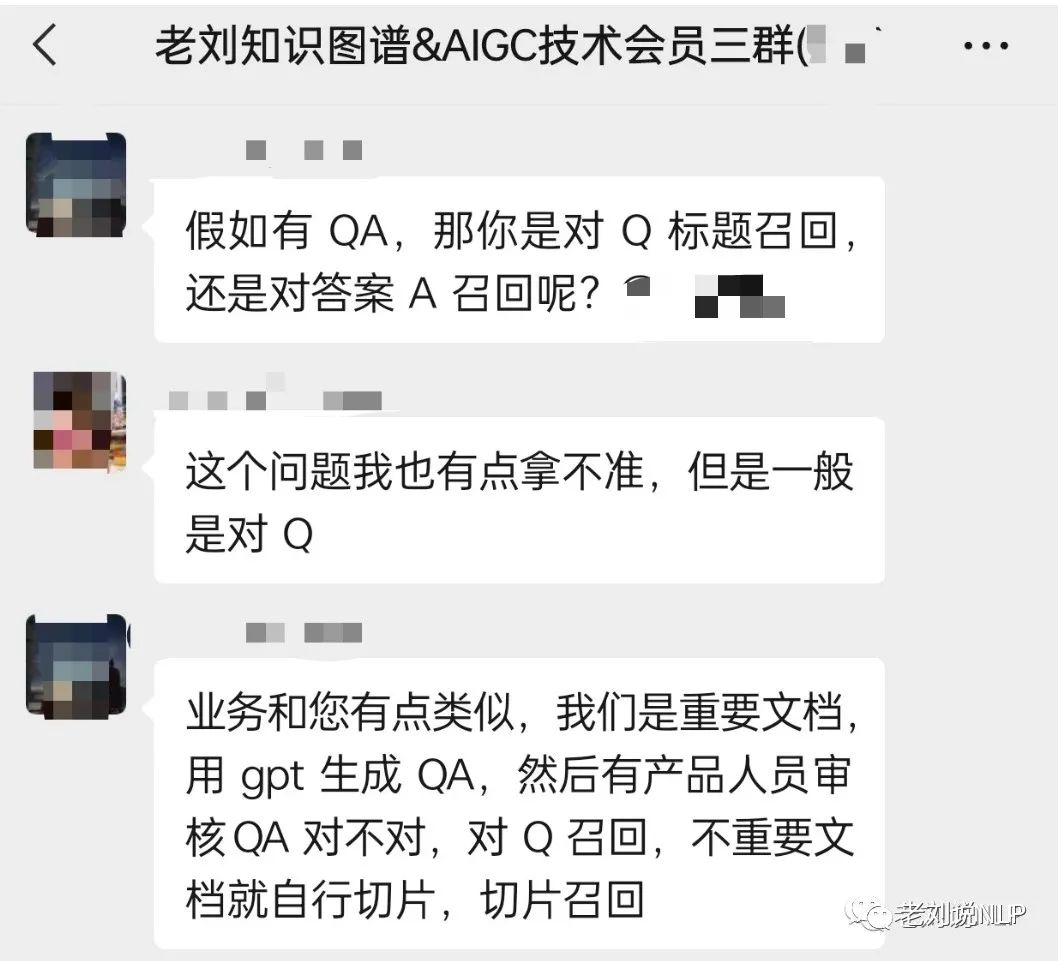

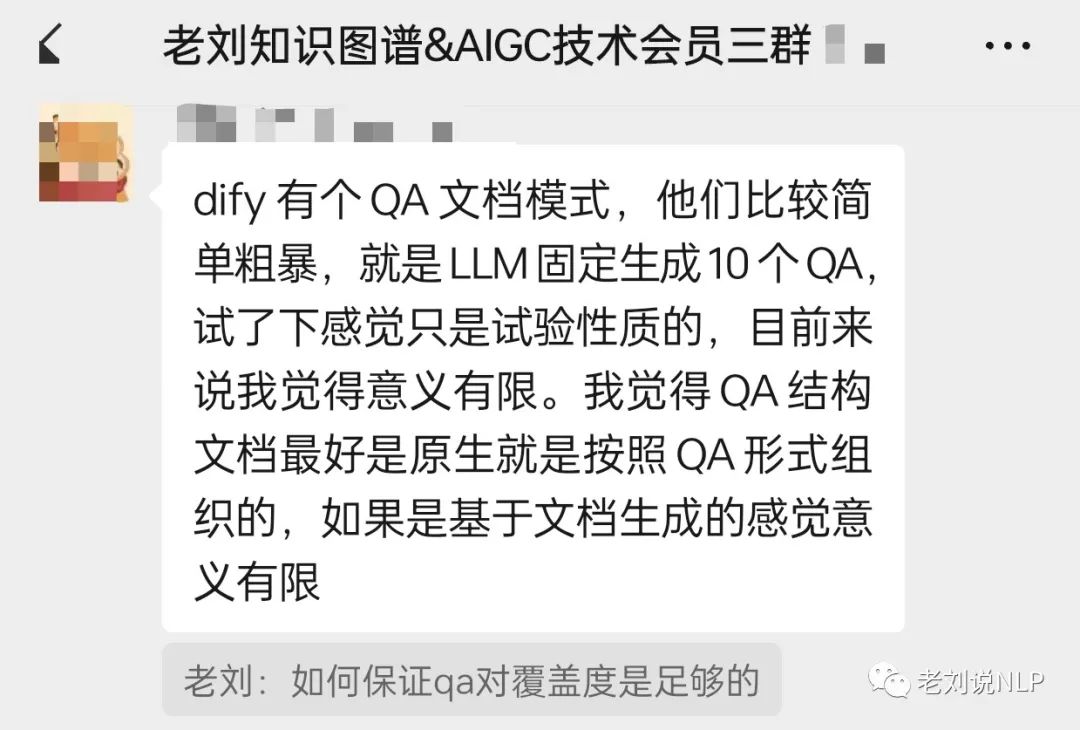

我们先来看这个关于垂直领域微调模型问答的场景,目前FAQ的形式和现有MRC的方式受到大家关注,而在实际落地过程中,如何对两者进行权衡是个有趣的话题。

社区近期对其进行了一些讨论,很有意思,欢迎加入一起讨论。

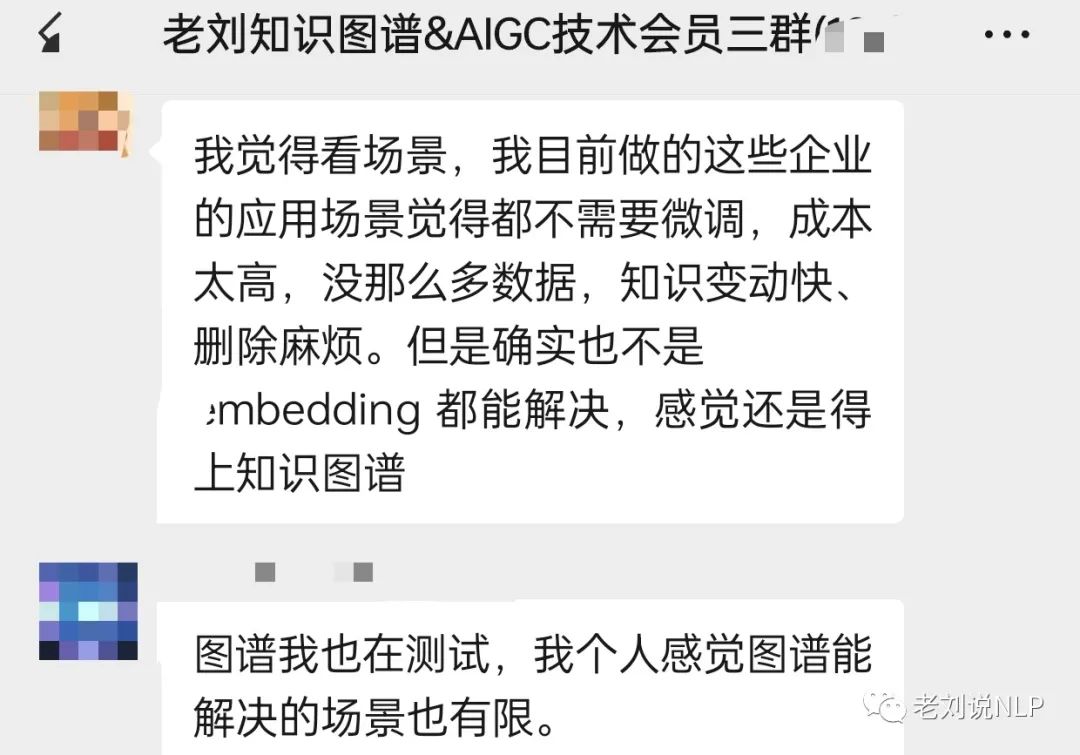

也就是说,我们对于一些具体的场景,尤其是知识变动快而且数据量少的情况,应该联合外部多种方法进行集成。

顺着领域微调这个主题,我们继续来看看大模型的汇总问题,我们已经在前面介绍过不少这类的模型,也给出了一些零散的清单。

那么,我们是否可以从模型名称、模型评测上,做一次统计,看看有到底有多少个模型呢。开源项目https://github.com/luban-agi/Awesome-Domain-LLM给出了一些整理成果,本文以该项目为基准进行介绍,进行补充,一共包括12个领域,57个领域微调模型,以及若干个对应的评测数据集,供大家一起参考。

一、22个医疗领域微调模型及2大评测基准

1、DoctorGLM

基于ChatGLM-6B的中文问诊模型,通过中文医疗对话数据集进行微调,实现了包括lora、p-tuningv2等微调及部署。

项目地址:https://github.com/xionghonglin/DoctorGLM

论文地址:https://arxiv.org/abs/2304.01097

2、BenTsao (本草)

该项目开源了经过中文医学指令微调的大语言模型集,包括LLaMA、Alpaca-Chinese、Bloom、活字模型等。我们基于医学知识图谱以及医学文献,结合ChatGPT API构建了中文医学指令微调数据集,并以此对各种基模型进行了指令微调,提高了基模型在医疗领域的问答效果。

项目地址:https://github.com/SCIR-HI/Huatuo-Llama-Med-Chinese

论文地址:https://arxiv.org/abs/2304.06975

3、Med-ChatGLM

该项目开源了经过中文医学指令微调的ChatGLM-6B模型,微调数据与BenTsao相同。

项目地址:https://github.com/SCIR-HI/Med-ChatGLM

4、BianQue (扁鹊)

该项目开源了生活空间健康大模型。结合当前开源的中文医疗问答数据集(MedDialog-CN、IMCS-V2、CHIP-MDCFNPC、MedDG、cMedQA2、Chinese-medical-dialogue-data),分析其中的单轮/多轮特性以及医生问询特性,结合自建的生活空间健康对话大数据,构建了千万级别规模的扁鹊健康大数据BianQueCorpus,基于扁鹊健康大数据BianQueCorpus,选择ChatGLM-6B作为初始化模型,经过全量参数的指令微调训练得到BianQue。

项目地址:https://github.com/scutcyr/BianQue

5、HuatuoGPT (华佗)

该项目开源了医疗大模型HuatuoGPT,包括基于Baichuan-7B训练得到的HuatuoGPT-7B和基于Ziya-LLaMA-13B-Pretrain-v1训练得到的HuatuoGPT-13B。

项目地址:https://github.com/FreedomIntelligence/HuatuoGPT

论文地址:https://arxiv.org/abs/2305.15075

6、QiZhenGPT

该项目利用启真医学知识库构建的中文医学指令数据集,并基于此在Chinese-LLaMA-Plus-7B、CaMA-13B、ChatGLM-6B模型上进行指令精调,大幅提高了模型在中文医疗场景下效果。

项目地址:https://github.com/CMKRG/QiZhenGPT

7、ChatMed

该项目开源了中文医疗大模型ChatMed-Consult,以中文医疗在线问诊数据集ChatMed_Consult_Dataset的50w+在线问诊+ChatGPT回复作为训练集,基于LlaMA-7b采用LoRA微调得到。

项目地址:https://github.com/michael-wzhu/ChatMed

8、ShenNong-TCM-LLM (神农)

该项目开源了中文中医药大模型ShenNong-TCM-LLM,以开源的中医药知识图谱为基础,采用以实体为中心的自指令方法,调用ChatGPT得到2.6w+中医药指令数据集ChatMed_TCM_Dataset,基于该数据集以LlaMA为底座,采用LoRA微调得到。

项目地址:https://github.com/michael-wzhu/ShenNong-TCM-LLM

9、XrayGLM

该项目开源了中文多模态医学数据集及模型,其在医学影像诊断和多轮交互对话上显示出了非凡的潜力。

项目地址:https://github.com/WangRongsheng/XrayGLM

10、MedicalGPT

该项目开源了医疗大模型MedicalGPT,实现了包括增量预训练、有监督微调、RLHF(奖励建模、强化学习训练)和DPO(直接偏好优化)。 项目地址:https://github.com/shibing624/MedicalGPT

11、Sunsimiao (孙思邈)

该项目开源了中文医疗大模型Sunsimiao,该模型基于baichuan-7B和ChatGLM-6B底座模型在十万级高质量的中文医疗数据中微调而得。

项目地址:https://github.com/thomas-yanxin/Sunsimiao

12、CareLlama (关怀羊驼)

项目地址:https://github.com/itsharex/CareLlama

该项目开源了医疗大模型CareLlama,同时它收集了数十个公开可用的医疗微调数据集和开放可用的医疗大语言模型以促进医疗LLM快速发展。

13、DISC-MedLLM

该项目是由复旦大学发布的针对医疗健康对话式场景而设计的医疗领域大模型与数据集,该模型由DISC-Med-SFT数据集基于Baichuan-13B-Base指令微调得到,有效地对齐了医疗场景下的人类偏好,弥合了通用语言模型输出与真实世界医疗对话之间的差距。

项目地址:https://github.com/FudanDISC/DISC-MedLLM

论文地址:https://arxiv.org/abs/2308.14346

14、PMC-LLaMA

该项目开源了医疗大模型PMC-LLaMA,包括预训练版本的MedLLaMA_13B和指令微调版本的PMC_LLaMA_13B。

项目地址:https://github.com/chaoyi-wu/PMC-LLaMA

论文地址:https://arxiv.org/abs/2304.14454

15、ChatDoctor

该项目开源了医疗大模型ChatDoctor,在LLaMA的基础上训练得到。

项目地址:https://github.com/Kent0n-Li/ChatDoctor

论文地址:https://arxiv.org/abs/2303.14070

16、MING (明医)

项目地址:https://github.com/189569400/MedicalGPT-zh

该项目开源了医疗大模型MING,基于bloomz-7b指令微调得到MING-7B,支持医疗问答、智能问诊等功能。

17、IvyGPT

该项目开源了医疗大模型IvyGPT,它在高质量的医学问答数据上进行了监督微调,并使用人类反馈的强化学习进行了训练。

项目地址:https://github.com/WangRongsheng/IvyGPT

18、PULSE

该项目开源了中文医疗大模型PULSE,该模型使用约4,000,000个中文医学领域和通用领域的指令微调数据进行微调,支持医学领域的各种自然语言处理任务,包括健康教育、医师考试问题、报告解读、医疗记录结构化以及模拟诊断和治疗。

项目地址:https://github.com/openmedlab/PULSE

19、HuangDI (皇帝)

该项目开源了中医大模型HuangDI (皇帝,该模型首先在Ziya-LLaMA-13B-V1基座模型的基础上加入中医教材、中医各类网站数据等语料库,训练出一个具有中医知识理解力的预训练模型,之后在此基础上通过海量的中医古籍指令对话数据及通用指令数据进行有监督微调,使得模型具备中医古籍知识问答能力。

项目地址:https://github.com/Zlasejd/HuangDI

20、ZhongJing (仲景)

该项目开源了中医大模型ZhongJing (仲景,该模型旨在阐明中医博大精深之知识,传承古代智慧与现代技术创新,最终为医学领域提供可信赖和专业的工具。

项目地址:https://github.com/pariskang/CMLM-ZhongJing

21、TCMLLM

该项目拟通过大模型方式实现中医临床辅助诊疗(病证诊断、处方推荐等)中医药知识问答等任务,推动中医知识问答、临床辅助诊疗等领域的快速发展。目前针对中医临床智能诊疗问题中的处方推荐任务,发布了中医处方推荐大模型TCMLLM-PR,通过整合真实世界临床病历、医学典籍与中医教科书等数据,构建了包含68k数据条目的处方推荐指令微调数据集,在ChatGLM大模型上进行微调得到。

项目地址:https://github.com/2020MEAI/TCMLLM

22、OpenBioMed

该项目开源了若干多模态生物医学大模型,包括多模态生物医药大模型BioMedGPT、多模态小分子基础模型DrugFM和MolFM、细胞表示学习模型CellLM等。

项目地址:https://github.com/PharMolix/OpenBioMed

论文地址:https://arxiv.org/abs/2308.09442

PromptCBLUE医疗评测基准

PromptCBLUE是一个面向中文医疗场景的评测基准,通过对CBLUE基准进行二次开发,将16种不同的医疗场景NLP任务全部转化为基于提示的语言生成任务。

项目地址:https://github.com/michael-wzhu/PromptCBLUE

论文地址:https://arxiv.org/abs/2308.04823

中文医疗模型评估基准CMB

A Comprehensive Medical Benchmark in Chinese,其包括了不同临床职业、不同职业阶段考试中的多项选择题(CMB-Exam)和基于真实病例的复杂临床诊断问题(CMB-Clin)。

论文地址:https://arxiv.org/abs/2308.08833

项目地址:https://github.com/FreedomIntelligence/CMB

二、4大心理健康领域微调模型

1、MeChat

该项目开源了中文心理健康支持对话大模型与数据集。模型由ChatGLM-6B LoRA 16-bit指令微调得到。数据集通过ChatGPT改写真实的心理互助QA为多轮的心理健康支持多轮对话,该数据集含有56k个多轮对话,其对话主题、词汇和篇章语义更加丰富多样,更加符合在长程多轮对话的应用场景。

项目地址:https://github.com/qiuhuachuan/smile

2、SoulChat (灵心)

该项目开源了心理健康大模型SoulChat (灵心,该模型以ChatGLM-6B作为初始化模型,经过百万规模心理咨询领域中文长文本指令与多轮共情对话数据联合指令微调得到。

项目地址:https://github.com/scutcyr/SoulChat

3、MindChat (漫谈)

该项目开源了心理大模型MindChat (漫谈,该模型采用了经过人工清洗的约20万条的高质量多轮心理对话数据进行训练,涵盖工作、家庭、学习、生活、社交、安全等多个方面,期望从心理咨询、心理评估、心理诊断、心理治疗四个维度帮助人们纾解心理压力与解决心理困惑, 提高心理健康水平.

项目地址:https://github.com/X-D-Lab/MindChat

4、QiaoBan (巧板)

该项目开源了儿童情感对话大模型QiaoBan,基于开源通用大模型,使用通用域人机对话、单轮指令数据以及儿童情感陪伴对话数据进行指令微调,研发出适用于儿童情感陪伴的大模型。

项目地址:https://github.com/HIT-SCIR-SC/QiaoBan

三、10大法律领域微调模型及2大评测基准

1、LawGPT_zh (獬豸)

本项目开源的中文法律通用模型由ChatGLM-6B LoRA 16-bit指令微调得到。数据集包括现有的法律问答数据集和基于法条和真实案例指导的self-Instruct构建的高质量法律文本问答,提高了通用语言大模型在法律领域的表现,提高了模型回答的可靠性和专业程度。

项目地址:https://github.com/LiuHC0428/LAW-GPT

2、LaWGPT

该系列模型在通用中文基座模型(如Chinese-LLaMA、ChatGLM等)的基础上扩充法律领域专有词表、大规模中文法律语料预训练,增强了大模型在法律领域的基础语义理解能力。在此基础上,构造法律领域对话问答数据集、中国司法考试数据集进行指令精调,提升了模型对法律内容的理解和执行能力。

项目地址:https://github.com/pengxiao-song/LaWGPT

3、LexiLaw

LexiLaw是一个经过微调的中文法律大模型,它基于ChatGLM-6B架构,通过在法律领域的数据集上进行微调,使其在提供法律咨询和支持方面具备更高的性能和专业性。该模型旨在为法律从业者、学生和普通用户提供准确、可靠的法律咨询服务。无论是需要针对具体法律问题的咨询,还是对法律条款、案例解析、法规解读等方面的查询,LexiLaw都能够提供有益的建议和指导。

项目地址:https://github.com/CSHaitao/LexiLaw

4、Lawyer LLaMA

该项目开源了法律领域的指令微调数据和基于LLaMA训练的中文法律大模型Lawyer LLaMA。Lawyer LLaMA首先在大规模法律语料上进行了预训练,让它系统的学习中国的法律知识体系。在此基础上,借助ChatGPT收集了一批对中国国家统一法律职业资格考试客观题的分析和对法律咨询的回答,利用收集到的数据对模型进行指令微调,让模型习得将法律知识应用到具体场景中的能力。

项目地址:https://github.com/AndrewZhe/lawyer-llama

论文地址:https://arxiv.org/abs/2305.15062

5、HanFei (韩非)

HanFei-1.0(韩非是国内首个全参数训练的法律大模型,参数量7b,主要功能包括:法律问答、多轮对话、撰写文章、检索等。

项目地址:https://github.com/siat-nlp/HanFei

6、ChatLaw

由北大开源的一系列法律大模型,使用大量法律新闻、法律论坛、法条、司法解释、法律咨询、法考题、判决文书等原始文本来构造对话数据,包括基于姜子牙-13B、Anima-33B训练而来的ChatLaw-13B和ChatLaw-33B。此外,还开源了ChatLaw-Text2Vec,使用93w条判决案例做成的数据集基于BERT训练了一个相似度匹配模型,可将用户提问信息和对应的法条相匹配。

项目地址:https://github.com/PKU-YuanGroup/ChatLaw

论文地址:https://arxiv.org/abs/2306.16092

7、Lychee (律知)

开源了中文司法领域大模型Law-GLM-10B,基于GLM-10B模型,在30GB中文法律数据上进行指令微调得到。

项目地址:https://github.com/davidpig/lychee_law

8、wisdomInterrogatory (智海-录问)

由浙江大学、阿里巴巴达摩院以及华院计算三家单位共同设计研发的法律大模型,基于Baichuan-7B进行了法律领域数据的二次预训练与指令微调,并设计了知识增强的推理流程。

项目地址:https://github.com/zhihaiLLM/wisdomInterrogatory

9、JurisLMs

该项目基于中文法学语料训练了一系列语言模型,包括: 1 可解释法律判决预测模型AI Judge,由GPT2在法学语料上进一步预训练之后,结合一个法条适用模型(一个基于BERT的分类器)微调得到,不仅能够给出判决结果,还能给出相应的法院观点; 2 智能法律咨询模型AI Lawyer,采用主动学习在少量数据上进行微调得到,可以根据用户咨询适用正确的法律法规回答问题。

项目地址:https://github.com/seudl/JurisLMs

10、夫子•明察司法大模型

以 ChatGLM 为大模型底座,基于海量中文无监督司法语料与有监督司法微调数据训练的中文司法大模型,支持法条检索、案例分析、三段论推理判决以及司法对话等功能,旨在为用户提供全方位、高精准的法律咨询与解答服务

项目地址:https://github.com/irlab-sdu/fuzi.mingcha

法律评测基准:LEXTREME

LEXTREME是一个多语言的法律评测基准,包含了24种语言11个评测数据集。

项目地址:https://github.com/JoelNiklaus/LEXTREME

论文地址:https://arxiv.org/abs/2301.13126

法律评测基准:LexGLUE

LexGLUE是一个英文法律评测基准。

项目地址:https://github.com/coastalcph/lex-glue

论文地址:https://arxiv.org/abs/2110.00976

四、10大金融领域微调模型及3大评测基准

1、BBT-FinCUGE-Applications

论文地址:https://arxiv.org/abs/2302.09432 该项目开源了中文金融领域语料库BBT-FinCorpus,知识增强型大模型BBT-FinT5及评测基准CFLEB。

项目地址:https://github.com/ssymmetry/BBT-FinCUGE-Applications

2、Cornucopia (聚宝盆)

该项目基于公开和爬取的中文金融领域问答数据构建指令数据集,并在此基础上对LLaMA系模型进行了指令微调,提高了LLaMA在金融领域的问答效果。

项目地址:https://github.com/jerry1993-tech/Cornucopia-LLaMA-Fin-Chinese

3、XuanYuan (轩辕)

轩辕是国内首个开源的千亿级中文对话大模型,同时也是首个针对中文金融领域优化的千亿级开源对话大模型。轩辕在BLOOM-176B的基础上针对中文通用领域和金融领域进行了针对性的预训练与微调,它不仅可以应对通用领域的问题,也可以解答与金融相关的各类问题,为用户提供准确、全面的金融信息和建议。

项目地址:https://github.com/Duxiaoman-DI/XuanYuan

论文地址:https://arxiv.org/abs/2305.12002

4、PIXIU (貔貅)

项目地址:https://github.com/chancefocus/PIXIU

论文地址:https://arxiv.org/abs/2306.05443 该项目开源了金融领域指令微调数据集FIT,大模型FinMA及评测基准FLARE。

5、FinGPT

该项目开源了多个金融大模型,包括ChatGLM2-6B+LoRA和LLaMA2-7B+LoRA等金融大模型,收集了包括金融新闻、社交媒体、财报等中英文训练数据。

项目地址:https://github.com/AI4Finance-Foundation/FinGPT

论文地址:https://arxiv.org/abs/2306.06031

6、FLANG

该项目开源了金融大模型FLANG。

项目地址:https://github.com/SALT-NLP/FLANG

论文地址:https://arxiv.org/abs/2211.00083

10、FinEval

FinEval是一个金融知识评测基准,包含了4,661个高质量的多项选择题,涵盖金融、经济、会计和证书等领域,34个不同的学术科目。 项目地址:https://github.com/SUFE-AIFLM-Lab/FinEval

论文地址:https://arxiv.org/abs/2308.09975

金融领域评测基准:FLARE

FLARE是一个金融评测基准,包含了金融知识理解和预测等任务。

项目地址:https://github.com/chancefocus/PIXIU

论文地址:https://arxiv.org/abs/2306.05443

金融领域评测基准:CFLEB

CFLEB是一个中文金融评测基准,包含两项语言生成任务和四项语言理解任务。

项目地址:https://github.com/ssymmetry/BBT-FinCUGE-Applications

论文地址:https://arxiv.org/abs/2302.09432

金融领域评测基准:FLUE

FLUE是一个金融评测基准,包含5个金融领域数据集。 项目地址:https://github.com/SALT-NLP/FLANG

论文地址:https://arxiv.org/abs/2211.00083

五、2大教育领域大模型

1、桃李 (Taoli)

该项目开源了适用于国际中文教育领域的大模型,基于目前国际中文教育领域流通的500余册国际中文教育教材与教辅书、汉语水平考试试题以及汉语学习者词典等,构建了国际中文教育资源库。通过多种形式的指令构造了共计88000条的高质量国际中文教育问答数据集,并利用收集到的数据对模型进行指令微调,让模型习得将国际中文教育知识应用到具体场景中的能力。

项目地址:https://github.com/blcuicall/taoli

2、EduChat

该项目开源了针对教育垂直领域的对话大模型,主要研究以预训练大模型为基底的教育对话大模型相关技术,融合多样化的教育垂直领域数据,辅以指令微调、价值观对齐等方法,提供教育场景下自动出题、作业批改、情感支持、课程辅导、高考咨询等丰富功能,服务于广大老师、学生和家长群体,助力实现因材施教、公平公正、富有温度的智能教育。

项目地址:https://github.com/icalk-nlp/EduChat

论文地址:https://arxiv.org/abs/2308.02773

六、自媒体领域微调模型

1、MediaGPT

该项目开源了中文自媒体大模型MediaGPT,首先在大规模自媒体语料上进行连续预训练,系统地学习自媒体的知识体系。然后,借助ChatGPT收集了一批关于抖音运营、短视频创作、巨量千川投放、直播运营和直播话术技巧等领域知识问题的分析和回答,并利用这些数据对模型进行指令微调,使模型习得如何将自媒体知识应用到实际场景中。

项目地址:https://github.com/IMOSR/MediaGPT

七、电商领域微调模型

1、EcomGPT

该项目开源了电商大模型EcomGPT,基于BLOOMZ在电商领域指令微调数据集EcomInstruct进行微调,在12个电商评测数据集上的人工评估超过ChatGPT。

项目地址:https://github.com/Alibaba-NLP/EcomGPT

论文地址:https://arxiv.org/abs/2308.06966

八、政务领域微调模型

YaYi (雅意)

该项目开源了多领域大模型YaYi (雅意,该模型在百万级人工构造的高质量领域数据上进行指令微调得到,训练数据覆盖媒体宣传、舆情分析、公共安全、金融风控、城市治理等五大领域,上百种自然语言指令任务。

项目地址:https://github.com/wenge-research/YaYi

九、2大天文地理领域微调模型及1大评测

1、StarGLM

该项目开源了天文大模型StarGLM,整合司天工程相关的语料数据与知识库资料,训练得到天文大模型StarGLM,以期缓解大语言模型在天文通用知识和部分前沿变星领域的幻觉现象,为接下来可处理天文多模态任务、部署于望远镜阵列的观测Agent——司天大脑(数据智能处理)打下基础。

项目地址:https://github.com/Yu-Yang-Li/StarGLM

2、K2

该项目开源了地球科学大模型K2,该模型在LLaMA的基础上使用地球科学文献和维基百科数据进行预训练,然后使用GeoSignal数据集进行指令微调。

项目地址:https://github.com/davendw49/k2

论文地址:https://arxiv.org/abs/2306.05064

天文地理领域评测:GeoGLUE

GeoGLUE是一个由阿里巴巴达摩院与高德联合发布的地理语义理解能力评测基准,旨在推动地理相关文本处理技术和社区的发展。本榜单提炼了其中多个典型场景:地图搜索、电商物流、政府登记、金融交通,并设计了六个核心任务:门址地址要素解析、地理实体对齐、Query-POI库召回、Query-POI相关性排序、地址Query成分分析、WhereWhat切分。

项目地址:https://modelscope.cn/datasets/damo/GeoGLUE/summary 论文地址:https://arxiv.org/abs/2305.06545

十、交通领域微调模型

1、TransGPT (致远)

该项目开源了交通大模型TransGPT (致远,主要致力于在真实交通行业中发挥实际价值。它能够实现交通情况预测、智能咨询助手、公共交通服务、交通规划设计、交通安全教育、协助管理、交通事故报告和分析、自动驾驶辅助系统等功能。TransGPT作为一个通用常识交通大模型,可以为道路工程、桥梁工程、隧道工程、公路运输、水路运输、城市公共交通运输、交通运输经济、交通运输安全等行业提供通识常识。以此为基础,可以落脚到特定的交通应用场景中。

项目地址:https://github.com/DUOMO/TransGPT

十一、网络安全领域微调模型

1、AutoAudit

该项目开源了网络安全大模型AutoAudit,其目标是为安全审计和网络防御提供强大的自然语言处理能力。它具备分析恶意代码、检测网络攻击、预测安全漏洞等功能,为安全专业人员提供有力的支持。

项目地址:https://github.com/ddzipp/AutoAudit

十二、2大科研领域微调模型

1、TechGPT

该项目开源了科技大模型TechGPT,该模型面向计算机科学、材料、机械、冶金、金融和航空航天等十余种垂直专业领域,涵盖了领域术语抽取、命名实体识别、关系三元组抽取、文本关键词生成、标题生成摘要、摘要生成标题、文本领域识别、机器阅读理解、基础常识问答、基于上下文的知识问答、建议咨询类问答、文案生成、中英互译和简单代码生成等多项自然语言理解和生成能力。

项目地址:https://github.com/neukg/TechGPT

2、Mozi (墨子)

该项目开源了科技论文大模型Mozi (墨子,可以用于科技文献的问答和情感支持。

项目地址:https://github.com/gmftbyGMFTBY/science-llm

论文地址:https://github.com/gmftbyGMFTBY/science-llm/blob/main/asset/mozi_technical_report.pdf

总结

本文主要对现有的一些垂直领域危险模型跟评测基准进行了介绍,一共包括12个领域,57个领域微调模型,以及若干个对应的评测数据集,供大家一起参考。

而对于行业问答这类问题,在落地过程中会有多种方式出现,对于一些具体的场景,尤其是知识变动快而且数据量少的情况,应该联合外部多种方法进行集成,这也是一些具体的经验,供大家参考。

参考文献

1、https://github.com/luban-agi/Awesome-Domain-LLM

关于我们

老刘,刘焕勇,NLP开源爱好者与践行者,主页:https://liuhuanyong.github.io。

老刘说NLP,将定期发布语言资源、工程实践、技术总结等内容,欢迎关注。

对于想加入更优质的知识图谱、事件图谱、大模型AIGC实践、相关分享的,可关注公众号,在后台菜单栏中点击会员社区->会员入群加入。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง