Transformer 如今已经成为主流,为各种任务创造了 SOTA 结果,它是一种新型的神经网络架构,用于处理多种感知模态数据(如图像、文本、音频等),比如机器翻译和文本生成。

9.14-9.15日我们邀请到哈工大博士李老师为大家直播分享——基于Transformer的视觉语言新SOTA,为大家解决Transformer基础模型原理、难点痛点以及Vision transformer的变式等问题!

扫码预约直播(附老师授课PPT)

免费领100篇多模态顶会论文!

部分授课ppt页面及论文展示

导师简介

-哈工大计算机博士

–共发表7篇SCI国际期刊和EI会议论文

-专业领域:人工智能、机器学习、深度学习、多模态表征学习和脉冲神经网络等

-担任国际顶级会议 AAAI, NeurIPS,期刊 IEEE TCSVT 的常任审稿人

直播大纲

第一天—Vision Transformer的前世今生

①Transformer基础模型原理

②Transformer难点痛点

③Vision transformer的变式

第二天—多模态Transformer的七十二变 ①Transformer用于多模态的背景及优势②多模态Transformer的各种变式及原因

扫码预约直播(附老师授课PPT)

免费领100篇多模态顶会论文!

(文末有福利)

多模态Transformer的特点是能够同时考虑输入序列中所有位置的信息,并且具有非常好的并行化性能。它使用了自注意力机制进行序列建模的神经网络架构,也采用了残差连接和层归一化等技术,以加快模型收敛速度和提高模型的泛化能力。

前段时间,清华团队提出了一个为多模态设计的概率建模框架 UniDiffuser,并采用该团队提出的基于 transformer 的网络架构 U-ViT,在开源的大规模图文数据集 LAION-5B 上训练了一个十亿参数量的模型,使得一个底层模型能够高质量地完成多种生成任务。

多模态Transformer的基本原理

输入编码

首先,每种感知模态的数据都会经过独立的编码层进行表示学习。对于文本数据,通常使用词嵌入技术将单词映射为向量表示。对于图像数据,可以使用卷积神经网络(CNN)提取特征。对于音频数据,可以使用卷积神经网络或者音频处理技术提取特征。

模态融合

经过编码的不同模态数据会被融合在一起,以便进行联合表示。常用的融合方式是使用注意力机制,通过计算模态间的相互注意力权重来自适应地融合不同模态的信息。这样可以使模型更好地关注重要的模态信息。

位置编码

和经典的Transformer一样,位置编码用于为模型提供序列中每个元素的位置信息。这样可以帮助模型理解输入数据中的顺序关系。

Transformer层

多模态Transformer通常由多个Transformer层组成。每个Transformer层由多头自注意力机制和前馈神经网络组成。自注意力机制能够捕捉输入序列中元素之间的关系,而前馈神经网络能够对每个元素进行非线性变换和映射。

输出解码

最后一个Transformer层的输出将被传递给输出解码层,以生成模型的最终输出。输出解码层的具体形式取决于所解决的任务,可以是分类、生成、检测等。

扫码预约直播(附老师授课PPT)

免费领100篇多模态顶会论文!

(文末有福利)

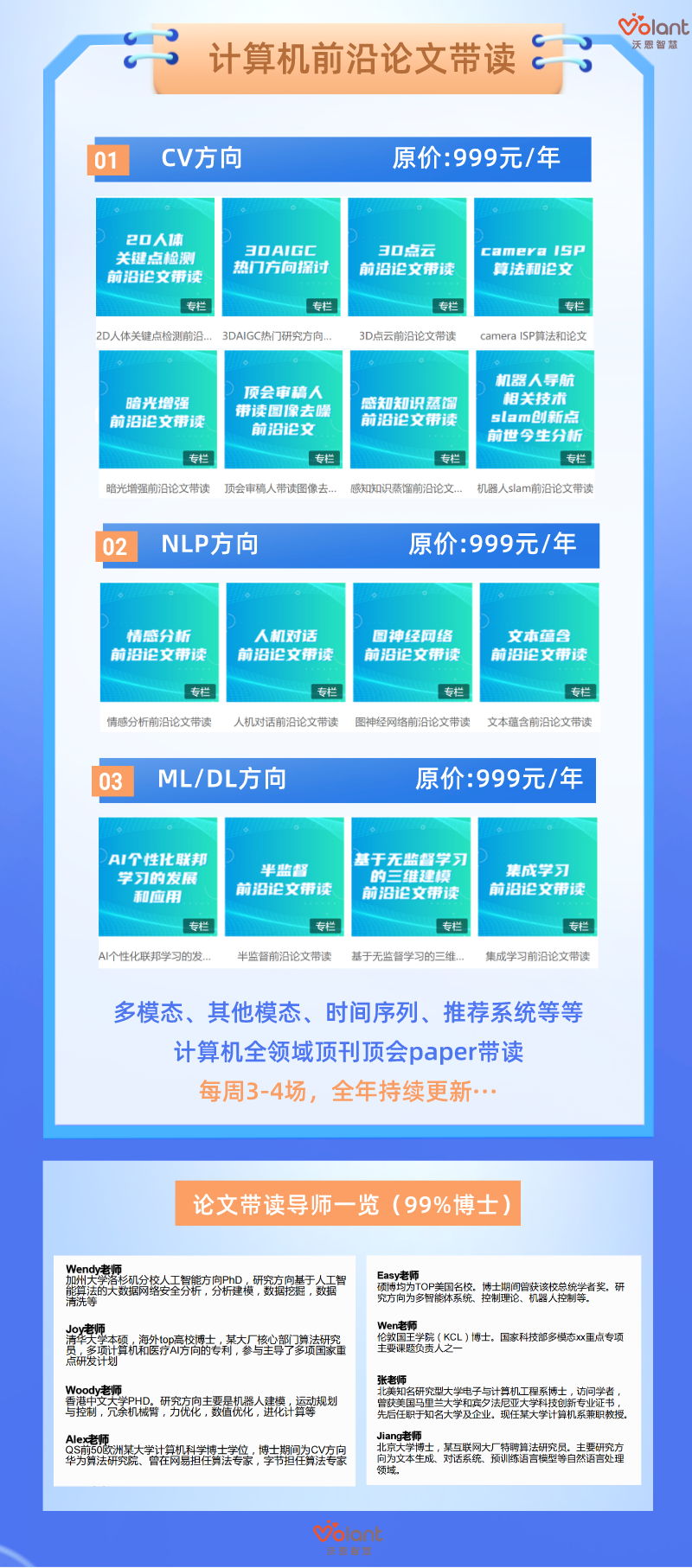

同时向大家推荐一个人工智能paper带读课程(课程持续更新),由qs前50导师倾力打造,助你找到自己的论文创新点,提高自己的思维框架能力。

通过此课程,你将获得

1.获得阅读Paper的正确方法

2.获得深度学习领域经典和前沿知识及发展脉络

3.洞悉优秀科研团队的研究方法、思路

4.细化吸收配套代码,快速借鉴用于自己的科研上

5.可以找到自己的论文创新点,提高自己的思维框架能力

适用人群

1.想学习人工智能但不知道如何入门的0基础小白

2.论文能力差,想提升自己的论文阅读能力的同学

3.有一定基础想提升人工智能相关领域水平的学习者

4.通过比赛实战提升代码能力等技能、增加简历含金量

扫描二维码

了解课程详情

✦

文末福利

作为日常为了论文而忙碌的科研人,小编知道大家一定很需要一些资料。因此,小编精心整理了一份Transformer论文&代码合集!包含最新顶会论文、书籍等资料,以及英文论文写作指导保姆级资料,从文献阅读到论文写作,全部免费帮你整理好~

扫码免费领课程资料-END-

扫码免费领课程资料-END-

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง