NExT-GPT: Any-to-Any Multimodal LLM

S Wu, H Fei, L Qu, W Ji, T Chua

[National University of Singapore]

NExT-GPT:通用任意模态多模态大语言模型、

-

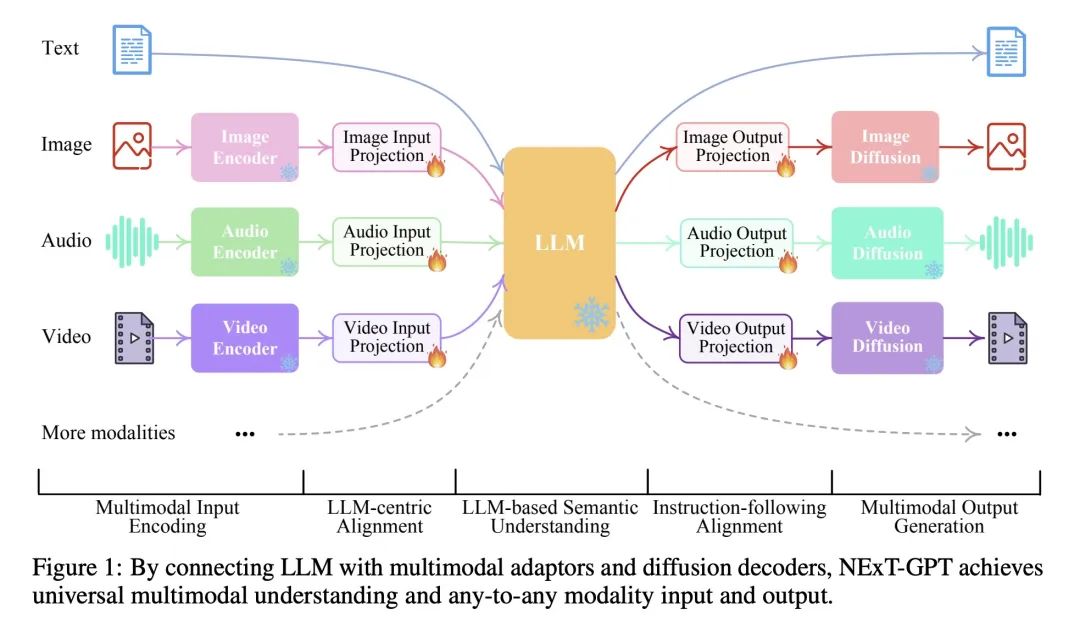

提出NExT-GPT,一个端到端的通用任意模态多模态大语言模型(MM-LLM),可以处理任意组合的文本,图像,视频和音频的输入与输出。

-

NExT-GPT通过连接语言模型与多模态适配器和不同的扩散解码器,实现了跨模态的输入理解与输出生成,通过利用现有训练好的编码器与解码器,只需要调整1%的参数。

-

提出两种轻量的对齐技术——编码端的语言模型中心对齐和解码端的指令遵循对齐,实现了高效的语义对齐与最小的计算开销。

-

提出新的模态切换指令微调(MosIT)方法与高质量数据集,赋予NExT-GPT复杂的跨模态理解与生成能力。

-

实验表明,NExT-GPT在各种文本到X、X到文本以及文本条件的模式编辑任务上都有出色表现。该模型也展示了更人性化的对话能力。

-

NExT-GPT代表了向实现通用多模态理解与任意模态输入输出的统一MM-LLM迈出的可喜的一步。

动机:构建一个任意多模态的大型语言模型,能接受和生成多种模态的内容,以实现人类级别的人工智能。

方法:通过将语言模型与多模态适配器和不同的解码器相连接,构建了一个端到端的通用任意多模态语言模型系统NExT-GPT。

优势:利用现有的高性能编码器和解码器进行微调,既避免了从头开始训练的成本,又便于扩展到更多潜在的模态。此外,通过引入模态切换指令微调(MosIT)和手动策划高质量数据集,使NExT-GPT具备复杂的跨模态语义理解和内容生成能力。

构建了一个任意多模态的语言模型NExT-GPT,通过连接适配器和解码器实现了通用的多模态理解和任意模态输入输出。

https://arxiv.org/abs/2309.05519

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง