Explainability for Large Language Models: A Survey

H Zhao, H Chen, F Yang, N Liu, H Deng, H Cai, S Wang, D Yin, M Du

[New Jersey Institute of Technology & Johns Hopkins University & Wake Forest University & …]

大型语言模型可解释性综述

-

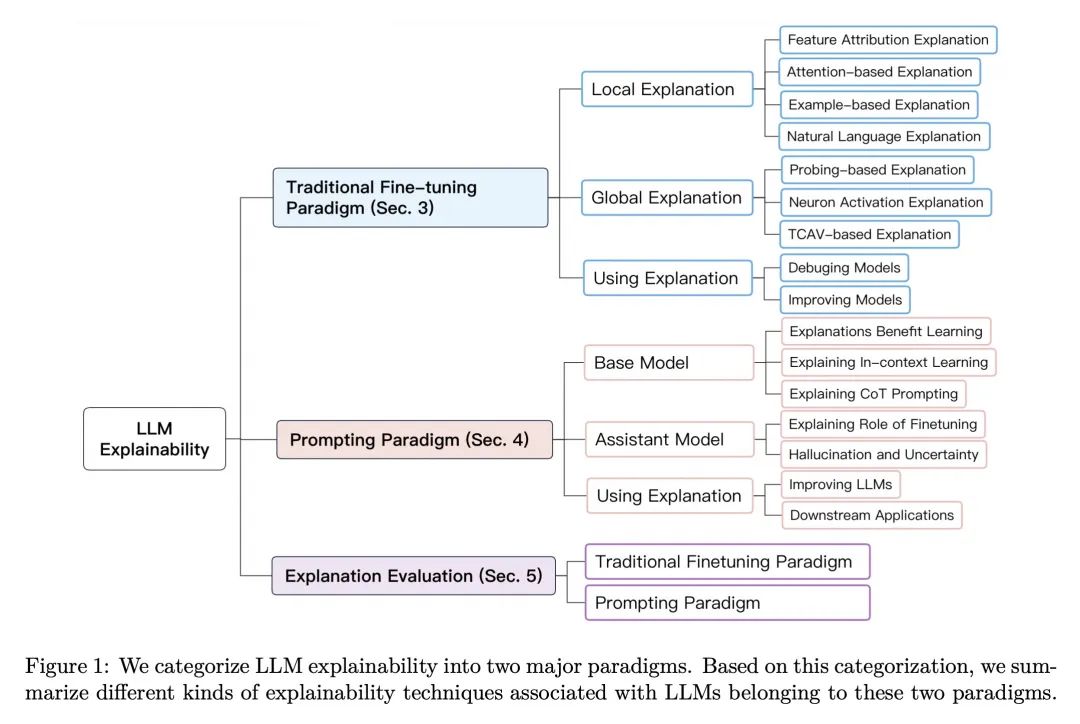

全面概述了面向基于Transformer大型语言模型(LLM)的解释性技术。

-

技术分类依据LLM的训练范式:微调 vs 提示。

-

对于经过微调的LLM,总结了局部解释方法(如特征归因法)和全局解释方法(如探测分类器)。

-

对于提示的LLM,讨论了解释上下文学习、连续思考提示和模型微调。

-

还讨论了解释的评估、利用解释改进模型的方法,以及关键挑战。

-

主要挑战包括缺乏真值解释、模型能力的起源、比较微调与提示、捷径学习,以及安全/伦理问题。

-

提高复杂LLM的解释性对于建立信任、改进模型和道德部署至关重要。

动机:理解和解释大型语言模型的内部机制对于揭示其行为、限制和社会影响至关重要。 方法:介绍了解释基于Transformer语言模型的方法,并根据模型的训练范式划分为传统微调范式和提示范式。 优势:通过解释方法,可以提高对模型预测的理解度,帮助用户建立适当的信任,同时也有助于研究人员和开发者发现模型的潜在问题并改进性能。

综述了大型语言模型的可解释性研究,提出了两种训练范式,介绍了解释方法和评估指标,为解释复杂语言模型的研究提供了参考。

https://arxiv.org/abs/2309.01029

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง