Contrastive Decoding Improves Reasoning in Large Language Models

S O’Brien, M Lewis

[Meta AI & University of California, San Diego]

用对比解码改善大语言模型推理

要点:

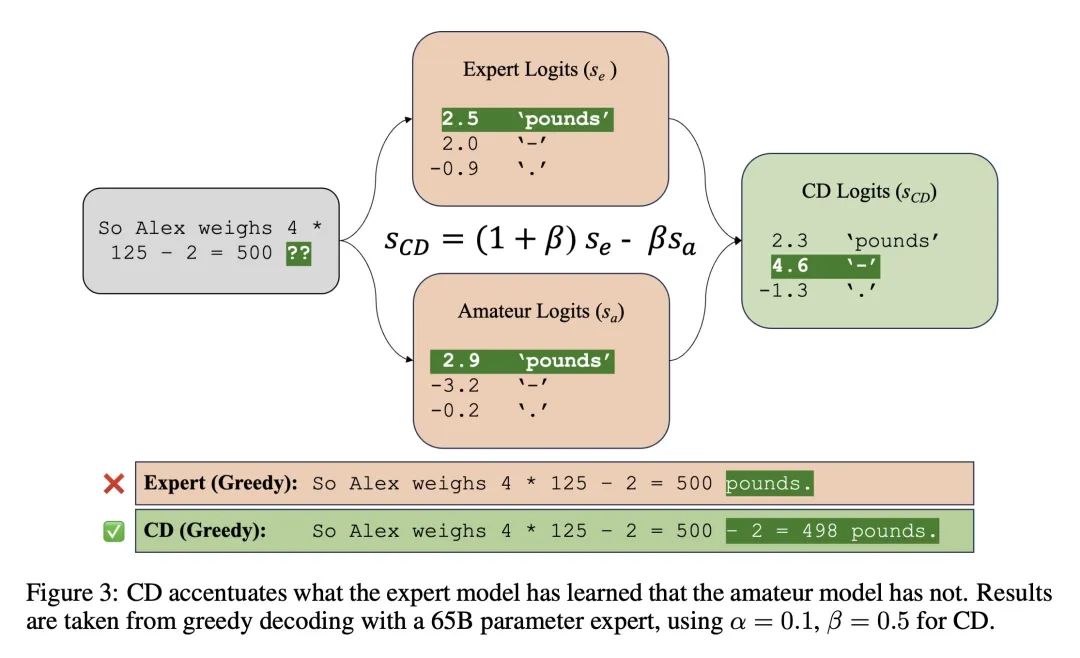

- 对比解码(CD)是一个简单、计算量小、无需训练的文本生成方法,通过最大化强大的”专家”模型和弱小的”业余”模型的可能性差异来搜索字符串。

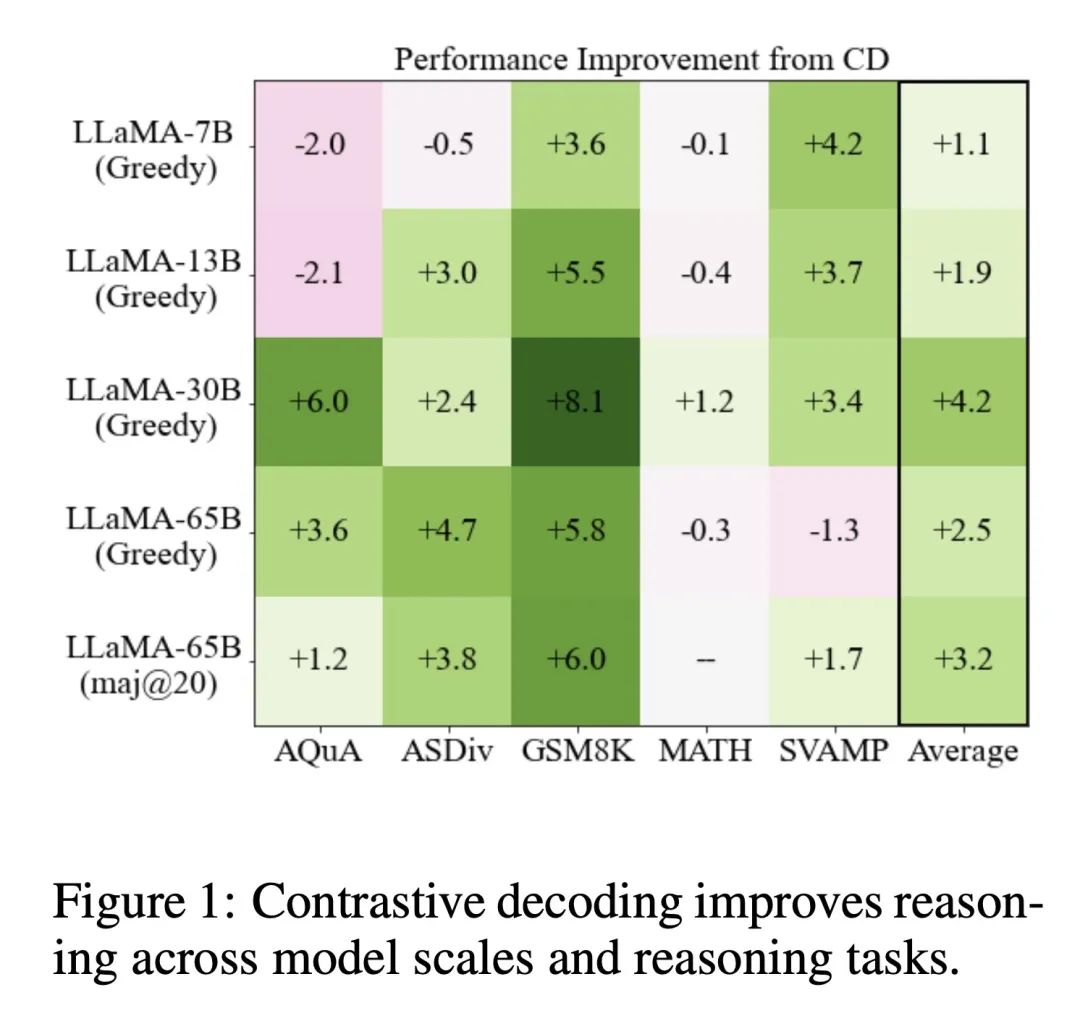

- 展示了CD大大提高了大规模语言模型在数学文字题和常识推理等任务上的推理能力,超过了贪心解码和nucleus sampling。

- 在GSM8K数学推理基准测试上,CD提高了LLaMA模型的准确率高达8个百分点,超过了更昂贵的自洽技术。

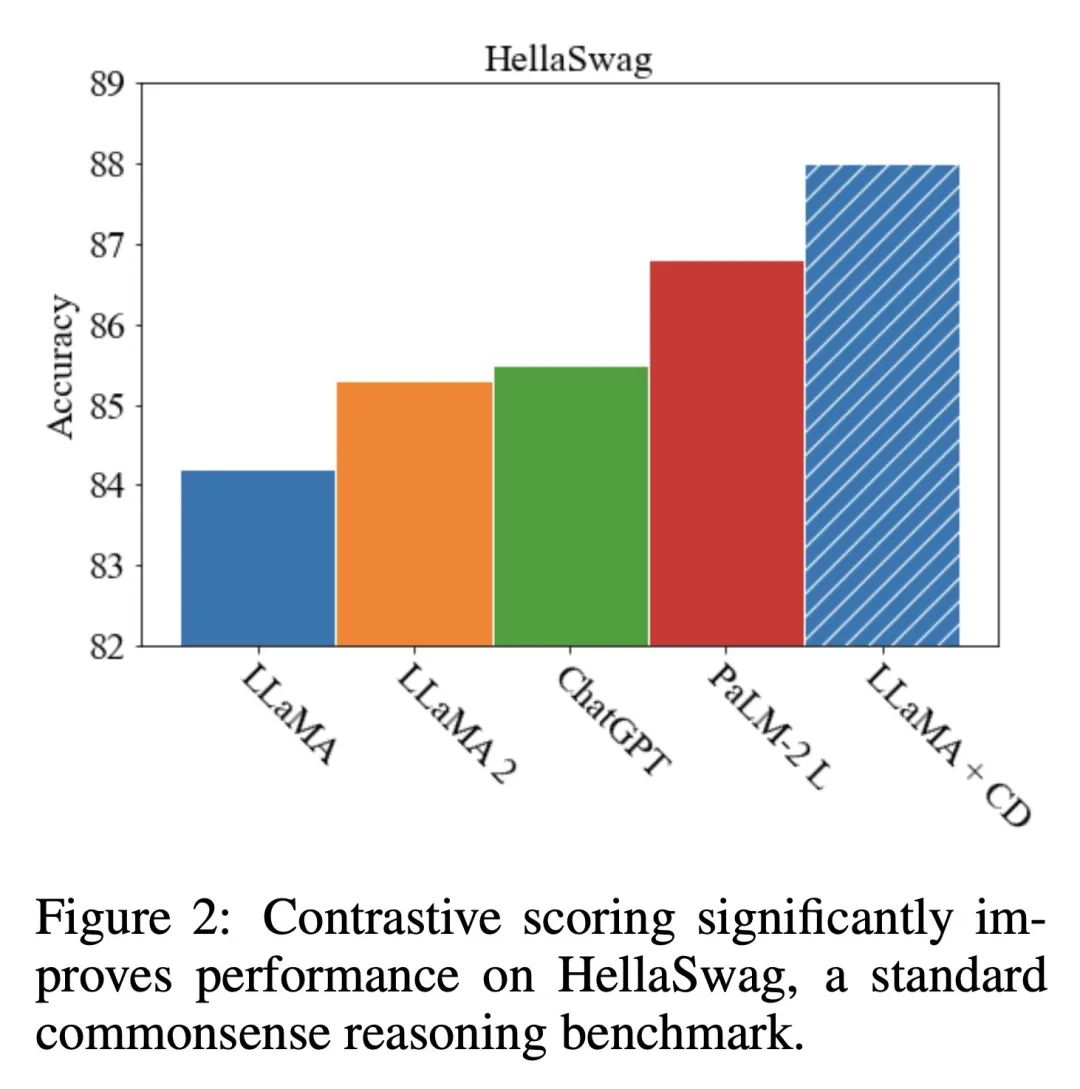

- 在HellaSwag常识推理基准测试上,CD帮助LLaMA-65B超过了GPT-3.5和PaLM-2等最先进的模型。

- 分析表明CD通过避免短小、通用的响应以及过多地从提示中复制内容来预防一些推理错误,更多地改善了逻辑推理而不是基础算术技能。

- CD提供了一种统一的方法来提高长文本和推理任务上的生成质量,尽管仍需进一步调整以达到最佳性能。

- 与其他方法相比,CD增加的计算量很小,因此效率高且可扩展。

动机:探索使用对比解码方法来提高大型语言模型在推理任务中的性能。 方法:使用对比解码方法来生成文本,通过最大化强模型和弱模型之间的似然差异来寻找最佳字符串。该方法避免了模型分布中不理想的模式,如短字符串和通用字符串。 优势:对比解码在各种推理任务上相对贪婪解码取得了显著的改进效果,包括在常识推理基准测试和数学推理基准测试上超过了其他模型。该方法还能减少抽象推理错误和输入中的复制操作,提高了文本生成的准确性和推理任务的性能。

一句话总结:

展示了通过对比解码方法在推理任务中相对于贪婪解码取得显著改进的效果,减少了抽象推理错误和复制操作,为生成文本和推理任务提供了一种强大的通用方法。

https://arxiv.org/abs/2309.09117

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง