当前,大模型训练成本仍居高不下。有数据显示,GPT-3训练一次的成本约为140万美元,而对于更大的模型,训练成本则在200万美元-1200万美元之间。高昂的训练成本严重制约大模型研究和落地。近日,智源研究院联合中科院计算所、南洋理工大学(新加坡)、电子科技大学(成都)、哈尔滨工业大学(深圳)的研究团队共同提出了一种「生长策略」(growth strategy),以解决大模型算力成本极高的问题。

研究团队基于「生长策略」逐步构建了一个具有1010亿参数的FLM-101B大模型。实际训练结果显示,只需约10万美元(约70万人民币)的算力成本,就能成功训练出一个效果和GPT-3、GLM-130B可比的千亿大模型。

线上直播分享

时间:9月21日(周四)14:30-15:30

讲者:智源认知模型团队负责人王业全

活动预约:《活动报名|如何使用70万预算从头训练千亿语言大模型》

FLM-101B模型的参数、代码和相关工具已开源。论文《FLM-101B: An Open LLM and How to Train It with $100K Budget》:https://arxiv.org/abs/2309.03852

FLM-101B模型地址:https://huggingface.co/CofeAI/FLM-101B

大模型面临的另一关键挑战是性能评测。传统的以知识性评测为主的评测方法可能无法全面反映大模型的智能水平。为此,研究团队在现有大模型评测方法的基础上,选取了基于IQ的方法对大模型进行IQ测试。研究团队在常规的知识导向评测基准和自建的IQ评测基准上分别对FLM模型进行了评测,并与GPT-3、GLM-130B进行了比较。实验结果表明,FLM-101B的表现具有竞争力和鲁棒性。

使用「生长策略」

10%成本,实现80%+性能

使用更多数据训练模型是当前大语言模型的研究趋势,例如LLaMA2系列的训练数据量高达 2T token,而这也导致大模型的训练成本一路攀升。研究团队所提出的控制大模型训练成本的关键思路在于,利用「生长策略」突破模型训练过程参数量固定的限制。“生长”的含义是,模型的参数量在训练过程中并不是固定的,而是可以随着训练进行,从较小的参数规模扩展到更大的参数规模。

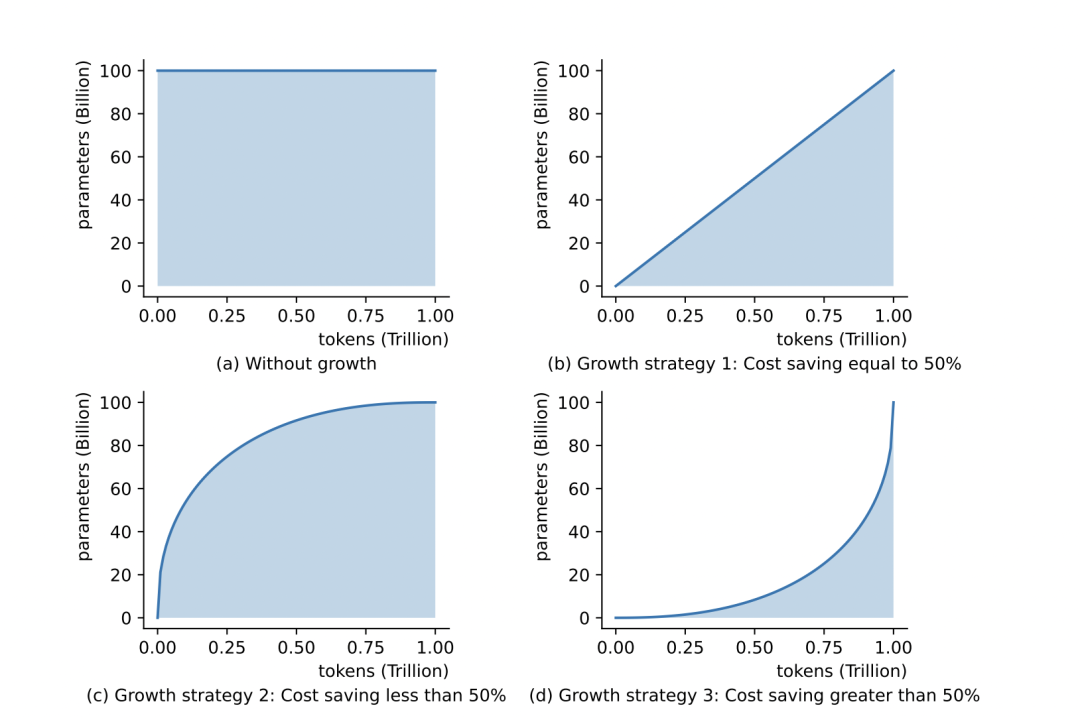

上图为不采用生长方法和三种典型的生长方法的训练情况对比。训练大模型的FLOPs(浮点运算次数)可作为衡量大模型的训练成本的最重要因素之一,其正比于图中阴影的面积。图示分析得出:可以采用激进的生长策略来最大可能节省训练成本。

受到前期研究工作MSG的启发,研究团队在千亿级别首次成功应用「生长策略」这一创新方法。MSG提出了一个完整的增长方法集合,涵盖Transformer的4个生长维度,其可通过逐渐从小型Transformer结构扩展到大型结构来加速大模型预训练。

了解更多MSG:

https://arxiv.org/pdf/2305.02869.pdf

模型设计方面,FLM模型采用FreeLM作为骨架。在模型结构的细节上,保留了FreeLM及GPT模型的设计,包括Pre-LayerNorm等,FLM在预训练策略上也继承了FreeLM。了解更多FreeLM:

https://arxiv.org/pdf/2305.01616.pdf

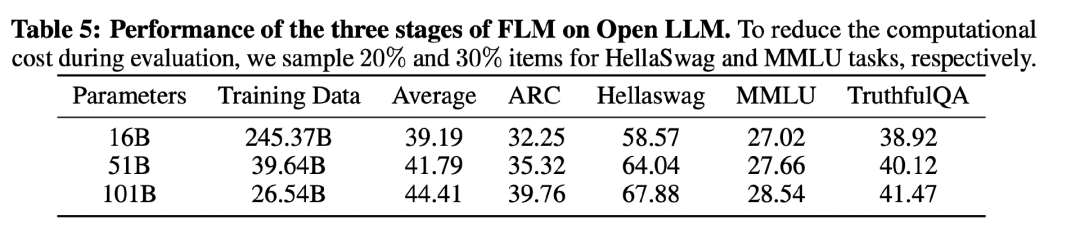

在模型尺寸方面,基于生长策略,有别于不同尺寸模型独立训练的常规方式,FLM依次训练了16B、51B和101B三个模型。这三个模型在训练过程中依次产生,后阶段的模型通过模型生长策略,得以继承前阶段模型学到的知识和习得的能力。训练全程在一个24节点的DGX-A800 GPU (8×80G)集群上完成,采用数据并行、张量并行、流水线并行的“3D并行”策略,以及利用序列并行进一步降低显存消耗。通过改进FreeLM的训练目标、应用最优超参数搜索方法、保值的模型生长方法等措施,保证了模型训练过程的稳定性。

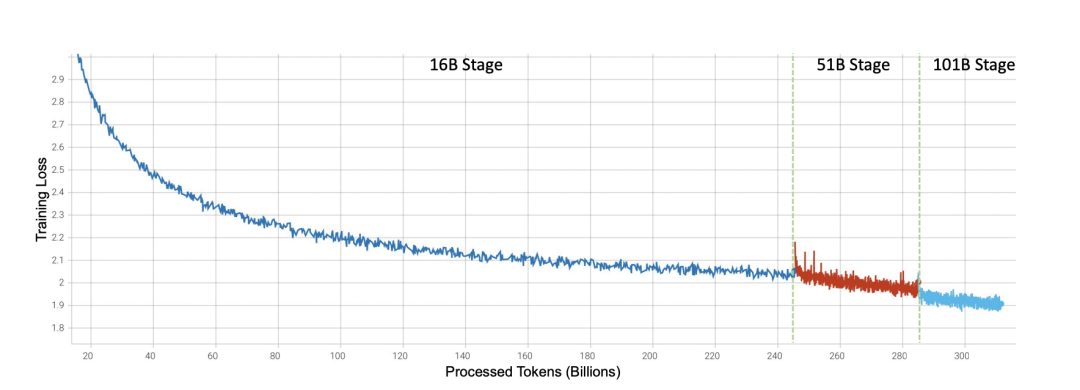

FLM系列模型的训练过程loss曲线

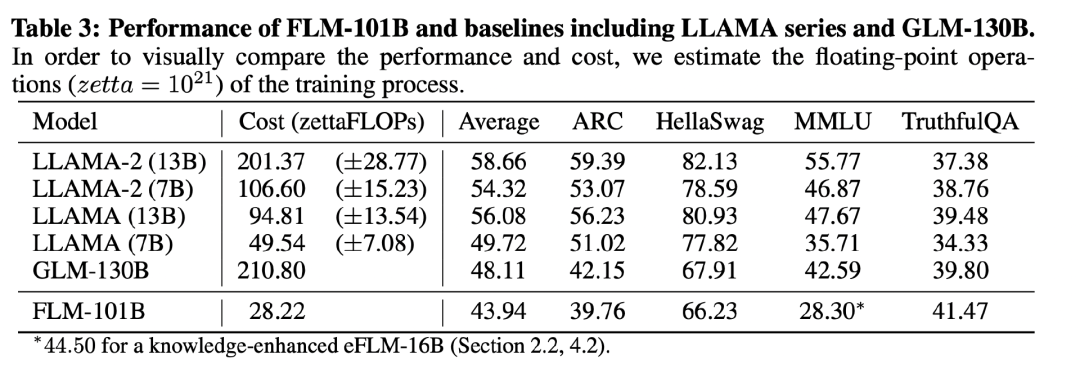

在最终的训练方案下,FLM-16B模型训练了245.37B tokens,FLM-51B模型训练了39.64B tokens,而FLM-101B模型训练了26.54B tokens。FLM系列模型的总训练时长为21.54天,与训练同样多数据的101B模型的非生长方案对比,实现了3.6倍的提速。同时,千亿模型的训练成本被控制在极低的水平 — 仅需10万美元的算力成本。FLM模型的知识能力也经过了多个评测基准的检验。实验结果表明,在更低的计算成本下,FLM-101B表现优于强基线模型。在下表3中,FLM-101B在Open LLM上的评测结果,以及与LLAMA 、GLM-130B对比结果显示,在绝对性能上,FLM-101B虽无优势(知识类的能力与训练数据量成正相关关系),但实现了花费10%的成本,达到80%+性能的目标。 在知识性评测方面,出于训练成本考虑,选取FLM-16B模型,在混合了知识性语料的数据集上进行增强训练,得到eFLM-16B进行实验。

在知识性评测方面,出于训练成本考虑,选取FLM-16B模型,在混合了知识性语料的数据集上进行增强训练,得到eFLM-16B进行实验。

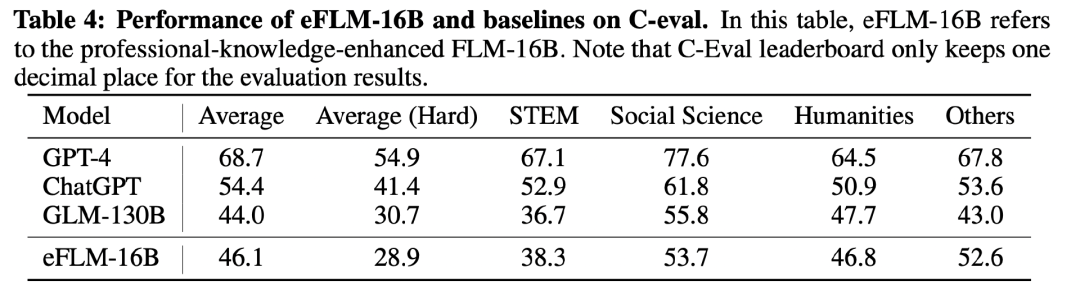

在专业知识评测基准MMLU上,eFLM-16B得分为44.50,超越了GLM-130B的42.59。而在采用较少计算量进行知识性增强前,FLM-16B的成绩仅为27.02 。在C-Eval中文知识评测中,eFLM-16B得分为46.1,超过了GLM-130B的44.0,而在知识增强前,FLM-16B的成绩仅为27.03。上述结果亦表明,大模型的知识能力可以通过加入知识性语料而获得快速提升。

eFLM-16B在C-Eval上的性能表现

在「生长策略」的知识继承度评测方面,选取Open LLM基准,分别对16B、51B、101B进行测试。如下图可以看出,随着模型的增大和少量训练数据的增加,模型的分数呈显著递增趋势。这表明,模型在生长前习得的知识能够很好地被生长后的模型继承。

4个维度,评测大模型的 IQ

目前大语言模型的评测方法多集中在知识性评测上,主流的大模型评测方式大致分为以知识为主的评测(如MMLU、C-Eval等)和NLP任务评测。但因为大模型需要的训练数据规模庞大,难以避免数据泄漏或过拟合问题导致的评测偏差问题。此外,知识与智能并不能直接划等号。以知识为主的评测可能难以全面反映模型的真实实力。因此,研究团队认为,IQ相关的评测,特别是采用了专门处理以避免数据泄漏影响的评测方法,可能会更公平客观地反映大型模型的智力水平。受IQ测试启发,研究团队从以下4个维度,对大模型的IQ展开评测:

-

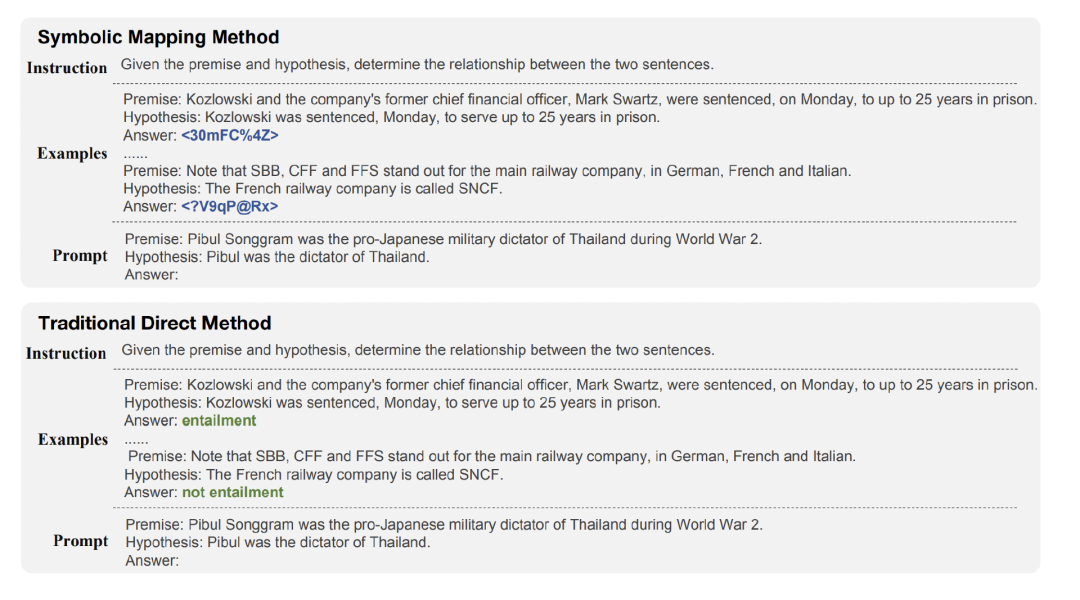

Symbolic Mapping 评测 (符号评测)

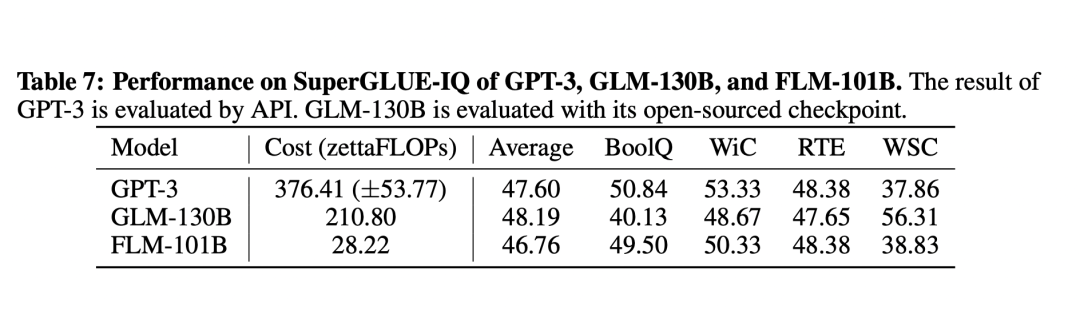

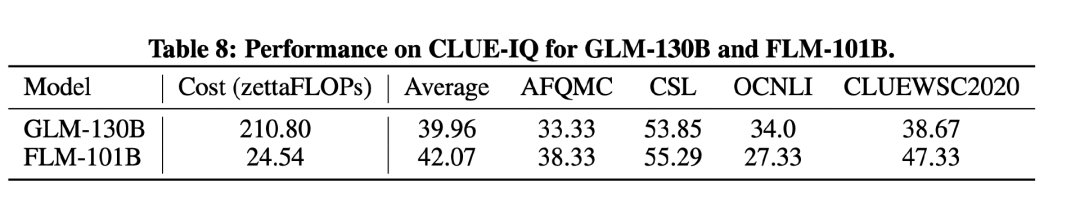

用信息含量更少的无意义符号作为文本标签,对SuperGLUE和CLUE评测基准进行改造,将其中的类别标签替换为随机字符串,以规避可能出现的评测数据泄露问题。此外,通过few-shot方法考察模型对陌生信息的理解和抽象能力。 下表7和表8分别显示了FLM-101B、GPT-3、GLM-130B在SuperGLUE-IQ和CLUE-IQ上的性能。结果显示:FLM-101B以较低的成本,实现了与二者相当的性能。

下表7和表8分别显示了FLM-101B、GPT-3、GLM-130B在SuperGLUE-IQ和CLUE-IQ上的性能。结果显示:FLM-101B以较低的成本,实现了与二者相当的性能。

-

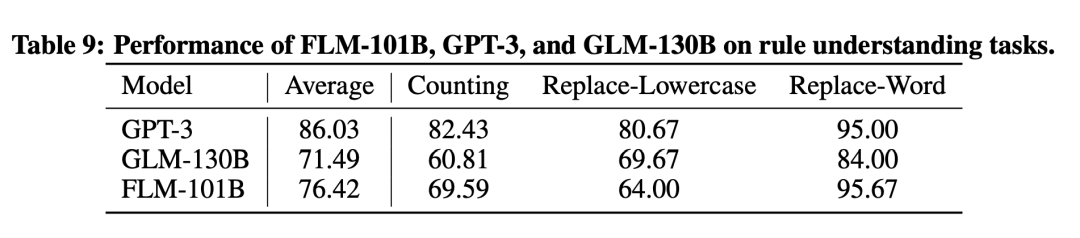

Rule Understanding 评测(规则理解)

准确理解指令并根据指令完成任务是大模型“智能”水平的一个重要体现。在规则理解方面,设计了Counting、Replace-Lowercase、Replace-Word 三种子任务。

如下图实验结果显示,FLM-101B在规则理解任务上的表现不输GPT-3 和 GLM-130B ,其中FLM-101B在Replace-Word子任务得分为95.69,超过 GLM-130B的84分,与GPT-3 持平。

-

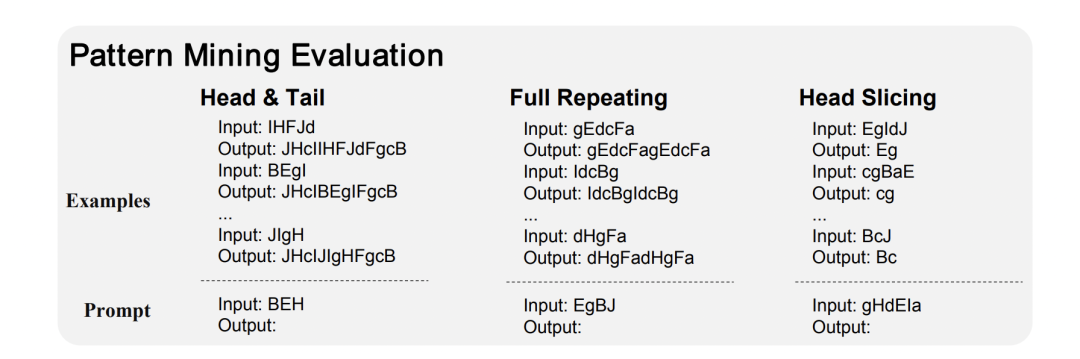

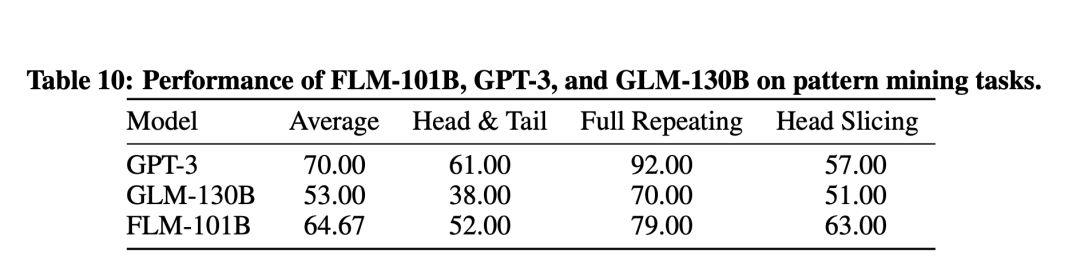

Pattern Mining 评测(模式挖掘)

模式挖掘包括归纳、演绎过程,考察模型对文本中出现的模式的归纳和演绎能力。对此设计了三种子任务:Head & Tail、Full Repeating、Head Slicing,分别让模型从few-shot例子中发现输入和输出之间的规律。 实验结果如下:FLM-101B在Average及3项子任务得分均超过了GLM-130B,并在Head Slicing任务上超过了GPT-3。

实验结果如下:FLM-101B在Average及3项子任务得分均超过了GLM-130B,并在Head Slicing任务上超过了GPT-3。

-

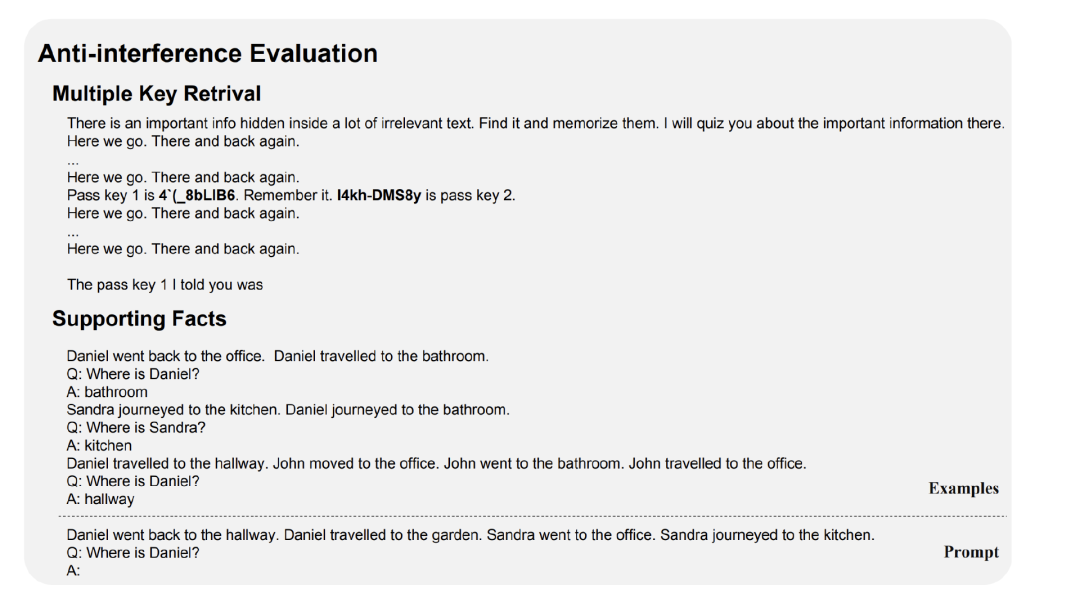

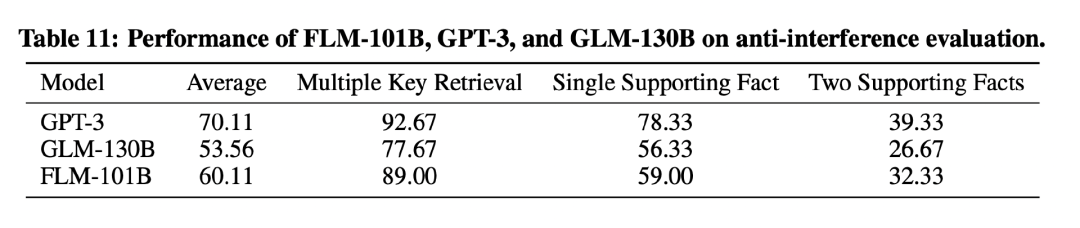

Anti-interference 评测(抗干扰评测)

抗干扰能力也是衡量大模型“智能”的一项重要指标。该评测考察模型在充满“噪声”的环境中寻找和利用与特定目标真正相关的信息的能力。针对这一考察目标设计了两个任务:Multiple Key Retrival和Supporting Facts。 实验结果可以看出,FLM-101B在Average及2项子任务的得分均超过了GLM-130B。

实验结果可以看出,FLM-101B在Average及2项子任务的得分均超过了GLM-130B。

小结:

为了进一步降低大模型的训练成本,研究团队采用了「生长策略」,首次成功地将千亿稠密大模型的算力成本降低到70万元。此外,为了更加全面、合理地评测大模型,研究团队在目前已有的知识类评测的基础上,借鉴IQ测试的概念,提出了大模型的IQ测试方案。

实验显示,用70万算力成本训练成功的千亿大模型表现出了非常好的能力。这表明,构建一个拥有较高智商但较少知识的语言模型,然后在不同领域扩展大模型的知识(以适应领域),或是一种有效降低大模型计算成本并实现可持续发展的有效路径。更重要的是,研究团队相信「生长策略」可以为突破单体稠密万亿模型带来全新的可能性。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง