关键词:静5青年讲座

编者按

2023年9月19日,王鑫博士访问北京大学前沿计算研究中心,并在静园五院作了题为“Foundations of Multimodal Embodied Agents for Human-Agent Collaboration”的报告,介绍了他与合作者在人机交流合作的多模态具身智能上的研究。此报告由中心助理教授董豪老师主持。

王鑫博士报告现场

王鑫老师从具身智能的定义出发。具身智能是指可以感知环境、与人交户并在真实世界中实施行动的智能体。能力较强的智能体可以在人为干涉最少(给出一两句话的指令)的情况下完成任务,而能力较弱的智能体只能在人为指导下一步一步执行动作。对于在两者之间的智能体,我们可以让智能体与人进行即时的互动,以合作的方式完成任务。

人机合作的智能体包括三个方面:环境探索(navigation)、人机交流(communication)、实机操作(manipulation)。接下来王老师的讲座围绕这三个方面的工作展开。

首先,环境探索方面,一个基本的问题是在指定环境中寻找特定物体(object navigation),而在这个问题中比较具有挑战性的一个分支是零视物体寻找(zero-shot object navigation),智能体需要寻找一个它在训练时没有见过的物体。这个任务要求模型具有较高的泛化性。同学们也对这个问题同王老师展开了讨论。

为此,王老师的团队提出利用常识来对环境探索施加限制,完成高效的物体寻找(ESC: exploration with soft commonsense constraints,ICML2023)。该方法首先使用预训练的 GLIP 模型来实现目标检测和语义信息解读,然后利用现有的大语言模型来提供环境探索的偏好,同时利用 PSL(Probabilistic Soft Logic)施加一系列的规则对候选物体进行筛选,得到最终的预测结果。

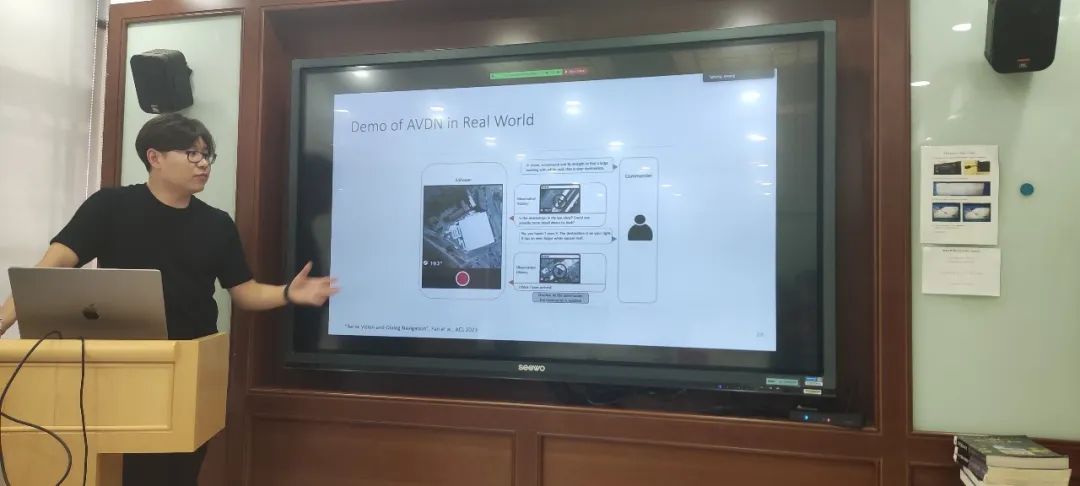

其次,人机交流方面,随着 ChatGPT 代表的大语言模型兴起,使用对话的方式来指导智能体行动也有了落地的可能。对此,王老师的团队在无人机的操控任务上提出结合视觉信息和人机对话来实现特定地点的搜寻(Aerial Vision-and-Dialog navigation,ACL 2023)。同时团队也收集并制作了 AVDN 数据集,包含超过3000个无人机飞行轨迹记录以及在飞行过程中操控者模拟的人机交互对话。

实机操作被视为具身智能中的“最后一公里”问题。当智能体通过感知环境规划自己的行动之后,就需要借助对应的机械设备在真实世界中完成指定的动作。延续在无人机任务上的想法,王老师团队制作了结合视觉信息与语言信息辅助操作的数据集(VLMbench: A Compositional Benchmark for Vision-and-Language Manipulation,NeurIPS 2022)。在此基础上,王老师提出了一个操作的自动化求解系统(Automatic Manipulation Solver),能够将原始任务分解为若干个原子任务,再依次执行。

在讲座的结尾,王老师谈到了他对未来工作的展望。除了人机合作式智能体的进一步发展,王老师还关注到了以人为中心、侧重于隐私保护、安全性和透明性的智能体构建。这类智能体能够满足更多的应用场景,使具身智能真正走向家用。讲座在听众们的热烈掌声中结束。

报告回放:

图文 | 黄蔚尧

往期讲座

— 版权声明 —

本微信公众号所有内容,由北京大学前沿计算研究中心微信自身创作、收集的文字、图片和音视频资料,版权属北京大学前沿计算研究中心微信所有;从公开渠道收集、整理及授权转载的文字、图片和音视频资料,版权属原作者。本公众号内容原作者如不愿意在本号刊登内容,请及时通知本号,予以删除。

点“阅读原文”转报告回放链接

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง