End-to-End Speech Recognition Contextualization with Large Language Models

E Lakomkin, C Wu, Y Fathullah, O Kalinli, M L. Seltzer, C Fuegen

[Meta AI]

基于大语言模型的端到端语音识别上下文化

- 提出一种新方法,使用大型语言模型(LLM)对语音识别进行上下文化。

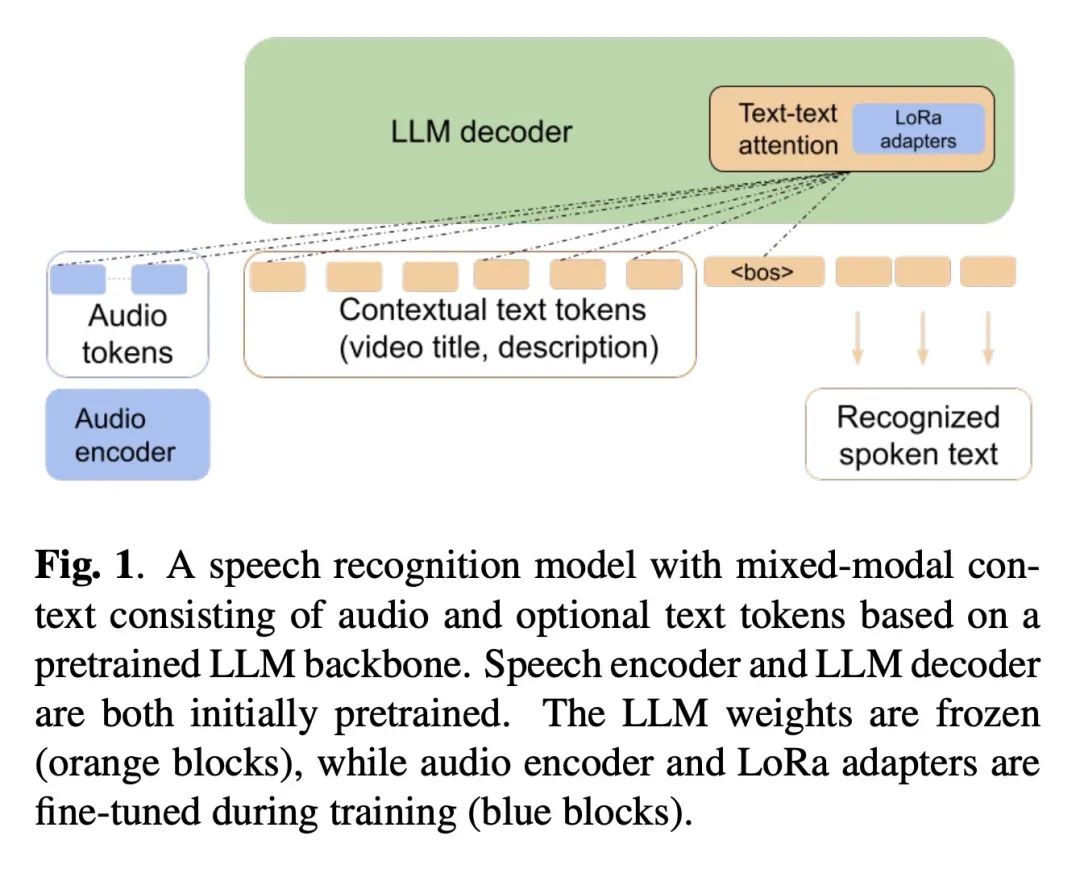

- 将语音识别建模为基于预训练LLM骨干的混合模态语言建模任务。

- 为LLM提供音频特征和可选文本上下文Token作为输入,以仅解码器方式完成转录。

- 提供文本上下文,与不提供上下文相比,WER降低了6%。

- 在整体WER上比在更多语音数据上训练的上下文化RNN-T基线好7.5%,在罕见词WER上好17%。

- 通过仅为LLM添加少量可训练参数的适配器,显示了具有竞争力的性能。

- 保持了原LLM的仅文本功能,同时解锁了上下文化语音识别能力。

动机:旨在提出一种新方法,将大型语言模型(LLM)引入语音识别模型的上下文化过程中,以提高性能和泛化能力。 方法:将语音识别视为基于预训练LLM的混合模态语言建模任务,通过提供音频特征和可选文本Token来训练系统以完成转录。 优势:在性能方面取得了显著的改进,当提供额外的文本上下文时,识别误差率(WER)降低了6%。此外,与基线的上下文化RNN-T系统相比,在整体上提高了7.5%的WER,并在罕见词上提高了17%的WER。通过仅添加少量可训练参数,可以为预训练LLM解锁上下文化语音识别能力,同时保持相同的文本输入功能。

提出了一种基于大型语言模型的上下文化语音识别方法,通过引入上下文信息,显著提升了性能和识别准确率。

https://arxiv.org/abs/2309.10917

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง