关键词:神经网络,自然语言模型,生成模型,语言感知

论文标题:Testing the limits of natural language models for predicting human language judgements论文来源:Nature Machine Intelligence斑图链接:https://pattern.swarma.org/paper/75e60c8e-5352-11ee-933f-0242ac17000d原文链接:https://www.nature.com/articles/s42256-023-00718-1

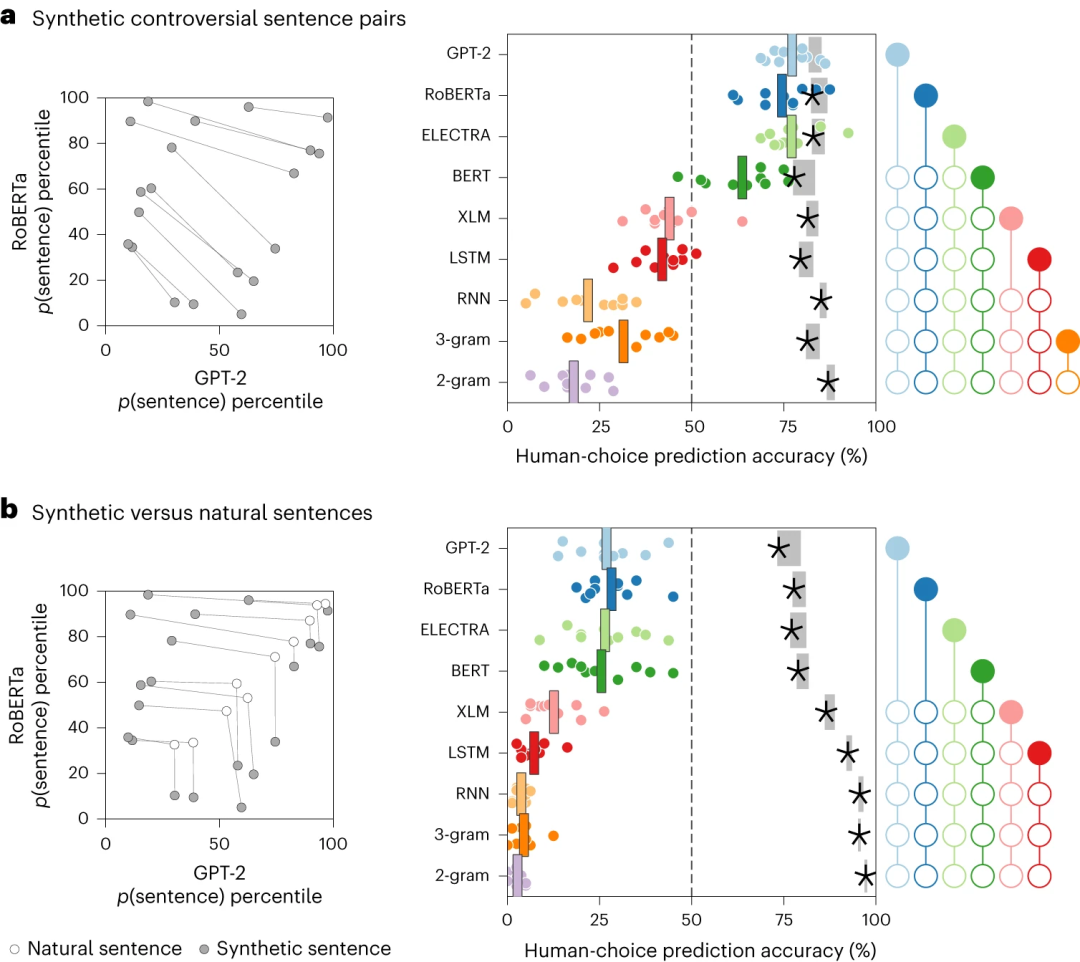

神经网络语言模型似乎越来越符合人类处理和生成语言的方式,但因为语言是离散的且人类语言感知的复杂性,因此通过对抗性示例来识别它们的弱点具有挑战性。文章通过将这些语言模型互相对抗来绕过这些限制。作者生成有争议的句子对,其中两个语言模型对于哪个句子更有可能出现存在不同意见。考虑到九种语言模型(包括 n-gram、循环神经网络和 transformer),作者通过合成优化或从语料库中选择句子来创建了数百个有争议的句子对。

有争议的句子对在揭示模型失效和确定与人类判断哪个句子更有可能出现最吻合的模型方面非常有效。 图1 使用合成句子进行模型比较

图1 使用合成句子进行模型比较

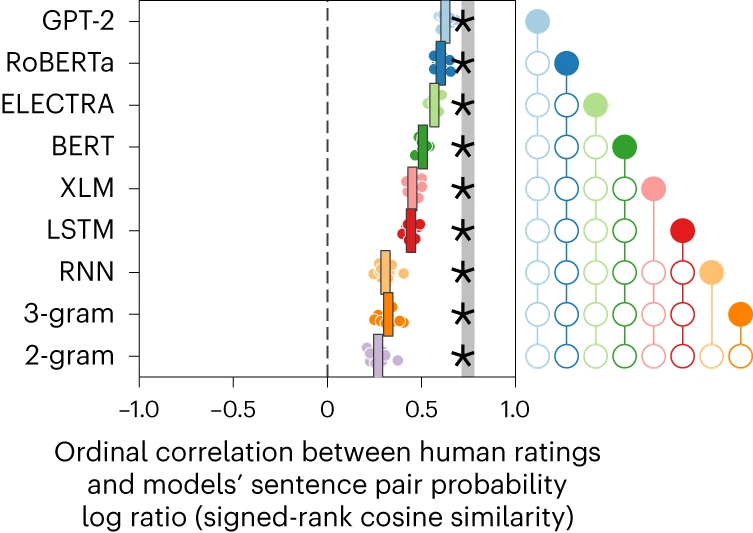

在测试中,与人类一致性最高的模型是GPT-2,尽管实验揭示了它在与人类感知的一致性方面存在相当大的不足。 图2 模型的句子概率对数比和人类Likert评分的序数相关性。

图2 模型的句子概率对数比和人类Likert评分的序数相关性。

足够强大的语言模型可以将实验设计搜索空间限制为特定的句子分布(例如,电影评论或医疗问题)。在这种受限的空间内可以寻找能够引发替代领域特定模型相互矛盾预测的良好构造句子。然而,正如结果所示,捕获良好构造句子的分布并不像看起来那么简单。

编译|董佳欣

“后ChatGPT”读书会

详情请见:

“后 ChatGPT”读书会启动:从通用人工智能到意识机器

推荐阅读

1. 论文清单:一文梳理因果推理在自然语言处理中的应用2. 如何量化语言亲密度?自然语言处理在计算社会科学中的应用3. Nat. Commun. 速递:抽象表征从训练执行多任务的神经网络中自然涌现4. 张江:第三代人工智能技术基础——从可微分编程到因果推理 | 集智学园全新课程5. 成为集智VIP,解锁全站课程/读书会6. 加入集智,一起复杂!

点击“阅读原文”,报名读书会

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง