Small-scale proxies for large-scale Transformer training instabilities

M Wortsman, P J. Liu, L Xiao, K Everett, A Alemi, B Adlam…

[Google DeepMind]

大规模Transformer训练不稳定性的小规模代用指标

要点:

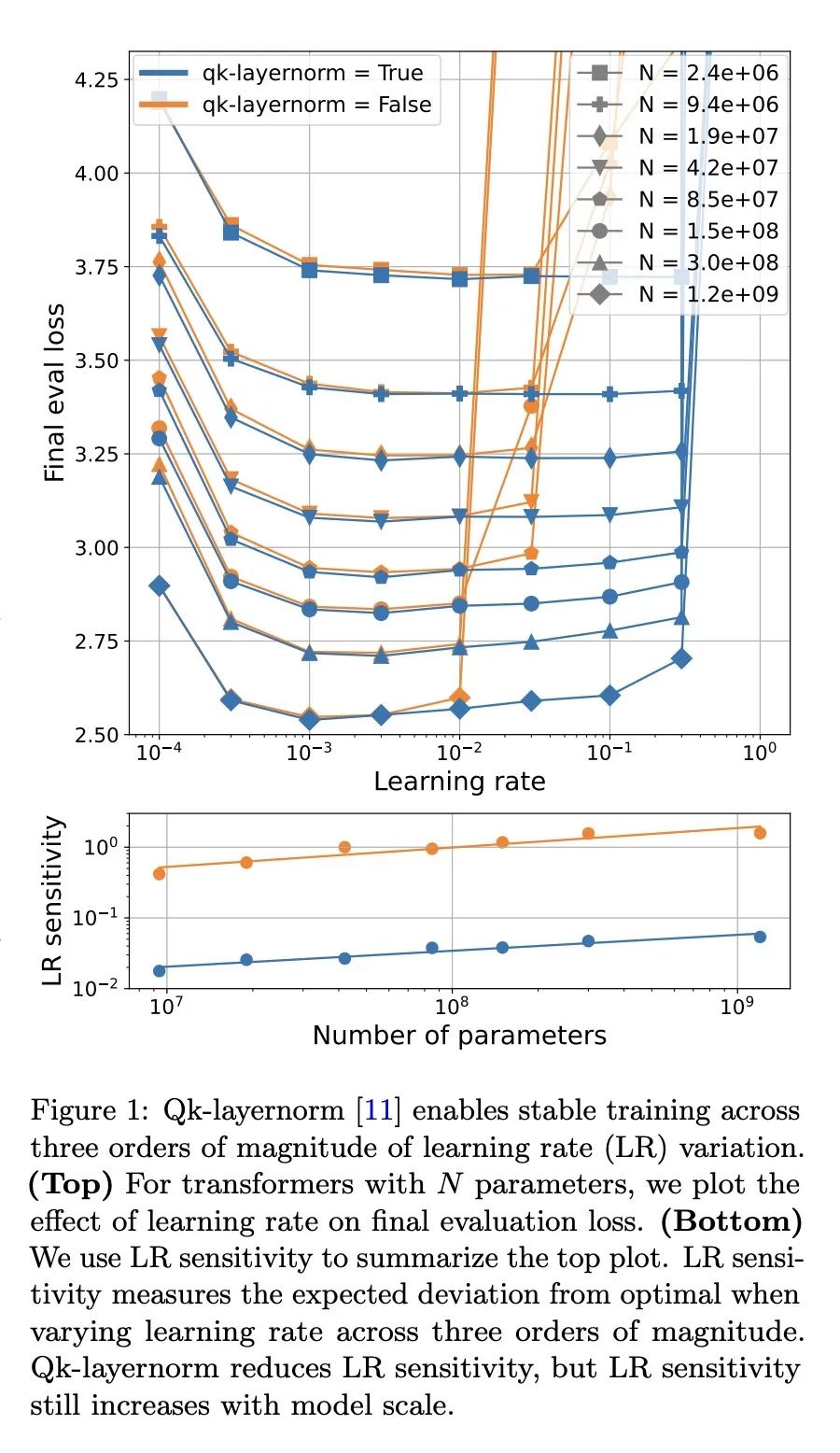

- 在扩展Transformers模型规模时,研究人员报告了在小规模下没有出现的训练不稳定性。研究这些不稳定性需要大量计算资源,使得调查变得困难。本文旨在在小规模的Transformers中重现和研究训练稳定性。

- 查明了两种已知的不稳定性:注意力层中的logits增长和输出logits与对数概率的偏离。通过测量学习率与损失的关系,这些不稳定性在高学习率下出现在小模型中。大规模使用的缓解方法在这种情况下对小模型同样有效。

- 研究了其他模型和优化器的干预对学习率敏感性的影响,例如warm-up、权重衰减和μParam,组合这些技术可以在学习率变化量级相同的情况下训练出小模型。

- 模型特征的扩展行为,如activation norms,可以预测不稳定性出现前的情况。已预测注意力logit增长并经验证,随着规模和学习率的增加,Gradient norms有所减小,这表示需要调整优化器超参数。

动机:大规模Transformer训练存在不稳定性,但由于资源需求较大,调查这些不稳定性变得困难。 方法:通过在小尺度上复现和研究训练稳定性和不稳定性,研究学习率和损失之间的关系,研究其他优化器和模型干预方式对学习率变化的敏感性,研究模型特征的缩放行为。 优势:通过在小模型上的研究,可以在不需要大规模资源的情况下研究训练稳定性,为研究提供新的科学机会。

一句话总结:

通过在小尺度上复现和研究大规模Transformer训练的不稳定性,提供了研究训练稳定性的新方法,探索了学习率和损失之间的关系以及其他优化器和模型干预方式对学习率变化的影响。

https://arxiv.org/abs/2309.14322

正文完

可以使用微信扫码关注公众号(ID:xzluomor)