今天是2023年9月27日,星期二,今天刚从重庆回京,在昨天举办的情报+大模型产业专家论坛上与许多大佬聊了聊大模型与情报方面的工作,很有启发。

夜晚之余,出去逛了逛,一个狠明显的感觉:重庆是个8D城市,与规整的北京相比,风格迥异。

3

3

这两天因为出差折腾,所以没有顾得上写,所以今天多写一些,来介绍了三个事情,第一个是关于大模型的十二大综述,第二个是Google DeepMind使用小规模模型来研究大规模模型训练不稳定性问题,第三个是HALO:检测及缓解大模型幻觉的方案。

这三方面的内容都是当下大模型的研发热点,供大家一起参考。

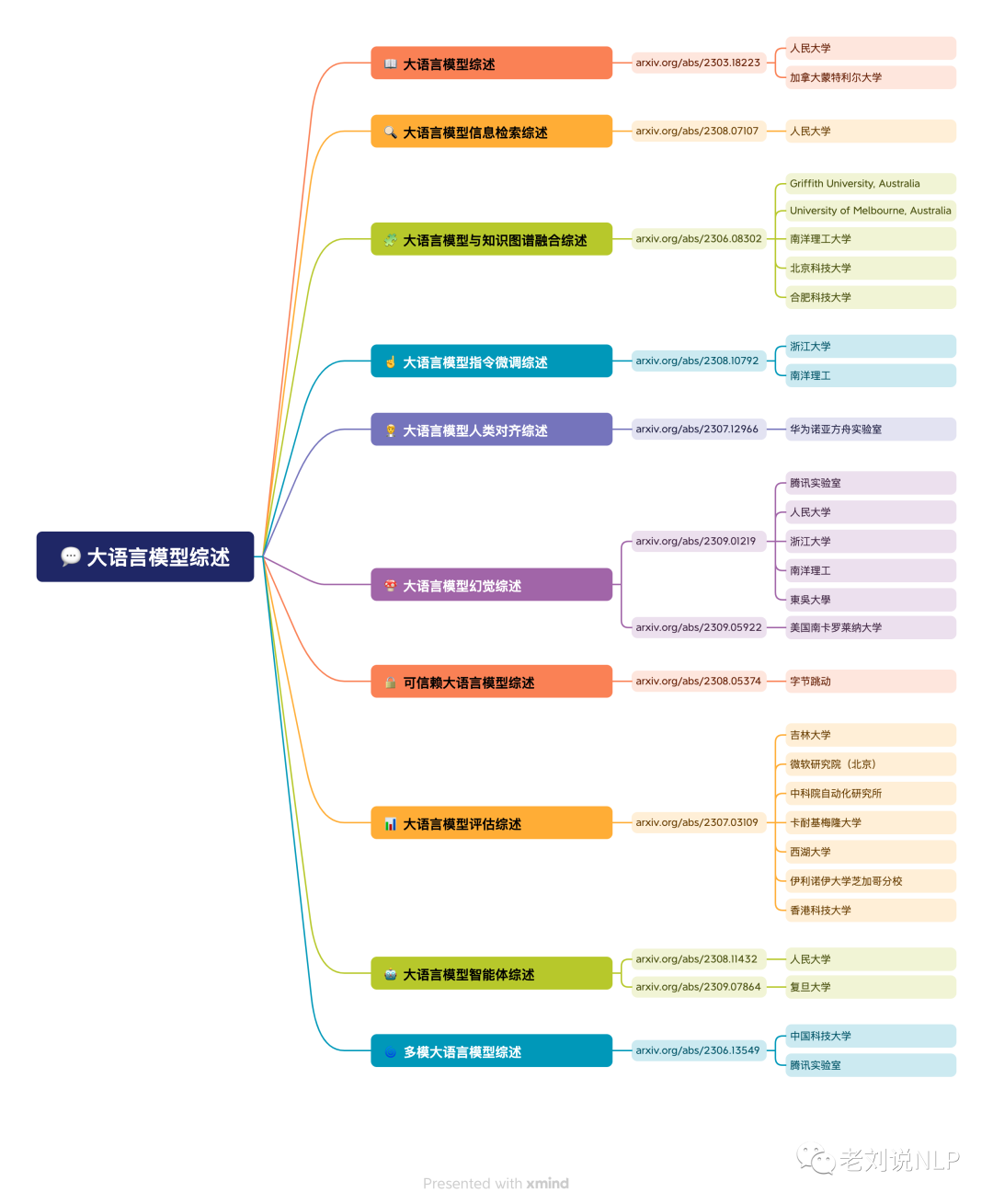

一、关于大模型的十二大综述

当前,大模型综述越来越多,也逐步体系化,社区对这部分内容进行部分梳理【感谢成员王涛老师整理】,

而加上最新出来的2个,大模型相关综述已经达到12个。

1、大语言模型综述

地址:https://arxiv.org/abs/2303.18223

2、大语言模型信息检索综述

地址:https://arxiv.org/abs/2308.07107

3、大语言模型与知识图谱融合综述

地址:https://arxiv.org/abs/2306.08302

4、大语言模型指令微调综述

地址:https://arxiv.org/abs/2308.10792

5、大语言模型人类对齐综述

地址:https://arxiv.org/abs/2307.12966

6、大模型幻觉综述

地址:https://arxiv.org/abs/2308.05374

7、可信赖大语言模型综述

地址:https://arxiv.org/abs/2309.01219、https://arxiv.org/abs/2309.05922

8、大语言模型评估综述

地址:https://arxiv.org/abs/2307.03109

9、大语言模型智能体综述

地址:https://arxiv.org/abs/2308.11432、https://arxiv.org/abs/2309.07864

10、多模大语言模型综述

地址:https://arxiv.org/abs/2306.13549

11、大语言模型压缩技术综述

地址:https://arxiv.org/pdf/2308.07633.pdf

12、大语言模型可解释性综述

地址:https://arxiv.org/abs/2309.01029.pdf

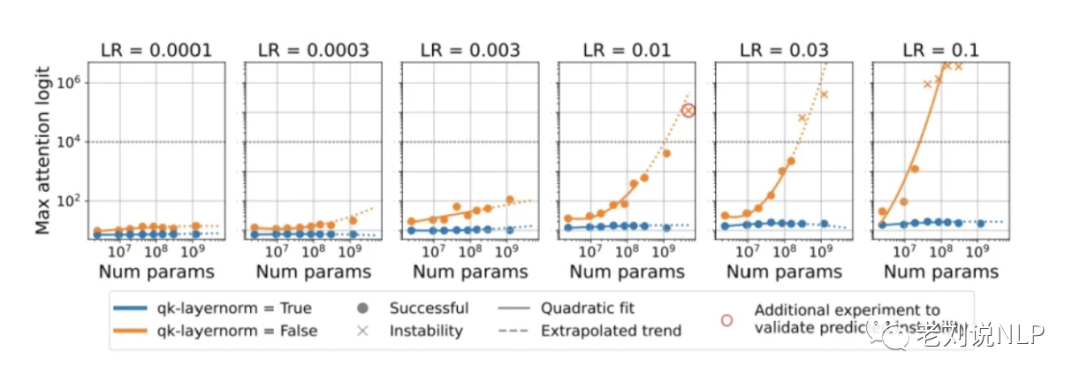

二、用小模型揭秘大模型训练不稳定问题

随着Transformer模型越来越大,训练稳定性变得越来越重要。过去训练大规模基于Transformer的模型时报告了些大规模下才会出现的训练不稳定性,这些不稳定性的成因具有科研价值,但需要大量计算资源来重现,使得研究很闲难,鉴于大规模模型训练不稳定性重现难度大,有必要研究如何在小规模下重现并研究这些不稳定性,以降低计算门槛。

Google DeepMind的工作《Small-scale proxies for large scale Transformer training instabilities》这一文章使用小规模模型来研究大规模Transformer模型的训练不稳定性问题,通过调整超参数,如使用高学习率,在小规模模型上可以重现大规模模型中的训练不稳定性,然后对这些不稳定性进行研究,同时也可研究不同的模型和优化器千预对最终损失对学习率变化敏感性的影响。

地址:https://arxiv-vanity.com/papers/2309.14322

我们来重点看一下结论,该工作指出,学习率与损失关系曲线和学习率敏感性是有用的工具,可以辨识和研究训练不稳定性。

可以在小规模模型上重现和研久之前在大规模横型训练中报告的两种不稳定性(注意力层logits增长和输出logits与对数概率发散)。

一些模型和优化器的干预技术(如qk-layernorm,Z-loss正则化、更长的预热期、独立调整权重衰减等)可以改善训练稳定性。

通过分析模型特征(如激活值、梯度等)的缩放趋势,可以预测训练不稳定性,在不稳定性出现之前就可以检测到。

通过梯度范数的缩放趋势,发现当前的AdamWepsilon默认值过大,导致了更新过小的问题,减小epsilon可以改善训练效果。

通过在小规模模型上研究大规模模型的训练Dynamics,可以在没有大量计算资源的条件下开展有影响力的研究,使之有利于大规模模型的训练。

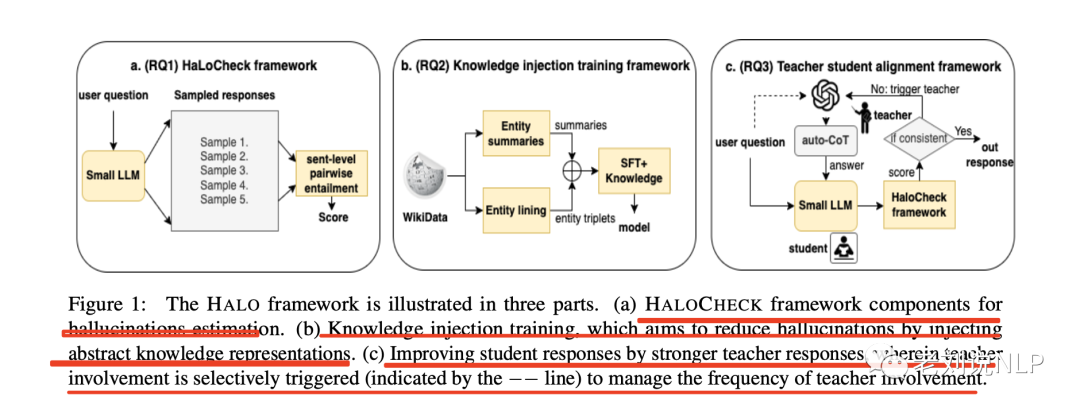

三、HALO:检测及缓解大模型幻觉的方案

文章《HALO: Estimation and Reduction of Hallucinations in Open-Source Weak Large Language Models》针对bloom模型的幻觉问题,进行缓解的探索实验。该工作以BLOOM7B为例,探讨了在开源弱语言模型中量化和减轻幻觉的问题。

地址:https://openreview.net/pdf?id=HklBjCEKvH

为了解决幻觉的测量问题,该工作引入了一种名为HALOCHECK的新型BlackBox无知识框架

为了减轻幻觉,该工作探索了将知识注入LLM的方法,研究结果表明这种方法是增强模型特定领域知识的直接手段。

该工作还研究了利用较强的教师模型来指导较弱的LLM的效果,结果表明这种技术与知识注入技术相辅相成,提高了鲁棒性较弱的LLM的性能。

但是,缺点也很明显:

在这项工作中,该工作只纳入了一个弱开源LLM(BLOOM7B)的例子。此外,为了便于分析,该工作有意只关注NBA领域。一般来说,依赖自动生成的问题有其局限性,因为这些问题可能并不总是与人类查询一致,或者在某些情况下可能不够清晰。虽然该工作的技术有可能扩展到类似的模型并覆盖更多的领域,但必须承认结果可能会有所不同。

该工作旨在解决三个研究问题,也就是如下图所示:

1、如何量化LLM中幻觉的严重程度?

在减少幻觉的背景下,该工作最初的重点是开发一种自动、高效的方法,以估算模型生成的输出中存在幻觉的严重程度。为了解决这个问题,该工作引入了HALOCHECK,这是一个基于采样的轻量级黑盒无知识框架。

LLM中的幻觉检测在各种NLP任务中,包括摘要、对话和问题解答,都对检测幻觉进行了探索。最近在消除LLM幻觉方面的工作可分为两种方法:自动评估和人工评估。

在自动评估方面,之前的工作有selfcheckGPT,这是一种BlackBox无知识度量,利用现有的评估指标,包括BERTScore和基于QA的评估指标,以及n-gram语言模型,来衡量自然语言生成任务中生成样本之间的一致性。

此外,也有引入了基于LLM的BlackBox评估指标,用于衡量文本生成任务中生成样本之间的矛盾。该指标利用LLM的能力来评估生成文本中存在的矛盾。

在实现上,该框架采用句子级蕴含方法来定量评估生成输出中的幻觉程度(如图1a所示)。

采用”蕴含”的理由是,回答可能看似相似,但仍有相互矛盾的信息,这可能会误导selfcheckGPT-BERTScore和selfcheckGPT-ngram,使其错误地判断为一致;对于问题的回答,尤其是简短的问题,使用n-gram模型进行可能性估计可能效果不佳。该方法不需要像selfcheckGPT-QA那样的问题生成迭代模块,因此更省时。

该方法认为,一个可靠的模型可以用不同的措辞对给定的提示做出回应,同时保留彼此一致的主要内容。

因此,该工作设计的HALOCHECK可以为一组抽样回答A={A1,…,An}计算得分μ,其中n是给定提示的抽样回答数,该工作设置n=5(任意选择4)。

得分μ表示回复的一致性水平,其中min(μ)=⇒inconsistent(A),max(μ)=⇒consistent(A)。

该方法与selfcheck-GPT主要的区别点在于:

其一,selfcheck-GPT使用句子级BERTScore或问题解答(QA)一致性来计算样本间的一致性,该工作依赖于回答对之间的句子级entailment(蕴含),主要利用SUMMAC方法(最初设计用于测量源文本和生成摘要之间的一致性)。

在该工作采用zeroshot句子级SUMMAC(SummaCzs),利用基于RoBERTa的多语言词义蕴涵模型,计算两个给定LLM回答的句子对之间的成对词义蕴涵。

计算结果的得分范围为[-1,1],其中得分范围在[-1,0]之间表示两个文本之间存在矛盾(-1表示样本之间完全矛盾),得分范围在(0,1]之间表示一致(1表示完全一致)。

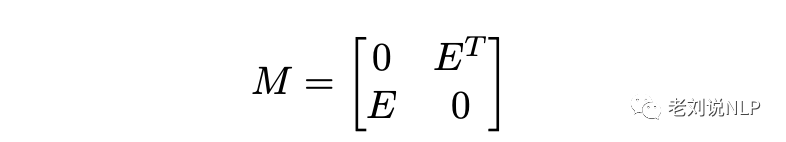

回答之间的成对蕴涵可表示为双向图,其广告矩阵M可表示为正方形矩阵:

在给定的等式中,U(M)=L(M)T,其中U和L分别代表上三角矩阵和下三角矩阵。这一对称性成立的原因是SUMMAC(Ai,Aj)=SUMMAC(Aj,Ai),其中i和j分别代表矩阵M中的行和列。

因此,矩阵M中的E和ET代表生成的A1到An的所有组合对之间计算出的SUMMAC分数。因此,该工作计算出一致性得分μ=mean(E)。

在SummaCzs的基础上,该工作得出结论:一致性得分μ的范围为[-1,1],得分-1表示回答之间完全矛盾,得分1表示完全一致或一致(0为中性)。

其二,与selfcheckGPT最初的激励机制主要通过衡量基于其他样本的句子级支持水平来评估生成回复的事实性不同,该工作在评估过程中对所有生成的样本给予同等重视,确保在所有回答中提供的信息保持一致。

我们看下效果:

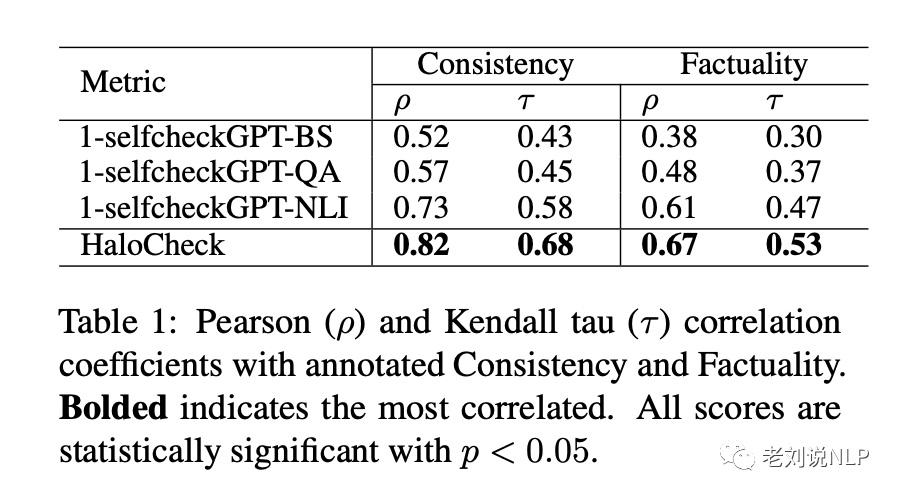

表1列出了相关性分析,显示与所有自检GPT方法(包括最近推出的基于词义的方法)相比,HALOCHECK在一致性和事实性指标上与人类注释得分的相关性更高。

值得注意的是,基于词义的方法比依赖BERTScore或QA方法的方法表现更好,这与该工作的假设一致,即基于词义的方法可以更有效地评估幻觉的严重程度。

为了与HALOCHECK保持一致,该工作报告了1-selfcheckGPT分数,因为selfcheck-GPT分数范围为[0,1],其中0表示完全一致。

在所有指标中,与事实性得分的相关性始终低于一致性得分,这可能是由于BlackBoxmetric在捕捉模型持续生成不准确响应的情况时存在局限性。

2、如何在不使用指令调整的情况下增强LLM的知识?

该工作的目标是通过知识注入(KI)来增强小型LLM的知识。这种方法涉及利用特定领域的知识对小型LLM进行微调,而不依赖人工输入结构或从更强大的LLM获取的指令,因为大规模生成这些指令可能会耗费大量资源。此外,从更强大的LLM获取的指令可能无法在研究环境之外使用。

在具体实现上,该工作探索了两种知识注入途径:实体摘要和实体三元组(如图1b.所示),来源于WikiData知识库。具体的:

对于摘要,该工作利用维基百科API从NBA维基百科页面中提取的NBA实体列表,其中有1121个独特的实体。该工作为列表中的每个实体提取了一页和两页的摘要,作为可信的事实信息来源。

API地址:https://pypi.org/project/Wikipedia-API/

对于实体三元组,每个实体都被视为主题实体,该工作使用WikiDataAPI从主题实体中提取相应的目标实体以及它们之间的关系。例如,对于”尼古拉-约基奇”这个实体,实体三元组的例子是”尼古拉-约基奇,丹佛掘金队选中”。

API地址:https://pypi.org/project/Wikidata/

这种方法发掘了摘要之外的更深层次的知识,与之前的工作(不同,该工作保留了三元组格式,而不是将其转换为自然语言。值得注意的是,这一决定并没有影响生成回复的自然性。最终的知识注入集由54K个训练样本组成。

我们同样来看下结论:

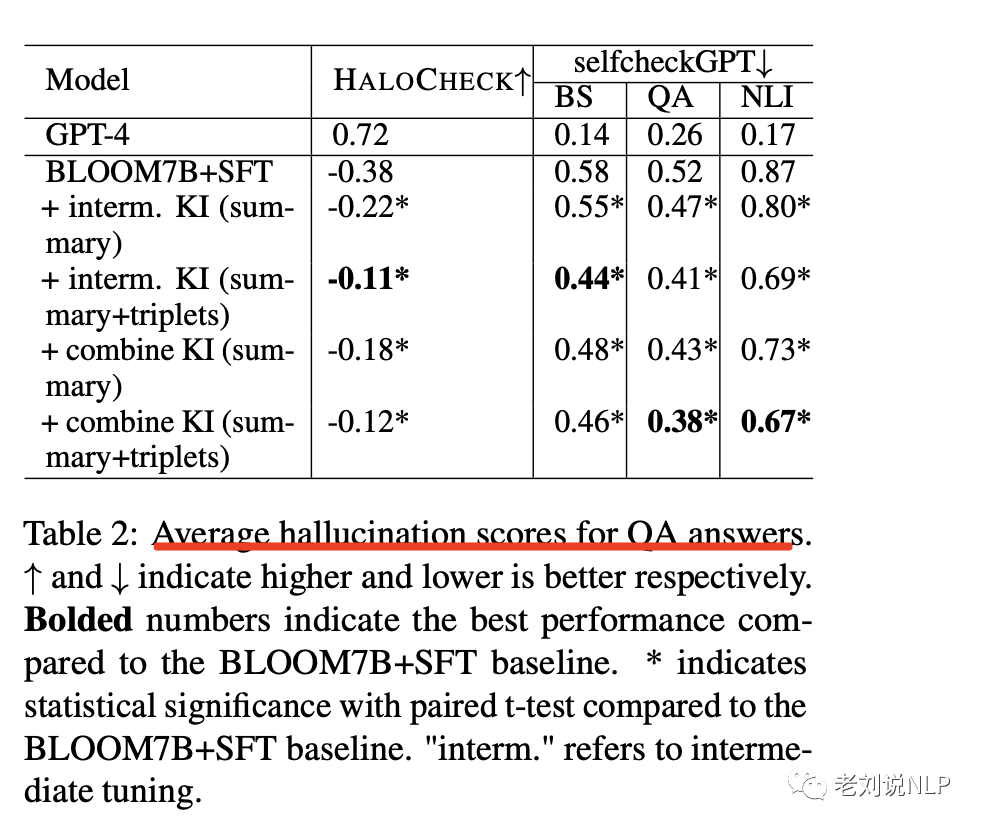

该工作给出了整个QA数据集的HALOCHECK分数和selfcheckGPT变体的平均值,该工作将进行知识注入调整的BLOOM7B与仅在SFT数据和GPT-4上进行微调的BLOOM7B进行了比较。

如表2显示,在所有评估指标中,所有知识注入训练方法都明显优于仅在SFT数据上进行微调的BLOOM7B。同时使用摘要和三元组的结果最好,这证实了假设,即与单独使用摘要相比,三元组可以挖掘出更深层次的关系和知识。

此外,值得注意的是,中间知识注入训练的结果与综合知识注入训练的结果一致,这表明模型在中间调整过程中保留了注入的知识。

尽管通过知识注入取得了改进,但模型的平均性能仍然不稳定。这表明,即使注入了特定领域的知识,单纯的知识注入可能也不足以彻底解决幻觉问题。

3、更强大的教师模型能否帮助指导较弱的模型?

该工作研究了如何利用更强大的LLM(特别是GPT-4),通过生成问题的详细答案来为较弱的LLM提供指导。该工作还研究了将”HALOCHECK”作为幻觉评估工具的实际应用。

具体的,为了评估向学生提供答案是否能减少幻觉,该工作假定学生一直依赖教师的帮助,这样就能估算出教师的一致性对改善学生回答的影响的上限。

该工作据此提示GPT-4,赋予它NBA专家的角色,并指示它准确、忠实地回答问题。为了给学生模型提供详细的答案,用自动思维链(auto-CoT)增强了提示,促使GPT-4将其回答分解为详细的步骤。

提示的结构如下:

-角色:"""你是NBA专家。你将得到一个问题,你的任务是准确、忠实地回答。""

-问题:问题:""""问题:{}"""

-自动作答:""""逐步回答:"""

生成的详细答案会在提示学生模型之前预置到问题中。

通过评估幻觉的严重程度,该工作旨在优化教师LLM的参与,从而减少对教师模型的频繁询问,只有在检测到学生回答不一致时才触发教师回答。 这种策略的优势在于减轻了计算负荷,并降低因严重依赖广泛参数LLM而产生的成本。

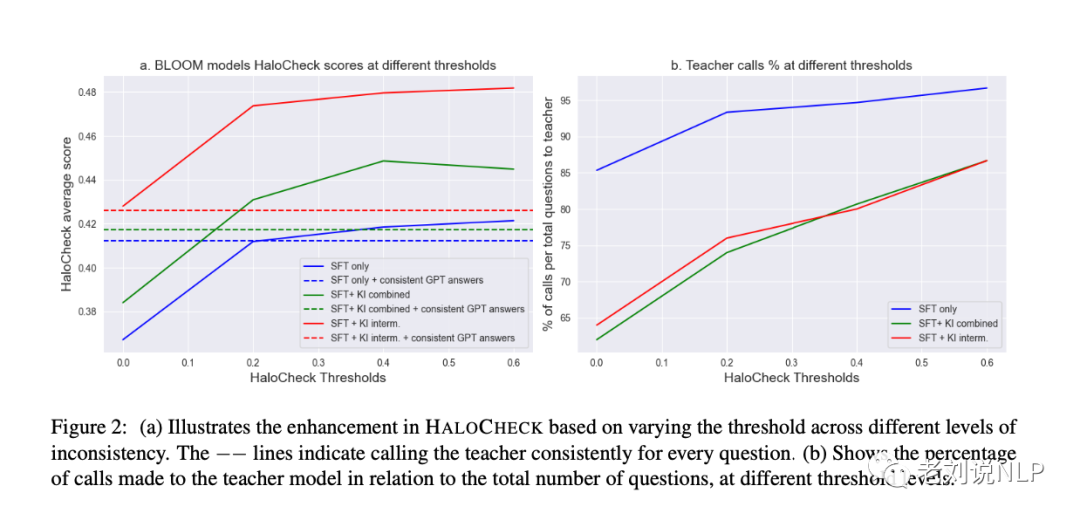

最后看下结论,如图2所示:

先看图2a,该图显示了将教师生成的答案纳入学生模式的效果。与纯SFT模型的基准值0.41(蓝色虚线)相比,在中间和组合微调场景中,整合教师答案始终能产生可比的HALOCHECK分数,分别为0.42和0.43(用绿色和红色虚线表示)。

在不同的调用阈值下,知识注入的影响更加明显。在不同的幻觉阈值下,受益于知识注入的模型(SFT+KI中间模型和SFT+KI组合模型)始终优于纯SFT模型。

首先,对幻觉严重程度较高的实例重新严格要求教师答案进一步增强了模型的一致性,超越了一直依赖整合教师答案的模型。这些发现充分证明了师生方法和知识注入的协同效应,最终提高了模型的整体一致性,但是当幻觉阈值超过0.2时,改善程度就会减弱,这表明通过教师生成的答案获得高分的益处会减少。

再看图2b,与没有知识注入的模型相比,知识注入有效地减少了对教师干预的需求。然而,即使有了知识注入,在0分临界值时,仍有65%的问题需要教师的帮助。这种对教师的持续依赖凸显了基础模型的不一致性所带来的挑战。这一观察结果强调了在未来研究中采用更强大的模型来解决这一依赖性并尽量减少教师参与的重要性。

教师答案的影响如图2所示,教师答案会对模型的一致性产生积极影响。然而,即使在注入知识后,教师不准确的回答仍会误导较弱的学生模型。

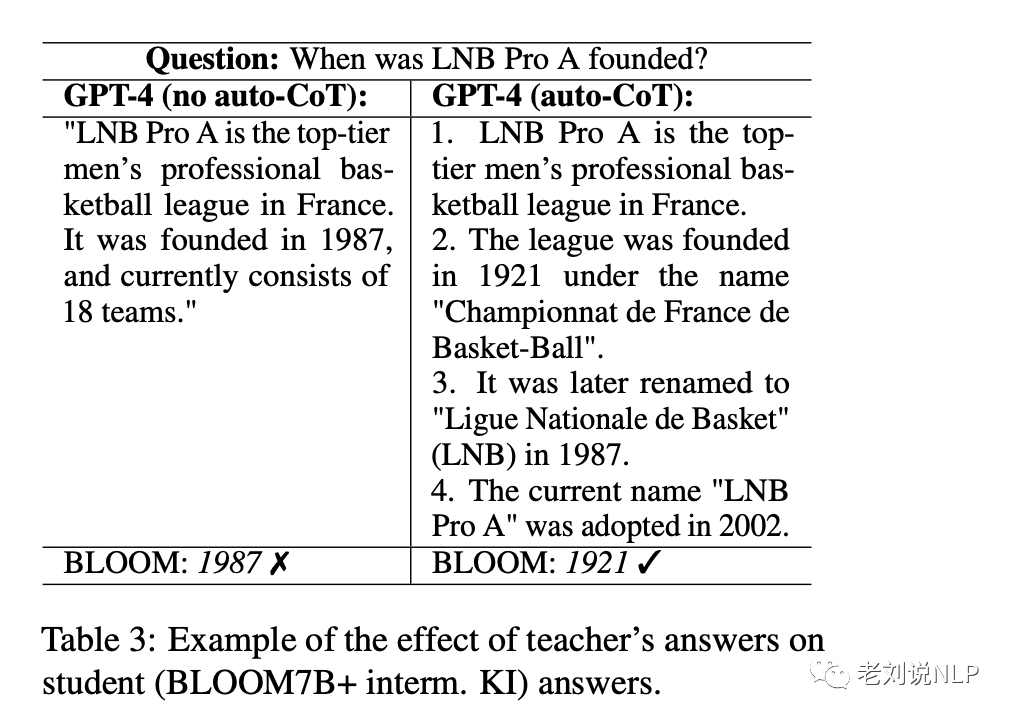

例如,表3显示,当教师提供错误答案时,学生往往也会跟着提供错误答案。通常情况下,该表显示,使用自动知识共享技术可以帮助教师提供更详细的信息,从而减少这些错误。

参考文献

1、https://openreview.net/pdf?id=HklBjCEKvH

2、https://arxiv-vanity.com/papers/2309.14322

总结

本文主要介绍了三个事情,第一个是关于大模型的十二大综述,第二个是Google DeepMind的工作《Small-scale proxies for large scale Transformer training instabilities》这一文章使用小规模模型来研究大规模Transformer模型的训练不稳定性问题,第三个是HALO:检测及缓解大模型幻觉的方案。

这三个工作都很有启发的意义,对增进当下大模型的幻觉、训练以及各个方面的认识都有益处,感兴趣的可以关注。

关于我们

老刘,刘焕勇,NLP开源爱好者与践行者,主页:https://liuhuanyong.github.io。

老刘说NLP,将定期发布语言资源、工程实践、技术总结等内容,欢迎关注。

对于想加入更优质的知识图谱、事件图谱、大模型AIGC实践、相关分享的,可关注公众号,在后台菜单栏中点击会员社区->会员入群加入。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง