克雷西 发自 凹非寺

量子位 | 公众号 QbitAI

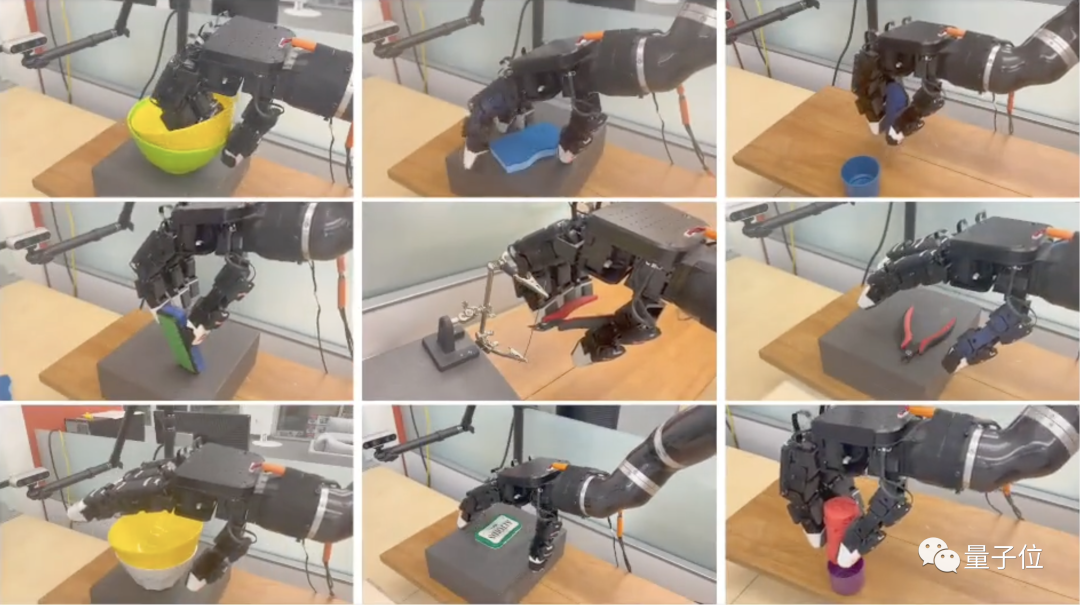

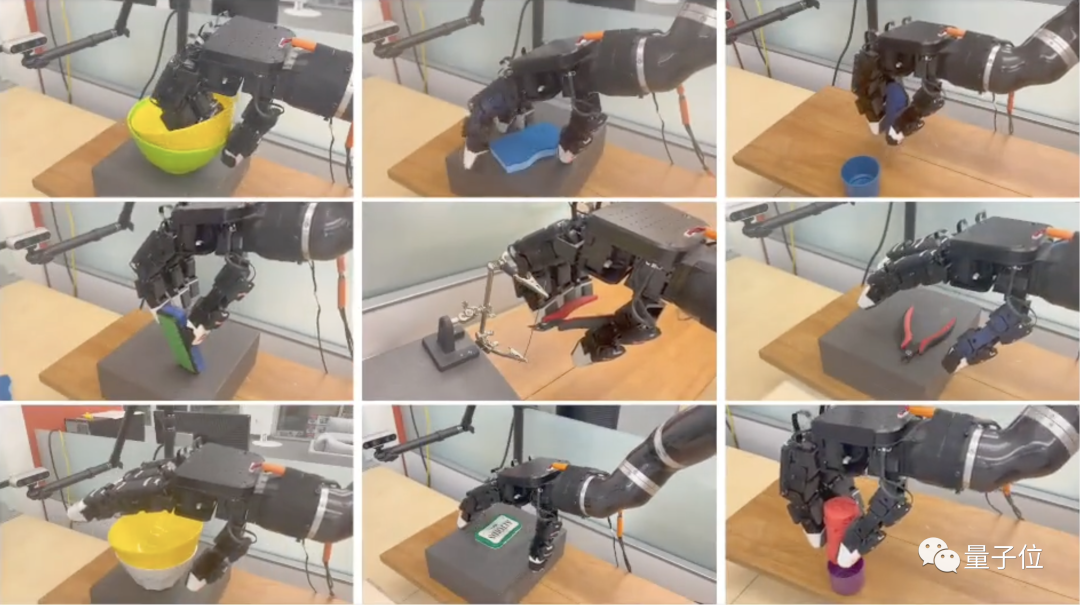

注意看,这个机器人用手中的钳子轻松剪断了一根金属丝。

盖上的铁盒子,也三下五除二就打开了。

除此之外,物体抓取等任务更是能轻松完成。

这个机器人的背后,是纽约大学联合Meta AI实验室推出的最新具身智能成果。

研究人员提出了一种名为TAVI的新训练方法,将视觉与触觉相结合,把机器人执行任务的效果提高一倍以上。

目前,研究团队的论文已经公开发表,相关代码也已经开源。

看到这个机器人的表现,Meta首席科学家LeCun也不禁感叹这是一项惊人的进展。

那么用这种方法训练出的机器人,还能做些什么呢?

取物置物易如反掌

它可以把摞在一起的两只碗分开,然后拿取上面的一个。

仔细观察可以发现,在分开的过程当中,机器人的手部做出了撵的动作,让黄色的碗沿着绿色碗的内壁滑动。

这个机器人不仅能“分”,还能“合”。

将红色的物块拿起之后,机器人将它精准地放入了紫色的盖子当中。

或者,给橡皮翻个身。

只见它将一大块橡皮拿起,然后利用下面的盒子调整角度。

虽然不知道为什么不多用几根手指,但毕竟也是学会了借助工具。

总之,用TAVI方式训练出的具身智能机器人,动作已经和人类有了几分相似。

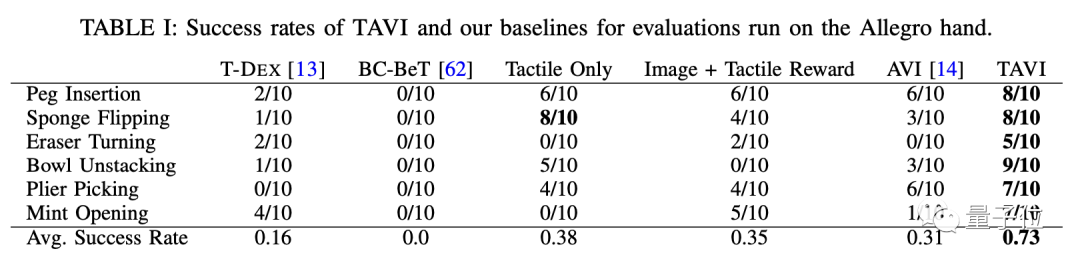

数据上,TAVI方式在6项典型任务中明显优于只用触觉或视觉反馈的方法。

和不使用触觉信息的AVI方式相比,TAVI的平均成功率提高了135%,和图像+触觉奖励模型的方式相比也翻了倍。

而同样采用视觉触觉混合模式的T-DEX训练方式,成功率还不到TAVI的四分之一。

TAVI训练的机器人还有很强的泛化能力——对于未曾见过的物体,机器人也可以完成任务。

在“拿碗”和“装盒”两项任务中,机器人面对未知物体的成功率均超过了半数。

此外,TAVI方法训练出的机器人不仅能出色完成各项任务,还能按顺序依次执行多项子任务。

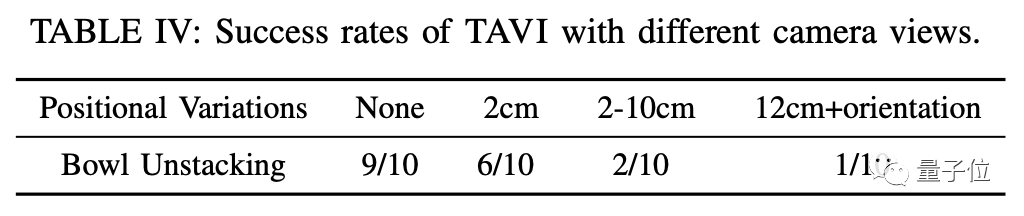

鲁棒性方面,研究团队通过调整相机角度进行了测试,结果机器人依旧保持了高成功率。

那么,TAVI方法是如何实现这样的效果的呢?

用视觉信息评价机器人表现

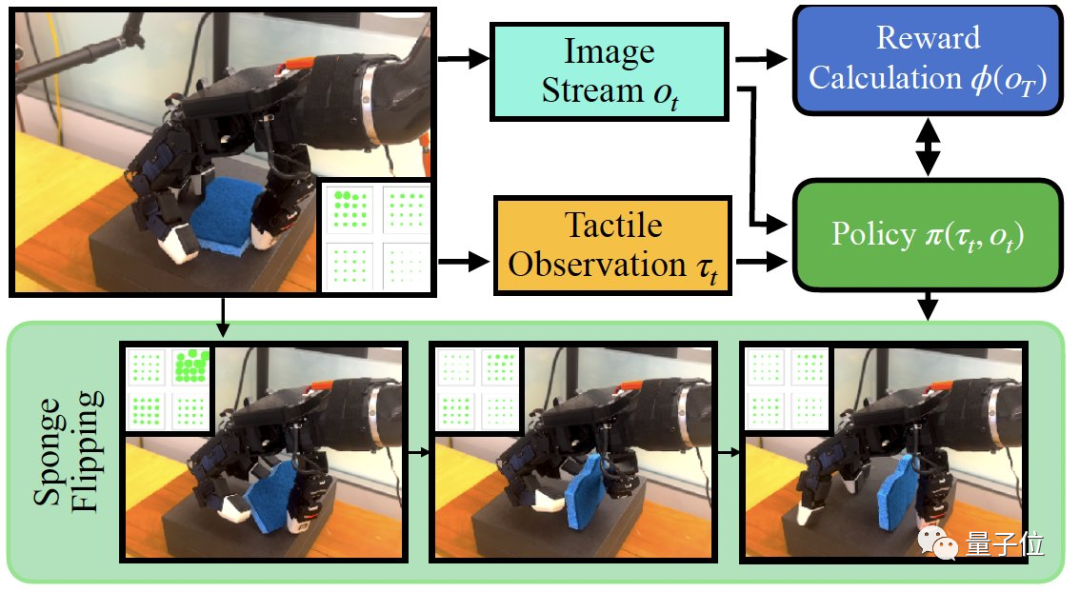

TAVI的核心是使用视觉上的反馈来训练机器人,工作主要分为三个步骤。

首先是从视觉和触觉两个维度收集人类给出的演示信息。

收集到的视觉信息会被用于建立奖励函数,以供后续学习过程中使用。

这一过程中,系统通过对比学习的方式来获取对完成任务有用的视觉特征,对机器人动作完成度进行评价。

然后结合触觉信息和视觉反馈,通过强化学习方式进行训练,让机器人反复尝试,直到获得较高的完成度评分。

而TAVI的学习是一个循序渐进的过程,随着学习步骤的增加,奖励函数越来越完善,机器人的动作也越来越精准。

而为了提高TAVI的灵活性,研究团队还引入了一种残差策略。

遇到与基础策略出现差别时,只需要对有差别的部分进行学习,而不必从头开始。

消融实验结果表明,如果没有残差策略,而是每次都从头学起,机器人完成任务的成功率将有所降低。

如果对具身智能有兴趣,可以阅读研究团队的论文了解更多详情。

论文地址:

https://arxiv.org/abs/2309.12300

GitHub项目页:

https://github.com/irmakguzey/see-to-touch

— 完 —

「AIGC+垂直领域社群」

招募中!

欢迎关注AIGC的伙伴们加入AIGC+垂直领域社群,一起学习、探索、创新AIGC!

请备注您想加入的垂直领域「教育」或「广告营销」,加入AIGC人才社群请备注「人才」&「姓名-公司-职位」。

点这里👇关注我,记得标星哦~

一键三连「分享」、「点赞」和「在看」

科技前沿进展日日相见 ~

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง