新智元报道

作者:专知

【新智元导读】ICCV 2023全部奖项已经公布,有两篇获得最佳论文,一篇来自斯坦福大学的研究者的ControlNet获得ICCV 2023马尔奖(最佳论文);另一篇来自多伦多大学。最佳学生论文奖由康奈尔大学、谷歌研究院和UC伯克利的研究者获得。大名鼎鼎的「Segment Anything」获得最佳论文提名。

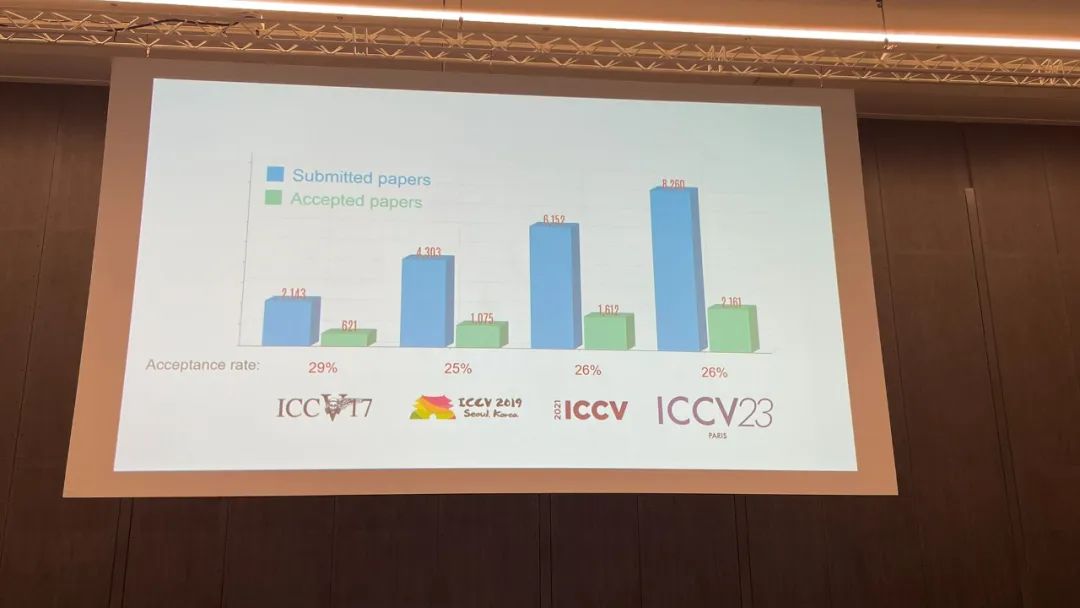

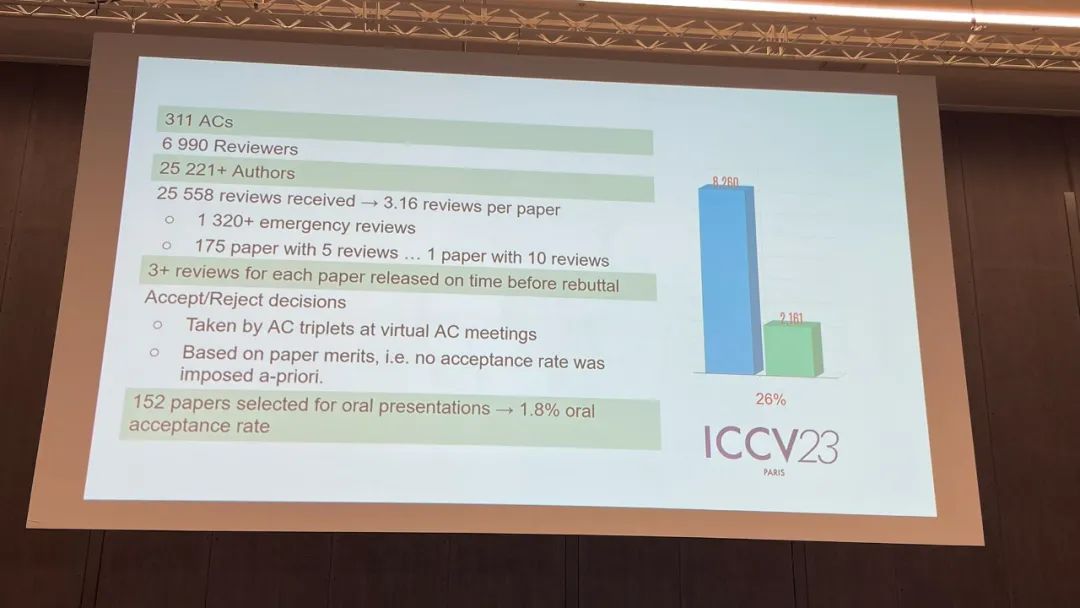

2023年度计算机视觉国际大会(International Conference on Computer Vision, ICCV)10月2日至6日在法国巴黎举行。ICCV是计算机领域世界顶级的学术会议之一,与CVPR、ECCV并称计算机视觉三大顶会,每两年举办一次。会议上将颁发最佳论文奖(Marr Prize)和最佳论文提名奖。今年7月,ICCV公布本届大会论文收录结果,共计2160篇论文入选。在开源社区HuggingFace已展示的1142篇入选论文中,50篇论文涉及的研究成果基于OpenMMLab系算法库产生。

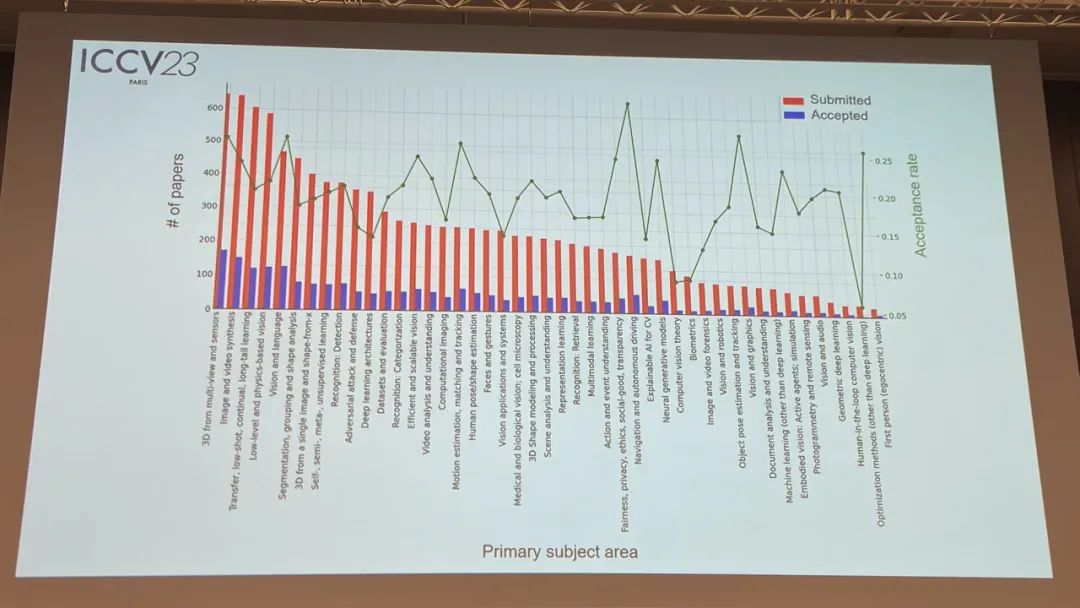

从接收论文的主题领域分布来看,前三位分别是:3D、图像视频合成、迁移少样本持续学习的呢过,在所有投稿中,各个主题领域的接收率如何?

ICCV 官方也进行了详细的统计:

接下来,介绍一下本届大会的获奖信息。

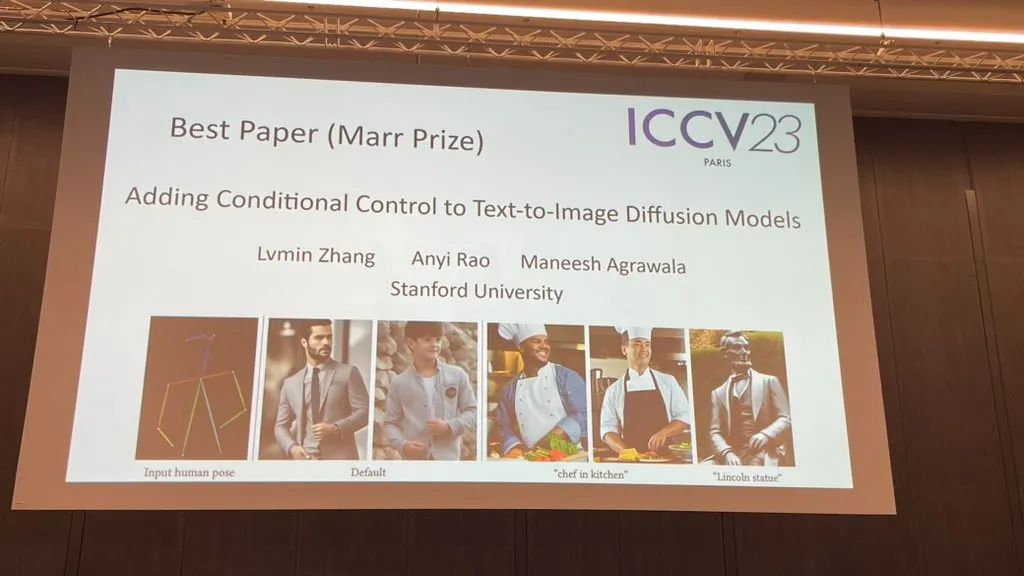

最佳论文 – 马尔奖

一篇来自斯坦福大学的研究者获得 ICCV 2023 马尔奖(最佳论文)。获奖论文:Adding Conditional Control to Text-to-Image Diffusion Models作者机构:斯坦福大学论文地址:https://www.zhuanzhi.ai/paper/3a26f5f6c78d2f3b70f01e08abfcc35e项目地址:https://github.com/lllyasviel/ControlNet 本文提出了一种神经网络结构ControlNet,用于控制预训练大型扩散模型,以支持额外的输入条件。ControlNet以端到端的方式学习特定任务的条件,即使训练数据集很小(<50k),学习也很稳健。此外,训练ControlNet的速度与微调扩散模型一样快,而且该模型可以在个人设备上进行训练。或者,如果可以使用强大的计算集群,模型可以扩展到大量(从百万到数十亿)的数据。我们报告,像Stable Diffusion这样的大型扩散模型可以通过ControlNets来增强,以实现边缘图、分割图、关键点等条件输入。这可能会丰富这些方法,以控制大型扩散模型,并进一步促进相关应用。 ControlNet是通过使用特定任务条件增强预训练图像扩散模型的一种神经网络结构。

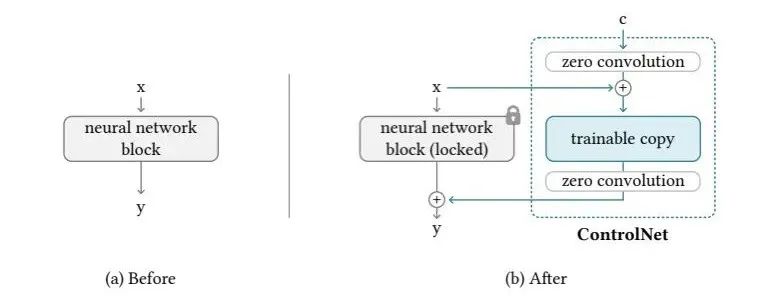

本文提出了一种神经网络结构ControlNet,用于控制预训练大型扩散模型,以支持额外的输入条件。ControlNet以端到端的方式学习特定任务的条件,即使训练数据集很小(<50k),学习也很稳健。此外,训练ControlNet的速度与微调扩散模型一样快,而且该模型可以在个人设备上进行训练。或者,如果可以使用强大的计算集群,模型可以扩展到大量(从百万到数十亿)的数据。我们报告,像Stable Diffusion这样的大型扩散模型可以通过ControlNets来增强,以实现边缘图、分割图、关键点等条件输入。这可能会丰富这些方法,以控制大型扩散模型,并进一步促进相关应用。 ControlNet是通过使用特定任务条件增强预训练图像扩散模型的一种神经网络结构。 ControlNet。我们展示了将ControlNet应用于任意神经网络块的方法。x,y是神经网络中的深层特征。“+”是指特征添加。“c”是我们想要添加到神经网络中的额外条件。“零卷积”是一个1×1的卷积层,权重和偏差都初始化为零。

ControlNet。我们展示了将ControlNet应用于任意神经网络块的方法。x,y是神经网络中的深层特征。“+”是指特征添加。“c”是我们想要添加到神经网络中的额外条件。“零卷积”是一个1×1的卷积层,权重和偏差都初始化为零。

另一篇来自多伦多大学的研究者获得 ICCV 2023 马尔奖(最佳论文)。

获奖论文:Passive Ultra-Wideband Single-Photon Imaging

作者机构:多伦多大学

论文地址:https://openaccess.thecvf.com/content/ICCV2023/papers/Wei_Passive_Ultra-Wideband_Single-Photon_Imaging_ICCV_2023_paper.pdf

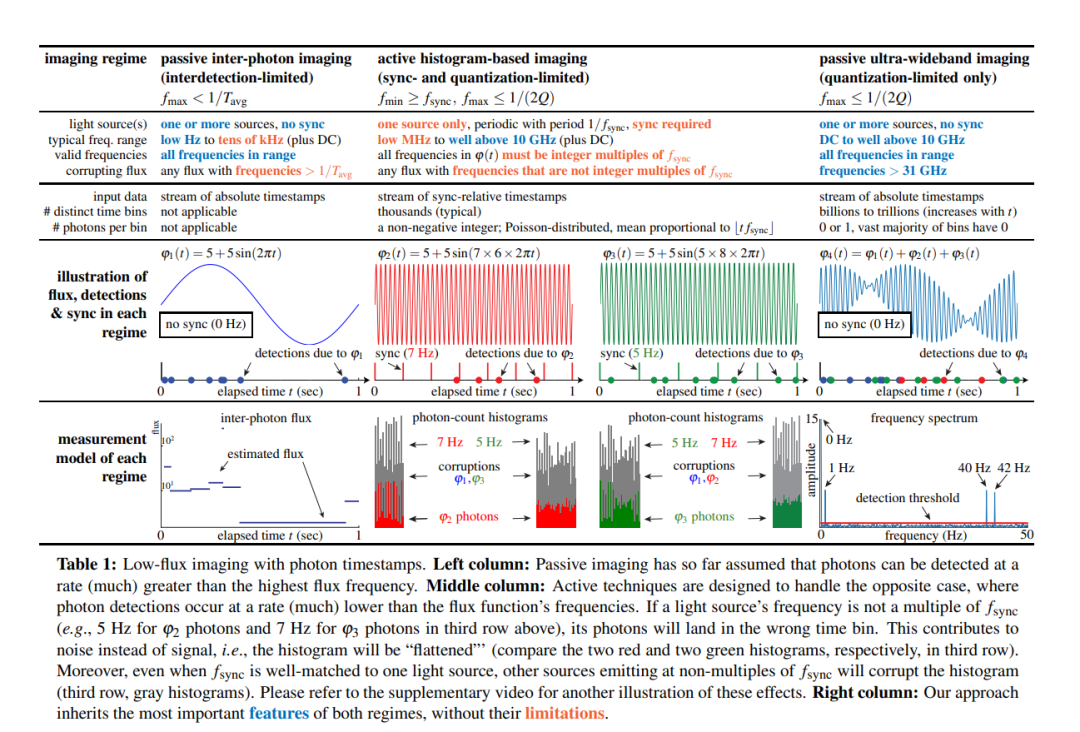

我们考虑如何在极端的时间范围内同时对动态场景进行成像—从秒到皮秒—并且这样做是被动的,光线不多,且不需要来自发光源的任何时间信号。因为现有的单光子相机的光束估计技术在这个范围内失效,我们开发了一种光束探测理论,该理论从随机微积分中得到启示,以实现从单调递增的光子检测时间戳中重建像素的时间变化光束。我们使用这个理论来 (1) 显示在低光束条件下,被动自由运行的SPAD相机具有可达到的频率带宽,该带宽跨越整个直流到31 GHz范围,(2) 推导出一个新颖的傅里叶域光束重建算法,该算法扫描此范围以寻找时间戳数据中具有统计显著支持的频率,以及 (3) 确保即使对于非常低的光子计数或不可忽略的死亡时间,算法的噪声模型仍然有效。通过实验证明了这种异步成像模式的潜力,展示了一些前所未见的能力:(1) 同时由在极其不同速度下运行的发光源(如灯泡、投影机、多个脉冲激光器)照亮的场景进行成像,而不需要同步,(2) 被动非视线视频采集,以及 (3) 录制超宽带视频,稍后可以以30 Hz的速度回放,以显示日常动作—但也可以放慢十亿倍速度以显示光的传播本身。

我们考虑如何在极端的时间范围内同时对动态场景进行成像—从秒到皮秒—并且这样做是被动的,光线不多,且不需要来自发光源的任何时间信号。因为现有的单光子相机的光束估计技术在这个范围内失效,我们开发了一种光束探测理论,该理论从随机微积分中得到启示,以实现从单调递增的光子检测时间戳中重建像素的时间变化光束。我们使用这个理论来 (1) 显示在低光束条件下,被动自由运行的SPAD相机具有可达到的频率带宽,该带宽跨越整个直流到31 GHz范围,(2) 推导出一个新颖的傅里叶域光束重建算法,该算法扫描此范围以寻找时间戳数据中具有统计显著支持的频率,以及 (3) 确保即使对于非常低的光子计数或不可忽略的死亡时间,算法的噪声模型仍然有效。通过实验证明了这种异步成像模式的潜力,展示了一些前所未见的能力:(1) 同时由在极其不同速度下运行的发光源(如灯泡、投影机、多个脉冲激光器)照亮的场景进行成像,而不需要同步,(2) 被动非视线视频采集,以及 (3) 录制超宽带视频,稍后可以以30 Hz的速度回放,以显示日常动作—但也可以放慢十亿倍速度以显示光的传播本身。

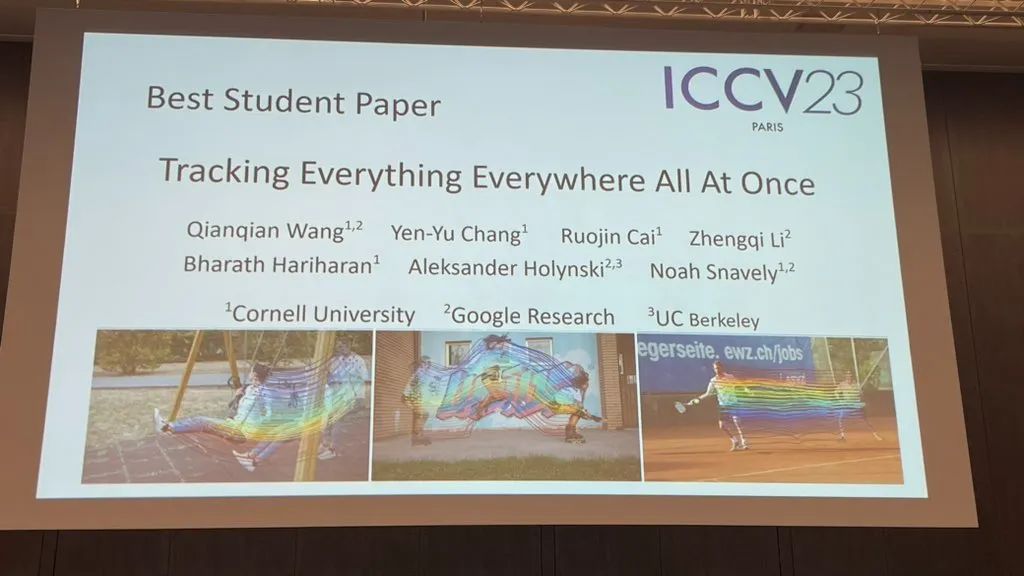

最佳学生论文奖

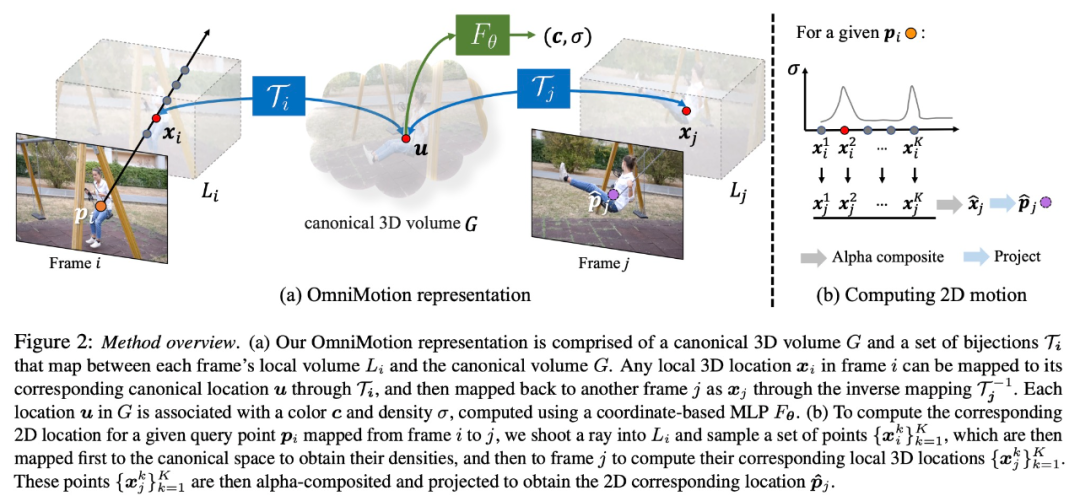

该研究由来自康奈尔大学、谷歌研究院和 UC 伯克利的研究者共同完成。他们联合提出了一种完整且全局一致的运动表征 OmniMotion,并提出一种新的测试时(test-time)优化方法,对视频中每个像素进行准确、完整的运动估计。

- 论文地址:https://arxiv.org/abs/2306.05422

- 项目主页:https://omnimotion.github.io/

在计算机视觉领域,常用的运动估计方法有两种:稀疏特征追踪和密集光流。但这两种方法各有缺点,稀疏特征追踪不能建模所有像素的运动;密集光流无法长时间捕获运动轨迹。该研究提出的 OmniMotion 使用 quasi-3D 规范体积来表征视频,并通过局部空间和规范空间之间的双射(bijection)对每个像素进行追踪。这种表征能够保证全局一致性,即使在物体被遮挡的情况下也能进行运动追踪,并对相机和物体运动的任何组合进行建模。该研究通过实验表明所提方法大大优于现有 SOTA 方法。

在计算机视觉领域,常用的运动估计方法有两种:稀疏特征追踪和密集光流。但这两种方法各有缺点,稀疏特征追踪不能建模所有像素的运动;密集光流无法长时间捕获运动轨迹。该研究提出的 OmniMotion 使用 quasi-3D 规范体积来表征视频,并通过局部空间和规范空间之间的双射(bijection)对每个像素进行追踪。这种表征能够保证全局一致性,即使在物体被遮挡的情况下也能进行运动追踪,并对相机和物体运动的任何组合进行建模。该研究通过实验表明所提方法大大优于现有 SOTA 方法。

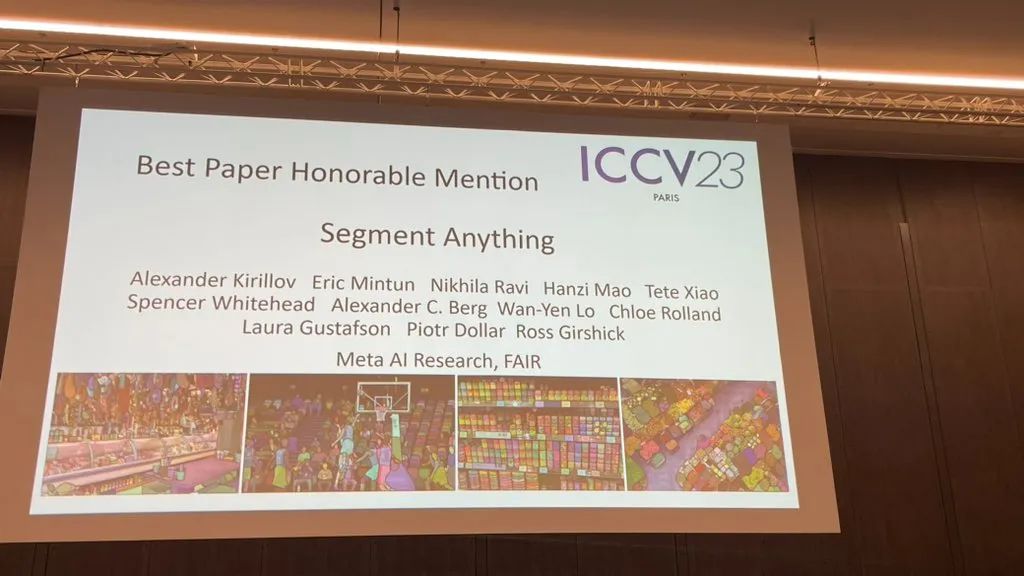

最佳论文荣誉提名奖

最佳论文荣誉提名奖给了大名鼎鼎的【Segment Anything】。

- 论文 :Segment Anything

- 论文地址:https://arxiv.org/abs/2304.02643

我们介绍Segment Anything(SA)项目:一种新的图像分割任务、模型和数据集。在数据采集循环中使用我们的高效模型,我们建立了迄今为止最大的分割数据集,在1100万许可和尊重隐私的图像上有超过10亿个掩码。该模型被设计和训练为可提示的,因此它可以将zero-shot transfer零样本迁移到新的图像分布和任务。我们评估了它在许多任务上的能力,并发现它的零样本性能令人印象深刻,通常与之前的完全监督的结果相当,甚至更优。我们正在发布Segment Anything Model(SAM)和相应的数据集(SA-1B),其中包含10亿个掩码和1100万个图像,以促进计算机视觉基础模型的研究。

我们介绍Segment Anything(SA)项目:一种新的图像分割任务、模型和数据集。在数据采集循环中使用我们的高效模型,我们建立了迄今为止最大的分割数据集,在1100万许可和尊重隐私的图像上有超过10亿个掩码。该模型被设计和训练为可提示的,因此它可以将zero-shot transfer零样本迁移到新的图像分布和任务。我们评估了它在许多任务上的能力,并发现它的零样本性能令人印象深刻,通常与之前的完全监督的结果相当,甚至更优。我们正在发布Segment Anything Model(SAM)和相应的数据集(SA-1B),其中包含10亿个掩码和1100万个图像,以促进计算机视觉基础模型的研究。

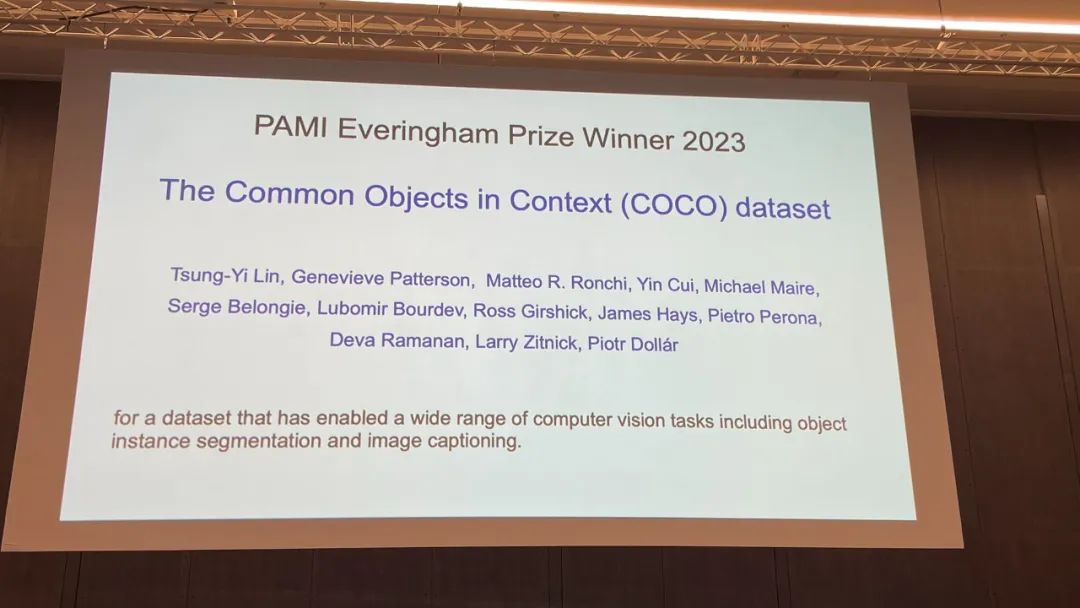

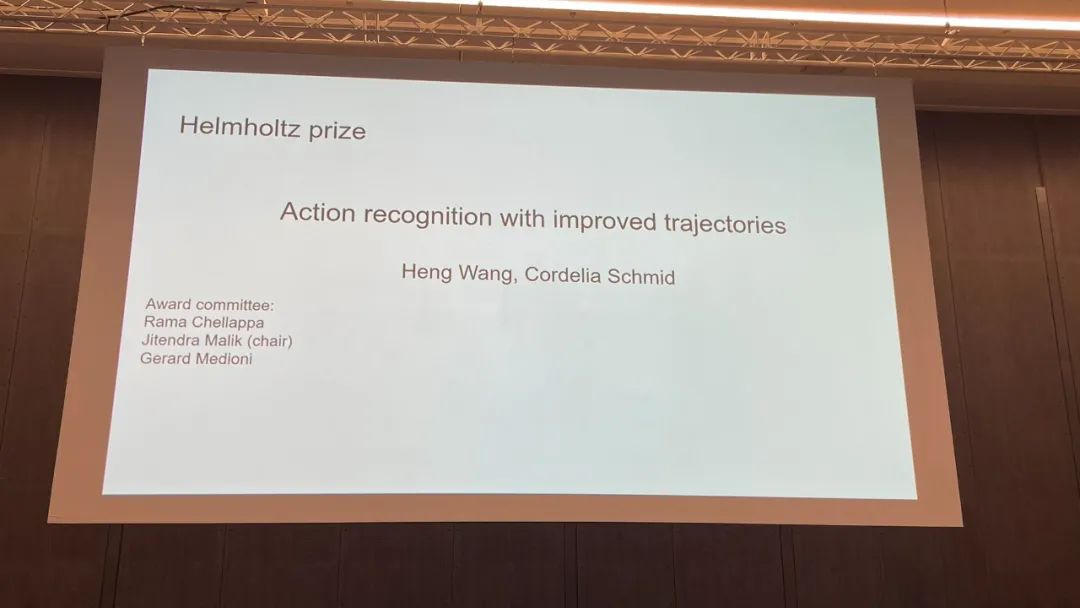

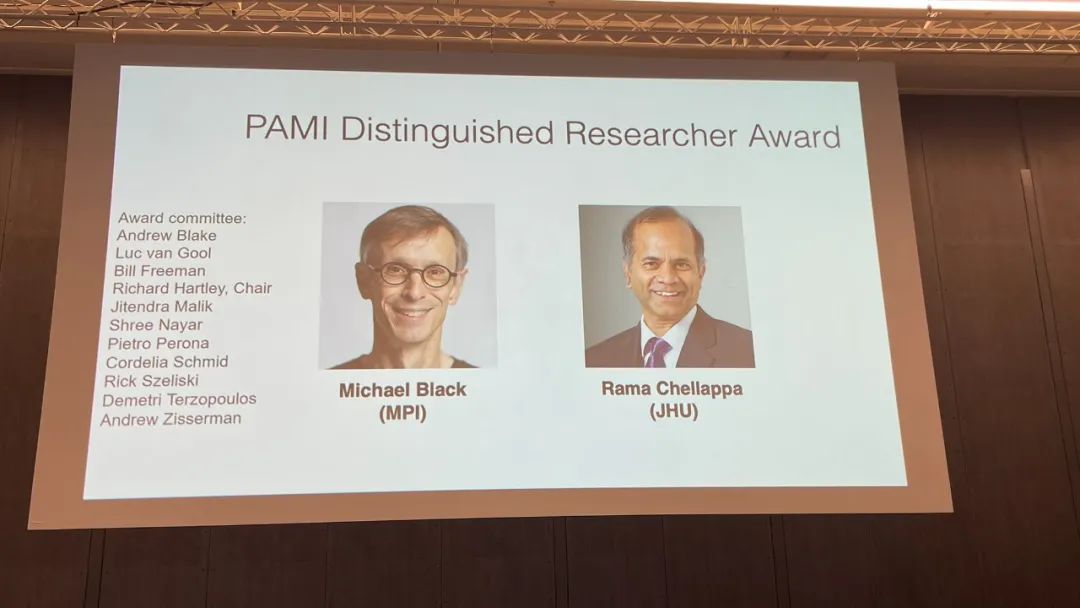

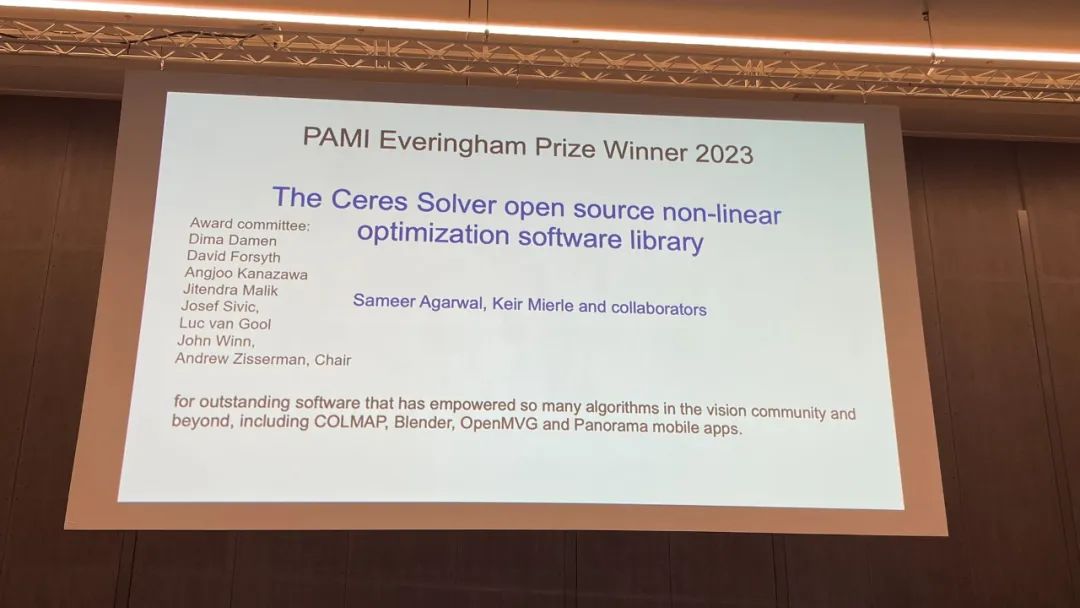

其他获奖奖项

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง