GAIA-1: A Generative World Model for Autonomous Driving

A Hu, L Russell, H Yeo, Z Murez, G Fedoseev, A Kendall, J Shotton, G Corrado

[Wayve]

GAIA-1:自动驾驶的生成式世界模型

-

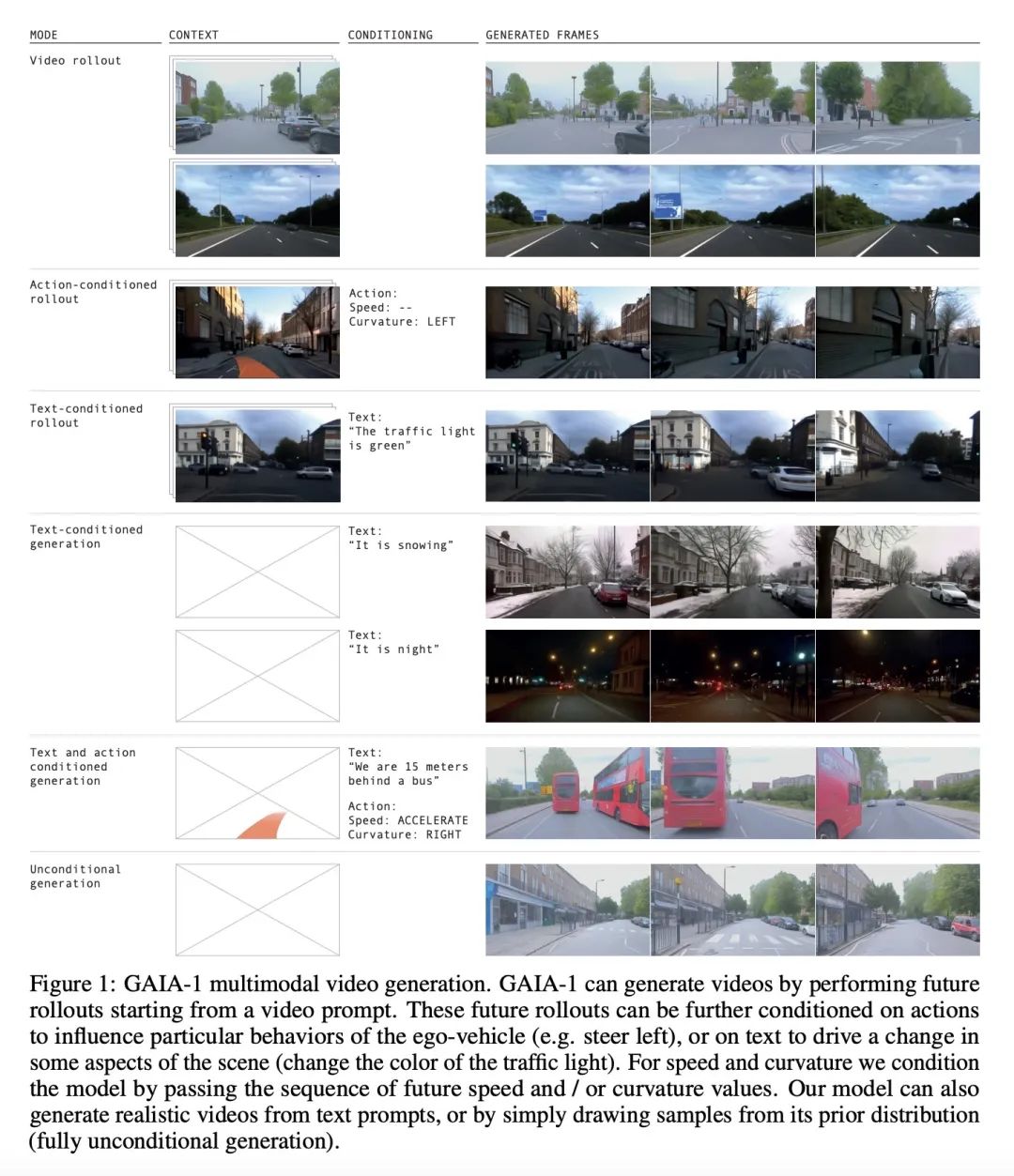

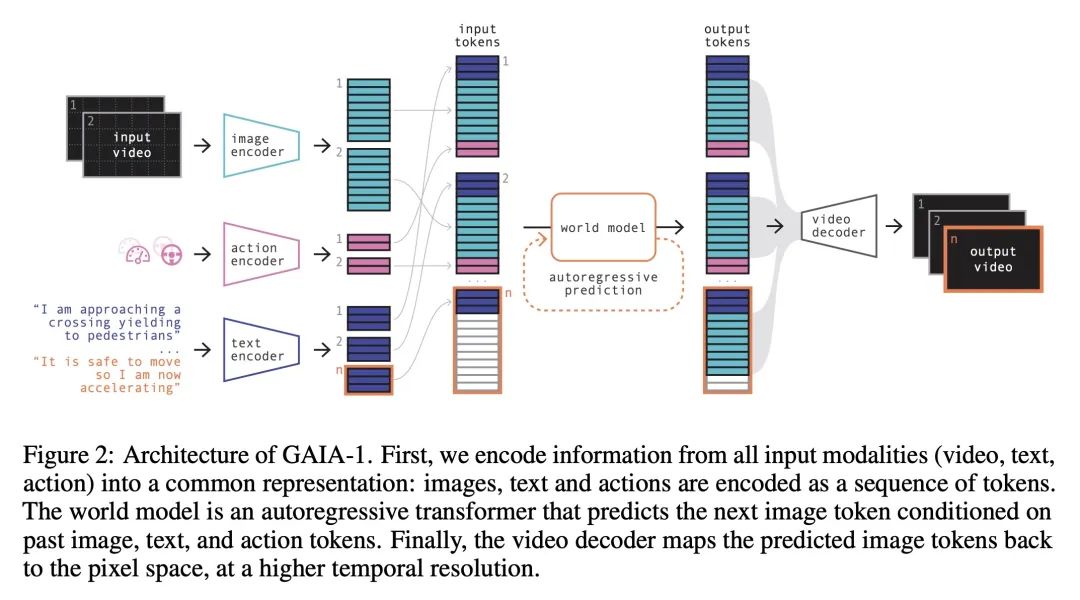

GAIA-1是一个用于自动驾驶的生成式世界模型,可以从视频、文本和动作输入生成逼真的驾驶场景,结合了基于transformer的世界模型和视频扩散解码器。

-

视频扩散解码器从世界模型的潜表示中生成高分辨率视频,在图像生成、视频生成和其他任务上进行了训练。

-

GAIA-1旨在实现多模态,通过在生成过程中对文本和动作进行条件化,可以控制自主车辆的动作和场景的特征。

-

GAIA-1展示了这样的能力:连贯的场景生成,泛化和创造力,对上下文的认知和3D几何的理解,智能体的反应行为。

-

模型对未来事件的学习表示,以及它逼真的生成,都可能增强自动驾驶技术。

动机:构建一个能准确预测自动驾驶中可能发生的各种潜在结果的世界模型,以提高自动驾驶系统的安全性和效率。

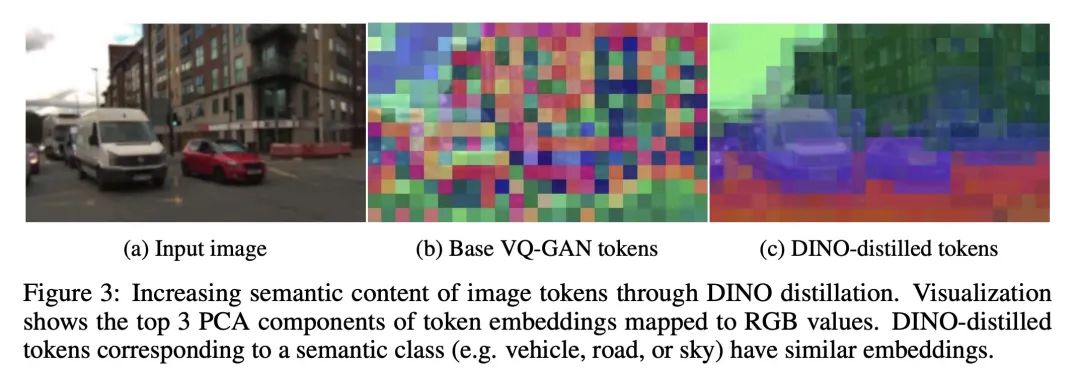

方法:引入了GAIA-1,一个利用视频、文本和动作输入生成逼真驾驶场景的生成式世界模型。通过将输入映射到离散标记序列,并预测序列中的下一个标记,将世界建模问题视为无监督的序列建模问题。模型的学习表示捕捉了未来事件的期望,并能生成逼真样本。

优势:GAIA-1的学习表示能准确预测未来事件,并具有生成逼真样本的能力,为自动驾驶技术的增强和加速训练提供了新的可能性。

GAIA-1是一个能生成逼真驾驶场景的生成式世界模型,通过学习表示和生成样本来准确预测未来事件,为自动驾驶技术的训练提供了新的可能性。

https://arxiv.org/abs/2309.17080

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง