Improved Baselines with Visual Instruction Tuning

H Liu, C Li, Y Li, Y J Lee

[University of Wisconsin–Madison & Microsoft Research]

基于视觉指令微调的改进基线

-

本文基于LLaVA框架建立了更强大、更可行的指导性多模态模型基准。

-

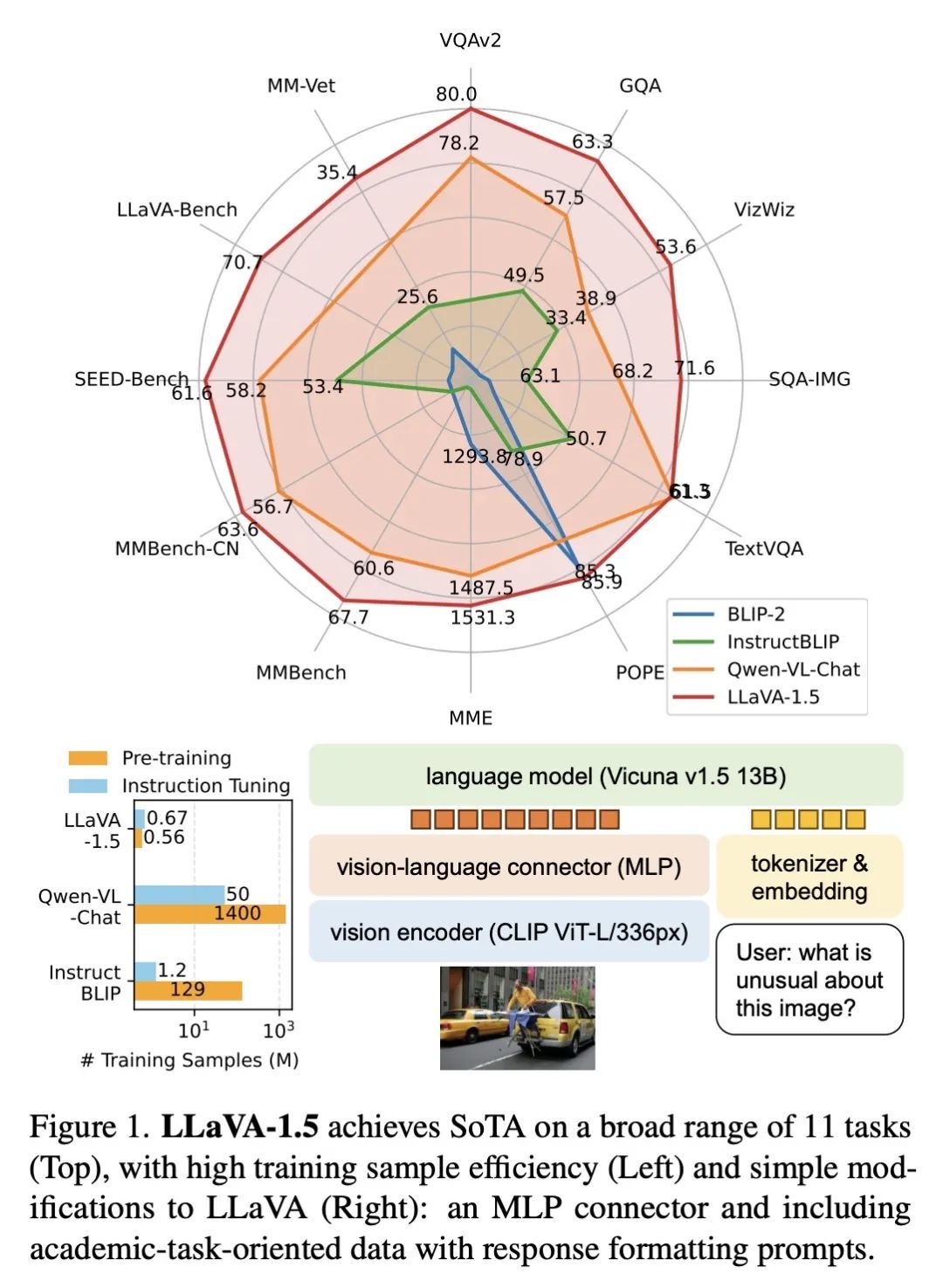

使用MLP而不是线性投影的跨模态连接器和加入学术任务相关的数据如VQA这两个简单的改进,大大增强了LLaVA的能力。

-

最终模型LLaVA-1.5在12个基准测试中的11个上获得了最先进的结果,尽管它使用的数据量远少于其他方法。

-

LLaVA-1.5采用最简单的架构设计,只使用一个全连接投影层,在仅120万公开可用的数据上训练,可以在单个8-A100节点上在~1天内完成全部训练。

-

结果表明,相比预训练,视觉指令微调在提升多模态模型上起着更重要的作用,而LLaVA框架具有高效的数据效率。

动机:提高大型多模态模型(LMM)的基线性能,使其更加易于使用和可复现。

方法:在LLaVA框架的基础上进行了两个简单的改进,包括使用MLP跨模态连接器和引入与学术任务相关的VQA数据。通过这些改进,建立了更强大和可行的基线模型,实现了在11个基准测试中的最新成果。

优势:使用简单的架构设计和较少的训练数据,在单个8-A100节点上仅需约1天的时间,就能取得与最先进方法相媲美的结果。此外,所使用的数据都是公开可用的,使得最新的LMM研究更加可获得。

通过简单的改进和使用公开可用的数据,建立了更强大和可行的大型多模态模型的基线,实现了与最先进方法相媲美的结果。

https://arxiv.org/abs/2310.03744

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง