MiniGPT-5: Interleaved Vision-and-Language Generation via Generative Vokens

K Zheng, X He, X E Wang

[University of California, Santa Cruz]

要点:

- 提出了MiniGPT-5,一种采用“生成式vokens”的交错式视觉语言生成新技术,这些vokens充当文本和图像之间的桥梁。

- 引入了两阶段的训练策略。第一阶段专注于使用单个文本图像对进行单模态对齐,第二阶段涉及在具有文本图像序列的数据集上进行多模态微调。

- 在训练过程中加入了无分类器指导,以增强vokens对图像生成的有效性。

- 实验结果显示,与基线模型相比,在MMDialog数据集上获得了改进的性能,并在VIST数据集上与最先进技术相当。

- 该模型展示了从多模态上下文生成连贯文本和高质量图像的能力,而无需依赖完整的图像描述。

- 所提出的技术使大规模语言模型获得交错式视觉语言生成能力。

动机:目前的大型语言模型在文本理解和生成方面表现出色,但是在同时生成连贯的图像和文本描述方面仍有待提高。因此,本论文的动机是引入一种创新的交错式视觉与语言生成技术,通过“生成式vokens”的概念作为桥梁,实现图像和文本的协调输出。

方法:提出一种独特的两阶段训练策略,专注于基于无描述的多模态生成,其中训练过程不需要对图像进行全面的描述。为了增强模型的准确性,还引入了无分类器的指导方法,提升了生成式vokens在图像生成中的效果。

优势:MiniGPT-5模型在MMDialog数据集上相比基线模型Divter展现出显著的改进,并且在VIST数据集上通过人工评估始终提供优秀或可比较的多模态输出,突出了其在各种基准测试中的有效性。

提出一种创新的交错式视觉与语言生成技术,通过引入“生成式vokens”的概念和独特的训练策略,实现了无描述的多模态生成,并在多个数据集上展现出优越的性能。

OpenAI 的 GPT-5 大模型似乎还遥遥无期,但已经有研究者率先推出了创新视觉与语言交叉生成的模型 MiniGPT-5。这对于生成具有连贯文本描述的图像具有重要意义。

大模型正在实现语言和视觉的跨越,有望无缝地理解和生成文本和图像内容。在最近的一系列研究中,多模态特征集成不仅是一种不断发展的趋势,而且已经带来了从多模态对话到内容创建工具等关键进步。大型语言模型在文本理解和生成方面已经展现出无与伦比的能力。然而,同时生成具有连贯文本叙述的图像仍然是一个有待发展的领域。

近日,加州大学圣克鲁兹分校的研究团队提出了 MiniGPT-5,这是一种以 「生成式 voken」概念为基础的创新型交错视觉语言生成技术。

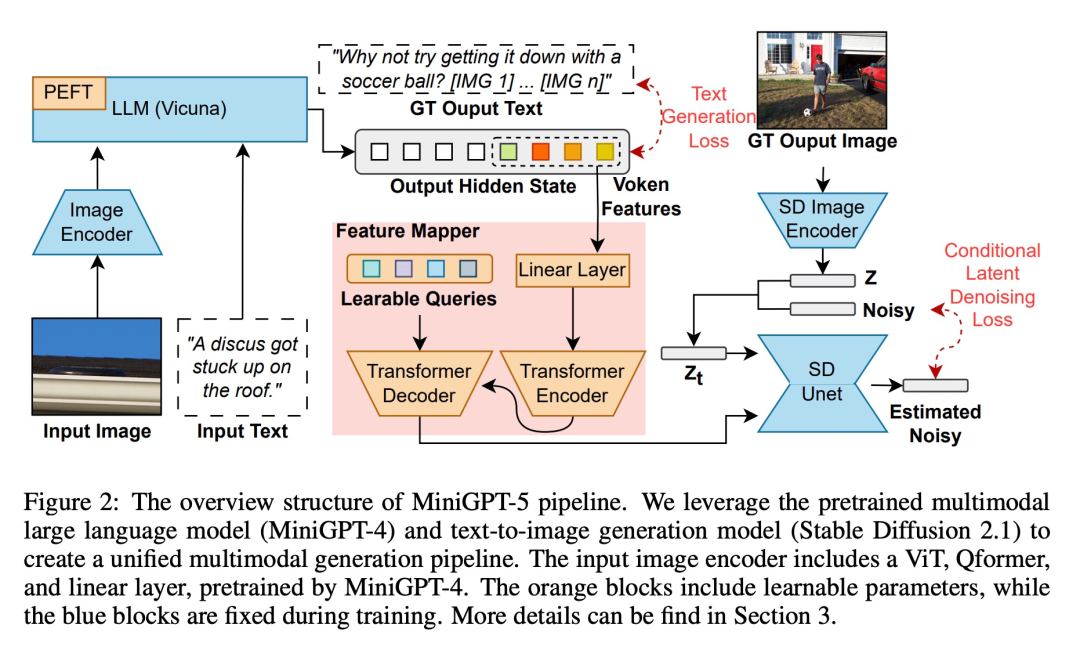

通过特殊的视觉 token「生成式 voken」,将 Stable Diffusion 机制与 LLM 相结合, MiniGPT-5 为熟练的多模态生成预示了一种新模式。同时,本文提出的两阶段训练方法强调了无描述基础阶段的重要性,使模型在数据稀缺的情况下也能「茁壮成长」。该方法的通用阶段不需要特定领域的注释,这使得本文解决方案与现有的方法截然不同。为了确保生成的文本和图像和谐一致,本文的双损失策略开始发挥作用,生成式 voken 方法和分类方法进一步增强了这一效果。

在这些技术的基础上,这项工作标志着一种变革性的方法。通过使用 ViT(Vision Transformer)和 Qformer 以及大型语言模型,研究团队将多模态输入转换为生成式 voken,并与高分辨率的 Stable Diffusion2.1 无缝配对,以实现上下文感知图像生成。本文将图像作为辅助输入与指令调整方法相结合,并率先采用文本和图像生成损失,从而扩大了文本和视觉之间的协同作用。

MiniGPT-5 与 CLIP 约束等模型相匹配,巧妙地将扩散模型与 MiniGPT-4 融合在一起,在不依赖特定领域注释的情况下实现了较好的多模态结果。最重要的是,本文的策略可以利用多模态视觉语言基础模型的进步,为增强多模态生成能力提供新蓝图。

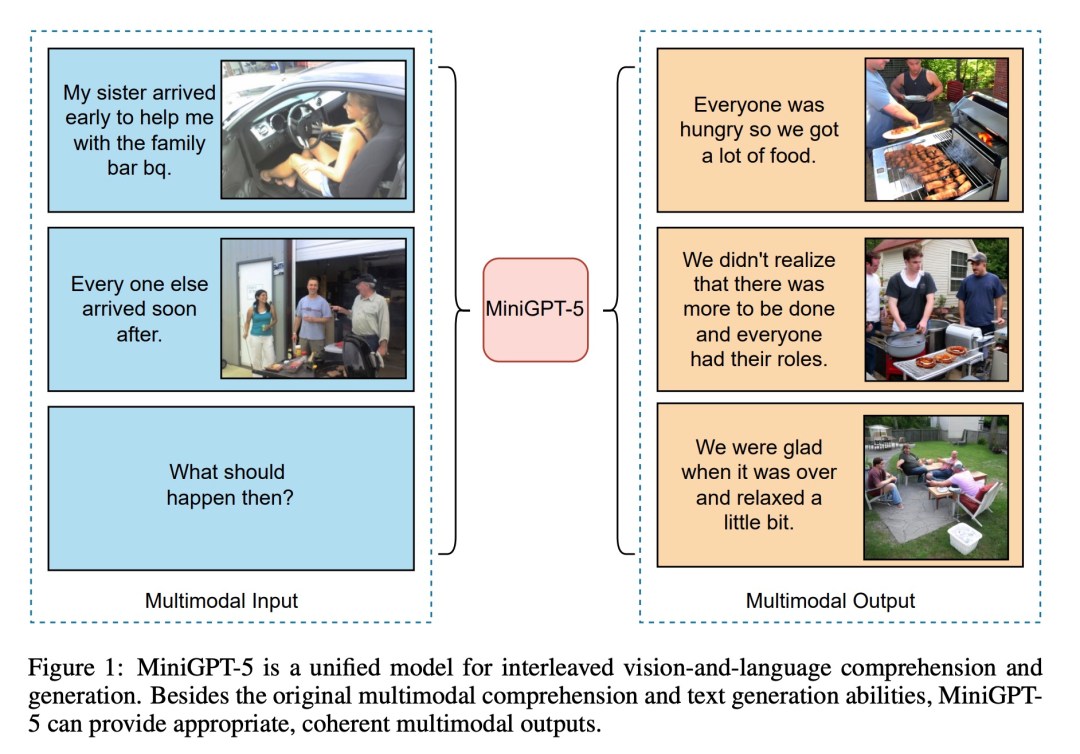

如下图所示,除了原有的多模态理解和文本生成能力外,MiniGPT5 还能提供合理、连贯的多模态输出:

本文贡献体现在三个方面:

- 建议使用多模态编码器,它代表了一种新颖的通用技术,并已被证明比 LLM 和反转生成式 vokens 更有效,并将其与 Stable Diffusion 相结合,生成交错的视觉和语言输出(可进行多模态生成的多模态语言模型)。

- 重点介绍了一种新的两阶段训练策略,用于无描述多模态生成。单模态对齐阶段从大量文本图像对中获取高质量的文本对齐视觉特征。多模态学习阶段包括一项新颖的训练任务,即 prompt 语境生成,确保视觉和文本 prompt 能够很好地协调生成。在训练阶段加入无分类器指导,进一步提高了生成质量。

- 与其他多模态生成模型相比, MiniGPT-5 在 CC3M 数据集上取得了最先进的性能。MiniGPT-5 还在 VIST 和 MMDialog 等著名数据集上建立了新的基准。

接下来,我们一起来看看该研究的细节。

方法概览

为了使大型语言模型具备多模态生成能力,研究者引入了一个结构化框架,将预训练好的多模态大型语言模型和文本到图像生成模型整合在一起。为了解决不同模型领域之间的差异,他们引入了特殊的视觉符号「生成式 voken」(generative vokens),能够直接在原始图像上进行训练。此外,还推进了一种两阶段训练方法,并结合无分类器引导策略,以进一步提高生成质量。

多模态输入阶段

多模态大模型(如 MiniGPT-4)的最新进展主要集中在多模态理解方面,能够处理作为连续输入的图像。为了将其功能扩展到多模态生成,研究者引入了专为输出视觉特征而设计的生成式 vokens。此外,他们还在大语言模型(LLM)框架内采用了参数效率高的微调技术,用于多模态输出学习。

多模态输出生成

为了使生成式 token 与生成模型精确对齐,研究者制定了一个用于维度匹配的紧凑型映射模块,并纳入了若干监督损失,包括文本空间损失和潜在扩散模型损失。文本空间损失有助于模型学习 token 的正确定位,而潜在扩散损失则直接将 token 与适当的视觉特征对齐。由于生成式符号的特征直接由图像引导,因此该方法不需要全面的图像描述,从而实现了无描述学习。

训练策略

鉴于文本域和图像域之间存在不可忽略的领域偏移,研究者发现直接在有限的文本和图像交错数据集上进行训练可能会导致错位和图像质量下降。

因此,他们采用了两种不同的训练策略来缓解这一问题。第一种策略包括采用无分类器引导技术,在整个扩散过程中提高生成 token 的有效性;第二种策略分两个阶段展开:最初的预训练阶段侧重于粗略的特征对齐,随后的微调阶段致力于复杂的特征学习。

实验及结果

为了评估模型功效,研究者选择了多个基准进行了一系列评估。实验旨在解决几个关键问题:

- MiniGPT-5 能否生成可信的图像和合理的文本?

- 在单轮和多轮交错视觉语言生成任务中,MiniGPT-5 与其他 SOTA 模型相比性能如何?

- 每个模块的设计对整体性能有什么影响?

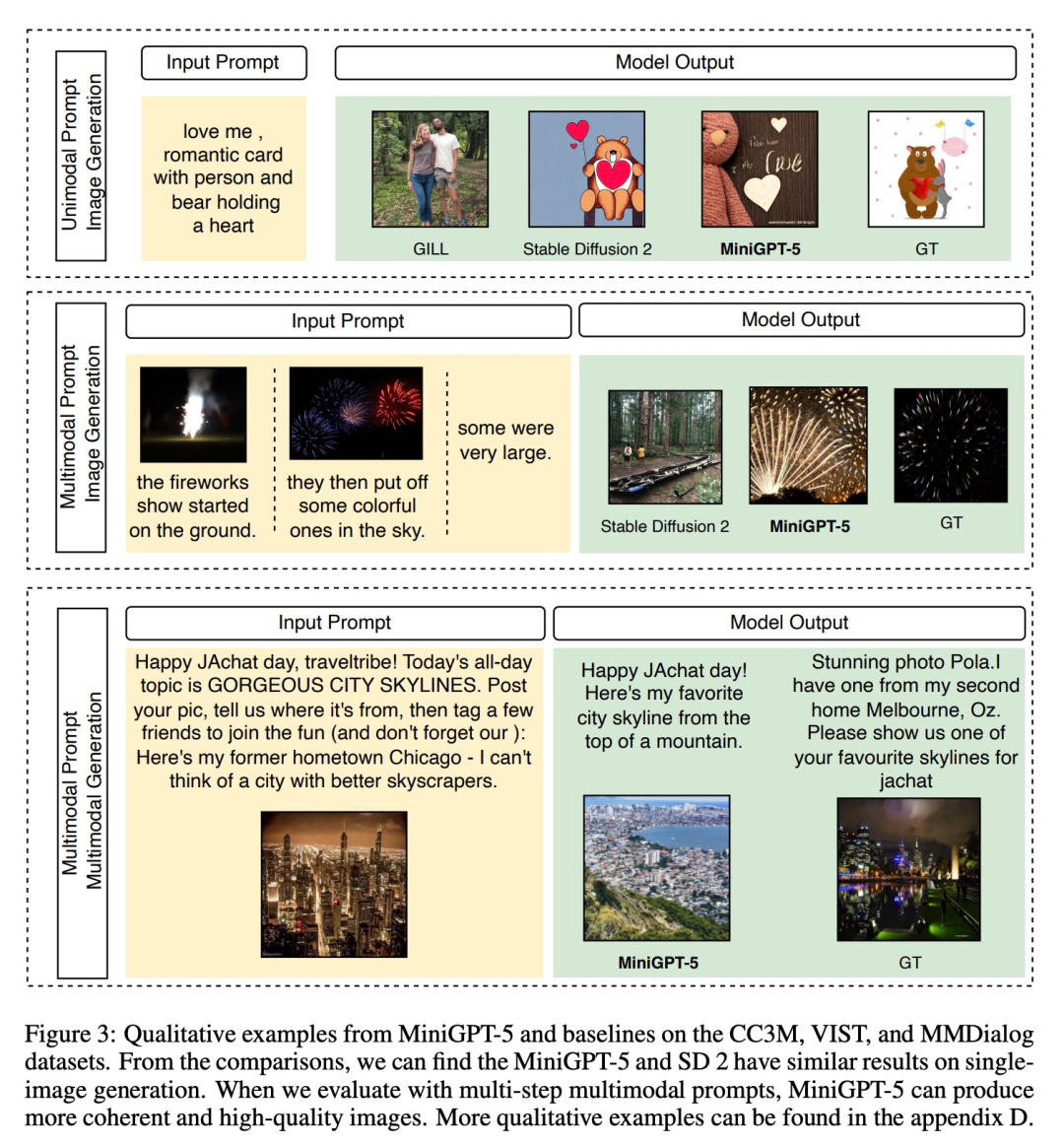

为了评估模型在不同训练阶段的不同基准上的性能,MiniGPT-5 的定量分析样本如下图 3 所示:

此处的评估横跨视觉(图像相关指标)和语言(文本指标)两个领域,以展示所提模型的通用性和稳健性。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง