今日值得关注的人工智能新动态:

-

抨击谷歌!微软首席执行官:他们在扼杀竞争

-

毕马威调查:首席执行官们将AI视为投资的重中之重

-

谁将拥有 AI 时代的“iPhone”?

-

IBM 发布新的 AI 驱动的威胁检测和响应服务

-

Thought Propagation:利用 LLMs 进行复杂推理的类比方法

-

GPT-4 教 GPT-3.5 编程,效果怎么样?

-

利用多代理强化学习进行自我监督神经元分割

-

微软新研究:减少 LLMs 幻觉的自然语言推理链

01

抨击谷歌!微软首席执行官:

他们在扼杀竞争

微软首席执行官 Satya Nadella 与 Alphabet 获取免费报告存在分歧,并在最近针对谷歌运营商的反垄断诉讼中出庭作证。Geekwire 分享了该证词的部分记录,Nadella 明确表示,他认为 Alphabet 利用其巨大的影响力来扼杀竞争。他还认为,Alphabet 在兜售一种错误的说法,即 OEM 合作伙伴有选择,但实际上他们没有选择。

另外,Nadella 还分享了他对人工智能的恐惧,他担心的是,现在所有人都能获得的内容——真正的知识,会变成专有内容。这可能不是机器人奴役人类,而是一种更难以防范的微妙危险。

02

毕马威调查:首席执行官们

将AI视为投资的重中之重

毕马威对 400 名美国首席执行官的最新调查显示,超过三分之二的首席执行官将投资生成式人工智能(AI)作为公司的首要任务。

虽然人们对 AI 的兴奋是显而易见的,而且企业也将其作为重中之重,但这些投资可能需要一段时间才能获得回报。毕马威的调查发现,62% 的首席执行官预计 AI 投资将在三到五年内获得回报,而 23% 的首席执行官预计仅一到三年就能获得回报。

03

谁将拥有 AI 时代的“iPhone”?

随着 ChatGPT 等生成式 AI 工具席卷全球,科技公司希望通过包含 AI 功能的新设备从炒作中获利——科技领导者将这种现象称为“iPhone 时刻”。

上周,马克·扎克伯格推出了 Meta 的最新一代 Ray-Bans Meta 智能眼镜,佩戴者可以通过 Meta 的对话助手 Meta AI 与眼镜对话,实时接收信息,并用它来直播视频片段。

甚至有报道称,苹果公司前设计总监、曾领导 iPhone 设计的 Jony Ive 和 OpenAI 首席执行官Sam Altman 正在共同打造一款专用的 AI 硬件设备,“采用全新的外形设计,不受矩形屏幕的限制”。据报道,软银首席执行官 Masayoshi Son 正考虑向该企业注资 10 亿美元。

这款神秘的设备还没有正式公布,但 Altman 告诉 Salesforce 首席执行官 Marc Benioff,“不把智能集成到每个产品和服务中,很快就会变得不可想象”。

04

IBM 发布新的AI驱动的

威胁检测和响应服务

IBM 今天发布了其管理检测和响应服务的下一代产品,该产品采用了新的人工智能技术,包括自动升级或关闭高达 85% 的警报能力,有助于加快客户的安全响应时间。

新的威胁检测和响应服务(TDR)可全天候监控、调查和自动修复来自客户混合云环境中所有相关技术的安全警报,包括现有的安全工具和投资,以及云、内部部署和运营技术(OT)。托管服务由 IBM 咨询公司的全球安全分析师团队通过 IBM 先进的安全服务平台提供,该平台从公司庞大的全球安全网络中应用多层 AI 和上下文威胁情报,帮助自动消除噪音,同时快速升级关键威胁。

05

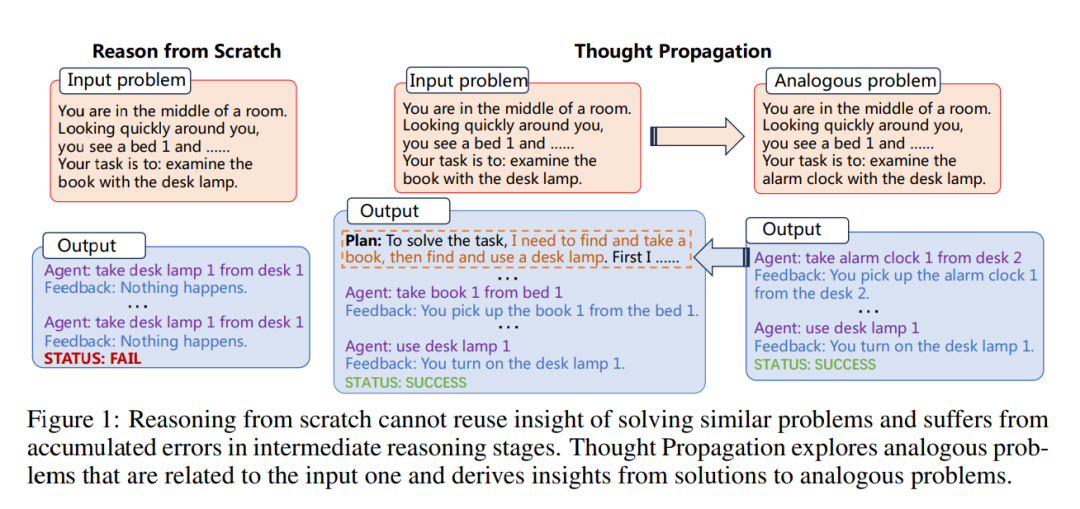

Thought Propagation:

利用LLMs进行复杂推理的类比方法

随着提示方法的发展,大型语言模型(LLMs)在推理任务中取得了显著的成就。然而,现有的提示方法无法重复利用解决类似问题的经验,并且在多步骤推理中存在累积错误,因为它们会提示 LLMs 从头开始推理。

为了解决这些问题,来自中国科学院、英国耶鲁大学的研究人员提出了 Thought Propagation,它可以探索类似问题,并利用它们的解决方案来增强 LLMs 的复杂推理能力。实验表明,TP 比基线方法有了大幅改进,在最短路径推理中,找到最优解的绝对值平均提高了 12%;在创意写作中,人类的偏好提高了 13%;在 LLM-Agent Planning 中,任务完成率提高了 15%。

论文:

Thought Propagation: An Analogical Approach to Complex Reasoning with Large Language Models

06

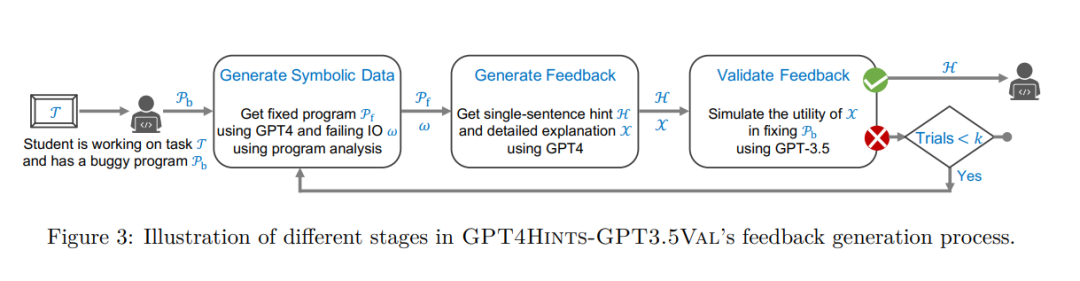

GPT-4 教 GPT-3.5 编程

效果怎么样?

研究人员研究了生成式 AI 模型在提供人类导师式编程提示方面的作用,来帮助学生解决程序中的错误。最近的一些研究已经针对各种反馈生成场景对最先进的模型进行了基准测试;然而,这些模型的整体质量仍然不如人类导师,还不能用于现实世界的部署。

来自马克斯·普朗克软件系统研究所、密歇根大学和微软的研究人员试图将生成式 AI 模型推向提供高质量编程提示的极限,并开发了一种新技术 GPT4Hints-GPT3.5Val。第一步,该技术利用 GPT-4 作为“导师”模型来生成提示。下一步,利用 GPT-3.5(一个较弱的模型)作为“学生”模型来进一步验证提示质量。该研究使用三个真实世界的 Python 程序数据集进行了广泛的评估,涵盖了从基本算法到正则表达式以及使用 pandas 库进行数据分析等各种概念,从而展示了此技术的功效。

论文:

Automating Human Tutor-Style Programming Feedback: Leveraging GPT-4 Tutor Model for Hint Generation and GPT-3.5 Student Model for Hint Validation

07

利用多代理强化学习

进行自我监督神经元分割

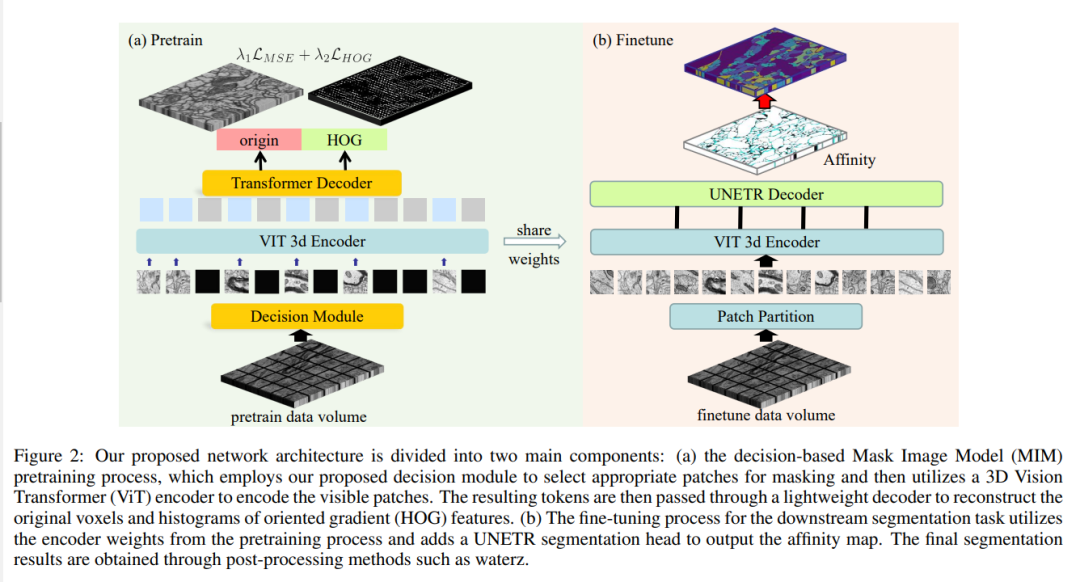

现有监督神经元分割方法的性能高度依赖于准确注释的数量,尤其是在应用于大规模电子显微镜(EM)数据时。通过从无标注数据中提取语义信息,自监督方法可以提高下游任务的性能,其中掩码图像模型(MIM)因其简单有效,能从掩码图像中恢复原始信息而得到广泛应用。然而,由于电磁图像具有高度的结构局部性,同时存在大量噪声,许多体素几乎不包含辨别信息,这使得 MIM 预训练在神经元分割任务中效率低下。

为了克服这一难题,该研究提出了一种基于决策的 MIM,它利用强化学习(RL)自动搜索最佳图像掩蔽比例和掩蔽策略。由于探索空间巨大,使用单个代理 RL 进行体素预测是不切实际的。因此,研究人员将每个输入补丁视为一个具有共享行为策略的代理,从而实现多代理协作。实验表明,在神经元分割任务上,此方法与其他自监督方法相比具有显著优势。

论文:

Self-Supervised Neuron Segmentation with Multi-Agent Reinforcement Learning

08

微软新研究:

减少LLMs幻觉的自然语言推理链

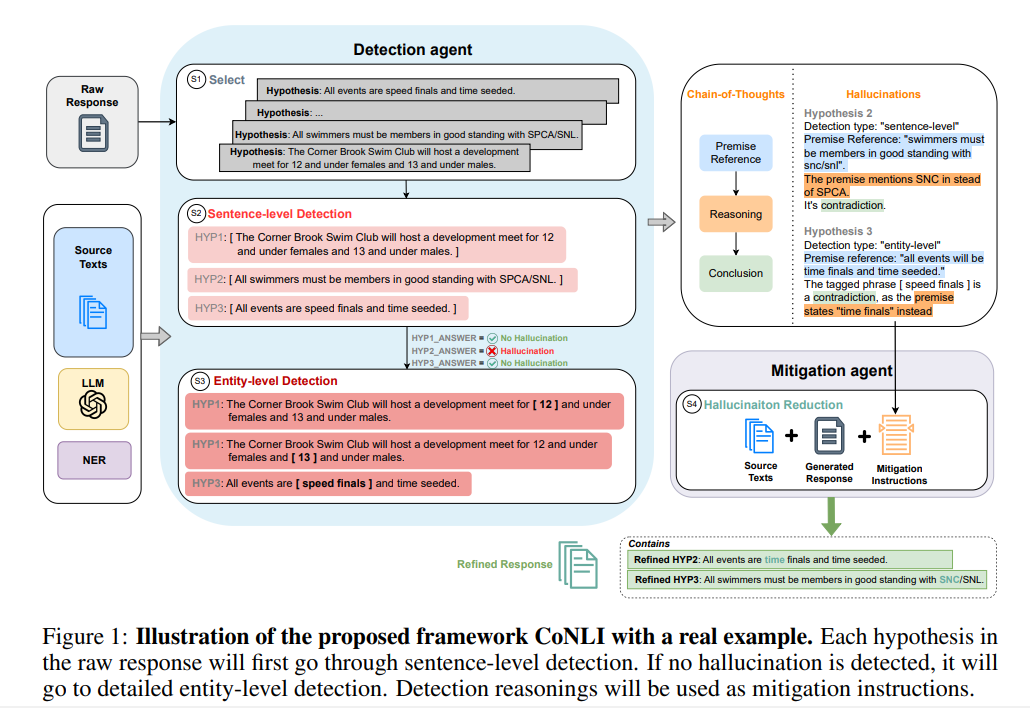

大型语言模型(LLMs)可以在给定相关文档作为背景语境的情况下生成流畅的自然语言文本。这种能力引起了人们对开发 LLMs 行业应用的极大兴趣。然而,LLMs 容易产生没有所提供来源支持的幻觉。

该研究提出了一个分层框架来检测和减轻这种无根据的幻觉。该框架使用自然语言推理链进行幻觉检测,并通过后期编辑减少幻觉。此方法在幻觉检测方面实现了最先进的性能,并通过重写提高了文本质量,使用 LLM 时无需任何微调或特定领域的提示工程。研究表明,这种简单的即插即用框架可以作为幻觉检测和减少幻觉的有效选择,在各种情况下都能实现具有竞争力的性能。

论文:Chain of Natural Language Inference for Reducing Large Language Model Ungrounded Hallucinations

|点击关注我 👇 记得标星|

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง