What do larger image classifiers memorise?

M Lukasik, V Nagarajan, A S Rawat, A K Menon, S Kumar

[Google Research]

模型大小与记忆的关系

- 使用Feldman(2019)提出的稳定性记忆度量,研究图像分类模型大小增大时的记忆情况。

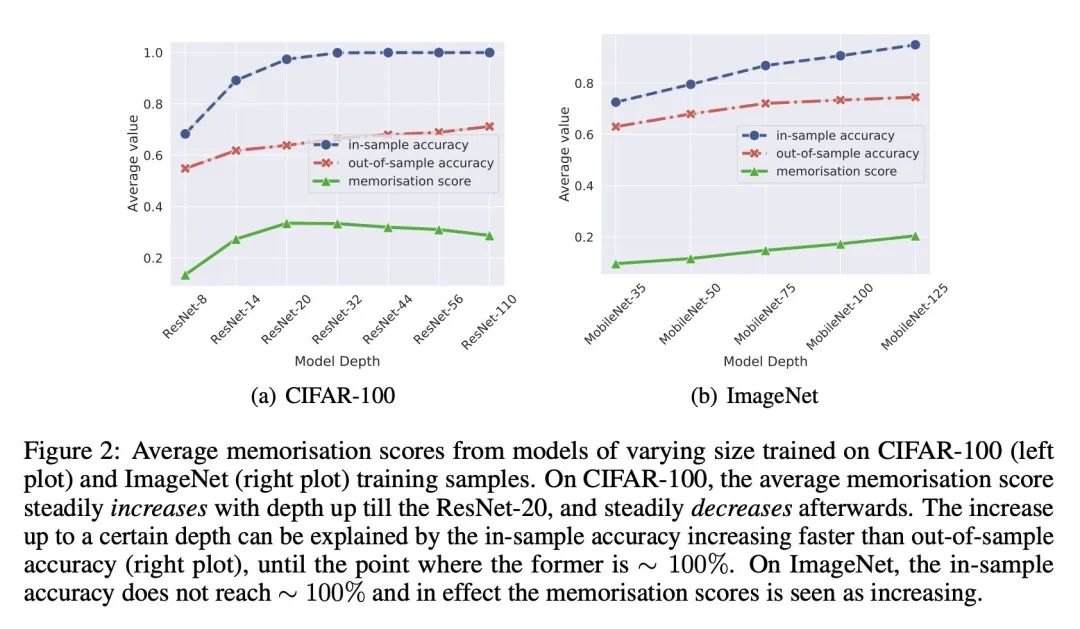

- 在CIFAR-100数据集上,随着模型深度的增加,平均记忆度先增加后减少,因为在样本内准确率饱和的同时,样本外准确率持续提高。

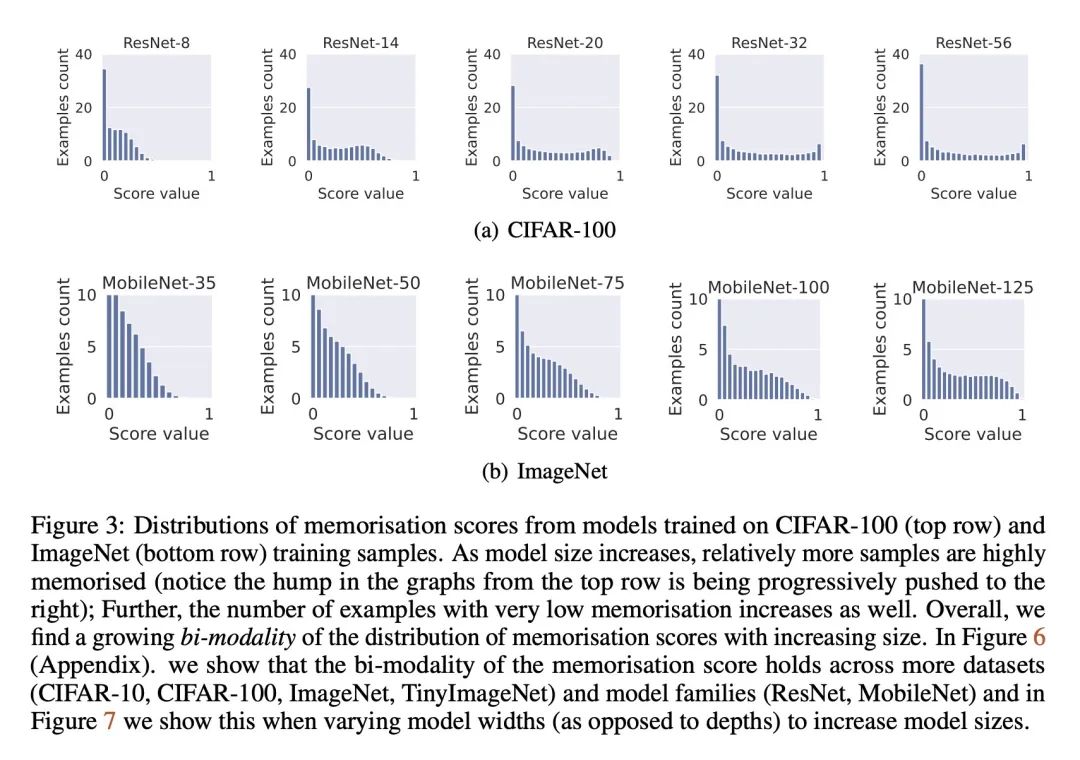

- 随着模型变大,记忆度分布变得越来越双峰——越来越多样本的记忆度接近0或1。

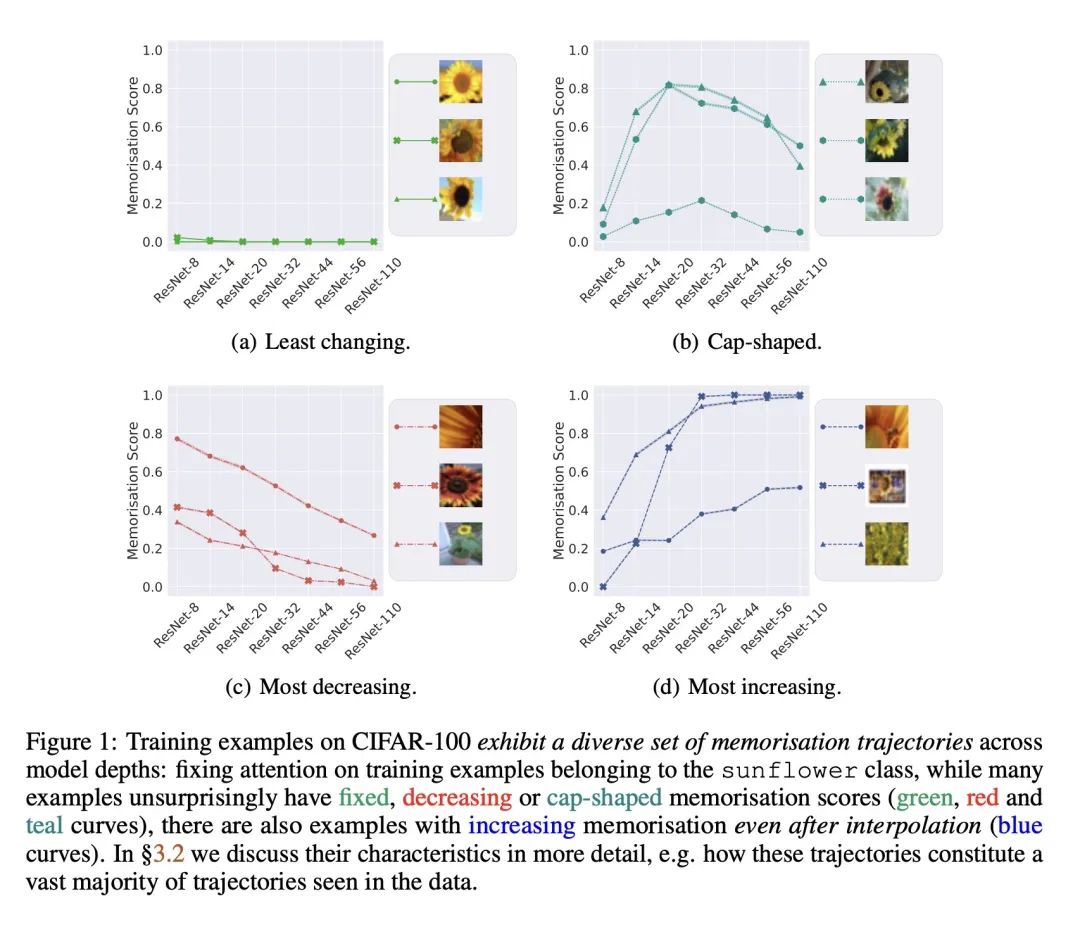

- 不同大小的模型对样本的记忆轨迹各异——大多数样本的记忆度降低,但某些样本的记忆度即使在模型输出饱和后也增加。

- 记忆度增加的样本通常含义模糊或错误标记,记忆度降低的样本虽复杂但标记正确。

- 一些记忆度近似指标如C-score无法反映记忆度的双峰分布和样本轨迹的多样性。

- 知识蒸馏抑制记忆,特别是对记忆度高的样本的记忆,它主要影响记忆度增加的样本,从而提高泛化能力。

动机:研究现代神经网络为什么能在训练集上完美拟合(“记忆”)随机标签的情况下,仍然能良好地进行泛化。

方法:使用Feldman提出的记忆度量方法,对不同模型大小的图像分类模型进行全面的实证分析,研究模型大小与记忆之间的关系,并探索知识蒸馏对记忆的影响。

优势:通过详细的实验和分析,揭示了模型大小与记忆之间的复杂关系,发现了记忆在不同模型大小下的多样性变化,并证明了知识蒸馏可以抑制记忆,同时改善泛化性能。

通过研究模型大小与记忆之间的关系以及知识蒸馏对记忆的影响,揭示了神经网络泛化能力与记忆之间的复杂关系,提出一种新的视角来理解神经网络的学习行为。

https://arxiv.org/abs/2310.05337

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง