FireAct: Toward Language Agent Fine-tuning

B Chen, C Shu, E Shareghi, N Collier, K Narasimhan, S Yao

[System2 Research & University of Cambridge & Monash University]

FireAct:语言Agent微调

-

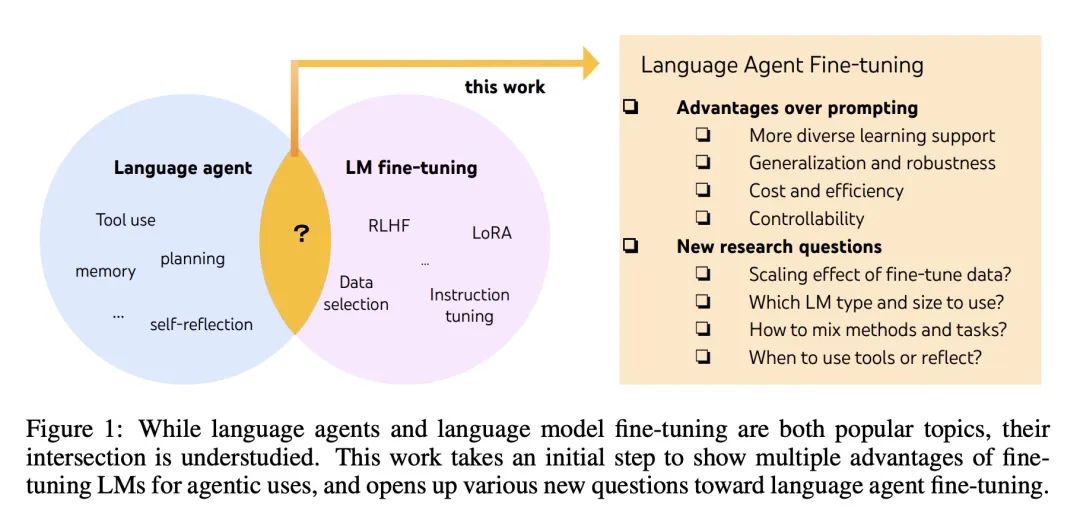

提出FireAct,一种用来微调语言模型的新方法,作为语言Agent的骨干模型。

-

现有的大多数语言Agent依赖于大型语言模型的少样本提示,这在性能、效率、鲁棒性和泛化性方面都存在局限性。

-

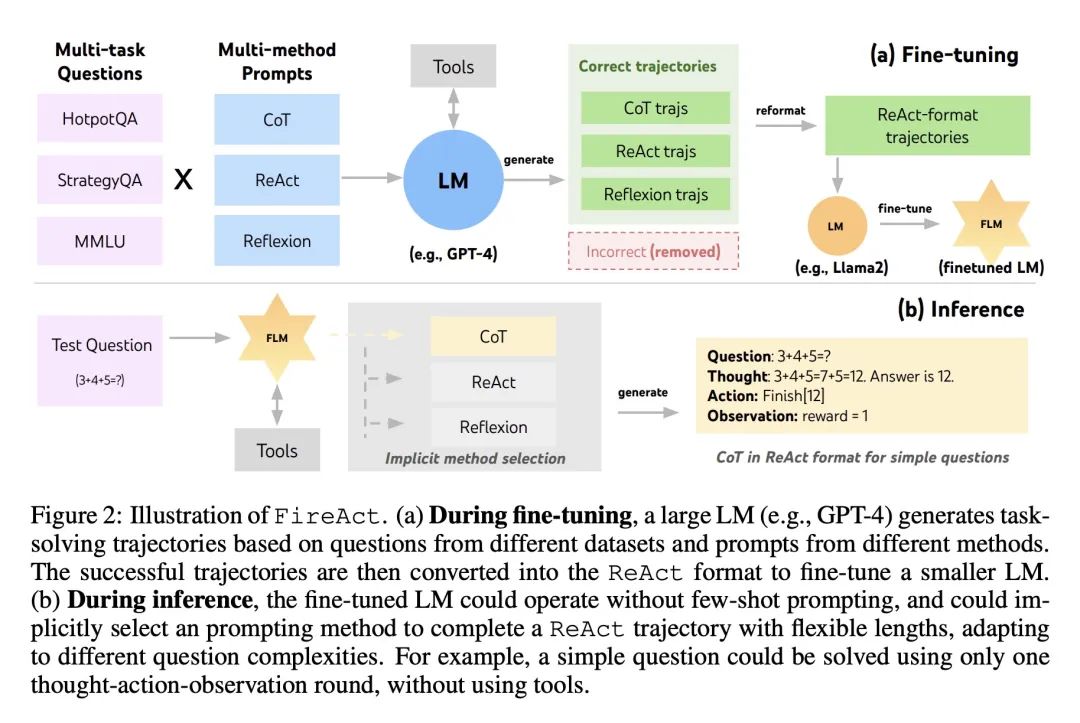

FireAct利用像GPT-4这样强大的语言模型,根据不同的任务和方法生成各种推理轨迹(ReAct、CoT、Reflexion格式),这些轨迹用于微调较小的语言模型。

-

在问答任务中使用Google搜索工具的实验表明,与提示相比,微调在精确匹配准确率、推理成本和时间以及对误导工具输出的鲁棒性方面都带来了实质性改进。

-

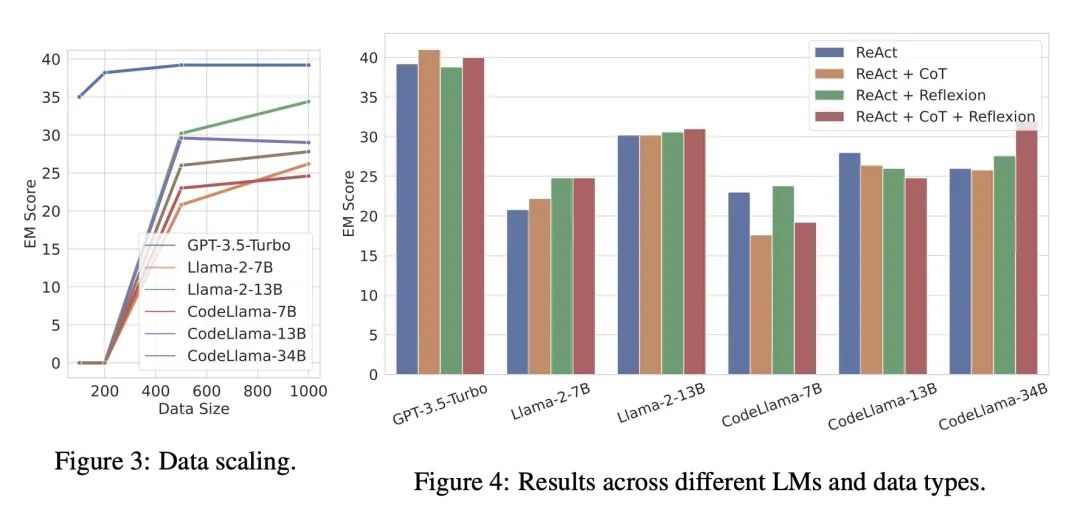

微调在泛化到未见的数据集方面也显示出更好的性能,像Llama-2这样的小型语言模型可以通过微调来匹配或超过像GPT-3.5这样的大型提示语言模型。

-

来自多个方法和任务的更多样化微调数据可导致更灵活的Agent,它们可以隐式地根据任务复杂性调整推理策略。

-

基础语言模型、提示方法、任务和数据大小之间的交互非常复杂,GPT-3.5的样本效率最好,但较小的语言模型在有更多数据的情况下可以赶上。

-

阐明了语言模型微调对Agent的多方面优势,并为该领域的新研究方向开辟了新的道路。

动机:研究语言模型微调对语言Agent的影响,以解决现有语言Agent在性能、鲁棒性、成本等方面存在的问题。

方法:提出一种名为FireAct的方法,通过使用来自多个任务和提示方法的Agent轨迹来对语言模型进行微调,以提高语言Agent的性能和鲁棒性。

优势:通过实验证明,微调语言Agent可以显著提升语言Agent的性能,降低推理时间和成本,并且更多的微调数据可以进一步改善Agent的表现。

研究了语言模型微调对语言Agent的影响,通过使用多任务和多提示方法的Agent轨迹进行微调,提高了Agent的性能和鲁棒性,解决了现有语言Agent存在的问题。

https://arxiv.org/abs/2310.05915

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง