Understanding the Effects of RLHF on LLM Generalisation and Diversity

R Kirk, I Mediratta, C Nalmpantis, J Luketina, E Hambro, E Grefenstette, R Raileanu

[Meta & University College London & University of Oxford]

RLHF对LLM泛化性和多样性的影响

-

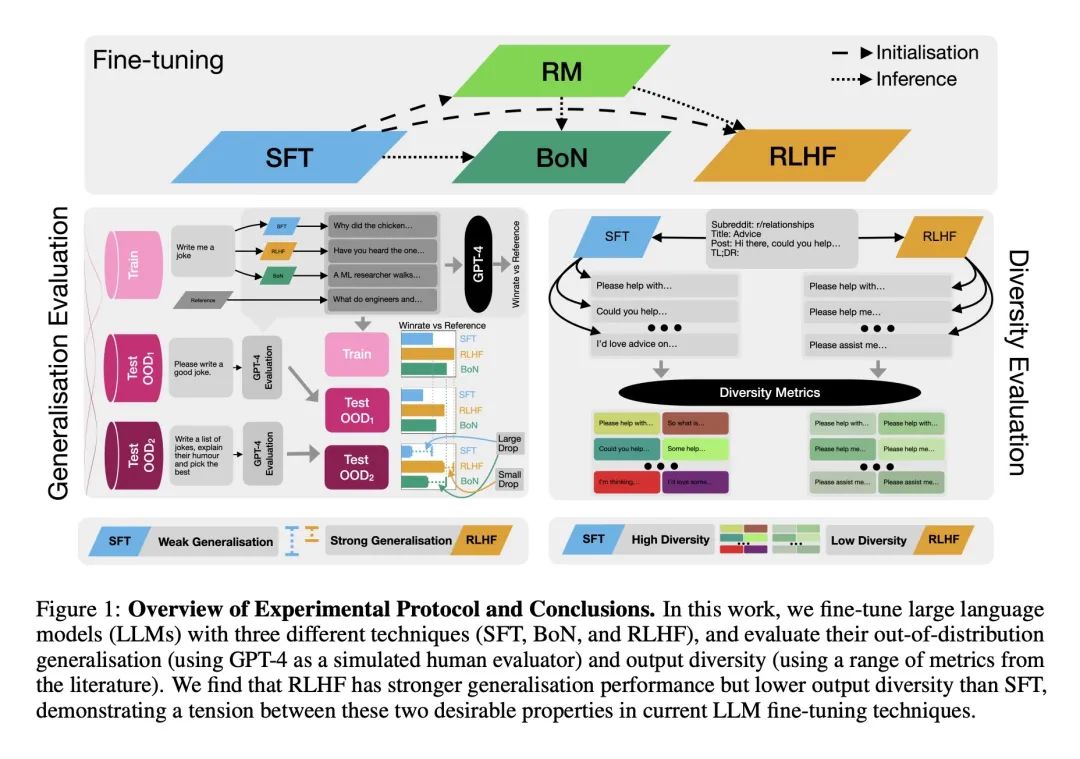

分析了三种大规模语言模型(LLM)微调方法:监督微调(SFT)、人工反馈强化学习(RLHF)和最佳N采样(BoN)。

-

评估了这些方法在两个关键属性上的效果:分布外(OOD)泛化和输出多样性。

-

RLHF相比SFT改进了在分布内和分布外的性能,但是,它大大降低了输出的多样性,无论是对单个输入采样多个输出,还是对不同输入采样输出。

-

在更困难的分布迁移上(例如非常不同的数据集),RLHF比SFT泛化性更好,在更轻易的迁移上,这些方法的泛化性相似。

-

在选择当前LLM微调方法时,存在固有的泛化性和多样性之间的权衡。

-

结果表明,当O分布外泛化至关重要时,应该使用RLHF;当多样性重要时,应该使用SFT。

-

需要进一步研究为何RLHF降低了多样性,以及是否可以在不牺牲多样性的情况下改进泛化性的新方法。

动机:

研究者们希望填补我们对强化学习用人工反馈微调大型语言模型(LLM)的每个阶段对模型的影响的了解不足,特别是在模型的泛化和输出多样性方面的影响。 方法:进行了对每个阶段(监督微调、奖励建模和强化学习)对模型的两个关键属性(分布外泛化和输出多样性)的影响的广泛分析,通过在总结和指令跟随任务上使用两个基础模型进行实验。

优势:

研究发现,与监督微调相比,强化学习用人工反馈微调可以更好地泛化到新的输入,特别是在训练和测试之间的分布差异变大时。然而,与监督微调相比,人工反馈强化学习微调显著降低了输出的多样性,表明当前的LLM微调方法在泛化和多样性之间存在权衡。这些结果为选择合适的微调方法提供了指导,并表明需要进一步研究如何改进泛化和多样性之间的权衡。

通过广泛分析人工反馈强化学习中微调的每个阶段对大型语言模型的泛化和多样性的影响,发现泛化和多样性之间存在权衡,为选择合适的微调方法提供了指导。

https://arxiv.org/abs/2310.06452

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง