01

摘要

由于训练数据中语言分布不均衡,现有的大语言模型(Large Language Model, LLM)在不同语言上的能力差距很大。它们在英语任务上的表现通常要比在非英语任务上强得多。为了改善这个问题,我们在本文中提出在语言之间进行语义对齐来提升LLM的非英语能力。我们首先从提升LLM在单独某种非英语语言上的语言能力开始,对LLaMA进行了跨语言指令微调(Cross-lingual Instruction-tuning, CoIT)。通过使用翻译任务指令数据和跨语言通用任务指令数据对其进行微调,即可获得跨语言模型x-LLaMA。我们也对跨语言指令微调中的scaling law进行了建模和研究,展现了使用可扩展的翻译数据的优势。随后,我们进一步探究同时激发LLM在多种非英语语言上的能力。我们通过混合多语言数据对LLaMA进行多语言指令微调(Multilingual Instruction-tuning, MuIT)来构建多语言模型m-LLaMA。我们还展示了如何利用scaling law在资源受限的场景下优化MuIT的数据配比。在基准数据集XQUAD和MLQA上的实验结果显示,x-LLaMA在六种非英语语言上的平均表现可以超过只用英文指令微调的Alpaca 27.83%。在翻译数据集Flores-101上,x-LLaMA也可以比此前基于LLaMA的模型平均提升18.89%。而m-LLaMA不进可以在各个语言上达到了与x-LLaMA相当的性能,并且具备了执行多语言指令的能力。通过对生成内容和表示空间的进一步分析,我们发现m-LLaMA的多语言语义空间中已经出现了明显的语言对齐现象。

【该工作由南京大学自然语言处理组与北京大学、上海人工智能实验室、香港大学、加州大学圣巴巴拉分校共同合作完成。本文的预印本已发布在arXiv:https://arxiv.org/pdf/2308.04948.pdf,本文相关代码已发布在Github:https://github.com/NJUNLP/x-LLM】

02

方法

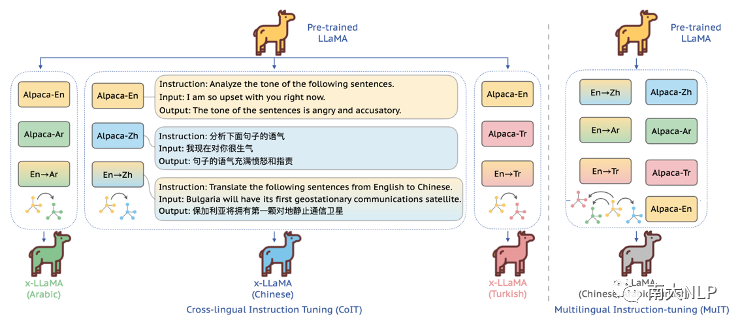

在本文中,我们探索通过强化英语与非英语之间的语义对齐来激发LLM的非英语能力(如图1)。相比于使用大规模单语数据进行继续预训练,我们的方案需要的非英语数据更少,产生的计算开销也更少。以下是对我们方法的具体介绍:

图 1 关于跨语言指令微调和多语言指令微调的示意图

-

跨语言指令微调

为了将英语与某种非英语对齐,提升LLM在目标语言上的表现,我们使用跨语言指令微调,使用跨语言通用任务指令数据和翻译任务指令数据来对LLM进行指令微调。

跨语言通用任务指令数据 跨语言通用任务指令数据包含英语版本和非英语版本的通用任务指令数据。由于通常使用的指令微调数据以英语内容为主导,我们使用翻译引擎得到了非英语版本。使用双语版本的通用任务指令数据,可以让LLM更好地理解和执行跨语言指令。

翻译任务指令数据 直觉上来说翻译数据是对学习语义对齐是最有帮助的数据。之前的研究显示,使用专家标注的翻译指令数据可以显著提升LLM的翻译能力 [1,2]。但与此前的工作不同,本文使用公开的平行语料,如WikiMatrix [3], NewsCommentary [4],来构建翻译任务指令数据。这使得我们的方法更加可复现和可扩展。另外,尽管En-X(从英语翻译到非英语)和X-En(从非英语翻译到英文)这两种方向的翻译数据都可以帮助LLM学习语义对齐,我们发现将非英语作为翻译数据的目标端更能提升LLM的非英语能力。

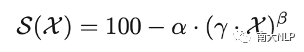

2. 跨语言指令微调中的scaling law

双语翻译表现是语义对齐程度的一种直接体现。我们在实验中发现翻译任务指令数据的规模对语义对齐程度影响巨大。为了量化描述翻译表现与翻译数据规模之间的关系,我们对scaling law进行了建模。在设计公式的过程中,我们考虑了以下三点因素:(1)翻译表现的上限通常是100,这也是常用翻译质量评估指标的最大分数。(2)随着翻译数据规模变大,翻译表现往往也会提升。(3)对于与英语差距较大的非英语,会需要更多的翻译数据构建语义对齐。因此,我们将scaling law写成如下形式:

其中和是需要估计的参数,是目标语言与英语之间的相似度。在后文中,我们将介绍如何利用这些scaling law在资源受限场景下解决多语言数据分配问题。

3. 多语言指令微调

尽管跨语言指令微调是一种有效的方案,但是为不同非英语语言定制不同的模型还是会带来很大的部署代价。因此我们进一步探究能否将LLM的英语能力同时拓展到多种语言。为了达到这一目的,我们混合多语言数据进行多语言指令微调。多语言数据具体包括:多语言通用任务指令数据和多语言翻译任务指令数据。在混合多语言资源时,我们考虑两种场景:

资源非受限场景 在该场景中,我们将所有可获得的多语言数据混合进行指令微调,无需考虑使用大量数据进行指令微调所带来的巨大计算开销。

资源受限场景 在该场景中,我们考虑了数据预算这一因素,这意味着只有固定数目的指令数据可以被用于指令微调。比如说,在多语言指令微调时使用的翻译任务指令数据的总量是固定的。为了在这种情况下取得最优的数据分配策略,我们提出将数据分配问题建模为非线形规划问题,规划目标是取得最高的平均多语言表现。

03

实验设定

预训练LLM 我们使用LLaMA-7B作为基座模型。它被证实有着强大的英语能力,但是非英语能力欠佳 [5]。我们选定六种语言作为非英语目标语言,包括阿拉伯语(Ar),希腊语(El),印地语(Hi),土耳其语(Tr),越南语(Vi)和中文(Zh)。

基线LLM 我们对比的基线LLM包括各种基于LLaMA微调得到的模型,包括Alpaca-7B [6](使用英语指令微调得到),Parrot-7B [1](使用专家标注的翻译数据微调得到),Bayling-7B [2](使用专家标注的交互式翻译数据和英语指令数据微调得到)。另外,我们还报告了Chinese-Alpaca-7B [7]和Bigtrans-13B [8]作为参考,这两个模型扩充了LLaMA的词表并使用大规模中文单语数据进行了继续预训练。

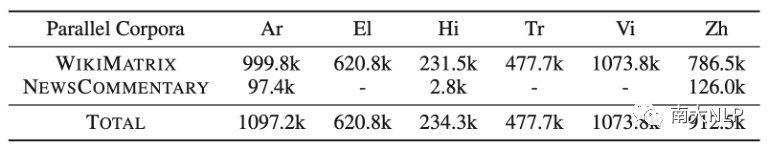

指令微调细节 对于翻译任务指令数据,我们使用了公开的平行语料Wikimatrix和NewsCommentary(表格1)。对于通用任务指令数据,我们采用了Alpaca数据集[7],其中包含了52k条英文问题和相应的回答。通过将这些数据翻译成非英语版本,我们进一步得到了跨语言通用任务指令数据。

表格 1 数据集统计情况

评估数据集 为了评估LLM的非英语能力,我们使用了基准数据集XQUAD [9]和MLQA [10]。此外我们还构建了一个多语言测试集MI-Eval来评估LLM执行多语言指令的能力。为了评估LLM的翻译能力,我们使用了多语言机器翻译数据集Flores-101 [11]

评估指标 在XQUAD,MLQA和MI-Eval上我们参照前人做法使用ChatGPT进行生成质量评估 [12,13]。在XQUAD和MLQA上我们也报告了严格匹配的评估结果。在Flores-101上,我们使用COMET,BLEURT和spBLEU作为评估指标。

04

主要实验结果

1.跨语言指令微调相关结果

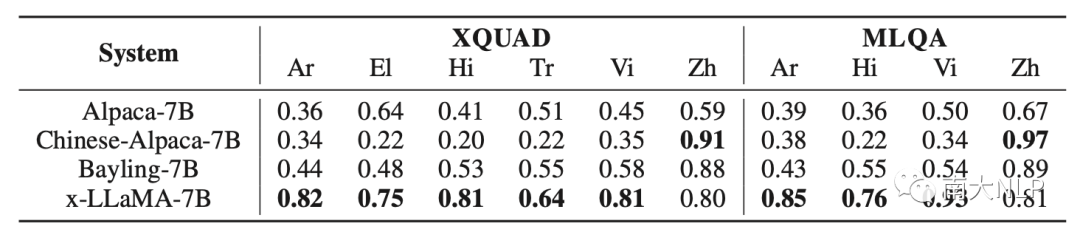

x-LLaMA在非英语QA任务上取得了巨大性能提升 从表格2的实验结果来看,Alpaca-7B在非英语上表现很差。而为各语言定制的x-LLaMA模型都可以在各语言上相比于Alpaca模型取得巨大提升,在六种非英语语言上平均提升达到27.83%。并且x-LLaMA的非英文回答准确率可以在部分语言上接近Alpaca-7B的英语回答准确率(0.95)。这说明跨语言指令微调可以很好地激发LLM的非英文能力

表格 2 在XQUAD和MLQA上的评估结果

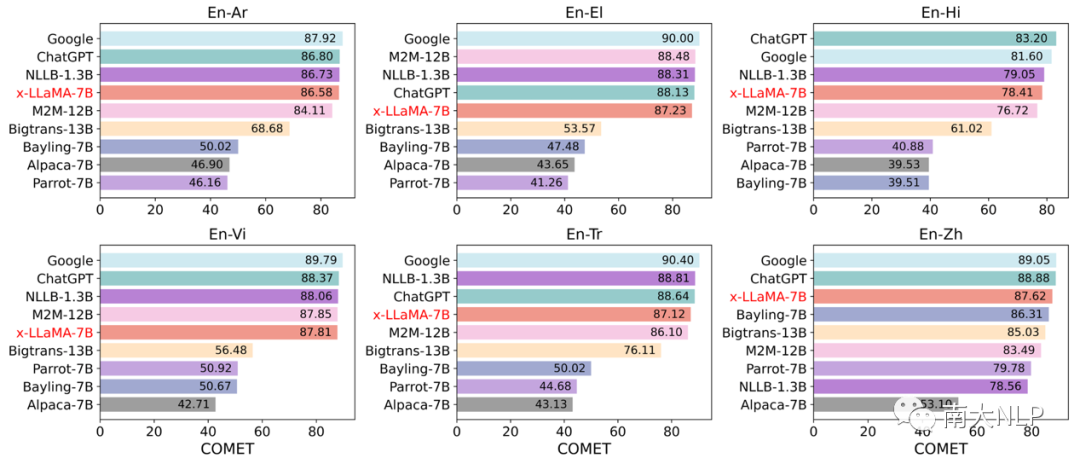

x-LLaMA也具备着很强的翻译能力 图2展示了不同系统在将英语翻译成非英语时的翻译表现。从图中可以看出,相比于其他基于LLaMA微调得到的模型,x-LLaMA在各方向上都有着更高的翻译表现。x-LLaMA甚至在部分方向上超过强大的有监督多语言模型M2M [14]。并且与Google Translate和ChatGPT这两个商用引擎间的差距也有限。

图 2 不同系统的翻译表现对比

图 2 不同系统的翻译表现对比

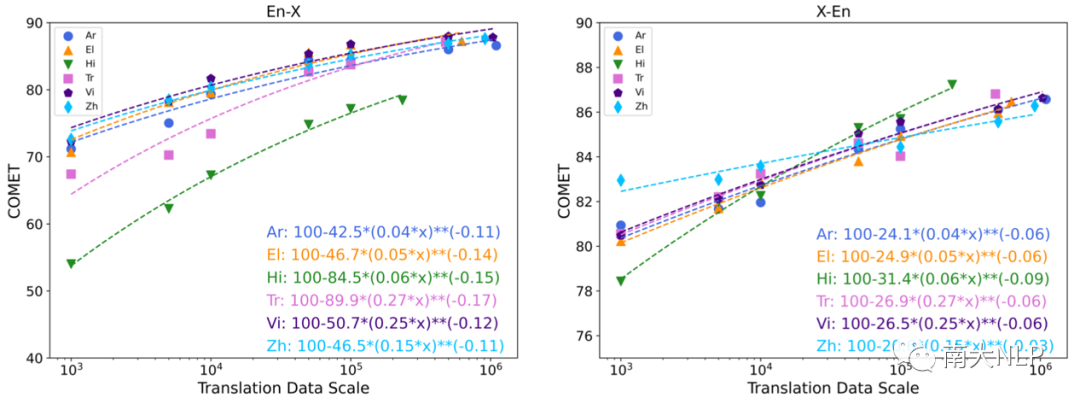

对跨语言指令微调中scaling law的研究 图3展示了翻译任务指令数据规模对模型翻译表现的影响。总体来说,使用更大规模的翻译数据基本都可以带来更高的翻译表现。我们提出的建模公式可以很好地拟合整体变化趋势。从该公式可以看出使用规模可扩展的翻译数据对于完善语义对齐是非常必要的

图 3 翻译表现随翻译数据规模的变化情况

图 3 翻译表现随翻译数据规模的变化情况

2. 多语言指令微调相关结果

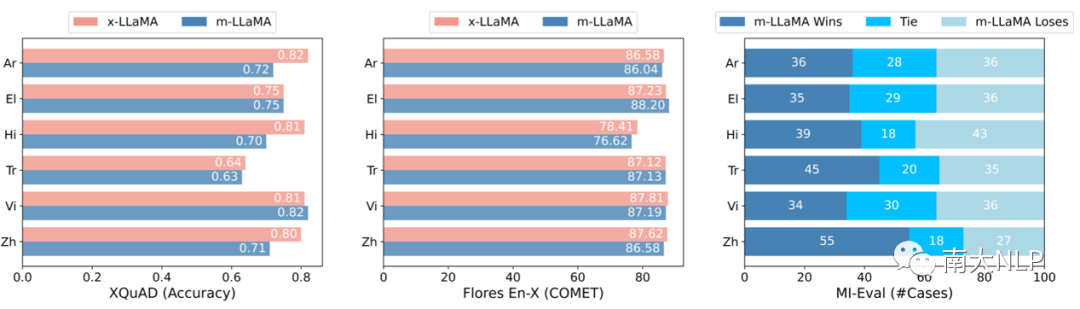

m-LLaMA可以与x-LLaMA在各个语言上取得近似表现 我们首先考虑资源非受限的场景,直接将所有可获得的资源混合构建多语言模型m-LLaMA。我们将其与为各语言单独定制的x-LLaMA模型进行了比较(图4)。从实验结果可以看出,m-LLaMA在非英语QA任务和多语言翻译任务上都可以取得与x-LLaMA近似的表现。这说明将预训练LLM的英语能力同时推广到多种非英语语言是可以实现的。

图 4 m-LLaMA与x-LLaMA之间的性能比较

图 4 m-LLaMA与x-LLaMA之间的性能比较

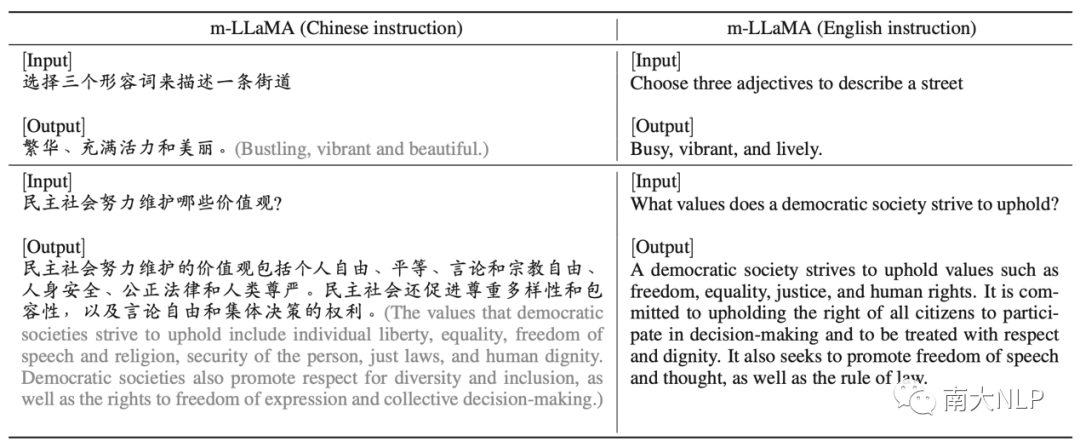

m-LLaMA能够根据英语记忆应对多语言指令 相比于x-LLaMA,m-LLaMA的一个独特的优势在于能够执行多语言指令。并且在MI-Eval数据集上的实验结果表明,m-LLaMA在各语言上的指令执行能力与为各语言定制的x-LLaMA相似。另外我们还发现m-LLaMA存在根据英文记忆回答非英语问题的倾向。表格3中展示了两个典型的例子。在这些例子中m-LLaMA给出的中文回复与英文回复内容十分相似。这意味着在指令微调后,英语和非英语正在模型内部逐渐对齐。

表格 3 案例分析

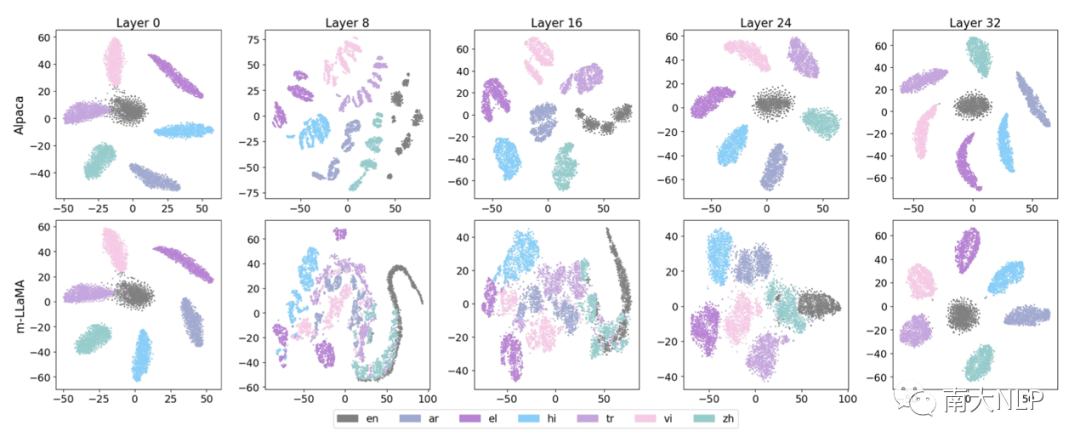

可视化结果进一步证实了在m-LLaMA的多语言语义空间内存在对齐现象 我们观察了m-LLaMA和Alpaca-7B的表示空间,发现对于Alpaca-7B,不同语言的表示不管在LLM底层还是在顶层都是始终分开的。而对于m-LLaMA,不同语言的表示存在重叠。表示重叠的现象在模型的中间层种尤其明显,如第8层、第16层。这些可视化的结果也表明多语言指令微调可以帮助语言对齐。

图 5 对Alpaca和m-LLaMA表示空间的可视化分析结果

图 5 对Alpaca和m-LLaMA表示空间的可视化分析结果

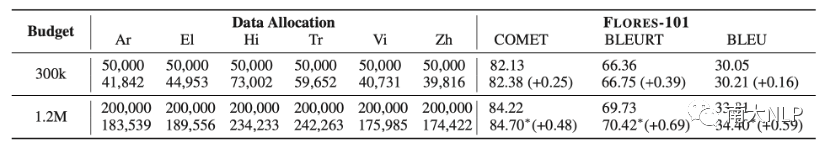

利用scaling law可以在资源受限时确定最优数据配比 现在我们考虑资源受限场景。表格4中对比了使用优化数据配比和均匀数据配比时模型的多语言翻译表现。我们发现当数据预算为300k时,不同配比策略间的差距并不大。而当数据预算为1.2M时,我们的数据配比方法显著好于均匀配比。

表格 4 在资源受限场景下,优化数据分配与均匀数据分配的对比结果

05

总结

在本文中,我们探究了如何通过语言对齐的方式将预训练LLM的英语能力拓展到非英语。具体而言,我们探索了两种方案:跨语言指令微调和多语言指令微调。实验结果表明我们的跨语言模型(x-LLaMA)在非英语任务上可以取得显著的进步。而在混合多语言资源进行多语言指令微调时,我们的多语言模型m-LLaMA不仅可以在各语言上取得与为各语言定制的x-LLaMA相似的表现,还具备了执行多语言指令的能力。在资源受限场景下,我们也展示了如何通过scaling law优化多语言指令微调的数据配比,取得最优的平均多语言表现。总体而言,我们的方法和研究结果都表明为非英语语言开发更强大的语言模型存在着巨大的研究空间。

参考文献

[1] Wenxiang Jiao, Jen-tse Huang, Wenxuan Wang, Xing Wang, Shuming Shi, and Zhaopeng Tu. Parrot: Translating during chat using large language models. arXiv:2304.02426, 2023.

[2] Shaolei Zhang, Qingkai Fang, Zhuocheng Zhang, Zhengrui Ma, Yan Zhou, Langlin Huang, Mengyu Bu, Shangtong Gui, Yunji Chen, Xilin Chen, Yang Feng. Bayling: Bridging cross-lingual alignment and instruction following through interactive translation for large language models. arXiv:2306.10968, 2023.

[3] Holger Schwenk, Vishrav Chaudhary, Shuo Sun, Hongyu Gong, and Francisco Guzmá

n. WikiMatrix: Mining 135M Parallel Sentences in 1620 Language Pairs from Wikipedia. EACL 2021.

[4] Joerg Tiedemann. Parallel data, tools and interfaces in OPUS. LREC 2012.

[5] Hugo Touvron, Thibaut Lavril, Gautier Izacard, Xavier Martinet, Marie-Anne Lachaux, Timothée Lacroix, Baptiste Rozière, Naman Goyal, Eric Hambro, Faisal Azhar, et al. Llama: Open and efficient foundation language models. arXiv:2302.13971, 2023.

[6] Rohan Taori, Ishaan Gulrajani, Tianyi Zhang, Yann Dubois, Xuechen Li, Carlos Guestrin, Percy Liang, and Tatsunori B. Hashimoto. Stanford alpaca: An instruction-following llama model. https://github.com/tatsu-lab/stanford_alpaca, 2023.

[7] Yiming Cui, Ziqing Yang, and Xin Yao. Efficient and effective text encoding for chinese llama and alpaca. arXiv:2304.08177, 2023.

[8] Bigtrans Wen Yang, Chong Li, Jiajun Zhang, and Chengqing Zong. Bigtrans: Augmenting large language models with multilingual translation capability over 100 languages. arXiv:2305.18098, 2023.

[9] Mikel Artetxe, Sebastian Ruder, and Dani Yogatama. On the cross-lingual transferability of mono-lingual representations. ACL 2020.

[10] Patrick Lewis, Barlas Oguz, Ruty Rinott, Sebastian Riedel, and Holger Schwenk. MLQA: Evaluating cross-lingual extractive question answering. ACL 2020.

[11] Naman Goyal, Cynthia Gao, Vishrav Chaudhary, Peng-Jen Chen, Guillaume Wenzek, Da Ju, Sanjana Krishnan, MarcAurelio Ranzato, Francisco Guzmán, and Angela Fan. The Flores-101 evaluation benchmark for low-resource and multilingual machine translation. TACL 2022.

[12] Yang Liu, Dan Iter, Yichong Xu, Shuohang Wang, Ruochen Xu, and Chenguang Zhu. GPTEval: NLG evaluation using gpt-4 with better human alignment. arXiv:2303.16634, 2023.

[13] Peiyi Wang, Lei Li, Liang Chen, Dawei Zhu, Binghuai Lin, Yunbo Cao, Qi Liu, Tianyu Liu, and Zhifang Sui. Large language models are not fair evaluators. arXiv:2305.17926, 2023a.

[14]Angela Fan, Shruti Bhosale, Holger Schwenk, Zhiyi Ma, Ahmed El-Kishky, Siddharth Goyal, Mandeep Baines, Onur Celebi, Guillaume Wenzek, Vishrav Chaudhary, Naman Goyal, Tom Birch, Vitaliy Liptchinsky, Sergey Edunov, Edouard Grave, Michael Auli, Armand Joulin. Beyond english-centric multilingual machine translation. JMLR 2021.

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง