Table-GPT: Table-tuned GPT for Diverse Table Tasks

Peng Li, Yeye He, Dror Yashar, Weiwei Cui, Song Ge, Haidong Zhang, Danielle Rifinski Fainman, Dongmei Zhang, Surajit Chaudhuri

[Microsoft Corporation]

Table-GPT:针对多样化表格任务的表格微调GPT

要点:

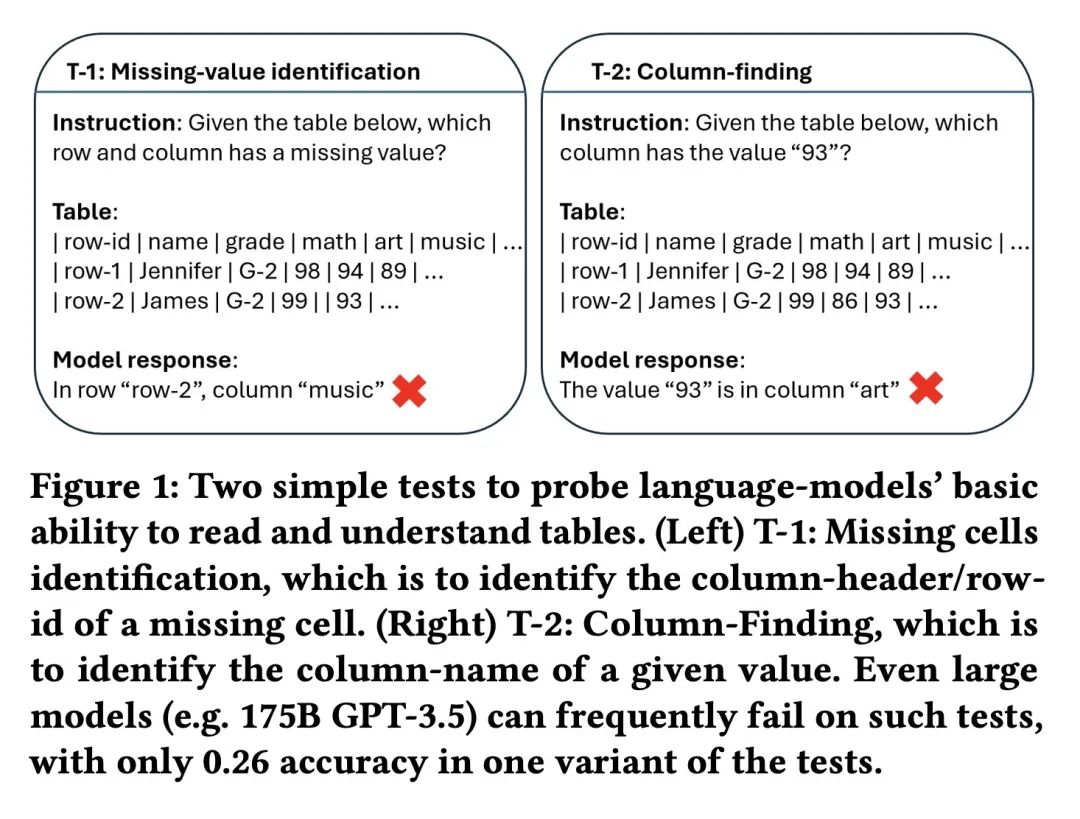

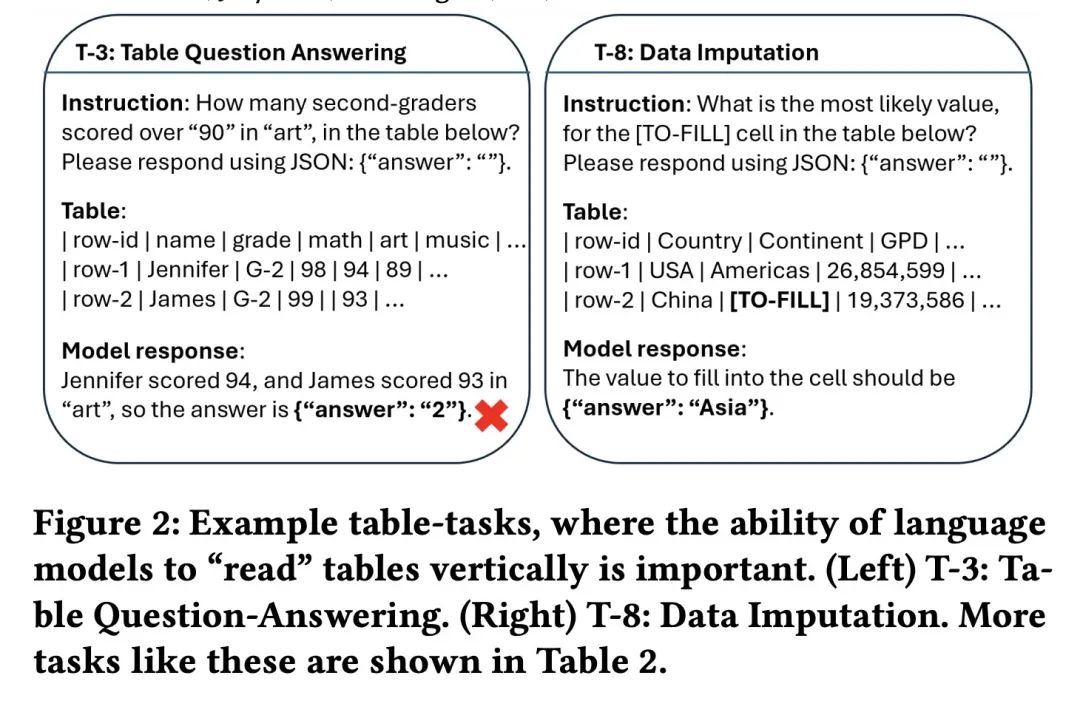

- GPT-3和ChatGPT等语言模型在自然语言任务上表现出色,但在与表格相关的任务上则存在不足,这可能是因为它们主要在文本数据上进行预训练,而表格是2D的。

- 提出“表格微调”的方法,通过继续在各种合成的表格任务上训练语言模型,来增强它们理解和操作表格的能力。

- 通过采样真实表格并自动生成数据增强、列类型注解、数据补全等任务来合成训练数据。训练数据在多个层面上进行增强以增加多样性。

- 结果产生的“Table-GPT”模型在各种已见及未见的表格任务上始终优于GPT-3.5和ChatGPT。

- Table-GPT展示了类似ChatGPT的强大泛化能力,可以通过指令执行新的表格任务,可以作为下游表格相关应用的“表格基础模型”。

- 表格微调与提示工程和特定任务微调等其他优化技术是互补的,精心设计的提示同样能使基础GPT模型和Table-GPT获得提升。

动机:当前的语言模型在处理表格相关任务时表现不佳,可能是因为它们主要在单维度的自然语言文本上进行预训练,而关系表格是二维对象。因此,提出一种新的“表格微调”方法,通过使用多样的合成表格任务作为训练数据来进一步训练/微调语言模型,以提高其理解表格和执行表格任务的能力。

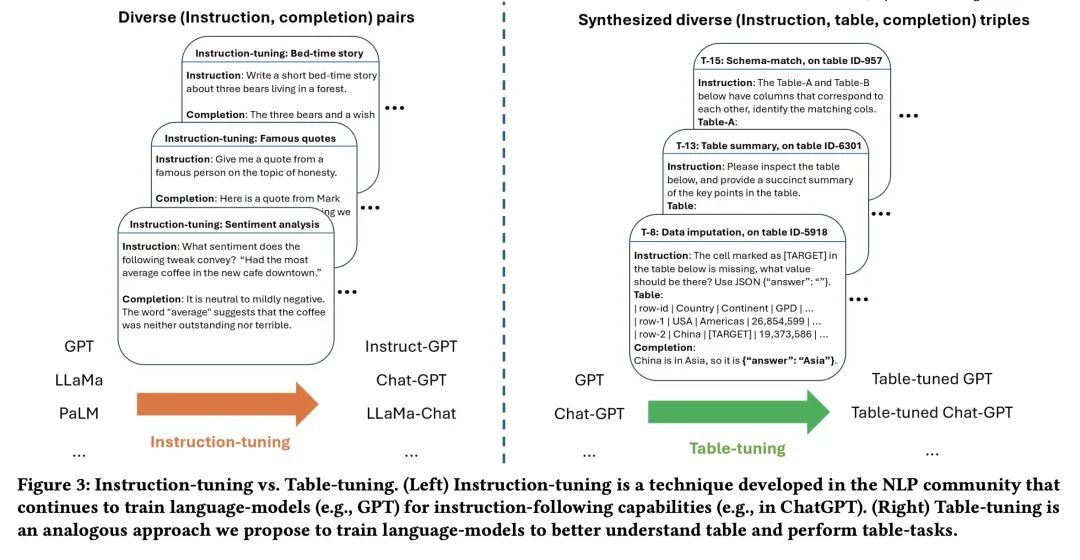

方法:采用一种新的“表格微调”范式,通过使用多样的表格任务作为训练数据,持续训练/微调语言模型,如GPT-3.5和ChatGPT,以改进其理解表格和执行表格任务的能力。

优势:本文提出的Table-GPT模型在广泛的表格任务中表现出更好的表格理解能力,并且在处理新的和未见过的表格任务时具有较强的泛化能力。

提出一种新的“表格微调”方法,通过使用多样的表格任务作为训练数据来改进语言模型的理解表格和执行表格任务的能力,取得了显著的改进。

https://arxiv.org/abs/2310.09263

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง