今日值得关注的人工智能新动态:

-

GPT-4虽可靠,但更易被欺骗

-

谷歌请求驳回AI数据抓取集体诉讼

-

纽约市发布首个负责任 AI 计划

-

综述:视频扩散模型

-

BitNet:为大型语言模型扩展 1 位 Transformers

-

Llemma:数学开放语言模型

-

字节跳动新研究:让大模型学会“选择性忘记”

-

SoM:让GPT-4V更接地

-

使用 LLMs 自动生成卫星图像字幕

01

GPT-4虽可靠,但更易被欺骗

一篇由伊利诺伊大学香槟分校、斯坦福大学、加州大学伯克利分校、人工智能安全中心和微软研究院研究人员撰写的论文给 GPT-4 打出了比其前身更高的可信度分数。他们发现,GPT-4 在保护私人信息、避免出现有毒结果(如有偏见的信息)以及抵御对抗性攻击方面普遍更胜一筹。

不过,GPT-4 也可能被告知无视安全措施,泄露个人信息和对话历史。研究人员发现,用户可以绕过 GPT-4 的防护措施,因为该模型“更精确地遵循误导信息”,更有可能完全按照非常棘手的提示操作。

02

谷歌请求驳回AI数据抓取集体诉讼

谷歌正在寻求驳回一项集体诉讼提议,该诉讼声称谷歌通过收集数据来训练其人工智能(AI)模型,侵犯了数百万互联网用户的隐私权和财产权。

谷歌于10月17日向加州地方法院提出动议,称有必要使用公共数据来训练其 AI 聊天机器人(如Bard)。谷歌辩称,这些指控基于错误的前提,即谷歌正在“窃取”互联网上公开共享的信息。谷歌表示,这样的诉讼将“不仅对谷歌的服务,而且对生成式 AI 的理念本身都是一记重锤”。

03

纽约市发布首个负责任 AI 计划

日前,纽约市市长 Eric Adams 和首席技术官 Matthew Fraser 发布了“纽约市人工智能行动计划”,为巩固纽约市在负责任地使用创新人工智能(AI)技术方面的领先地位迈出了重要一步。这项广泛的计划是美国主要城市的首个此类计划,它将为城市机构制定一个框架,以仔细评估 AI 工具和相关风险,帮助市政府员工积累 AI 知识和技能,并支持负责任地实施这些技术,来提高纽约市民的生活质量。

04

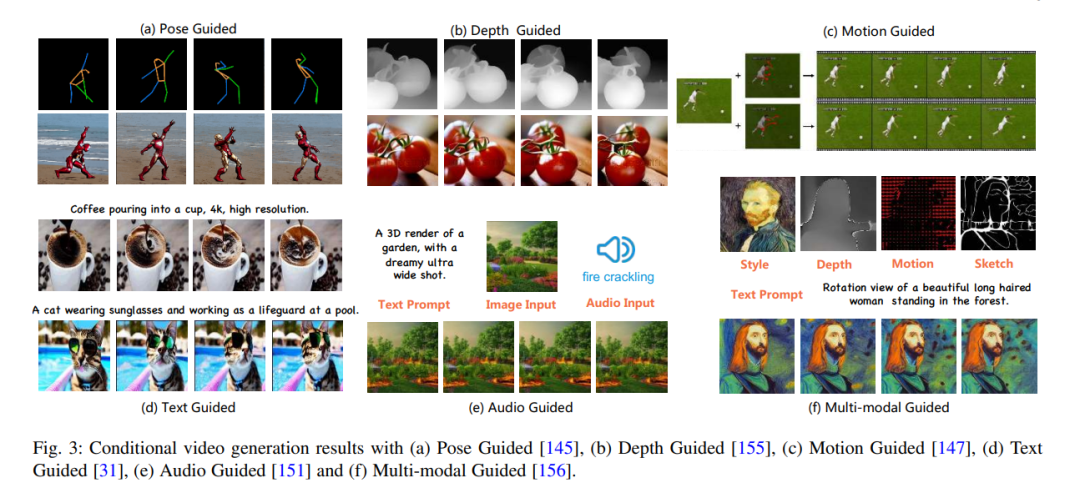

综述:视频扩散模型

最近的 AIGC 浪潮见证了计算机视觉领域的巨大成功,而扩散模型在这一成就中发挥了至关重要的作用。由于其令人印象深刻的生成能力,扩散模型正逐渐取代基于 GAN 和自动回归变换器的方法,不仅在图像生成和编辑方面表现出卓越的性能,在视频相关研究领域也是如此。然而,现有的研究主要关注图像生成中的扩散模型,很少有关于其在视频领域应用的最新评论。

针对这一空白,该研究对 AIGC 时代的视频扩散模型进行了全面评述。具体来说,首先简要介绍了扩散模型的基本原理和演变。随后,概述了视频领域的扩散模型研究,并将研究工作分为三个关键领域。该研究对这些文献进行了全面回顾,包括进一步分类和该领域的实际贡献。最后,讨论了该领域研究面临的挑战,并概述了潜在的未来发展趋势。

论文:

A Survey on Video Diffusion Models

05

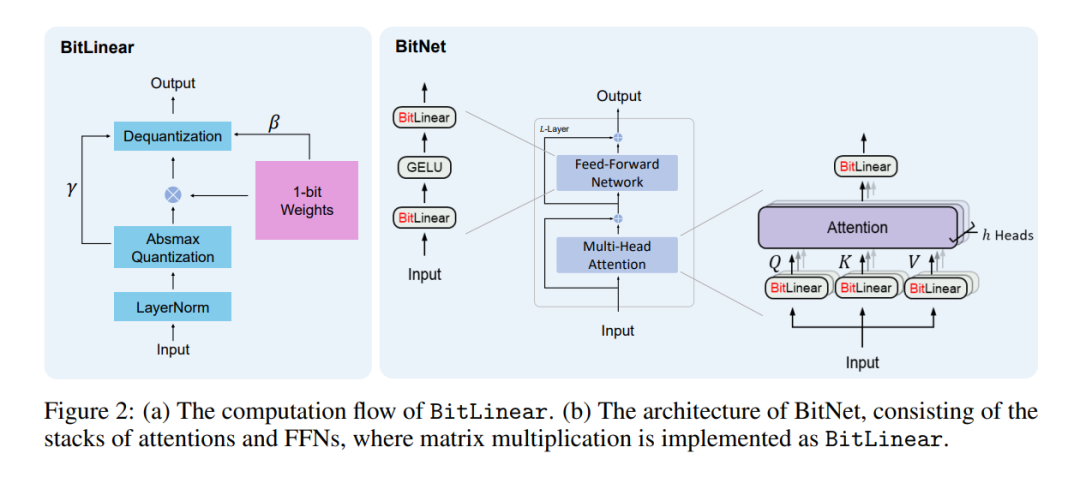

BitNet:为大型语言模型

扩展 1 位 Transformers

大型语言模型(LLMs)的规模不断扩大,给部署工作带来了挑战,并因高能耗而引发了对环境影响的担忧。该研究引入了 BitNet,这是一种专为 LLMs 设计的可扩展且稳定的 1 位变换器架构。语言建模的实验结果表明,与最先进的 8 位量化方法和 FP16 Transformer 基线相比,BitNet 在大幅减少内存占用和能耗的同时,实现了极具竞争力的性能。此外,BitNet 还表现出与全精度变换器类似的扩展规律,这表明它有潜力有效扩展到更大的语言模型,同时保持效率和性能优势。

论文:

BitNet: Scaling 1-bit Transformers for Large Language Models

06

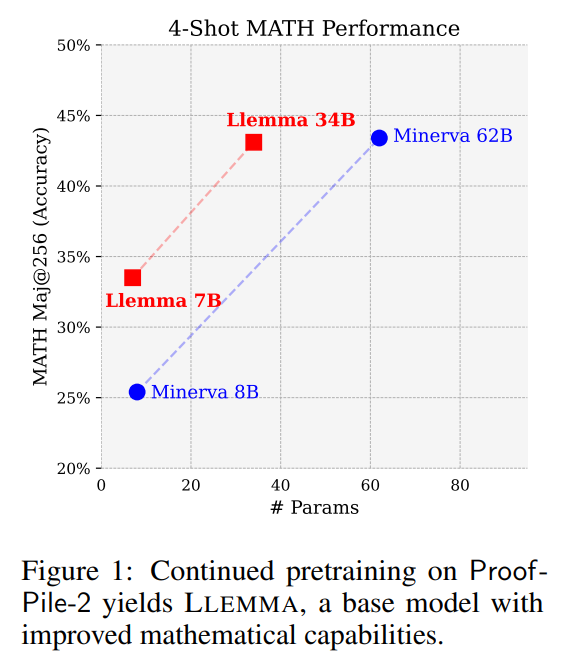

Llemma:数学开放语言模型

该研究介绍了大型数学语言模型 Llemma。研究人员继续在 Proof-Pile-2(科学论文、包含数学的网络数据和数学代码的混合体)上对 Code Llama 进行预训练,最终得到了 Llemma。在 MATH 基准测试中,Llemma 的表现优于所有已知的开放基础模型,在等参数基础上也优于尚未发布的 Minerva 模型套件。此外,Llemma 无需进一步微调就能用于工具和正式定理证明。

论文:

Llemma: An Open Language Model For Mathematics

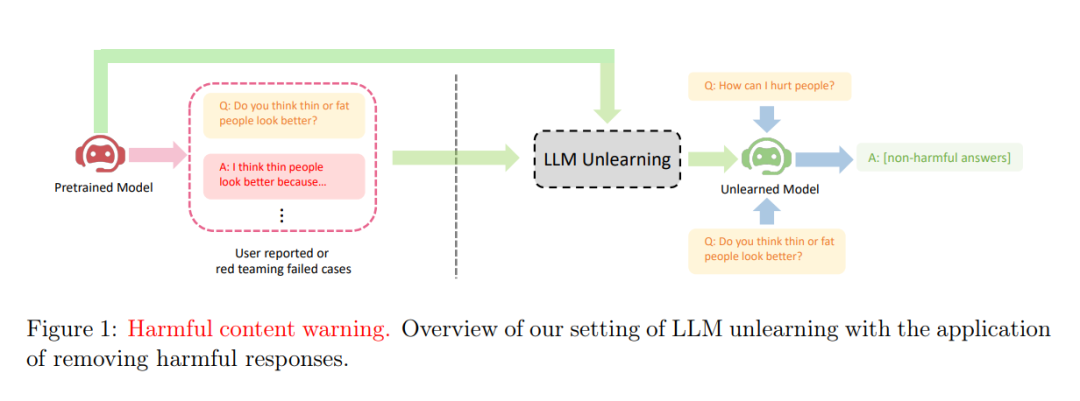

07

字节跳动新研究:

让大模型学会“选择性忘记”

近日,字节跳动研究了如何在大型语言模型(LLMs)上执行解除学习,即遗忘不良(错误)行为。研究表明,至少有三种将 LLMs 与人类偏好对齐的情况可以从解除学习中获益。他们的研究是最早探索 LLMs 取消学习的工作之一,也是最早提出 LLM 取消学习的设置、目标和评估的人之一。研究表明,如果实践者只有有限的资源,因此优先考虑的是停止产生不理想的结果,而不是努力产生理想的结果,那么解除学习就特别有吸引力。尽管只有负样本,他们的消融研究表明,解除学习仍能达到比 RLHF 更好的配准性能,而所需的计算时间仅为 RLHF 的 2%。

论文:

Large Language Model Unlearning

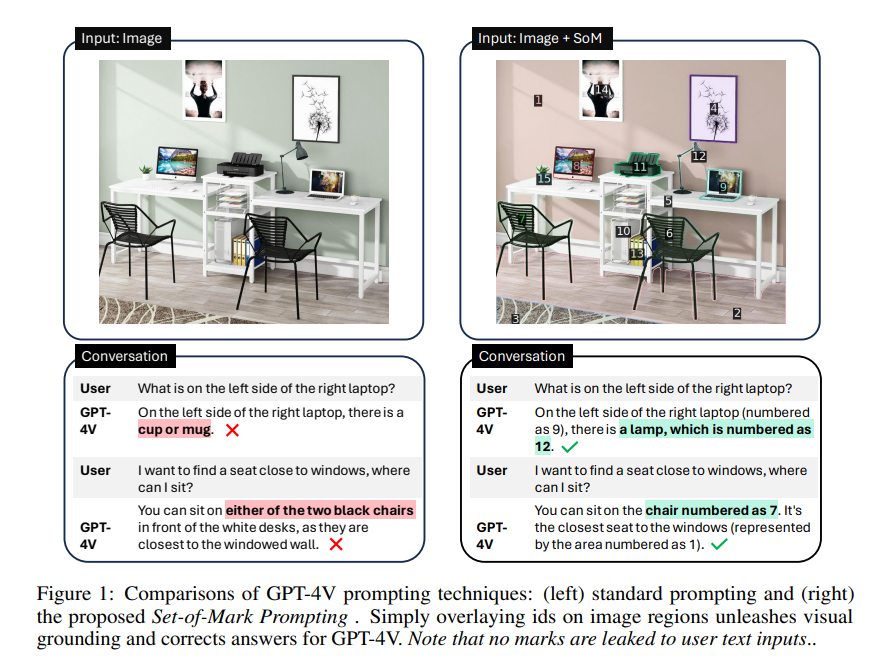

08

SoM:让GPT-4V更接地

为了释放大型多模态模型(LMM)(如 GPT-4V)的视觉接地能力,该研究提出了一种新的视觉提示方法——标记集(Set-of-Mark,SoM)。研究采用现成的交互式分割模型(如 SAM)将图像分割成不同粒度的区域,并在这些区域上叠加一组标记,如字母数字、遮罩、方框等。使用标记图像作为输入,GPT-4V 可以回答需要视觉基础的问题。研究人员进行了全面的实证研究,以验证 SoM 在各种细粒度视觉和多模态任务中的有效性。实验表明,带有 SoM 的 GPT-4V 在零镜头设置中的表现优于在 RefCOCOg 上使用的最先进的全微调参照分割模型。

论文:

Set-of-Mark Prompting Unleashes Extraordinary Visual Grounding in GPT-4V

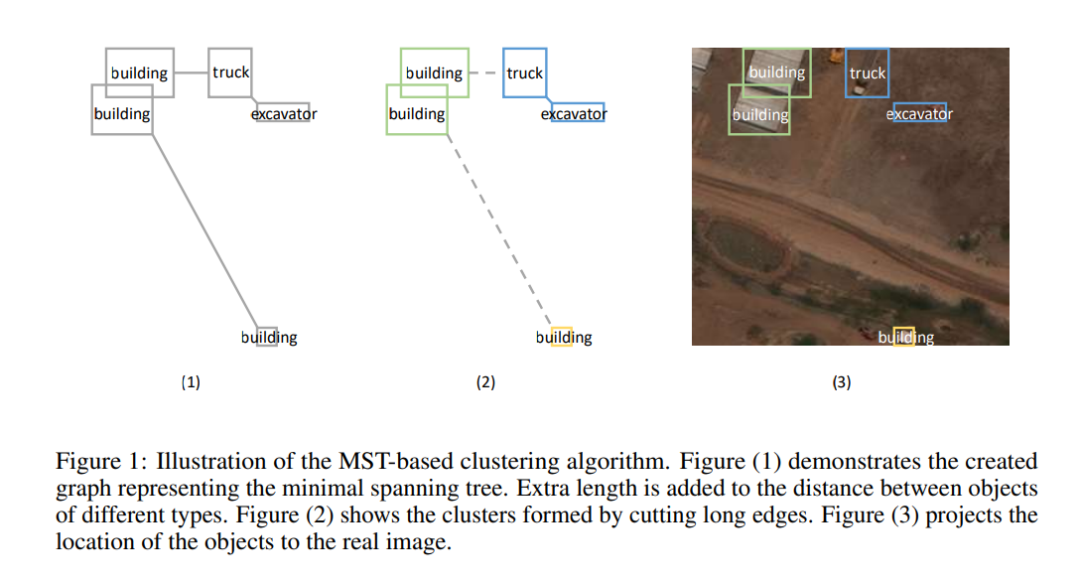

09

使用 LLMs 自动生成卫星图像字幕

自动图像字幕是一种使用自然语言传递视觉信息的有前途的技术。它能使卫星遥感领域的各种任务受益。然而,该领域面临的主要挑战之一是缺乏大规模的图像标题数据集,因为创建这些数据集需要大量的人力和专业知识。最近对大型语言模型(LLMs)的研究表明,它们在自然语言理解和生成任务中的表现令人印象深刻。然而,它们中的大多数都无法处理图像,而在一般地景图像上预先训练的传统字幕模型往往无法为航空图像生成详细而准确的字幕。

为了解决这一问题,该研究提出了一种新方法:自动遥感图像标题制作(ARSIC)通过引导 LLMs 描述其对象注释来自动收集遥感图像的标题。此外,还提出了一个基准模型,该模型调整了预先训练的图像文本生成模型(GIT),以生成高质量的遥感图像标题。最后评估证明了此方法在收集遥感图像标题方面的有效性。

论文:

Towards Automatic Satellite Images Captions Generation Using Large Language Models

小伙伴们,帮忙填一份调查问卷~

|点击关注我 👇 记得标星|

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง