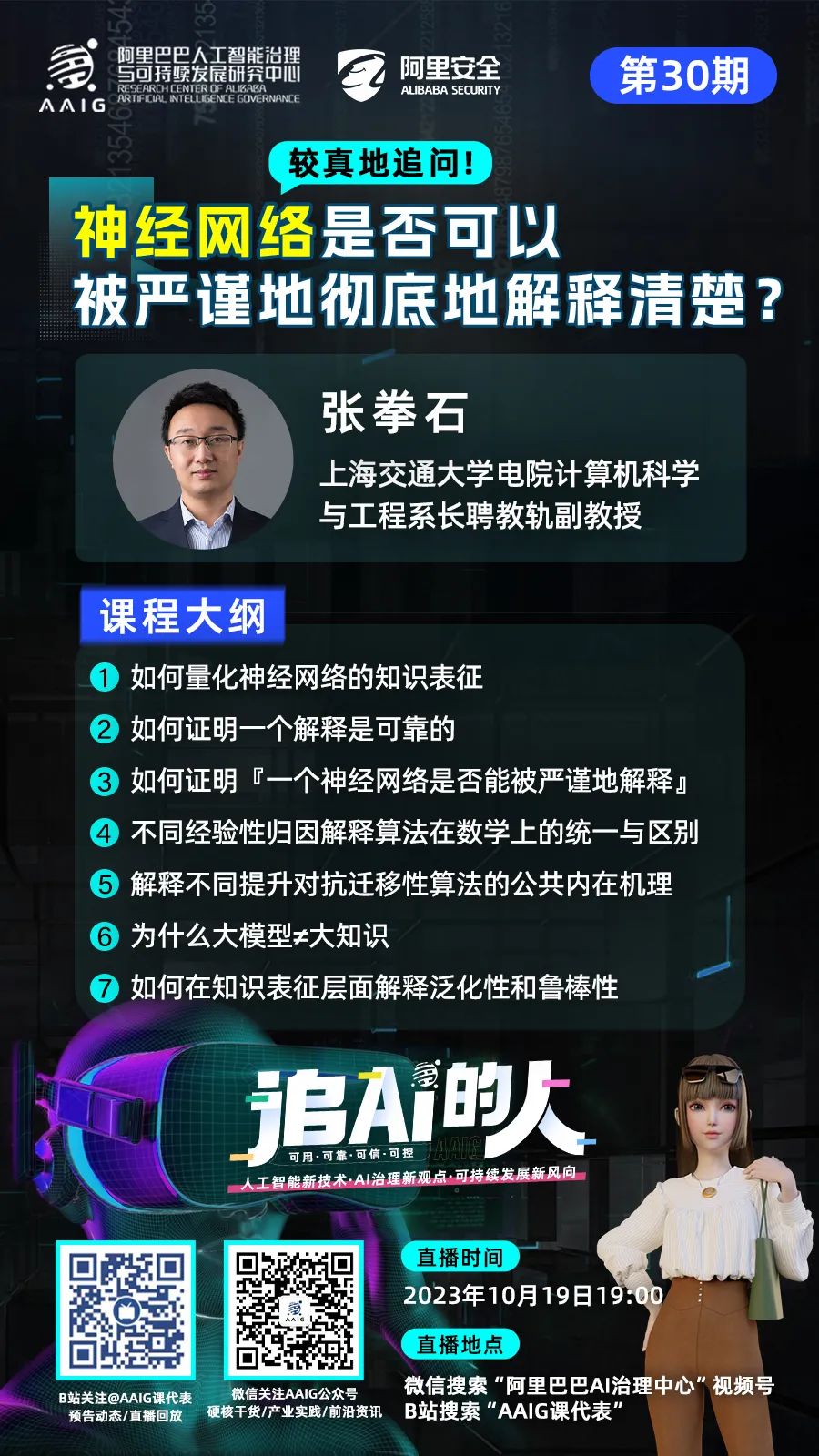

今晚(周四)19:00,《追AI的人》系列直播第30期邀请了上海交通大学张拳石教授分享《较真地追问,神经网络是否可以被严谨地彻底地解释清楚?》。

本期热点讨论

💙 如何在研发中构建具有透明度的技术体系?💙 如何将让人工智能从不可解释的黑箱变为政府信任、客户满意、用户放心的工具箱?💙 如何对推理能力进行可解释性建模?

💙 提示词工程是否有科学的方法?

02

提前预习

直播详情点击👉为什么大模型≠大知识?神经网络是否可以被严谨地彻底地解释清楚?《追AI的人》第30期来咯!

直播详情点击👉为什么大模型≠大知识?神经网络是否可以被严谨地彻底地解释清楚?《追AI的人》第30期来咯!

本期内容干货满满,为了让大家更好地吸收知识,AAIG课代表和大家课前预习,一起来阅读一下张老师的文章吧👇

【人工智能系统评测的问题】

近年来,大模型在人工智能领域取得了令人瞩目的重大发展。然而,理论学者和工程学者看待大模型时,往往有不同的角度。不同于Intelligence Technology,从Intelligence Science的角度,大模型蓬勃发展背后的一些现象反而是令人沮丧的。

随着黑盒模型的增大和复杂化,人工智能学者们往往只能以一种被动的姿态去接受神经网络各种能力的涌现,从一个观察者的角度见证神经网络性能的突破,但难以在这个过程中积极主动地进行干预。

如果我们没有办法从根本上对于大模型表征和决策逻辑进行全面的检验,那么在可以预见的未来,大模型乃至人工智能领域的发展将不得不囿于收集数据,事后观察,再收集数据,再事后观察的循环发展模式。因此我们需要站在一些新的角度,回答一些新的,去面对传统检验评测方法所忽视的问题。

如何“数出来”神经网络所建模的知识量?如何量化神经网络的表达能力?如何利用利用“形式化检验”的方式,来保证神经网络建模的知识的正确性?如何打通神经网络“知识表征”和其“性能”(泛化性、鲁棒性、安全性)的关系?人工智能领域中有太多工程化的技术,而上述问题需要严谨的系统性的理论解答和评测,这就是新一代人工智能评测需要面对的问题。

【传统基于测试样本评测的问题】

在大模型时代,面对上述问题,传统“基于测试样本”的检验评测方法往往无能为力,表现在三个方面。

第一,随着通用人工智能模型的能力范围越来越广泛,内容覆盖面有限的小的测试集无法再满足大模型评测的需求。沿着类似的思路,人们往往尝试寻找更多的测试样例,穷举各个覆盖各个领域、各个层次的问题来测试大模型的各项能力,但是人们很难穷举所有的测试样例,从而难以全面评测大模型的潜在能力。

第二,大模型的“应试教育”问题。测试样例一经发布,开发者可能会在相应数据集上刷分,这种将极大妨碍评测的公平性和可靠性。

第三,基于测试样本很难检测黑盒模型的“伪善”。文艺上的“伪善”对应在学术是指,黑盒模型是否用了人们无法接受的错误逻辑,来给出一个表面上正确合理的输出。事实上,我们大量的前期研究发现这样的问题已经广泛存在于各类黑盒模型之中。藏在大模型卓越性能背后,不可控制的、甚至有欺骗性的风险,恰恰是工业应用中真正让人忧心所在。

不久前,著名企业家埃隆·马斯克等一千多名业界、学界人士联署发表公开信,呼吁所有AI实验室立即暂停训练比GPT-4更强大的AI系统,这更加凸显了人们对于大模型的担忧。考虑到目前大模型发展的速度,与人工智能伦理问题相关的挑战必然是无法回避的。

【从符号主义角度评测的理论基础:神经符号主义——大模型=大参数+大数据,但未必是大知识】

对于上述种种问题的解答,我们都归纳到一个核心问题——我们是否可以在“符号化的认知层面”来评测黑盒模型的性能。

所谓大模型,即指具备大量参数的模型在大规模数据集上进行训练后得到的结果。但这样的大模型建模的知识是无限的吗?神经网络所建模的知识是可数、可量化的吗?在这个问题上,我们的研究结果[1,2,3]给出了明确的结论:大模型固然是大参数加上大数据,但她并非是大知识的,相反,它建模了中等规模的知识,甚至在特定条件下是小规模的知识。

“对符号化概念涌现现象的证明”指证明在哪些条件下神经网络中符号化概念的涌现会是一中“客观必然”。这里,一个符号化概念指,神经网络建模了一组输入单元之间的非线性关系,形成特定的交互,而每种交互对神经网络的输出产生一定的数值效用。这些概念的非线性关系可以表示为多个输入单元之间的“与关系”。符号化概念的涌现指,神经网络往往仅仅建模少量的交互,又称“交互概念”,而神经网络的预测输出可以精确地解构为少量交互概念的数值效用之和。

相关研究的具体介绍请见:【数学证明神经网络中符号化概念涌现的现象】

1. 证明交互概念的稀疏性。我们实验发现了[3],并在数学上证明了[1],任何模(不限于神经网络),只要在遮挡样本上可以稳定的进行分类,这个模型就往往仅仅会建模极少量的交互作用,我们称之为“交互概念”。神经网络的输出数值可以表示为这些交互概念的数值效用的和的形式,即我们可以用少量交互概念的数值效用拟合出输入样本在任意遮挡状态下神经网络的输出值——即“概念涌现”现象。

2. 发现交互概念的泛化性。我们[2]发现了在同一数据集上训练的结构不同、参数不同的神经网络往往建模了相似的一组交互概念。同一交互概念往往会出现在同一类别的不同样本上。同一交互概念的数值效用往往体现出很强的分类性。

3. 从交互概念解释性能。交互概念可以用来解释神经网络的泛化性和鲁棒性[4,5,6,7,8]。

我们发现神经网络所建模的“交互概念”并不是海量的,而是稀疏的,有迁移性的,即神经网络建模了中等规模的知识。这些概念表征是可数的,可以在人的认知层面对其进行正确性评测的。

【认知层面的评测:神经符号主义】

对于上述种种问题的解答,我们都归纳到一个核心问题——我们是否可以在“符号化的认知层面”来评测黑盒模型的性能。我们需要

1. 定义并“数出来”神经网络所建模的概念量,从而量化模型的表达能力。跳出基于测试样本端到端测试的框架,从模型表征的内在本质去描述黑盒模型的特点。

2. 基于所量化的概念量重新定义模型的泛化性和鲁棒性。一般地,可以证明复杂(高阶)的交互概念有更差的泛化性和鲁棒性。

3. 将神经网络所建模的潜在概念与人类认知的知识进行对齐。这是“交流式学习和评测”的基础。

4. 基于所量化的概念,通过类似“形式化检验”的方式,检验神经网络建模的知识的正确性和可靠性。

【总结】

大模型拥有大规模的参数,并在大规模的数据上进行训练,但其并非建模了大的知识,相反,它建模了有限的,可数的,中等或者小规模的交互概念。而且不同结构的模型往往建模了相似的交互概念,虽然神经网络的结构是五花八门的,虽然其中层特征在不同网络间也没有对应关系,但是根本上不同神经网络在交互层面的表征却是殊途同归的。从而,这允许我们站在符号化概念的角度去重新评测人工智能模型的性能,为人工智能的评测提供新的维度。 还有直播好礼!

还有直播好礼!

🧸萌萌飞猪空调被🧸☕️精致吨吨吨咖啡杯☕️

📌往期推荐

🌟《人工智能治理与可持续发展实践白皮书》 精华大图集锦版 | 如何维护电商平台信息真实和竞争公平…👉点击查收白皮书全书连载

🔥《追AI的人》系列直播教你掌握互联网的“流量密码” | 如何避免ChatGPT被滥用…👉点击查收过往29期直播的全部文字回放

🎈《算法治理制度》系列丛书内容和电商领域推荐算法的应用与治理差异|“大数据杀熟” 的背后…👉点击阅读更多算法治理干货

📚《AI治理必修》月刊为什么现在的LLM都是Decoder-only的架构? | 大脑视觉信号被Stable Diffusion复现成图像!”AI读脑术”来了…👉点击阅读往期40刊月刊全文

📺 AI治理科普短视频流量为王的时代,教你如何“破圈”创作 | 信息茧房和马太效应是什么…👉点击观看往期21期精彩视频

👇AAIG课代表,获取最新动态就找她

关注公众号发现更多干货❤️

有启发点在看喔👇

有启发点在看喔👇

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง