今日值得关注的人工智能新动态:

-

斯坦福发布基础模型透明度指数,GPT-4排名第三

-

Meta利用AI从大脑扫描中再现心理图像

-

AI生成歌词引发争议,环球音乐等公司起诉Anthropic

-

富士康与英伟达联手打造“AI工厂”

-

《黑镜》编剧:AI不可能与人类的创造力相媲美

-

Google DeepMind:生成式AI系统的社会技术安全评估

-

EvalCrafter:大型视频生成模型基准测试和评估

-

Meta新研究:基础模型的有效长语境扩展

-

群体不变性学习:更好满足人类偏好的通用方法

-

用语言模型诱发人类偏好

01

斯坦福发布基础模型透明度指数,

GPT-4排名第三

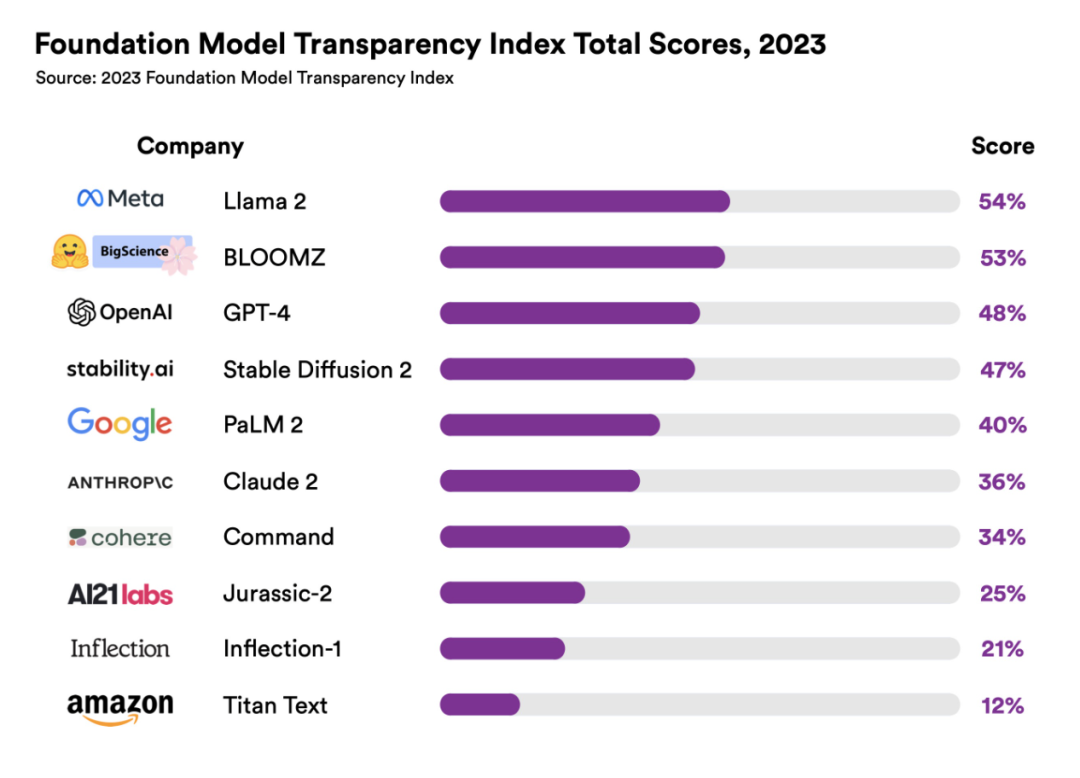

最近,斯坦福大学的研究人员公布了一套评分系统,该系统被称为 “基础模型透明度指数”(Foundation Model Transparency Index),根据 10 个大型人工智能语言模型的透明度对其进行评分。

索引中包括一些流行的模型,如 GPT-4、Google 的 PaLM 2 和 Meta 的 LLaMA 2。为了得出排名,研究人员根据 100 项标准对每个模型进行了评估,10 个模型中透明度最高的是 LLaMA 2,得分为 54%。GPT-4 的透明度得分位居第三,为 40%,与 PaLM 2 相同。

02

Google DeepMind

如何利用AI解决气候危机?

日前,DeepMind 的气候主管 Sims Witherspoon 接受了《连线》杂志的采访,讨论了人工智能(AI)帮助应对气候变化的方式以及目前遇到的障碍。

他表示,AI 可以通过更好的预测和监测模型,帮助人们了解气候变化以及所面临的与气候变化相关的问题。其中一个例子是在降水预报方面所做的工作,即提前几小时预报降雨,模型被气象局的预报员评为比其他方法更有用、更准确。但这仅仅是个开始,因为还可以建立预测更复杂现象的模型。

另外,阻碍人工智能用于应对气候变化的障碍是获取数据。无论是电力、交通还是建筑和城市,所有部门在气候关键数据方面都存在巨大差距。

03

Meta利用AI从大脑扫描中

再现心理图像

日前,Meta 公司的研究人员发布了图像解码器(Image Decoder),这是一款基于 Meta 的开源基础模型 DINOv2 的全新深度学习应用,几乎可以实时地将大脑活动转化为高精度的图像,显示被试者正在看什么或想什么。它本质上是结合了两个迄今为止完全不同的领域:机器学习和脑磁学。

Meta 团队使用了 DINOv2,这是一个自我监督学习模型,旨在训练其他模型。研究人员指示“Image Decoder”算法既要查看原始数据,又要查看人脑产生 MEG 活动时实际看到的图像。这样,通过将 MEG 数据与实际源图像进行比较,该算法学会了破译大脑中具体代表了哪些形状和颜色,以及如何进行破译。

04

AI生成歌词引发争议,

环球音乐等公司起诉Anthropic

环球音乐和其他两家音乐公司指控 Anthropic 未经许可盗用他们的歌曲,并通过与 ChatGPT 竞争的 Claude 生成“相同或几乎相同的歌词副本”。这些音乐公司说:“这些受版权保护的材料不能仅仅因为可以在互联网上找到就可以随意使用,”它们同时声称,Anthropic 公司甚至从未尝试过对它们受版权保护的作品进行授权。

目前,Anthropic 没有回应置评请求。

05

富士康与英伟达联手打造“AI工厂”

据路透社报道,富士康与英伟达日前表示,两家公司将利用英伟达的芯片和软件建立新型数据中心,用于包括自动驾驶汽车在内的一系列应用。

富士康董事长刘永好和英伟达首席执行官黄仁勋在富士康年度技术展示会上表示,两家公司将共同建设这些“人工智能(AI)工厂”。

“一种新型的制造业已经出现——智能生产。而生产智能的数据中心就是 AI 工厂。”黄仁勋说,富士康拥有在全球范围内建造这些工厂的专业知识和规模。英伟达在一份声明中表示,AI 工厂将使用其芯片和软件,包括尖端 GH200 超级芯片。

06

《黑镜》编剧:

AI不可能与人类的创造力相媲美

最近,《黑镜》编剧 Charlie Brooker 在参与 SXSW 悉尼活动时表示,当他指示 ChatGPT 为他的第四频道/Netflix 热播电视连续剧撰写一集时,他最初经历了类似恐慌和绝望的情绪波动。

Brooker 表示,人工智能(AI)将继续存在,并将成为一个非常强大的工具。他谈到 AI 聊天机器人时说:“但我不认为它能取代杂乱无章的人,也不认为它在创造富有想象力的故事情节和巧妙的情节转折方面能力有限。”

07

Google DeepMind:

生成式AI系统的社会技术安全评估

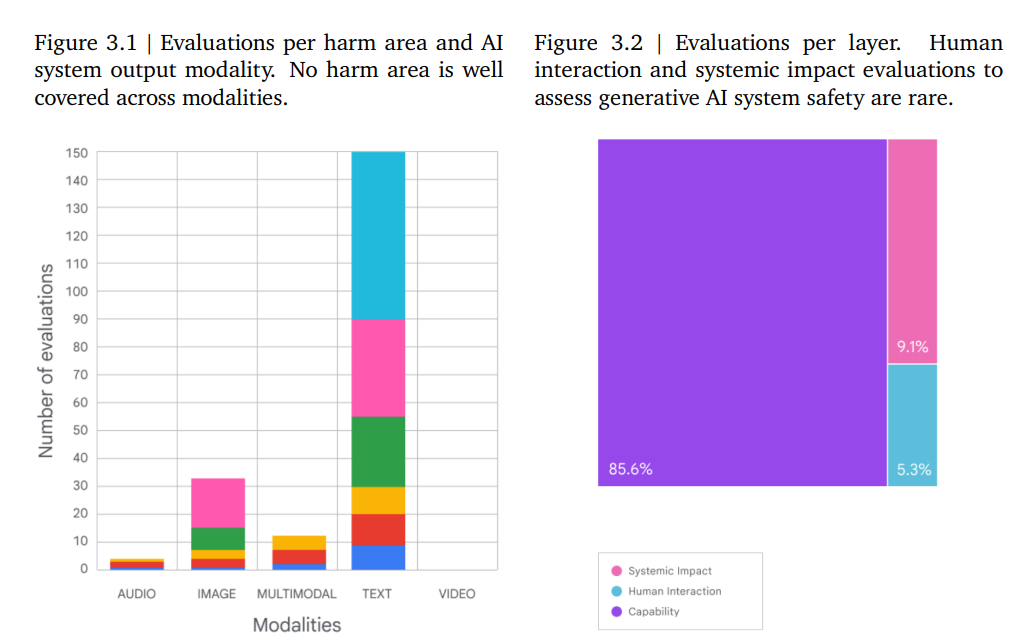

生成式人工智能(AI)系统会产生一系列风险。为了确保生成式 AI 系统的安全性,必须对这些风险进行评估。该研究将为建立此类评估做出两大贡献。首先,研究人员提出了一个三层框架,采用结构化的社会技术方法来评估这些风险。其次,调查了生成式 AI 系统安全评估的现状,并创建了一个现有评估库。通过分析,他们发现了三个突出的评估差距,并提出了缩小这些差距的方法,概述了实际步骤以及不同参与者的角色和责任。社会技术安全评估是对生成式 AI 系统进行稳健而全面的安全评估的一种可行方法。

论文:

Sociotechnical Safety Evaluation of Generative AI Systems

08

EvalCrafter:

大型视频生成模型基准测试和评估

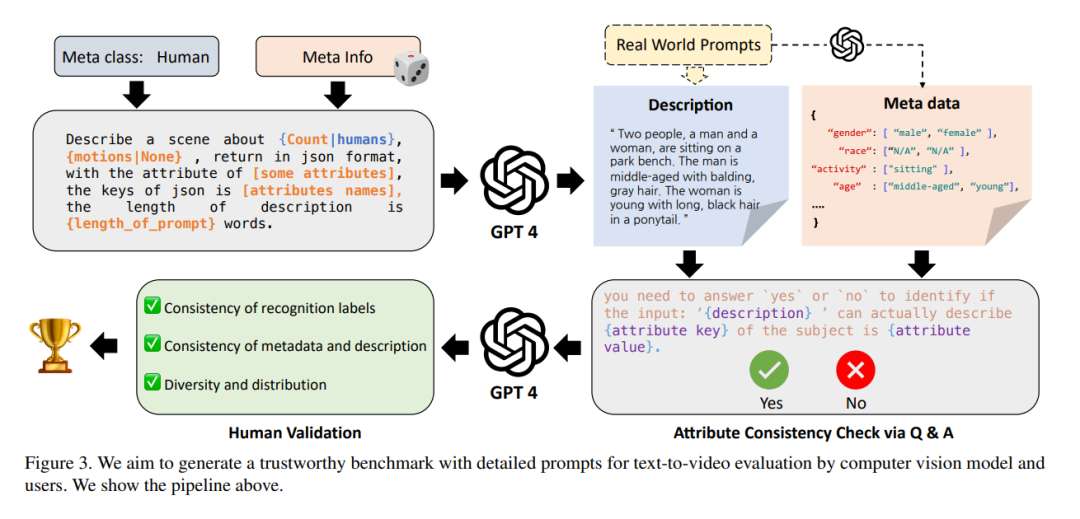

近年来,视觉和语言生成模型已经发展得非常成熟。在视频生成方面,各种开源模型和公共服务都已发布,用于生成高视觉质量的视频。然而,这些方法通常使用一些学术指标来评估性能,很难通过简单的指标来评判大型条件生成模型,因为这些模型通常是在具有多方面能力的大型数据集上训练的。

该研究提出了一种新的框架和管道,用于详尽评估生成视频的性能。研究人员首先在大型语言模型(LLMs)的帮助下,通过分析真实世界的提示列表,为文本到视频的生成创建了一个新的提示列表。然后,根据设计的基准,用大约 18 个客观指标对最先进的视频生成模型进行评估。基于建议的意见对齐方法,最终得分显示出比简单的指标平均值更高的相关性,这证明了建议的评估方法的有效性。

论文:

EvalCrafter: Benchmarking and Evaluating Large Video Generation Models

09

Meta新研究:

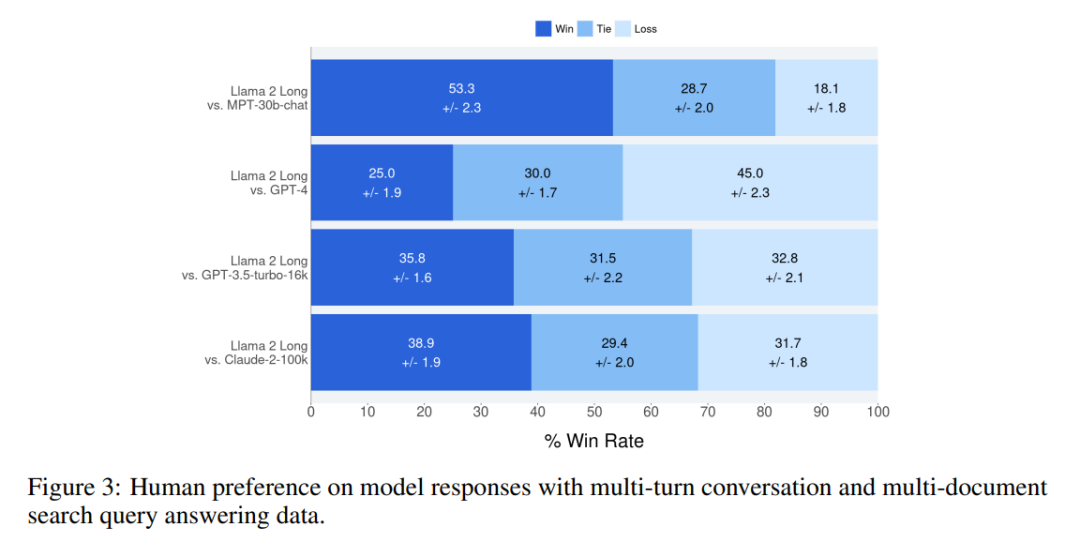

基础模型的有效长语境扩展

该研究提出了一系列长语境大型语言模型(LLMs),可支持多达 32768 个词组的有效语境窗口。此模型系列是在 Llama 2 的基础上,通过更长的训练序列和上采样长文本的数据集进行持续预训练而建立的。值得注意的是,由于采用了经济高效的指令调整程序,不需要人类标注的长指令数据,70B 变体在一系列长上下文任务中的总体性能已经超过了 gpt-3.5-turbo-16k。研究人员还深入研究了 Llama 的位置编码,并讨论了它在长依赖关系建模方面的局限性,考察了预训练过程中各种设计选择的影响。

实验表明,在预训练数据集中有大量的长文本并不是获得强大性能的关键,并且通过经验验证了长语境持续预训练比从头开始用长序列进行预训练更有效,而且效果相似。

论文:

Effective Long-Context Scaling of Foundation Models

10

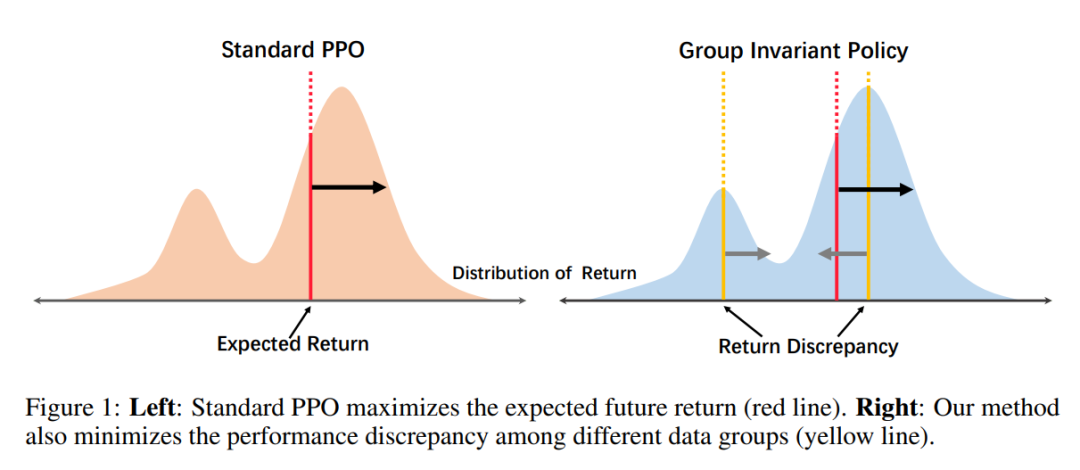

群体不变性学习:

更好满足人类偏好的通用方法

基于大型语言模型(LLMs)的人工智能(AI)助手能否取得成功,关键在于基于人类反馈的强化学习(RLHF),它能生成更符合人类偏好的反应。以往的工作表明,强化学习往往利用捷径来获得高回报,而忽略了具有挑战性的样本。这种对快速奖励收益的关注破坏了训练的稳定性和模型泛化到新的、未见过的数据的能力。

该研究提出了一种新方法,它可以通过 RL 在不同数据组或领域中学习一致的策略。考虑到获取组注释所面临的挑战,此方法会自动将数据分类到不同的组中,刻意使性能差异最大化。然后优化策略,使其在具有挑战性的组中表现良好。最后,利用已建立的组,此方法自适应地调整探索空间,将更多的学习能力分配给更具挑战性的数据,防止模型在更简单的数据上过度优化。实验结果表明,此方法大大提高了训练稳定性和模型泛化能力。

论文:

Improving Generalization of Alignment with Human Preferences through Group Invariant Learning

11

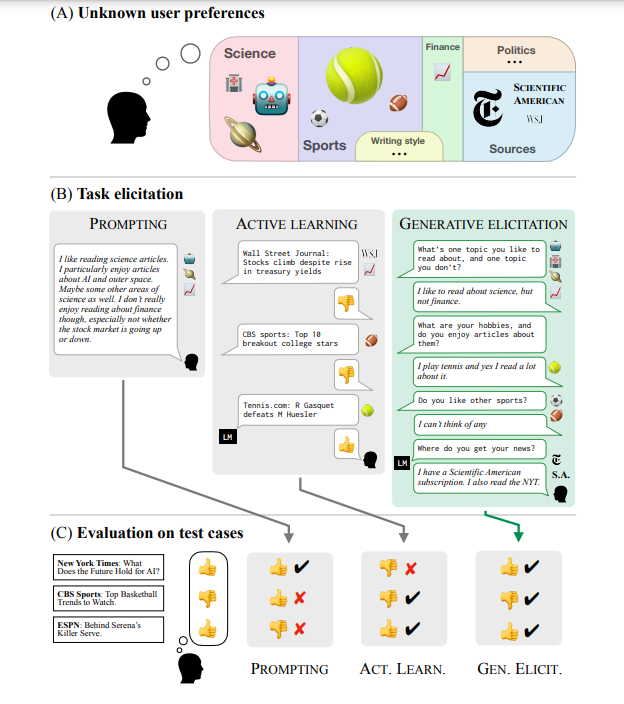

用语言模型诱发人类偏好

语言模型(LM)可以通过标注示例或自然语言提示来执行目标任务。但是,选择示例或编写提示语可能具有挑战性——尤其是在涉及不寻常的边缘情况、需要精确表达模糊偏好或需要语言模型行为的精确心智模型的任务中。

该研究介绍了生成式主动任务诱发(GATE):这是一种学习框架,其中的模型通过与用户进行自由形式的、基于语言的交互来引导和推断预期行为。研究人员在三个领域对 GATE 进行了研究,他们发现,提示进行 GATE 的 LM 所引起的反应往往比用户编写的提示或标签更有信息量。用户报告说,交互式任务诱发比提示或示例标注所需的精力更少,而且还能发现用户最初没有预料到的新问题。研究结果表明,LM 驱动的诱发可以成为使模型与复杂的人类偏好和价值观保持一致的有力工具。

论文:

Eliciting Human Preferences with Language Models

|点击关注我 👇 记得标星|

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง