AI治理必修10月(上)第40刊发布!

AAIG的专家们用多学科的专业视角,每月从全球收集和筛选关于算法治理和可持续发展的全球态势。重点关注算力时代的新技术、新风险、新实践、以及对它们新解释。

10月(上)共13篇文章2304字,分【本月洞察、行业动态、前沿技术、产业实践】四个板块展开。

点击题目即可查看全文

由科技部、教育部、工业和信息化部等十部门联合印发的《科技伦理审查办法(试行)》(以下简称《审查办法》)正式公布,意在规范科学研究、技术开发等科技活动的科技伦理审查工作,强化科技伦理风险防控,促进负责任创新。

2. 重磅!首个生成式AI安全指导性文件来了,明确31种安全风险

本文件给出了生成式人工智能服务在安全方面的基本要求,包括语料安全、模型安全、安全措施、安全评估等。

1. 试过GPT-4V后,微软写了个166页的测评报告,业内人士:高级用户必读

微软报告深入研究了GPT-4V功能,对多模态模型的应用进行了定性探讨。报告介绍了GPT-4V的任务、输入和工作模式,以及视觉参考提示的有效方法。探索发现GPT-4V在处理多模态输入方面具有前所未有的能力,并提出了基于GPT-4V的新应用场景和未来研究方向。

2. 400万token,大模型推理飙升22倍!清华校友爆火一作,GitHub狂揽1.8k星

「高效流式语言模型」(ESLM)方法解决了大语言模型上下文长度限制的问题,使得有限上下文能力的语言模型能够支持几乎无限的上下文窗口。通过保留初始token并结合滑动窗口的方法,ESLM实现了无限长度文本的处理。

3. ControlNet、「分割一切」等热门论文获奖,ICCV 2023论文奖项公布

法国巴黎举办了全球顶级计算机视觉会议ICCV。本届会议收到8068篇论文投稿,录用率为26.8%,热门主题是3D多视图和传感器。最佳论文奖分别被多伦多大学和斯坦福大学的研究者获得。Meta的SAM模型也受到了关注,并获得了最佳论文提名。

4. 7.7亿参数,超越5400亿PaLM!UW谷歌提出「分步蒸馏」,只需80%训练数据|ACL 2023

大型语言模型性能优异,但在实际部署中不实用,需要大量计算资源和内存利用效率低。华盛顿大学和谷歌提出了分步蒸馏机制,使用更小的模型和少量训练数据来实现优于大模型的性能。该机制提取预测理由作为额外的监督信息,并通过多任务问题训练小模型。

5. 弗吉尼亚理工大学 | 利用 ChatGPT 生成漏洞利用代码

该论文研究了研发人员在开发软件过程中引入的第三方组件存在的安全漏洞,并通过使用ChatGPT生成测试用例来触发这些漏洞,以帮助研发人员评估漏洞的影响并提供修复决策指标。与传统的解决方案相比,ChatGPT能够生成更多的测试用例和攻击,提高了安全性。其目的是减轻软件供应链威胁和促进漏洞修复。

6. Meta开源数字水印Stable Signature,极大增强生成式AI安全

Meta宣布开源数字水印产品Stable Signature,可防止AI生成的图片非法用途。Stable Signature不受破坏性操作影响,可追溯图片来源。该技术通过训练两个神经网络实现,具有高精准性和误报控制能力。它能够帮助识别AI图片和防止滥用。

7.碾压GPT-4,微软最强AutoGen爆火!多个智能体协作,编码速度飙升4倍,GitHub狂揽10k星

AutoGen是一个新A智能体框架,可以实现自定义对话和任务解决。它可以代替openai.Completion或openai.ChatCompletion作为增强型推理API。使用AutoGen只需几行代码即可完成复杂任务。

8. 防止刷分的大模型评测来了|复旦大学NLP实验室推出LLMEval-3,涵盖13个学科门类50余个学科20万题目!

LLMEval-3开放了,提供全面的中文生成式知识问答评测。采用题库考试模式,涵盖13个学科门类,20W道题目。评测流程防止作弊,采用相对分数和绝对分数指标。模型表现不如预期,有改进空间。使用相对分数更客观,稳定性更好。

9. GPT-4V被曝离谱bug:突然执行神秘代码,空白图片读出打折信息,网友们都看呆了

GPT-4V出现了安全问题,被注入提示词攻击,导致泄露了用户的聊天记录。这个问题暴露了大模型对于图像提示的处理能力不足的困境,目前还没有找到根本解决方法。一些人提出了双LLM模式的方案来提高安全性。

1. Fashion AI|塔玑虚拟模特演绎不重样的上班OOTD,打工人直接抄作业!

AAIG塔玑虚拟模特为大家展示上班7天的时尚穿搭,让你在通勤、会议和社交场合中展现最佳的风采。

2. 谷歌推出全球最大通用大模型之一RT-X,并开放训练数据集!

RT-X在特定任务上的工作效率是同类型机器人的3倍,并可执行未训练动作。Open X-Embodiment由全球33家学术实验室合作,整合了来自22种机器人类型的数据开发而成。这将推动机器人技术的发展。

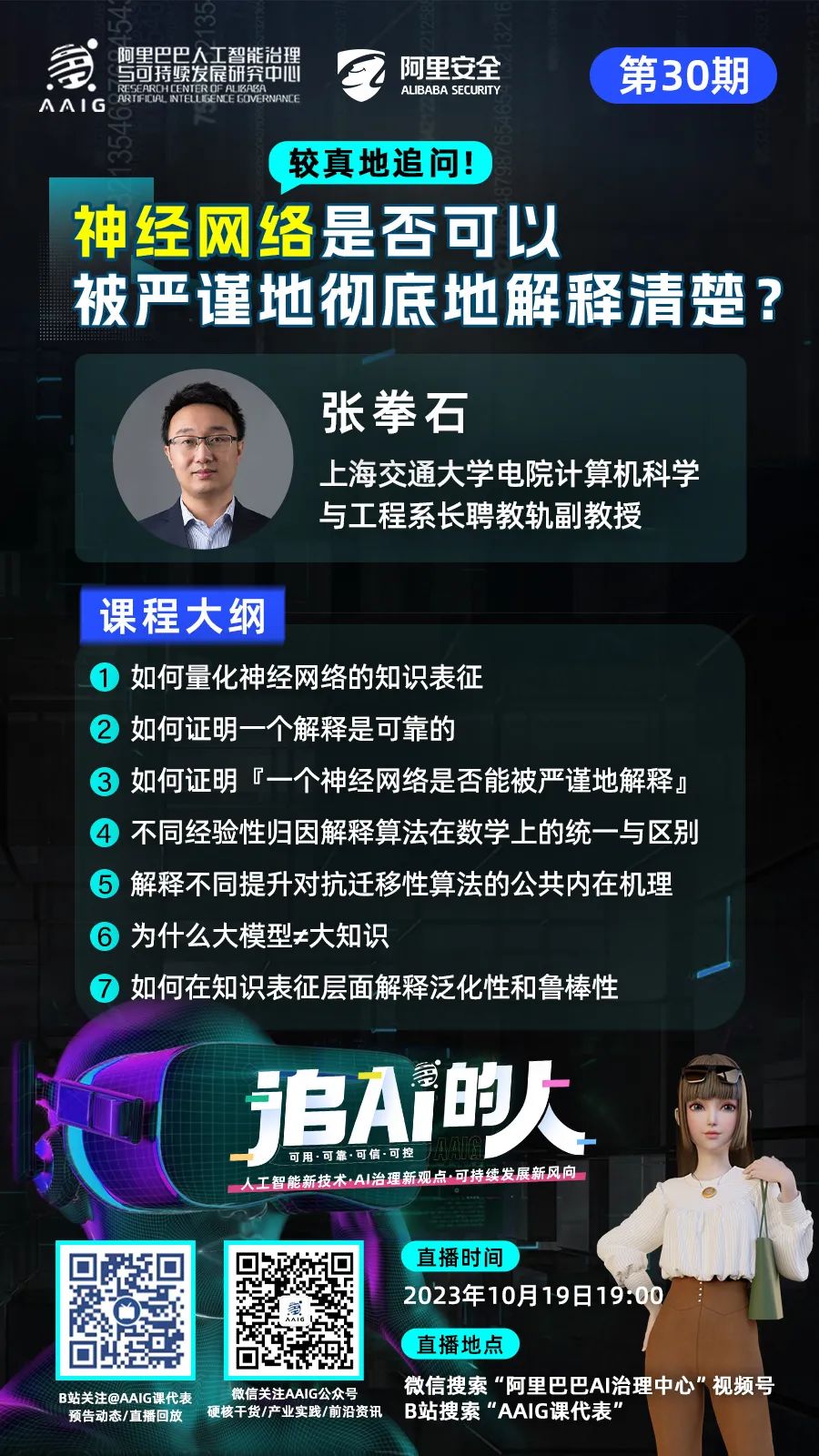

📺直播预告

📌往期推荐

🌟《人工智能治理与可持续发展实践白皮书》

精华大图集锦版 | 如何维护电商平台信息真实和竞争公平…👉点击查收白皮书全书连载

🔥《追AI的人》系列直播教你掌握互联网的“流量密码” | 如何避免ChatGPT被滥用…👉点击查收过往29期直播的全部文字回放

📚《AI治理必修》月刊为什么现在的LLM都是Decoder-only的架构? | 大脑视觉信号被Stable Diffusion复现成图像!”AI读脑术”来了…👉点击阅读往期40刊月刊全文

📺 AI治理科普短视频流量为王的时代,教你如何“破圈”创作 | 信息茧房和马太效应是什么…👉点击观看往期21期精彩视频

👇AAIG课代表,获取最新动态就找她

关注公众号发现更多干货❤️

有启发点在看喔👇

有启发点在看喔👇

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง