随着GPT4多模态/Microsoft 365 Copilot/Github Copilot X/ChatGPT插件的推出,绝大部分公司的技术产品服务,以及绝大部分人的工作都将被革新一遍。

① 类似iPhone的诞生大家面向iOS编程有了App Store。

② 现在有了ChatGPT插件/GPT应用商店,以后很多公司很多人面向GPT编程(很快技术人员分两种,一种懂GPT,一种不懂GPT)。

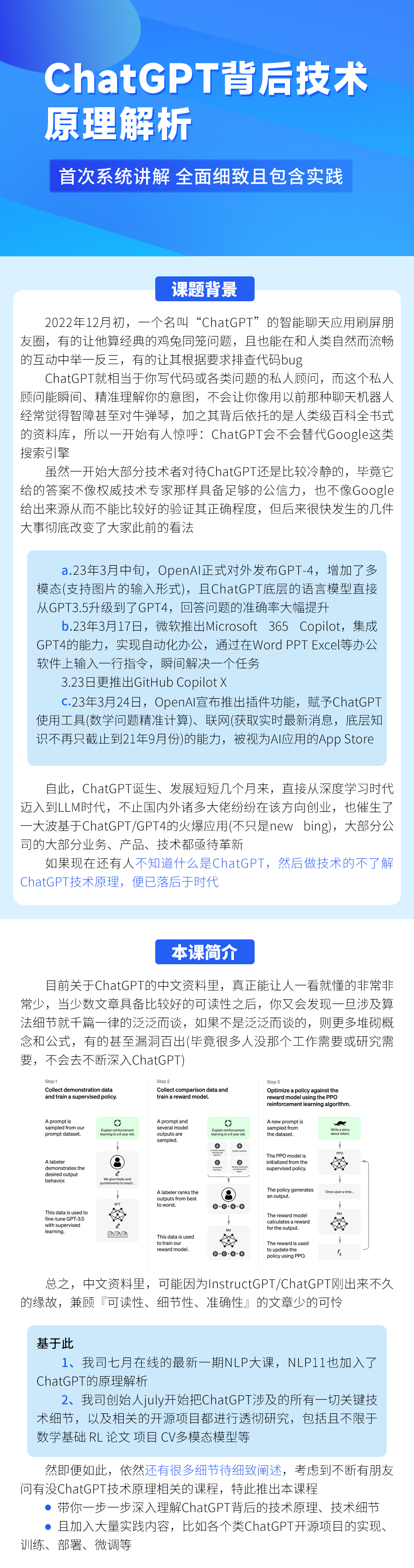

如此火的ChatGPT正在改变世界,其背后原理是什么呢(比如为何可以精准理解人类意图、为何可以做数学推理题、为何可以debug、为何长对话下如此流畅)。

通过100篇论文做支撑,本课程讲解ChatGPT技术细节最全面、细致、透彻的课程。

课程:

https://www.julyedu.com/course/getDetail/481/frP0aHm9OerHSGqLy9DuHGKK

扫描加入:

大纲

第一阶段 ChatGPT背后的数学基础:微积分/概率统计/优化

先导课 整体理解ChatGPT背后的技术原理

第一课 微积分、概率统计梳理回顾

知识点1:先讲积分:由无数个无穷小的面积组成的面积S

知识点2:什么是导数、微分

知识点3:理解牛顿–莱布尼茨公式:通过原函数反向求定积分

知识点4:偏导数

知识点5:理解期望和方差

第二课 优化方法

知识点1:理解方向导数、梯度

知识点2:从零推导梯度下降法

知识点3:梯度下降算法的具体应用

知识点4:理解随机梯度下降(SGD)

第二阶段 强化学习极简入门

第三课 RL极简入门(上):RL基本概念与三大表格求解法

知识点1:RL基础:什么是RL与MRP、MDP

知识点2:RL进阶之三大表格求解法:DP、MC、TD

知识点3:价值学习:从n步Sarsa算法到Q-learning、DQN

第四课 RL极简入门(下):从策略梯度、Actor-Criti到TRPO、PPO算法

知识点1:策略梯度与其突出问题:采样效率低下

知识点2:优势演员–评论家算法(Advantage Actor-Criti):为避免奖励总为正增加基线

知识点3:基于信任区域的TRPO:加进KL散度解决两个分布相差大或步长难以确定的问题

知识点4:近端策略优化PPO:解决TRPO的计算量大的问题

第三阶段 ChatGPT底层强大的语言模型:GPT系列

第五课 理解Transformer:从Word2Vec、Seq2Seq逐步理解到GPT、BERT

知识点1:理解基本概念:从NNLM到Word2Vec

知识点2:从Seq2Seq到Seq2Seq with Attention

知识点3:理解Transformer:通过自注意力机制开启大规模预训练时代

知识点4:一步一步的理解自注意力机制

知识点5:理解BERT:从Elmo/GPT到集大成者BERT

第六课 从GPT/GPT2/GPT3:微调到prompt学习的过渡

知识点1:GPT:基于Transformer Decoder预训练 + 微调/Finetune

知识点2:GPT2承1启3:基于prompt尝试舍弃微调 直接Zero-shot Learning

知识点3:GPT3:In-context learning正式开启prompt新范式(小样本学习)

第七课 GPT3到GPT3.5:指令微调、思维链、代码训练

知识点1:Prompt技术的升级与创新:指令微调技术(IFT)与思维链技术(CoT)

知识点2:GPT3到GPT3.5:从InstructGPT到ChatGPT初版的迭代过程

知识点3:ChatGPT初版与InstructGPT的差别:基于GPT3还是GPT3.5微调

知识点4:ChatGPT改进版:底层语言模型从GPT3.5升级到GPT4

第四阶段 ChatGPT背后的训练方式与GPT4的多模态技术解密

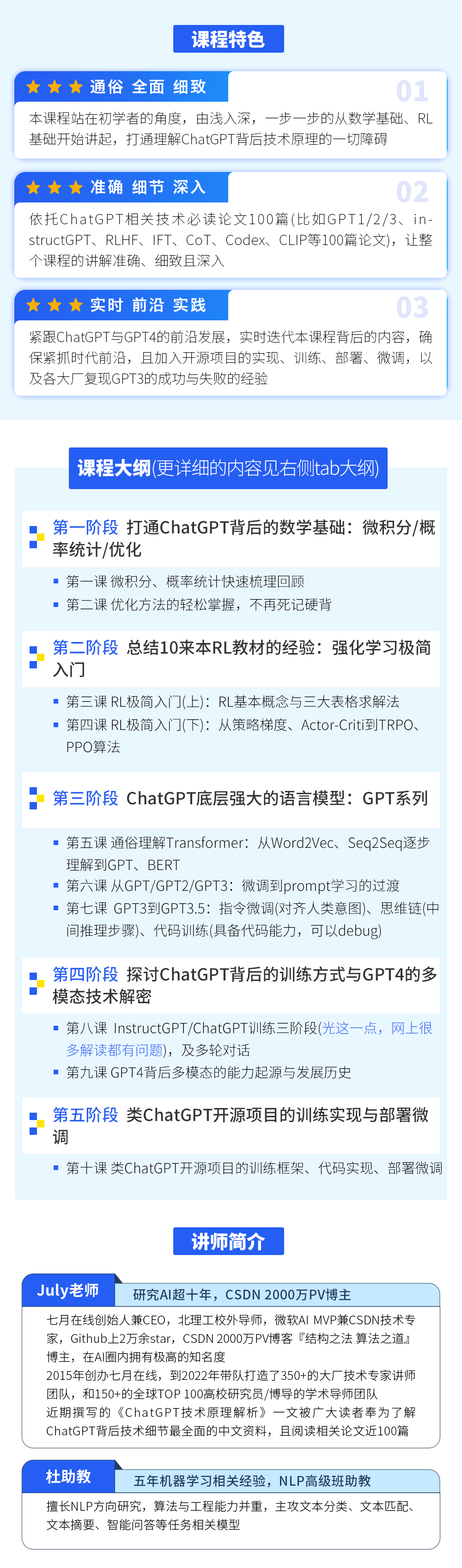

第八课 InstructGPT/ChatGPT训练三阶段及多轮对话能力

知识点1:基于GPT3的InstructGPT训练三阶段,以及为何大部分解读漏洞百出

知识点2:InstructGPT训练阶段2:如何对多个输出排序及如何训练RM模型

知识点3:InstructGPT训练阶段3:如何通过PPO算法进一步优化模型的策略

知识点4:InstructGPT论文中的目标函数是如何与PPO表达式的各项表示一一对应的

知识点5:InstructGPT如何更好的构建多轮对话能力

第九课 GPT4背后多模态的能力起源与发展历史(上)

知识点1:如何更好的理解DTER、DDPM、Vision Transformer

第十课 GPT4背后多模态的能力起源与发展历史(下)

知识点1:如何快速理解CLIP、Swin Transformer、DALL·E 2、Stable Diffusion

第五阶段 类ChatGPT开源项目的训练实现与部署微调

第十一课 LLaMA的解读与其微调:Alpaca-LoRA/Vicuna/BELLE/中文LLaMA/姜子牙/LLaMA 2

知识点1:LLaMA的代码级解读:RMSNorm/SwiGLU/RoPE/Transformer

知识点2:各种微调LLaMA:Alpaca(self-instruct)、Vicuna(shareGPT)、BELLE(self-instruct)

知识点3:更强的LLaMA 2开源,可直接商用

第十二课 ChatGLM-6B的基座/部署/微调/实现:从GLM到6B的LoRA/P-Tuning微调、及6B源码解读

微信群 公众号

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง