01

研究动机

自然语言理解(Natural Language Understanding,NLU)模型在许多下游任务上取得了显著的进展,但也被发现存在着各种各样的数据集偏差,导致模型在面对与训练数据分布不同的数据时表现不佳。数据集偏差是指非因果性的统计关联,即某些特征可能和标签之间存在一定的相关性,但是和标签之间并不具有明确的因果关联。例如,人们可能习惯于在商品的评论中通过否定词(比如no、not、never等)来表达不满,但是使用否定词却并不一定意味着该评论是负面的。然而,模型却有可能会学习到这样的偏差进行预测。例如,在情感分类任务中,如果训练数据集中否定词总是和负面情感类别相关联,模型就有可能学习到否定词和负面情感类别之间的关联性,并将包含否定词的样本一律预测为负类。利用偏差特征进行预测或许能够在训练数据分布中表现出优异的性能,却无法泛化到更加复杂的分布中。

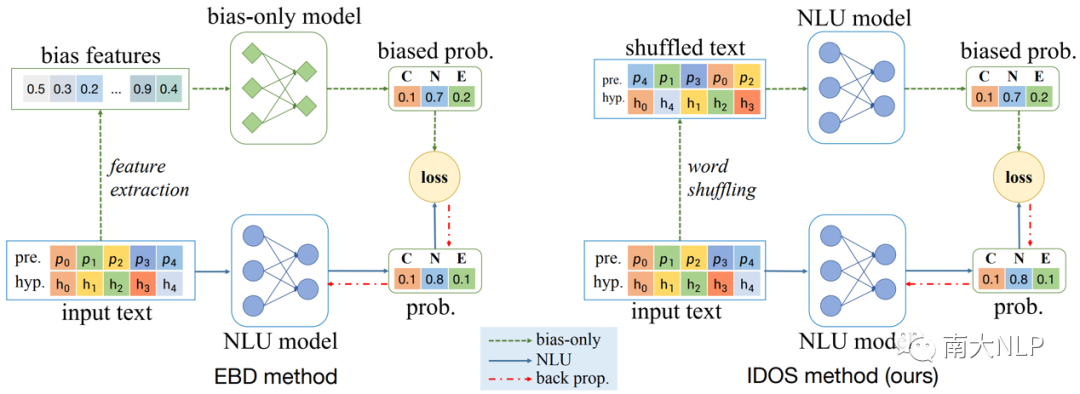

为了提高NLU模型的泛化能力,许多去偏差方法被提出。其中,基于集成的去偏差(Ensemble Based Debiasing, EBD)方法是一种有效的方法(如图1 左侧所示)。EBD方法通过引入一个额外的偏差模型来估计训练样本的偏差,并设计去偏差损失函数来降低偏差样本在NLU模型训练中的权重,从而缓解数据集偏差对模型的影响。然而,EBD方法也存在一些局限性。首先,为了获得一个偏差模型,使用者需要具备先验偏差知识或者采用繁琐的模型调优技巧来训练偏差模型。其次,这些方法采用两阶段训练过程,先训练一个偏差模型,再使用这个偏差模型来指导NLU模型的训练,这带来了额外的模型参数和人力成本。

为了解决这些局限性,我们提出了一种基于词乱序的模型去偏差方法,即IDOS(a unIfied Debiasing method via wOrd Shuffling)。我们的方法不需要引入额外的偏差模型,而是通过打乱输入文本中的词序来模拟偏差特征。借助于词乱序,我们将偏差模型和NLU模型统一为一个单一的模型,并只需进行一次训练就能达到去偏差的目标。

02

贡献

-

提出了一种通过打乱输入文本中的词序来模拟偏差特征的方法,这种方法不需要引入额外的偏差模型,而是利用NLU模型自身来估计样本的偏差程度。

-

提出了IDOS一种基于词乱序的模型去偏差方法。这种方法是端到端的,不需要额外的参数,只需要比基线模型稍微多一点的训练计算量。

-

在三个不同的NLU任务上进行了实验,结果表明IDOS可以有效地减少数据集偏差,并与现有的去偏差方法达到了可比甚至更好的性能。

03

解决方案

下图展示了IDOS和已有工作的对比。

图1:EBD(左侧)和IDOS(右侧)对比

3.1 词乱序

我们将“词乱序”定义为将输入文本中每个单词随机打乱顺序后重新组合成新文本的过程。例如,“A dog chased a cat”可以被打乱为“cat a dog chased a”或“chased a cat a dog”等。我们认为词乱序可以有效地消除语义特征,因为语义特征通常依赖于正确的语法结构和语义关系,而这些都需要正确的词序来体现。另一方面,词乱序可以保留偏差特征,因为偏差特征通常是一些低层次的表面特征,例如词重叠、否定词出现、词频等,这些特征不受词序的影响。因此,当NLU模型面对打乱后的文本时,它只能依赖于偏差特征来进行预测,因此输出的置信度分数就反映了输入样本的偏差程度。 我们认为,置信度分数越高,模型越能够依赖文本中的偏差特征进行预测,输入样本中包含的偏差特征的程度越高。

3.2 模型

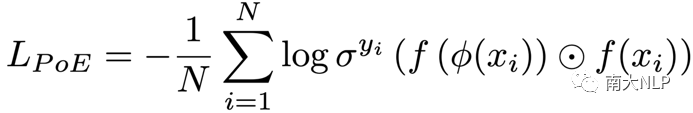

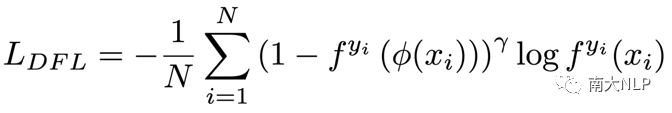

我们的模型基于预训练的NLU模型,例如BERT或RoBERTa等。我们将输入文本和打乱后的文本都输入到模型中,并将输出的两个概率分布结合起来计算去偏差损失。基于词乱序,我们修改Product of Expert(PoE)损失和Debiased Focal Loss(DFL)损失。PoE 和 DFL损失通过调整偏差样本的权重来缓解偏差特征对模型的影响。具体的,我们用 x 表示输入文本,用 phi表示词乱序操作,用 f 表示 NLU 模型(BERT等预训练模型)。则修改后的 PoE 损失为:

修改后的DFL 损失为:

直观上,两种损失函数都是让偏差样本有较小的权重,减小偏差样本在反向传播时贡献的梯度大小,从而使得模型能够更多地关注偏差较小的样本,学习语义特征。

和已有的EBD模型相比,IDOS只需使用一个 NLU 模型且只进行一次训练,更加简单高效。

04

实验

4.1 主实验

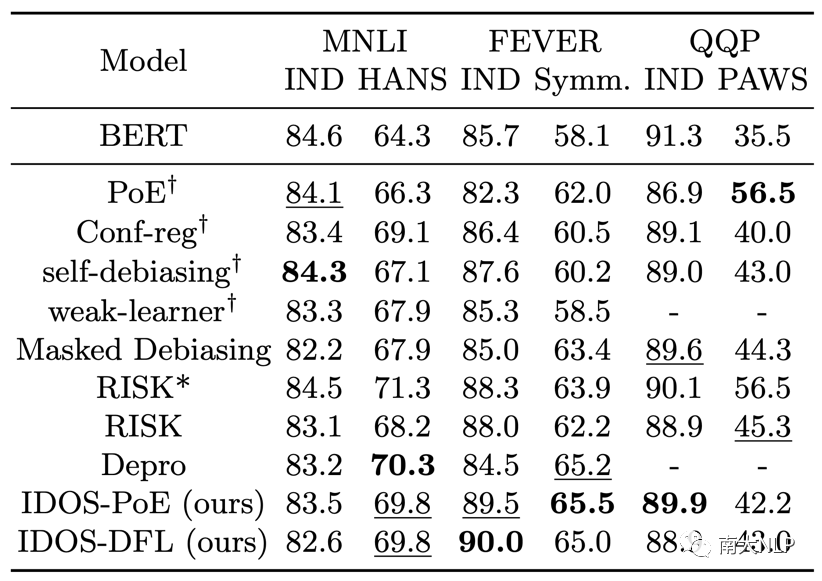

我们在三个不同的NLU任务上进行了实验,分别是自然语言推理(NLI)、事实验证(FEVER)和释义识别(QQP)。我们使用MNLI、FEVER和QQP数据集作为训练集,并使用HANS、FEVER对称集和PAWS数据集作为测试集。实验结果如表1 所示。实验结果显示,总体而言 IDOS 的性能和主流去偏差模型相当,并且在事实核查任务中达到了 SOTA 性能。

表1:主试验结果(准确率)

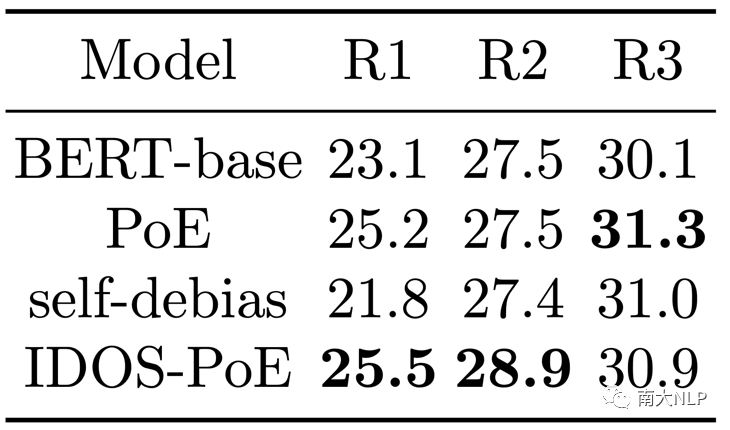

4.2对抗鲁棒性实验

偏差可能被用于对抗攻击以误导NLU模型,因此去偏差方法有望提高对抗鲁棒性。为验证IDOS 能否提高NLU模型抵抗对抗攻击的能力,我们在 ANLI 数据集上进行了实验。ANLI 数据集包含人工制作的对抗样本,可以成功地欺骗大型预训练模型。实验结果表明,IDOS方法在所有三个子集上都超过了BERT-base,分别提高了2.4%,1.4%和0.8%,显示出更强的抵抗对抗攻击的能力。

表2:模型在 ANLI 数据集上的性能(准确率)

4.3偏差率的敏感性

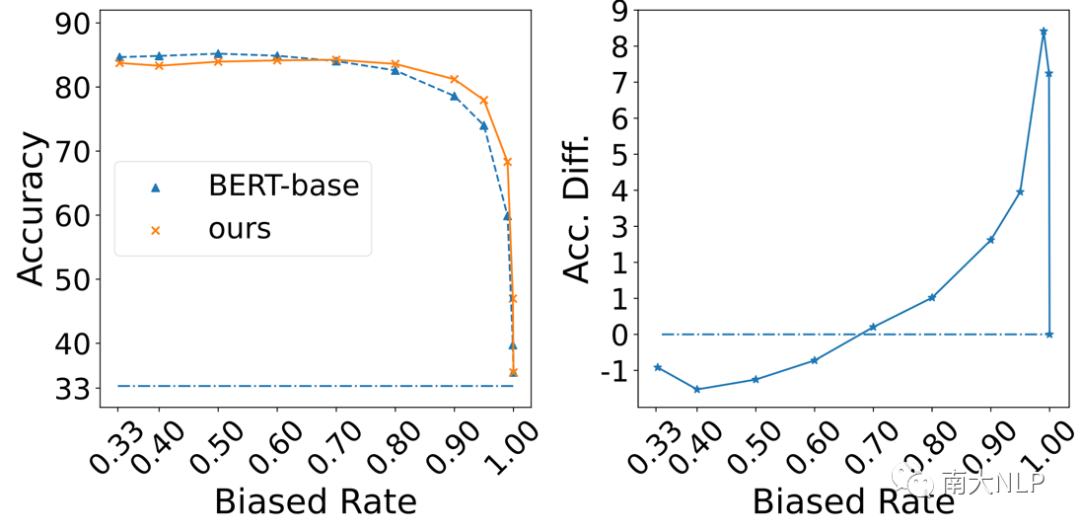

为测试IDOS方法对不同偏差率的敏感性,我们在合成数据集上测试了IDOS 模型的性能。偏差率是指与某个偏差特征和类别相关联的样本的百分比。我们通过向MNLI数据集注入合成偏差来创建合成数据集,通过控制和合成偏差特征关联的样本的类别比例来控制偏差率。实验结果如图 2 所示。随着偏差率的增加,两个模型都面临着性能下降,直到达到与随机猜测相同的水平。然而,IDOS-PoE的性能下降得更慢,并且超过 BERT-base 最多达 9%。这表明 IDOS方法可以有效地减少NLU模型对不同偏差率的敏感性,并提高模型在高偏差数据集上的泛化能力。

此外,可以观察到,当数据集即将达到完全偏差时,即合成偏差特征和和Entailment类别的相关性达到1 时,IDOS 的性能也接近随机猜测的水平。这种变化揭示了IDOS方法的一个局限性。也就是说,当可用的无偏差样本数量非常少时,仅仅通过增加这些样本的权重是不足以平衡偏差和无偏差信息的。我们将这个问题的解决留作未来的工作。

图2:模型在不同偏差率下的性能表现

图2:模型在不同偏差率下的性能表现

05

总结

我们提出了一种通过打乱输入文本中的词序来模拟偏差特征的方法,这种方法不需要引入额外的偏差模型,而是利用NLU模型自身来估计样本的偏差程度。基于词乱序,我们进一步提出了一种统一的模型去偏差方法,即IDOS,这种方法是端到端的,不需要额外的参数,只需要比基线模型稍微多一点的训练计算量。实验结果表明,IDOS可以有效地减少数据集偏差,并与现有的去偏差方法达到了可比甚至更好的性能。

06

参考文献

[1] Karimi Mahabadi, R., Belinkov, Y., Henderson, J.: End-to-end bias mitigation by modelling biases in corpora. In: Proc. of ACL (2020)

[2] Utama, P.A., Moosavi, N.S., Gurevych, I.: Mind the trade-off: Debiasing nlu models without degrading the in-distribution performance. In: Proc. of ACL (2020)

[3] Utama, P.A., Moosavi, N.S., Gurevych, I.: Towards debiasing nlu models from unknown biases. In: Proc. of EMNLP (2020)

[4] Lin, T.Y., Goyal, P., Girshick, R., He, K., Dollar, P.: Focal loss for dense object detection. In: Proc. of ICCV (2017)

[5] Hinton, G.E.: Training products of experts by minimizing contrastive divergence. Neural Computation (2002)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง