每一周,我们的同事都会向社区的成员们发布一些关于 Hugging Face 相关的更新,包括我们的产品和平台更新、社区活动、学习资源和内容更新、开源库和模型更新等,我们将其称之为「Hugging News」。快来看看有哪些近期更新吧!🎉

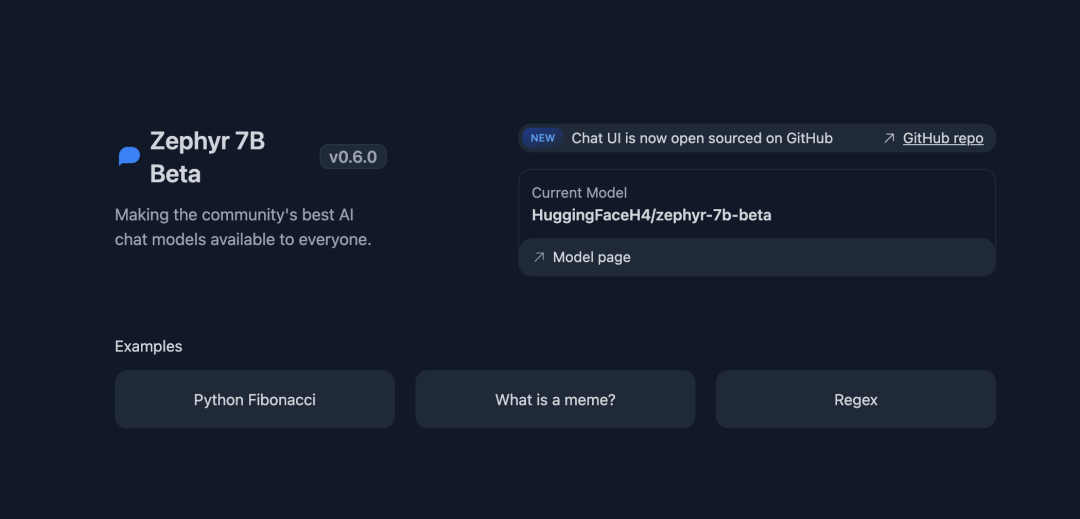

新的训练方法 Zephyr-7B 模型超越 70B Llama2

跟大家介绍一个比较简单的方法训练出的一个 7B 的模型,它在 MT Bench 测试中的表现甚至超过了 Llama2 70B 模型。

马上就试试看?https://huggingfaceh4-zephyr-chat.hf.space/

=== 方法揭秘 🤓 ===

首先,使用 UltraChat 数据集对 SFT Mistral 7B 模型进行训练。然后,使用”直接偏好优化” (DPO) 方法,将 SFT 模型调整到 UltraFeedback 数据集上。

=== 细节揭秘 🤓 ===

对于 SFT 训练,我们使用了 UltraChat 数据集,它包含了约 1.6M个 由 GPT3.5 生成的对话。我们最初是在所有数据上进行训练的,但后来发现训练出来的模型性格有点让人讨厌😅。因此,我们筛选出了大约 200K 个更注重有益帮助的例子进行训练:https://hf.co.co/datasets/stingning/ultrachat

接下来,我们使用了来自 Stanford 研究者们的超棒 DPO 算法进行了另一轮微调。我们发现, DPO 比 PPO 稳定得多——强烈推荐去看他们的论文,了解更多信息!https://hf.co/papers/2305.18290

在使用 DPO 的过程中,我们选用了 UltraFeedback 数据集,它包含了 64K 个提示和完整的回答,涵盖了各种开放和封闭访问模型的范围。每个回答都由 GPT-4 根据有益性等标准进行了评分,以此来推导 AI 的偏好:https://hf.co/datasets/openbmb/UltraFeedback

在训练方面,我们在所有实验中都使用了 🤗 TRL 和 DeepSpeed ZeRO-3:

- SFTTrainerhttps://hf.co/docs/trl/sft_trainer

- DPOTrainer:https://hf.co/docs/trl/dpo_trainer

总计算成本:$500 或在16 x A100 上运行 8 小时

为了评估,我们使用了 LMSYS 提供的优秀工具 MT Bench。这个多轮的基准测试可以评估聊天机器人在创意写作、编码和数学等各个领域的能力。相比其他排行榜,它能提供更准确的关于聊天机器人性能的信息:https://hf.co/spaces/lmsys/mt-bench

这个教程其实是我们在 Hugging Face 工作的一部分,是 “Alignment Handbook” 手册的预告,我们在这本手册中分享了关于 SFT、DPO、PPO 等多种训练方法的稳健训练方法。我们计划不久后发布初版,你可以在这里跟踪项目的进度👇:https://github.com/huggingface/alignment-handbook

Hugging Face Hub 0.18.0 现已发布

0.17.0 发布的内容已经很多了,现在,0.18.0 也发布啦!0.18.0 加入了对网站上 Collection 的 API 支持,文档也有了社区支持的韩语和德语的翻译。更多详细内容,请查看此次 release notehttps://github.com/huggingface/huggingface_hub/releases/tag/v0.18.0

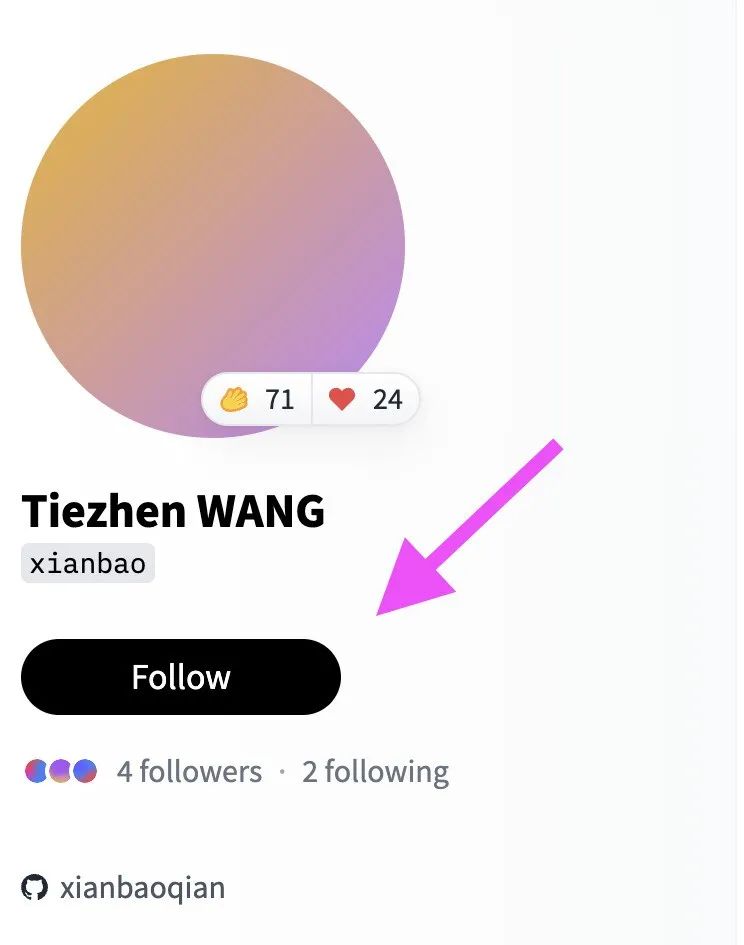

Hugging Face Hub|Follow 功能上线 🤗

Hub 刚刚更新了 Follow – 互相关注功能,可以随时关注你喜欢的 / 仰慕的 / 想一起合作的 / 社群小伙伴啦 ❤️(社群小伙伴 = 业界大牛👀)

来试试 👋 然后告诉我们你的使用感受和建议吧 ✨

以上就是本周的 Hugging News,周末愉快!

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง