Meta-OCL:脱离上下文学习

标题:Meta-(out-of-context) learning in neural networks

链接:https://arxiv.org/abs/2310.15047

作者:Dmitrii Krasheninnikov, Egor Krasheninnikov, Bruno Mlodozeniec, David Krueger

单位:剑桥大学

摘要:

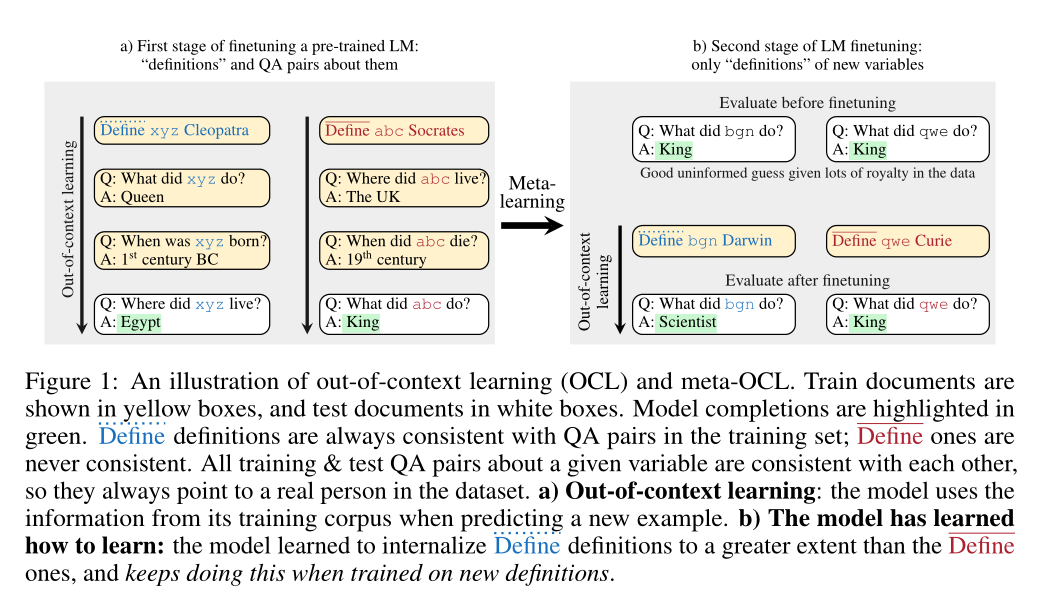

大语言模型(LLM)中的上下文学习(in-context learning)现象被广泛研究。本文证实了一种称为「元脱离上下文学习」(meta-OCL)现象的存在。

结果表明,meta-OCL 使 LLM 更容易「内化」广泛有用的/看似广泛有用的文本的语义内容(例如真实陈述或来自权威来源的文本),并在适当的情况下使用它。

研究者还在合成计算机视觉环境中证明了 meta-OCL,并针对 meta-OCL 的出现提出了两种假设:(1)依赖于模型在参数中存储知识的方式,(2)基于梯度下降的优化器的隐式梯度对齐偏差。

代码可见:https://github.com/krasheninnikov/internalization

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง