Large Language Models as Generalizable Policies for Embodied Tasks

A Szot, M Schwarzer, H Agrawal, B Mazoure, W Talbott, K Metcalf, N Mackraz, D Hjelm, A Toshev

[Apple]

大型语言模型作为具身任务的通用策略

要点:

-

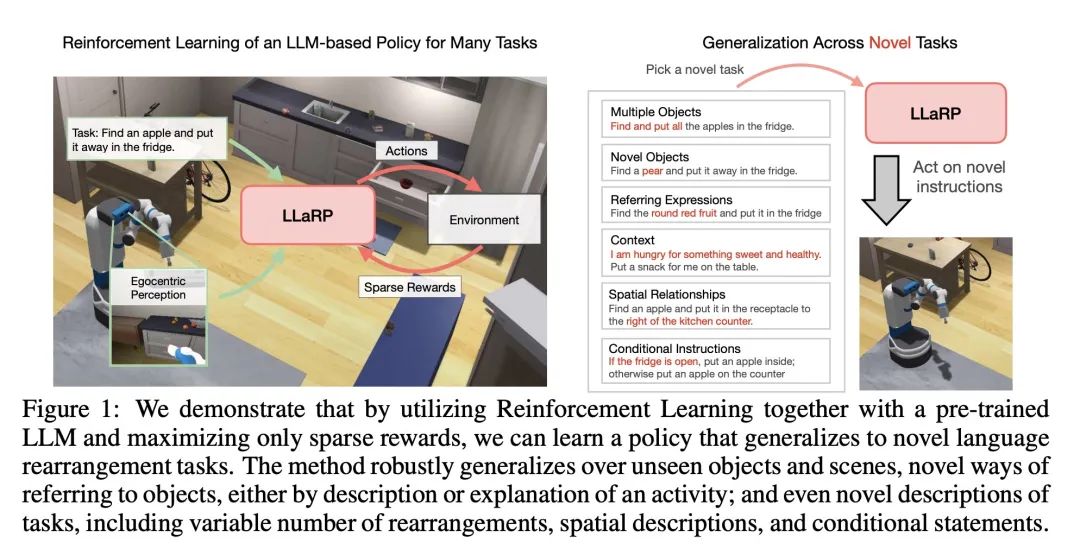

本文介绍了LLaRP,一种通过强化学习将大型语言模型(LLM)适配为具身AI任务策略的方法。

-

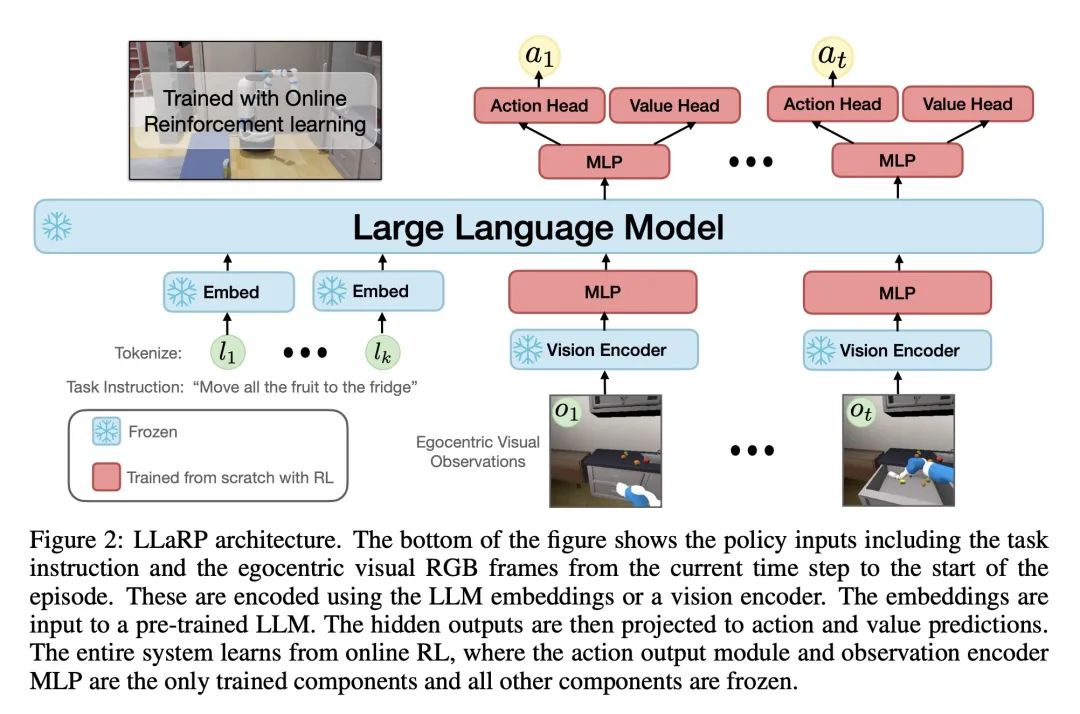

LLaRP以文本指令和自我视觉观察作为输入,输出环境中的行动,使用预训练冻结的LLM作为核心,带有用于视觉输入和动作输出的适配器模块。

-

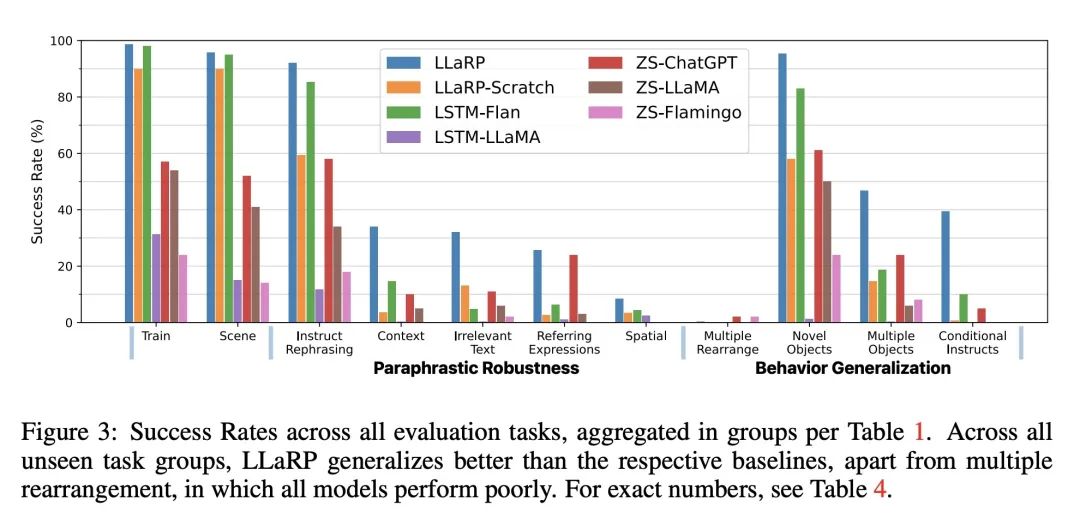

LLaRP在所提出的包含15万训练和1千测试任务的语言重排基准测试中展示出强大的泛化能力,与LSTM和transformer基线相比,其在新指令和新行为上获得了更高的成功率。

-

与基线相比,LLaRP在训练和持续学习期间展示了更好的样本效率和更快的收敛速度,在监督效率方面,可以与模仿学习相比。

-

LLM的使用导致策略表现出明显的解释鲁棒性,意味着其可以处理指令的语言变体,同时保持最优行为,LLM的世界知识也有助于策略泛化到新的行为。

-

为促进语言条件化的具身AI研究,本文发布了语言重排基准,其包含大量多样化的操作任务。

动机:探索大型语言模型(LLM)作为具有泛化能力的行为策略在具身视觉任务中的应用。

方法:采用一种称为大语言模型强化学习策略(LLaRP)的方法,通过在环境中接收文本指令和视觉自我中心观察作为输入,并直接在环境中输出行为,将预训练的冻结LLM进行自适应和训练。

优势:展示了LLaRP在复杂任务指令的改写和需要新的最优行为的新任务上的鲁棒性和泛化能力。在1,000个未见任务上,LLaRP实现了42%的成功率,比其他常见学习基线或LLMs的零样本应用成功率高出1.7倍。

一句话总结:

通过强化学习训练预训练大型语言模型,使其成为可以在具身视觉任务中泛化的行为策略,克服了任务指令重述和新任务最优行为的挑战,展现了超越直觉的泛化能力。

https://arxiv.org/abs/2310.17722

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง