Transformers as Graph-to-Graph Models

J Henderson, A Mohammadshahi, A C. Coman, L Miculicich

[Idiap Research Institute]

Transformer作为图到图模型

- 文章认为Transformer本质上是图到图的模型,序列只是一种特例。

- 注意力权重与图的边功能性等价。

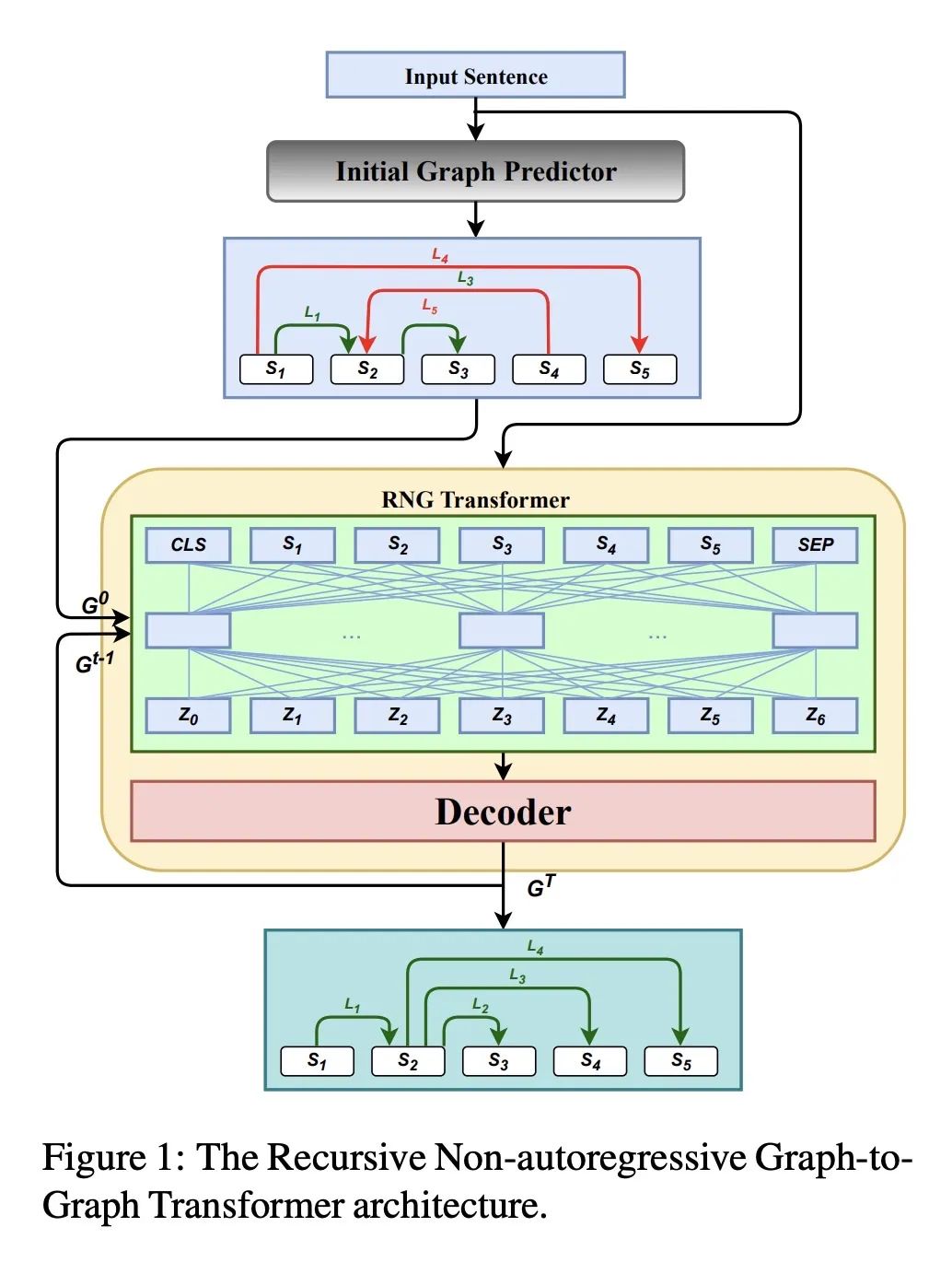

- 文章提出Graph-to-Graph Transformer架构,直接在自注意力机制中输入图的边。

- 迭代地聚合预测图可以实现联合嵌入输入图、输出图和潜在图。

- 在多种语言结构建模任务上取得最优结果,表明Transformer对表示语言结构是足够的。

动机:传统的神经网络模型无法很好地处理结构化表示,而Transformer模型的成功启发了研究人员将显式图结构与隐式图结构相结合,以更好地建模结构化表示。

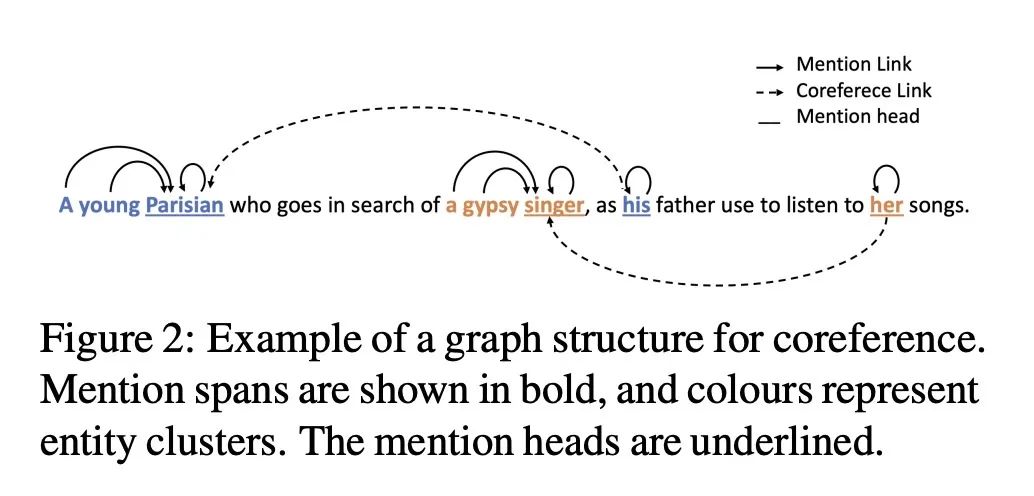

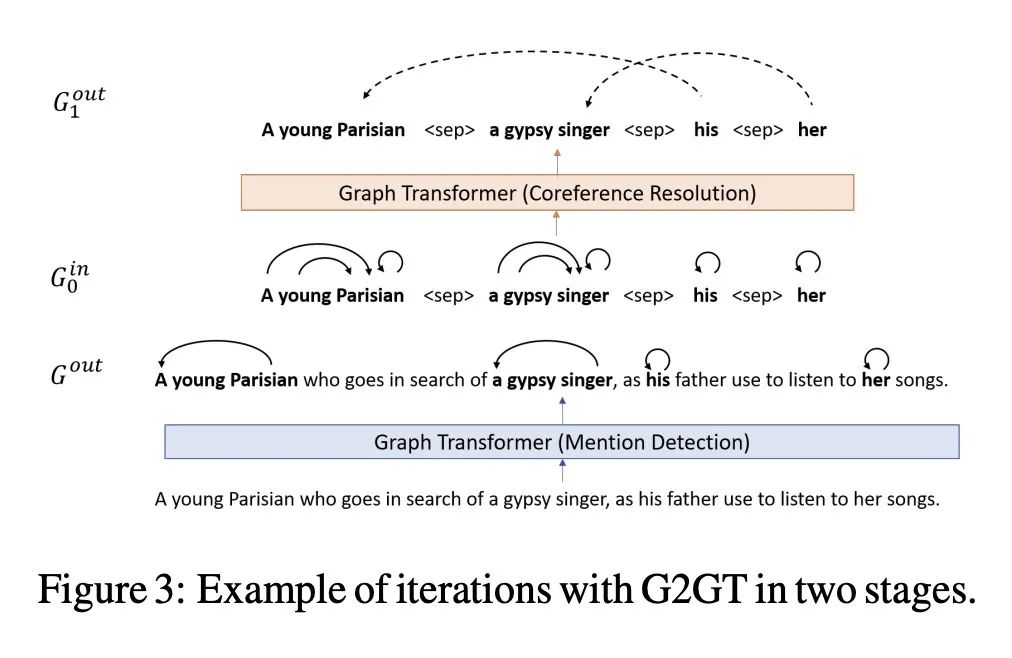

方法:提出一种名为Graph-to-Graph Transformer(G2GT)的架构,将显式图输入到注意力权重计算中,并使用注意力类似的函数预测图的边,从而将显式图整合到预训练Transformer学习到的隐式图中。通过迭代图优化,实现了对输入、输出和隐式图的联合嵌入,使得非自回归的图预测能优化完整的图结构。

优势:G2GT架构能以灵活而强大的方式将显式图整合到Transformer的隐式图中,实现对图的联合建模。通过对显式图的迭代优化,G2GT能同时预测和整合整个图结构,而不需要特定的流水线或解码策略。实验证明,该架构在建模各种语言结构方面取得了最先进的准确性,并与预训练的语言表示学习非常有效地集成。

提出一种Graph-to-Graph Transformer(G2GT)架构,将显式图结构整合到Transformer的隐式图中,实现了对结构化表示的联合建模和预测,具有优秀的准确性和集成能力。

https://arxiv.org/abs/2310.17936

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง