点击下方卡片,关注「AI视界引擎」公众号

华南理工AI安全团队联合约翰霍普金斯大学提出抵御联邦学习后门攻击的全新方案,发表于 ICCV 2023 中,提出一种解决联邦学习中后门攻击识别问题的全新方案。目前,Edge-case PGD 攻击给联邦学习带来巨大的威胁,其使用 edge-case 数据使得后门信息不会被其他客户的上传的梯度所稀释,使 PGD 方法训练的后门模型无法被服务器端部署的防御区分出来。之前的 state-of-the-arts 模型,如 FLAME, Foolsgold 等在 cifar10 数据集上的后门攻击准确率高达 60%。

本文在缓解“维度诅咒”的基础上提出了一种 Multi-metrics 的动态框架,以强大的后门识别能力将 Edge-case PGD 攻击的后门准确率降低至惊人 3.06%,并且保持着几乎不变的主任务准确率 84%,大大提高了联邦学习框架的鲁棒性。

论文链接:http://arxiv.org/abs/2303.06601

代码链接:https://github.com/siquanhuang/Multi-metrics_against_backdoors_in_FL

1. 摘要

联邦学习(FL)的分散性和隐私保护性使其很容易受到后门攻击,这些攻击的目的是在对手选择的特定输入上操纵生成模型的行为。然而,大多数基于统计差异的现有防御措施只能对特定攻击有效,尤其是当恶意梯度与良性梯度相似或数据高度非独立且同分布(非 IID)时。在本文中,我们重新审视了基于距离的防御方法,发现

i) 欧氏距离在高维度下变得毫无意义;

ii) 具有不同特征的恶意梯度无法通过单一指标识别。

为此,我们提出了一种简单而有效的防御策略,利用多指标和动态加权来自适应地识别后门。此外,我们的新型防御方法不依赖于对攻击设置或数据分布的预定义假设,对良性性能的影响也很小。为了评估我们方法的有效性,我们在各种攻击设置下的不同数据集上进行了综合实验,在这些实验中,我们的方法取得了最佳防御性能。例如,在难度最高的 Edge-case PGD 下,我们的后门准确率最低,仅为 3.06%,与以往的防御方法相比优势明显。实验还证明,我们的方法可以很好地适应各种非 IID 度,而不会牺牲良性性能。

2. 背景

联邦学习(FL)是一种在保护客户数据隐私安全的同时,能够高效训练深度学习模型的分布式框架。但也由于其对隐私的考虑,导致其容易受到数据投毒的攻击,尤其是隐蔽性更强的后门攻击(Backdoor attack)。为了提高 FL 的鲁棒性,人们提出了多种防御方法,例如基于评分的方法,这种方法利用特定的指标来区分恶意梯度和良性梯度。尽管这种方法对某些后门很有效,但研究人员发现,精心设计的攻击(本文称之为隐形后门,如 Edge-case PGD [1]),其梯度与良性梯度无法区分,可以轻松绕过这些防御措施。基于差分隐私(DP)的方法是在观察到传统上用来对付差分攻击的 DP 方法也能有效对付后门的基础上发展起来的。通过向全局模型添加高斯噪声,这些方法可以淡化潜在中毒模型更新的影响。令人惊讶的是,基于 DP 的方法在抵御这种高级后门方面表现出很强的能力。尽管 DP 有能力抵御隐形后门,但它所增加的噪声会显著降低整体性能和收敛速度。相比之下,基于距离的方法只汇总良性梯度,对全局模型的影响较小。因此,一个自然而然的问题出现了:我们能否在不牺牲 FL 模型性能的情况下防御隐蔽后门?为了实现这一目标,我们转向了不牺牲良性性能的基于距离的方法,并提出了以下研究问题:如何才能成功利用距离度量来区分敌意更新和良性更新?

于是,本文聚焦于以下两个问题:

1. 由于存在着维度诅咒效应 [2],欧氏距离(即 L2 距离)在高维空间(神经网络)中失去度量意义;

2. 单一度量仅对特定攻击有效,并需要对恶意攻击梯度有详细假设。

3. 本文方法

3.1 曼哈顿距离缓解维度诅咒

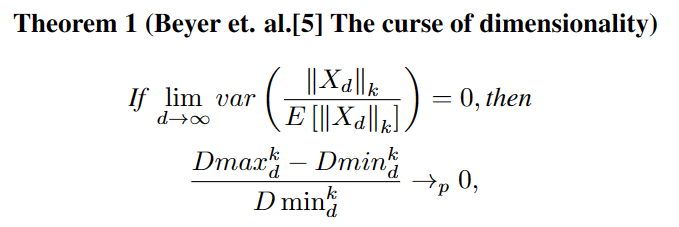

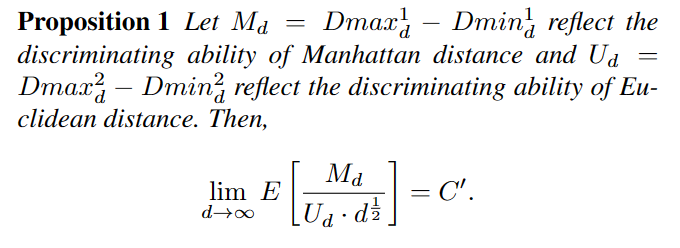

Theorem1 为维度诅咒效应的公式,随着维度 d 的上升,距离指标将会逐渐丧失意义。

虽然无法彻底解决维度诅咒带来的问题,根据我们的理论证明,本文表示曼哈顿距离在高维空间中的识别能力要远远好于常用的欧式距离,可以缓解维度诅咒效应。

3.2 Multi-metrics 框架

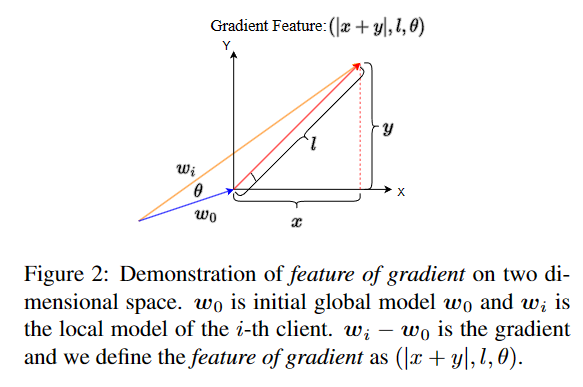

即便曼哈顿距离有着更好的识别效力,但是本文也不认为在识别后门攻击的时候曼哈顿就能完全替代欧氏距离。除此以外,先前的工作已经表明 [3],有的后门攻击会在欧氏距离上表现区分度,有的则会在余弦相似度(Cos 距离)上表现差异。于是本文决定采用曼哈顿、欧氏和 Cos 距离共同去识别后门,如上图所示。

在定义好了识别梯度时的指标之后,在我们面前也有两个障碍:1. 三种距离有着不同的尺度,由于每个度量都是相关的,因此需要一种新的正则化方法,而不是通常的按最大值进行归一化;2. 不同的数据分布(如不同程度的非 IID)会使恶意客户端和良性客户端的梯度不同。因此,需要动态加权来应对各种环境和攻击,以实现通用防御。

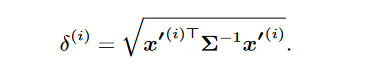

为了解决上述问题,本文提出了一种通过浓度矩阵(协方差矩阵的逆)进行白化的方法如上图所示,其中为客户端距离特征向量,为协方差矩阵,其能够根据每个客户端上三个指标特征的分布动态地决定每个指标的权重,以适应不同的数据分布情况和攻击策略。在得到了客户端的距离得分后,便可以根据该分数聚合更优梯度。

4. 实验结果

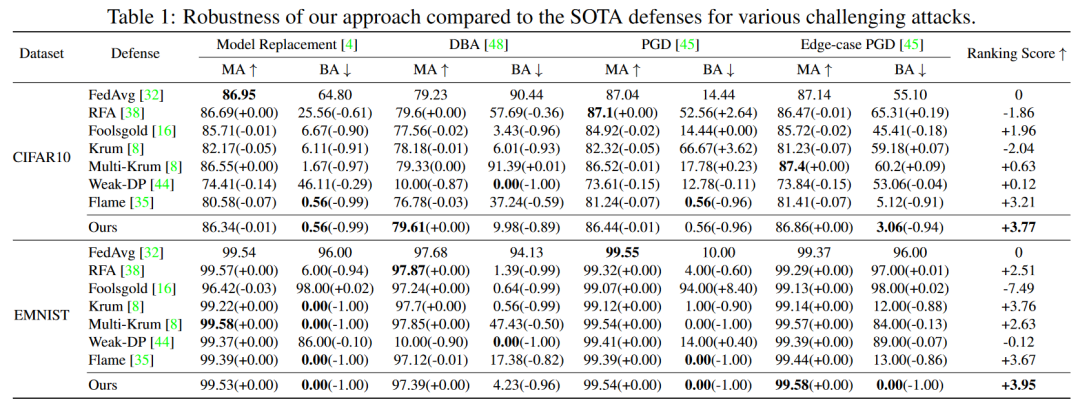

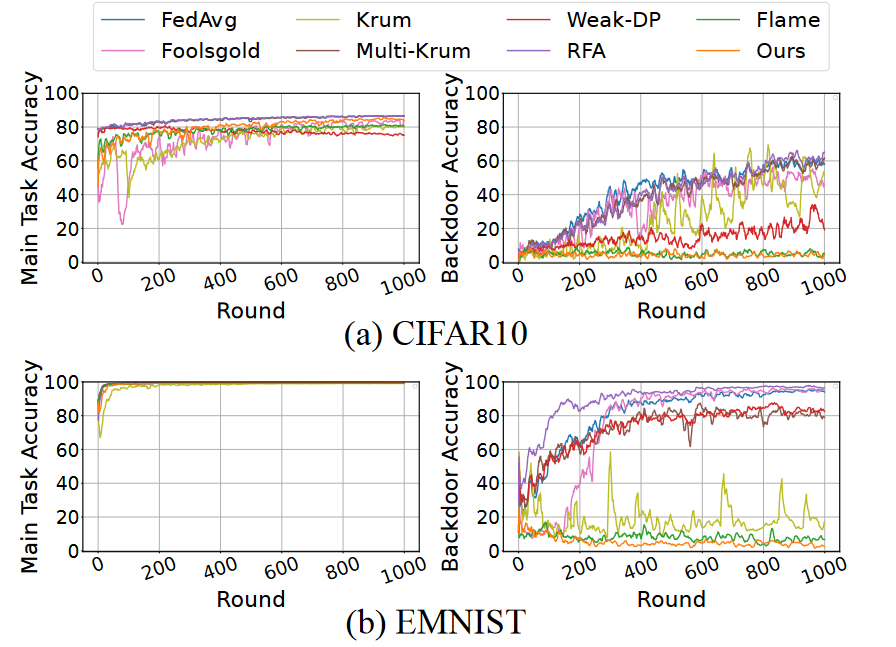

跟其他防御比较起来,我们的方法展现出了巨大的优势,尤其是在面对隐形后门 Edge-case PGD [1],只有我们的方法和 Flame [3] 可以对其有效的防御。其中 Flame 还会伴随着主任务性能的明显下降,而我们的方法几乎没有这种损失。

从训练曲线上看,我们的方法也有着独树一帜的效果。本文也通过充分的消融实验说明了我们方法的有效性,尤其是我们充分分析了在不同攻击场景下我们方法动态加权的特性。

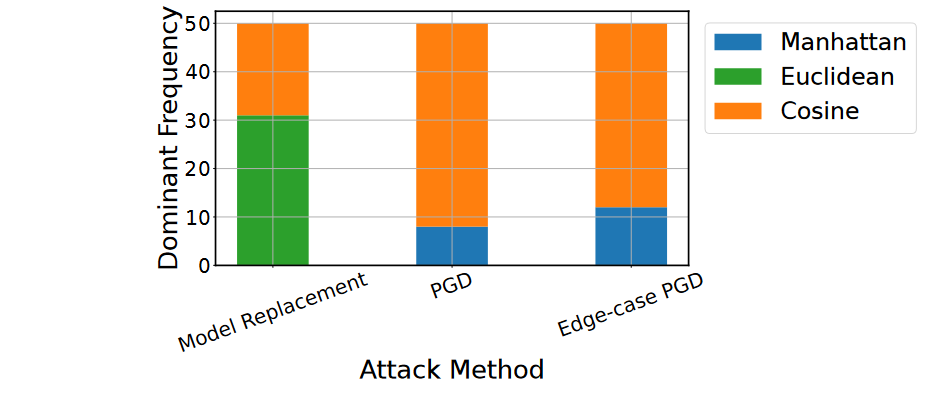

如上图所示,我们展示了在不同攻击场景下,起主导作用(权重最大)的距离特征的频率,发现我们的方法在面对不同攻击的时候给每个特征的权重不同。在面对模型替换攻击时(该攻击在欧氏距离上进行了放大),由于攻击梯度在欧式距离最明显,则会加大欧式距离的权重。而在面对 PGD 攻击时(该攻击在欧式距离上进行了缩小),欧式距离上攻击梯度与其他良性梯度更相似,则其权重最小。这种结果表明,我们的方法会在任何情况,都会动态给每个特征进行最适当的加权,以应对不同特征的攻击。

5. 参考文献

[1] Hongyi Wang, Kartik Sreenivasan, Shashank Rajput, Harit Vishwakarma, Saurabh Agarwal, Jy-yong Sohn, Kangwook Lee, and Dimitris Papailiopoulos. Attack of the tails: Yes, you really can backdoor federated learning. Advances in Neural Information Processing Systems, 33:16070–16084, 2020.

[2] Kevin Beyer, Jonathan Goldstein, Raghu Ramakrishnan, and Uri Shaft. When is “nearest neighbor” meaningful? In International conference on database theory, pages 217–235. Springer, 1999.

[3] Thien Duc Nguyen, Phillip Rieger, Huili Chen, Hossein Yalame, Helen M ̈ ollering, Hossein Fereidooni, Samuel Marchal, Markus Miettinen, Azalia Mirhoseini, Shaza Zeitouni, et al. Flame: Taming backdoors in federated learning. In 31st USENIX Security Symposium (USENIX Security 22), pages 1415–1432, 2022.

6. 推荐阅读

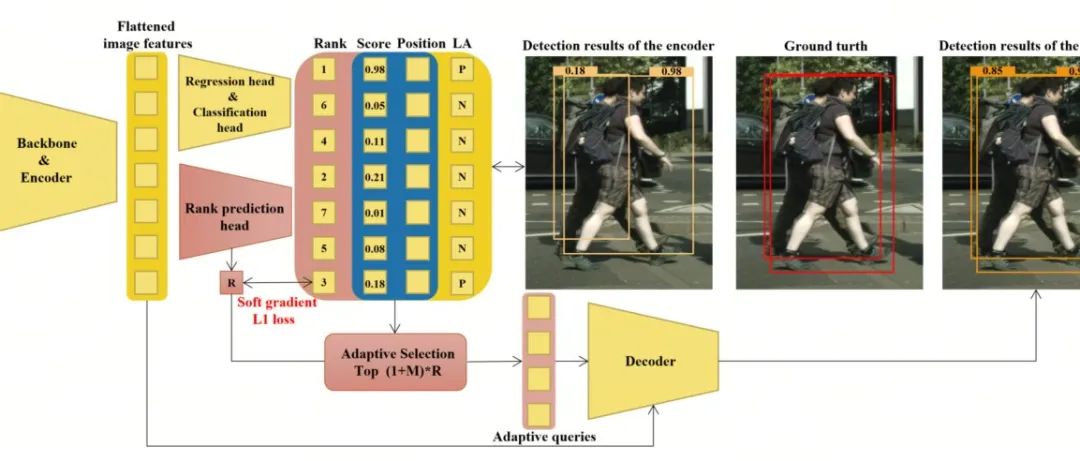

即插即用 Trick | Query-adaptive DETR 提出 Soft Gradient L1 loss,拥挤不是问题

AutoDesk团队提出Segment-Like-Me | SLiME能比SAM分割更丝滑吗?

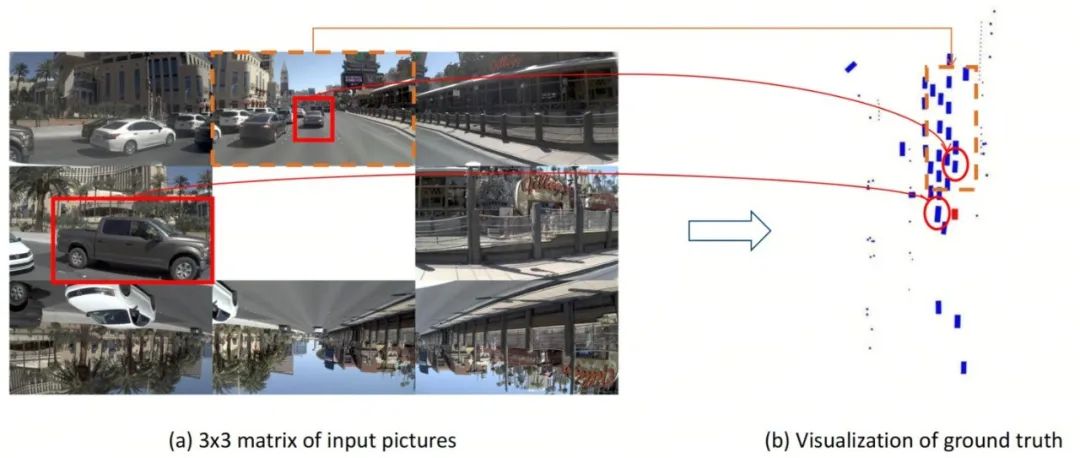

YOLO没向3D低头 | 毫不意外!YOLO-BEV正式来袭,依旧沿袭YOLO家族超快推理特性

点击上方卡片,关注「AI视界引擎」公众号

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง