大模型的性能该如何量化?开源模型与闭源模型间是否存在能力差距?什么样的大模型才是“好”的大模型?

近日,上海人工智能实验室(上海AI实验室)正式推出OpenCompass大模型开放评测体系(以下简称“OpenCompass”),通过完整开源可复现的评测框架,支持大语言模型、多模态模型各类模型的一站式评测,并定期公布评测结果榜单。

今年7月,上海AI实验室联合多家机构发布“书生通用大模型体系” ,包含三大基础模型及贯穿数据、预训练、微调、部署和评测五大环节的全链条工具体系。此次正式推出的OpenCompass,从评测角度进一步巩固了大模型创新的技术基石,以纯粹技术及中立视角为产学研界提供客观的大模型能力参考。

加入评测及查看报告,可访问:

官网链接 https://opencompass.org.cn

开源链接 https://github.com/open-compass/opencompass

六大亮点功能,提供专业模型评测

作为高效、全面的大模型评测体系及开放平台,OpenCompass提供完整开源可复现的评测框架,支持大语言模型、多模态模型的一站式评测,基于分布式技术,对大参数量模型亦能实现高效评测。同时,通过零样本评测、小样本评测和思维链评测等多样化评测,OpenCompass可全方位量化模型在各个的维度能力。

1

全面的能力维度

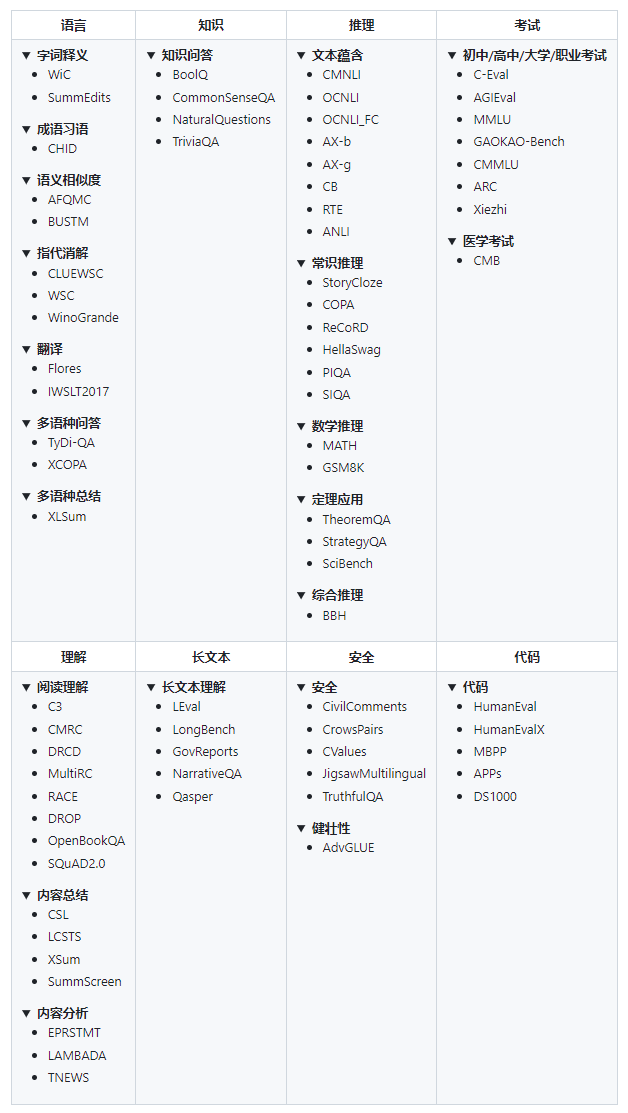

为全面反映大模型在不同领域的能力差异,客观反映优势与问题,OpenCompass将测评方向汇总为知识、语言、理解、推理、考试5大能力维度,整合集纳了超过70个评测数据集,合计提供了超过40万个模型评测问题,并提供长文本、安全、代码3类大模型特色技术能力评测。在实际评测过程中,每一能力维度的评测均需通过各维度下所有的数据集,避免因大模型“偏科”而产生评测结果的倾向性情况。

OpenCompass包含的评测数据集

OpenCompass包含的评测数据集

2

丰富模型支持

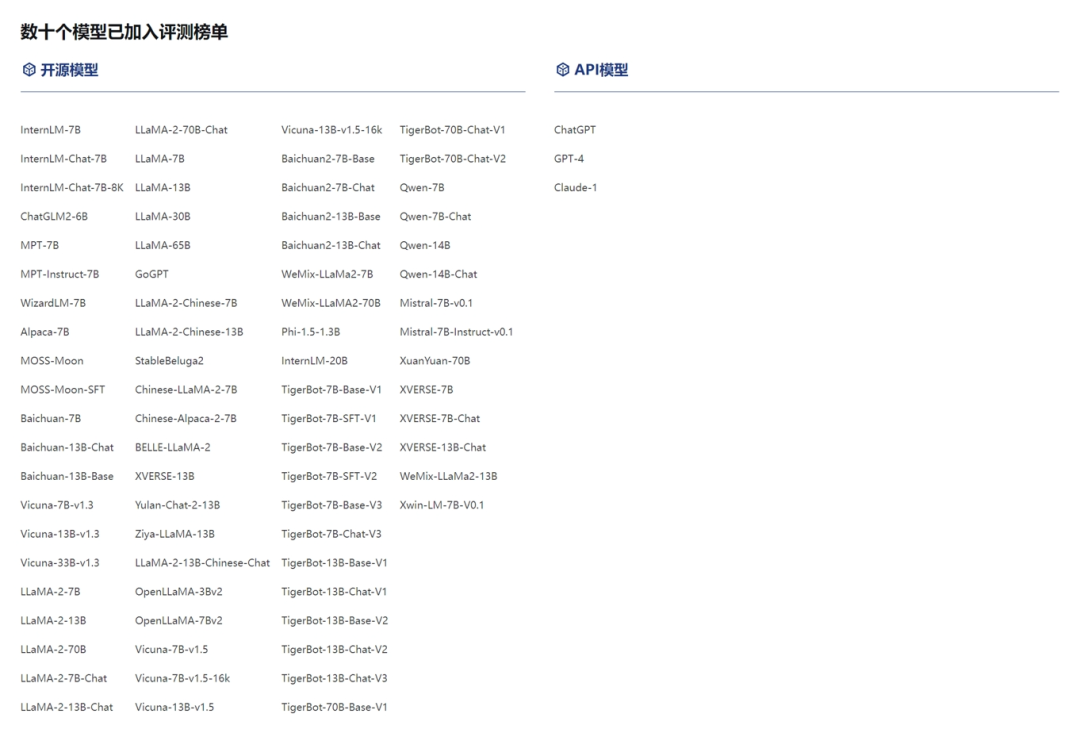

可对种类丰富的大模型进行评测是OpenCompass的重要属性。OpenCompass不仅可对超过70种开源模型的进行评测,还预留了简洁的模型接口,开发者可自主接入API模型。目前,OpenCompass 已支持OpenAI 接口的调用(支持测试ChatGPT/GPT-4),后续还持续支持 Claude, PaLM 等多种 API 模型的评测。作为具有重要影响力的大模型托管平台,HuggingFace承载了当前业界几乎所有的开源模型,研究团队与技术社区紧密合作,用户可通过OpenCompass对HuggingFace承载的开源大模型进行“一站式”评测,为学术研究提供直接便利。

OpenCompass支持的模型评测类型

OpenCompass支持的模型评测类型

3

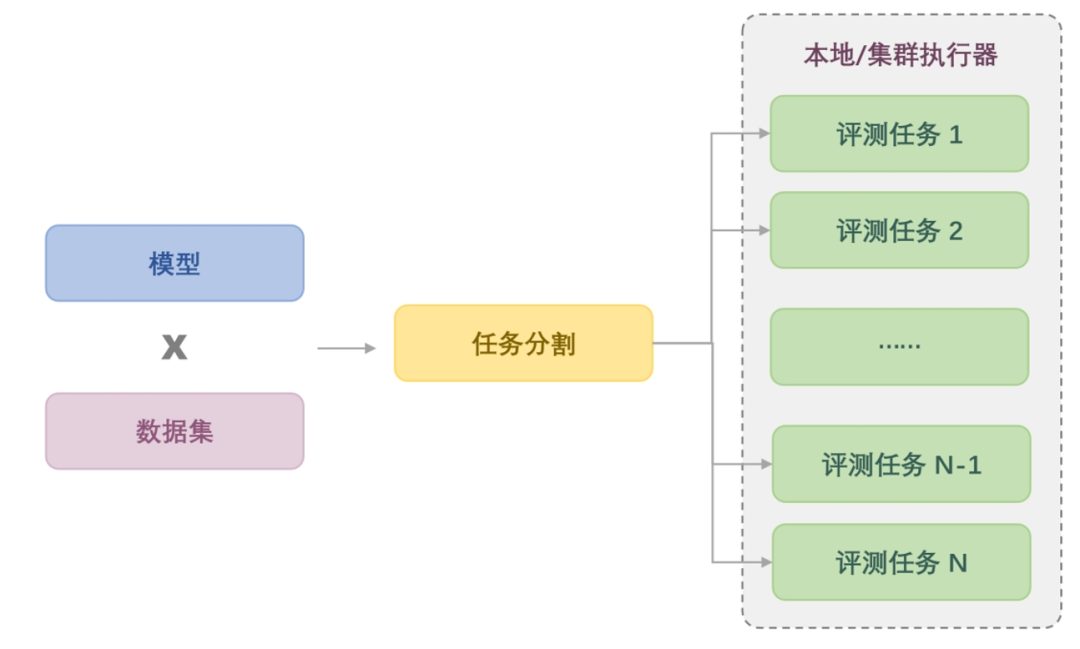

分布式高效评测

OpenCompass 原生提供分布式评测方案,支持在本机或集群上的计算任务并行分发,实现评测并行式的提速。此外,还通过分割大任务、合并小任务等策略,控制各计算任务的执行时间尽可能相等,实现计算负载均衡,更加充分地利用所有的计算资源。研究团队在测试中发现,当运算资源充足的情况下,OpenCompass 最短仅需 3 个小时即可完成千亿参数量级模型的完全评测,实现了模型训练-评测链路上的快速迭代。

OpenCompass支持任务自由切割和组合,高效并发评测

OpenCompass支持任务自由切割和组合,高效并发评测

4

多样化评测方式

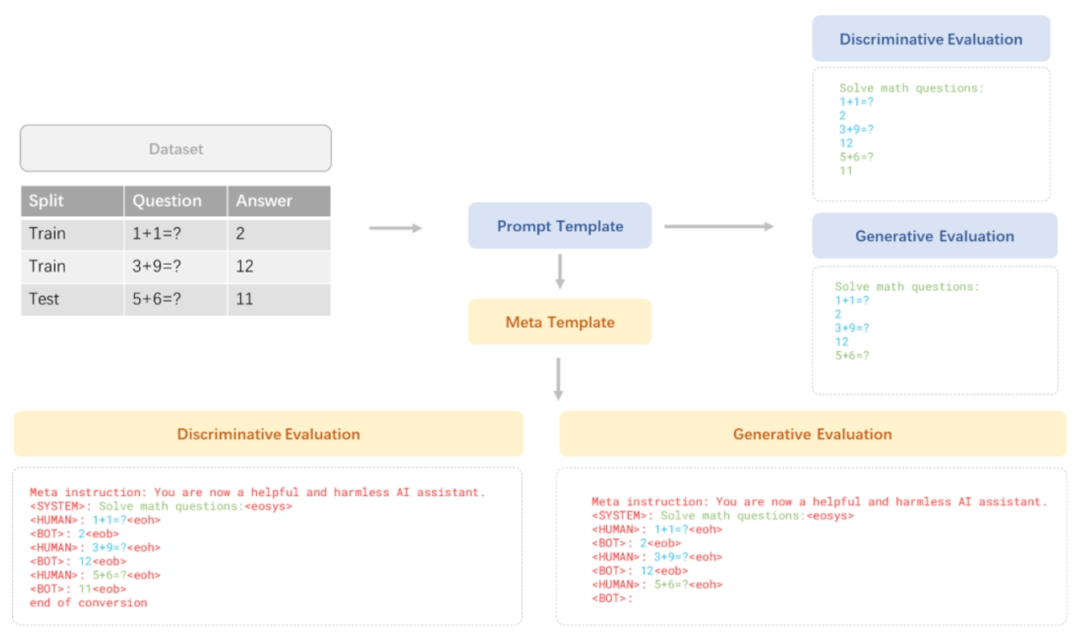

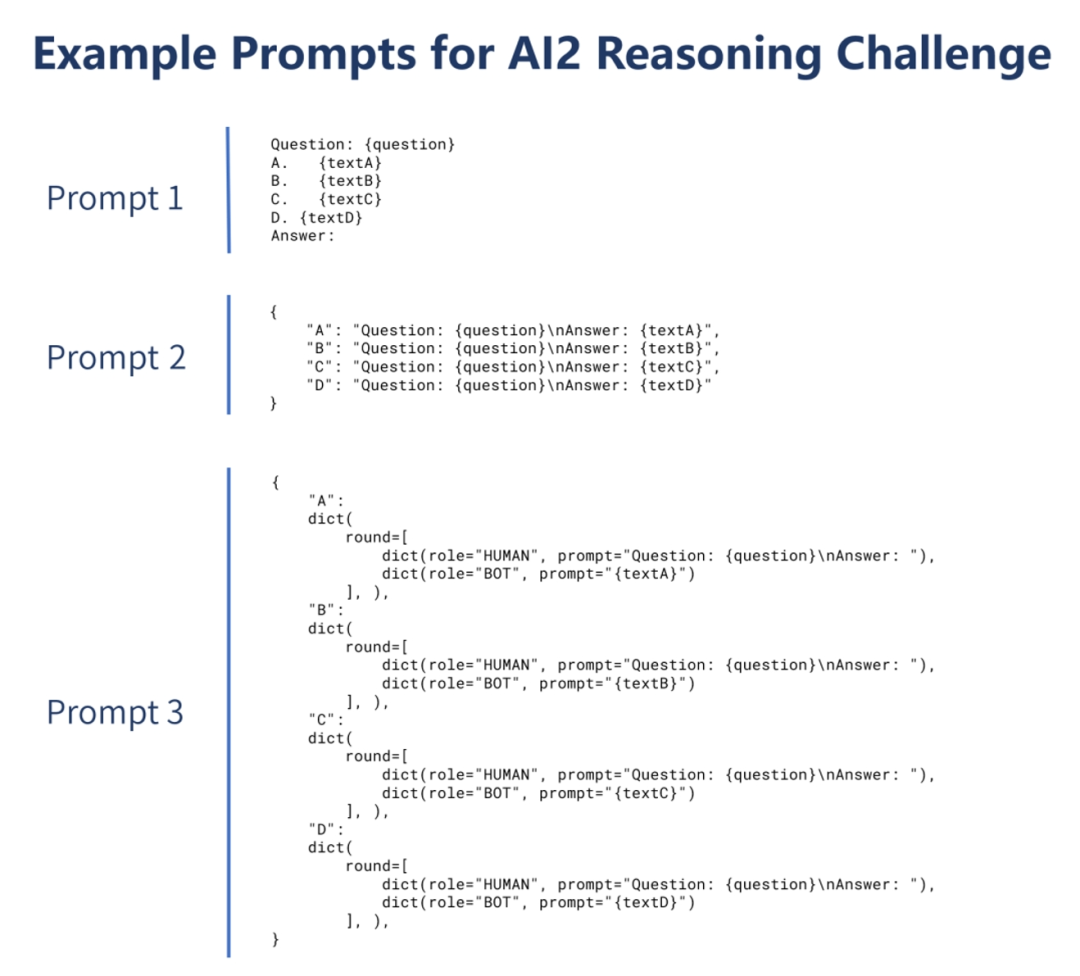

OpenCompass提供基础的零样本评测策略,并支持小样本评测策略,同时提供 7 种不同的上下文样例的提取方案,助力提示词构建。未来,OpenCompass还将提供思维链式(chain-of-thought)评测策略。此外,OpenCompass针对对话模型的特性,首创与模型绑定的提示词模板(Meta Template),允许用户自定义模型的对话模板,从而把提示词以最优的方式传入基座或对话模型。

支持多种评测提示词构建策略,最大程度激发模型性能

支持多种评测提示词构建策略,最大程度激发模型性能

5

灵活化拓展

OpenCompass支持灵活便捷的添加评测数据集与模型,用户可通过预留接口,对非开源的自定义模型进行评测。研究团队通过设计代码架构,允许用户新增数据集数据集或自定义数据划分策略,甚至接入新的集群管理后端。为拓展评测模型的类型提供无限可能。

6

开源可复现

作为公开评测方案,OpenCompass向技术社区开源。当前OpenCompass所有支持的数据集及各数据集多版本提示词,用户可一键下载。通过多方位全链路的公开,确保评测结果可以被完整复现。同时,OpenCompass欢迎各界共同参与贡献,持续优化提示词和测试逻辑,共同打造更强大、更全面的大模型评测基准。

OpenCompass 为每个数据集都提供了多种评测方案(上图以ARC为例)

OpenCompass 为每个数据集都提供了多种评测方案(上图以ARC为例)

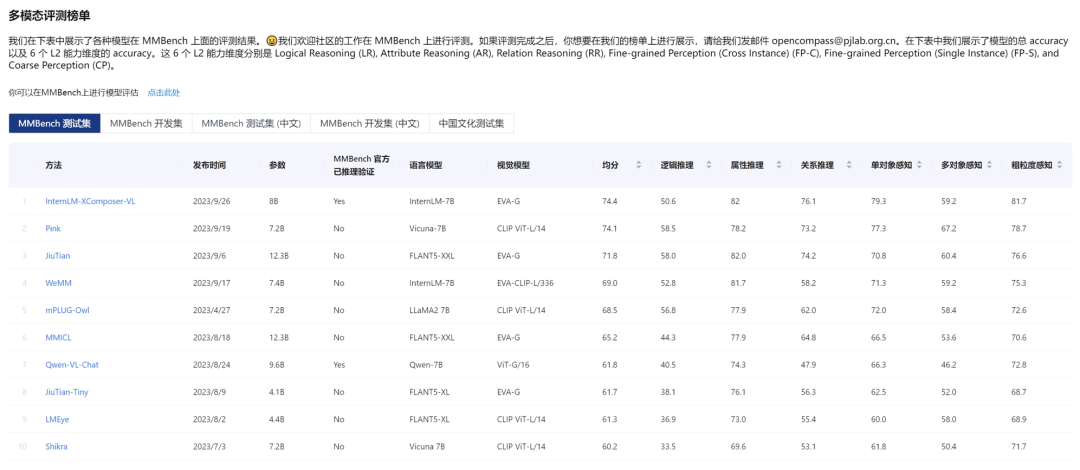

不止 LLM,解锁多模态能力评测

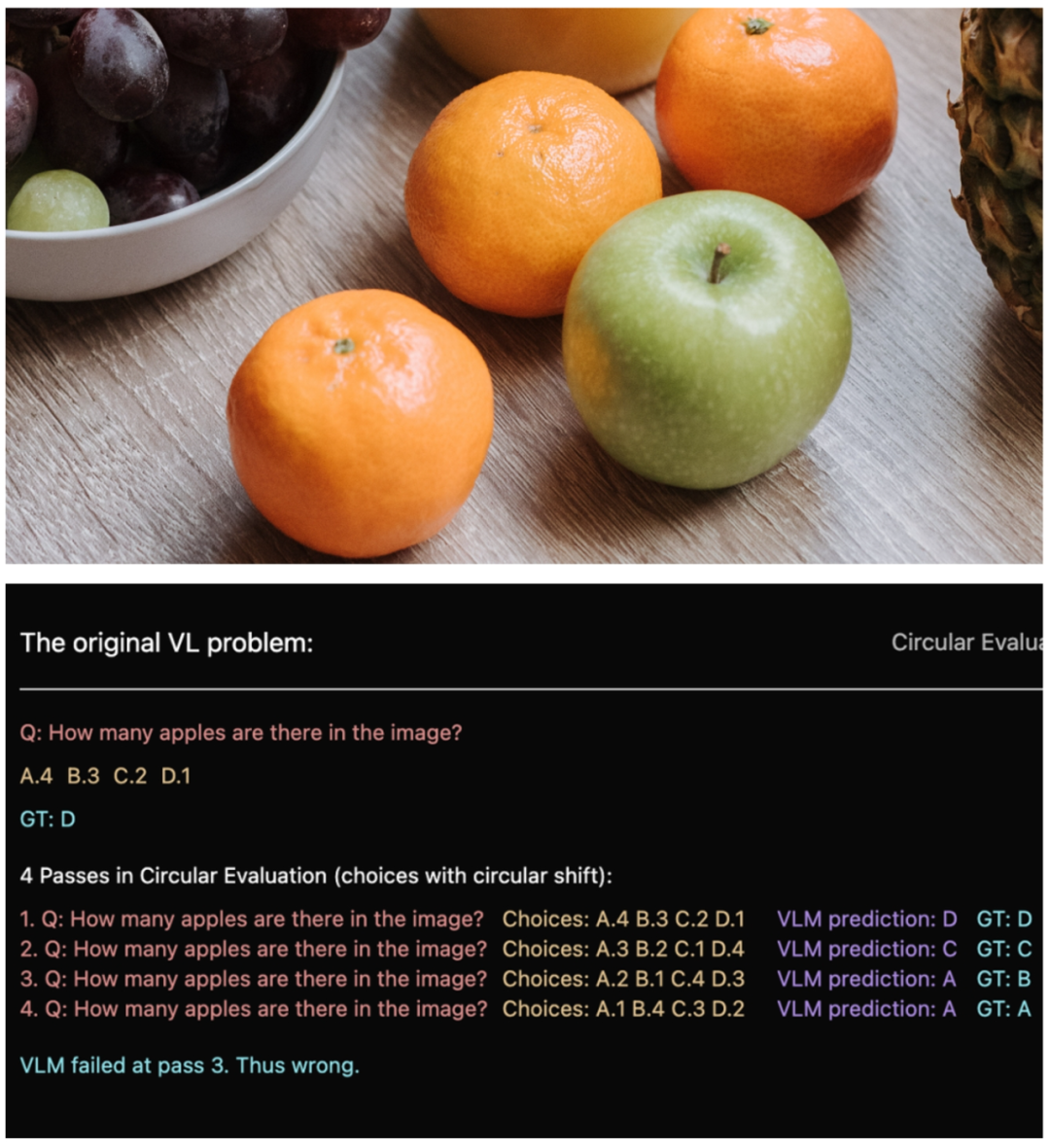

研究团队在大语言评测的基础上,进一步研发了MMBench数据集,将OpenCompass功能拓展至多模态大模型能力评测。MMBench是OpenCompass 研究团队自建的视觉语言模型评测数据集,可实现从感知到认知能力逐级细分评估。研究团队从互联网公开信息与权威基准数据集采集约 3000 道单项选择题 ,覆盖目标检测、文字识别、动作识别、图像理解、关系推理等 20个细粒度评估维度。在具体评测中,提出了更具鲁棒性的评估方式,对相同单选问题循环选项提问,模型输出全部指向同一答案认定为通过,最大程度减少各种噪声因素对评测结果的影响,保证了结果的准确性及可复现性。

MMBench对模型图像理解维度的评测

MMBench对模型图像理解维度的评测

MMBench对部分开源视觉语言模型的评测结果

MMBench对部分开源视觉语言模型的评测结果

在多模态评测领域,OpenCompass还收录了SEED-Bench, MME, ScienceQA 等十余个多模态评测集,从多种视角客观量化多模态大模型的能力。此外,OpenCompass还可用于评测大模型的工具调用能力,配合Lagent、LangChain 等智能体框架。快速开展工具调用能力评测。

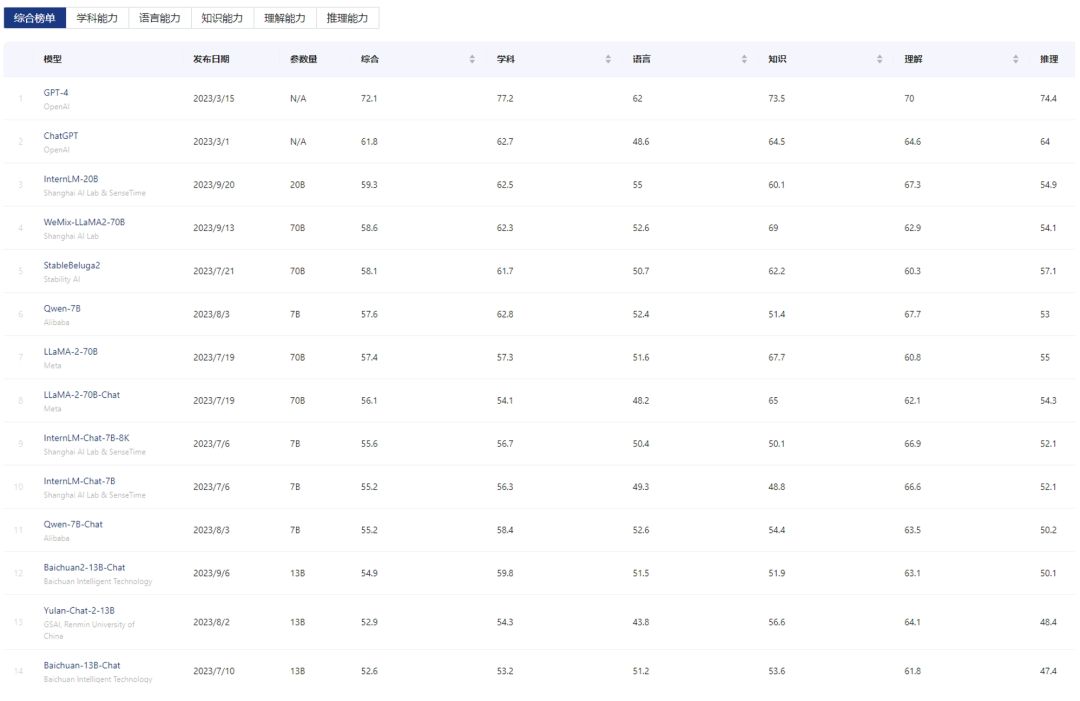

公开评测榜单,降低评测门槛

OpenCompass 同时接受技术社区提交的评测申请,评测结果会在完成后被实时更新于榜单上。

目前,OpenCompass针对大语言模型的评测榜单OpenCompass LLM

Leaderboard已被技术社区HuggingFace 官方发布的模型能力评测合集The Big Benchmarks Collection 所收录。

OpenCompass LLM Leaderboard

https://huggingface.co/spaces/opencompass/opencompass-llm-leaderboard

The Big Benchmarks Collection

https://huggingface.co/collections/open-llm-leaderboard/the-big-benchmarks-collection-64faca6335a7fc7d4ffe974a

榜单一览 (数据截止2023.9.24,排行榜分数受到 OpenCompass 当前支持的数据集及提示词影响,分值和相对排名仅供参考。OpenCompass 将会持续保持榜单、测试数据及评分细则的公开。)与此同时,为进一步降低大模型评测门槛,OpenCompass提供丰富完善的引导文档,包含环境安装、数据集配置、模型准备、高效评测、任务运行监控、评估指标和结果展示等详细信息,帮助用户快速上手评测工具,迅速开展模型能力评估,与各界一道共建更完善的模型评测体系,共促AI生态繁荣。

榜单一览 (数据截止2023.9.24,排行榜分数受到 OpenCompass 当前支持的数据集及提示词影响,分值和相对排名仅供参考。OpenCompass 将会持续保持榜单、测试数据及评分细则的公开。)与此同时,为进一步降低大模型评测门槛,OpenCompass提供丰富完善的引导文档,包含环境安装、数据集配置、模型准备、高效评测、任务运行监控、评估指标和结果展示等详细信息,帮助用户快速上手评测工具,迅速开展模型能力评估,与各界一道共建更完善的模型评测体系,共促AI生态繁荣。

欢迎关注OpenMMLab公众号,了解OpenCompass最新动态

欢迎扫码加入OpenCompass微信交流群

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง