时光荏苒,岁月如梭,不知不觉,我们又一起走过了 2023 年的第三季度。在过去的三个月里,OpenMMLab 又攒了哪些“瓷器活儿”,各个算法库进行了哪些重大更新?社区里开展了哪些精彩的活动呢?现在我们就来向社区的小伙们报告啦!

01

核心进展

开放域感知,让视觉模型突破类别限制

开放域感知是目前视觉领域的研究热点之一。传统感知任务中,模型能力往往受限于训练数据中的样本类别。开放域感知突破了这一限制,让训练后的模型可以感知训练集之外的物体类别,甚至感知任意的语义概念,大大拓展了模型的能力边界和应用场景。

OpenMMLab 此次更新增加了多个热门的开放域感知算法:

-

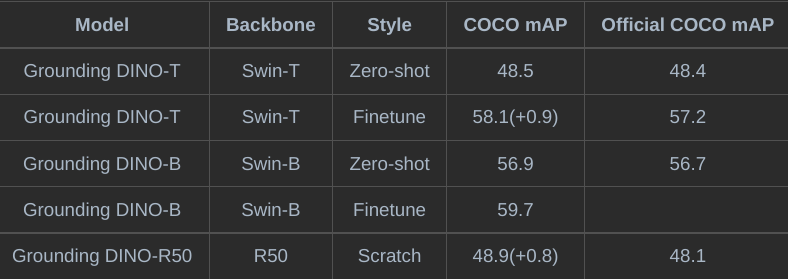

支持了开放域目标检测算法 GoundingDINO,并提供了目前唯一的开源微调方案,性能超过官方结果(~1 AP)

MMDetection 支持 GroundingDINO 微调,

性能优于官方模型

-

支持了视觉定位算法 GLIP 微调,性能优于论文结果

-

支持了开放词汇检测算法 Detic,可以联合使用分类和检测数据进行训练

-

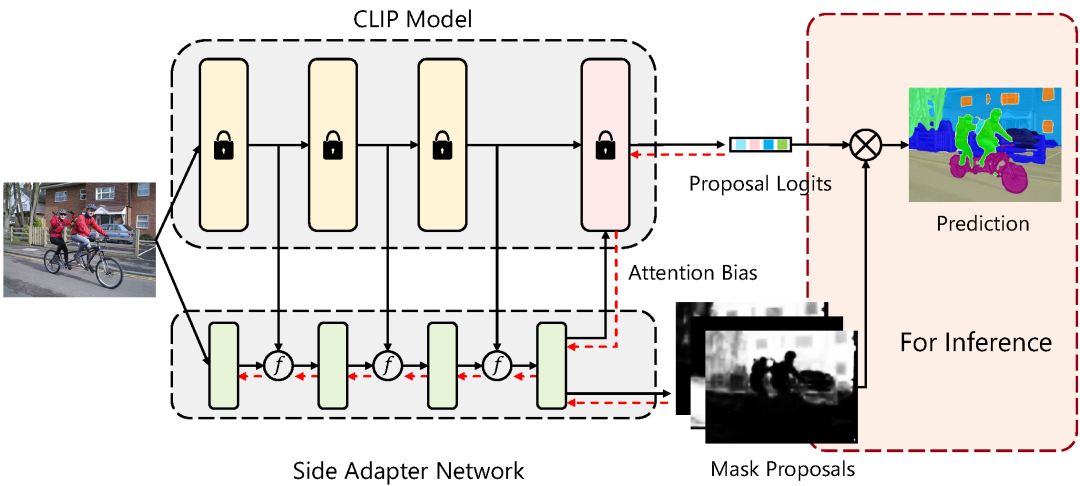

增加开放词汇分割算法 SAN(CVPR23),并支持了完整的训练流程

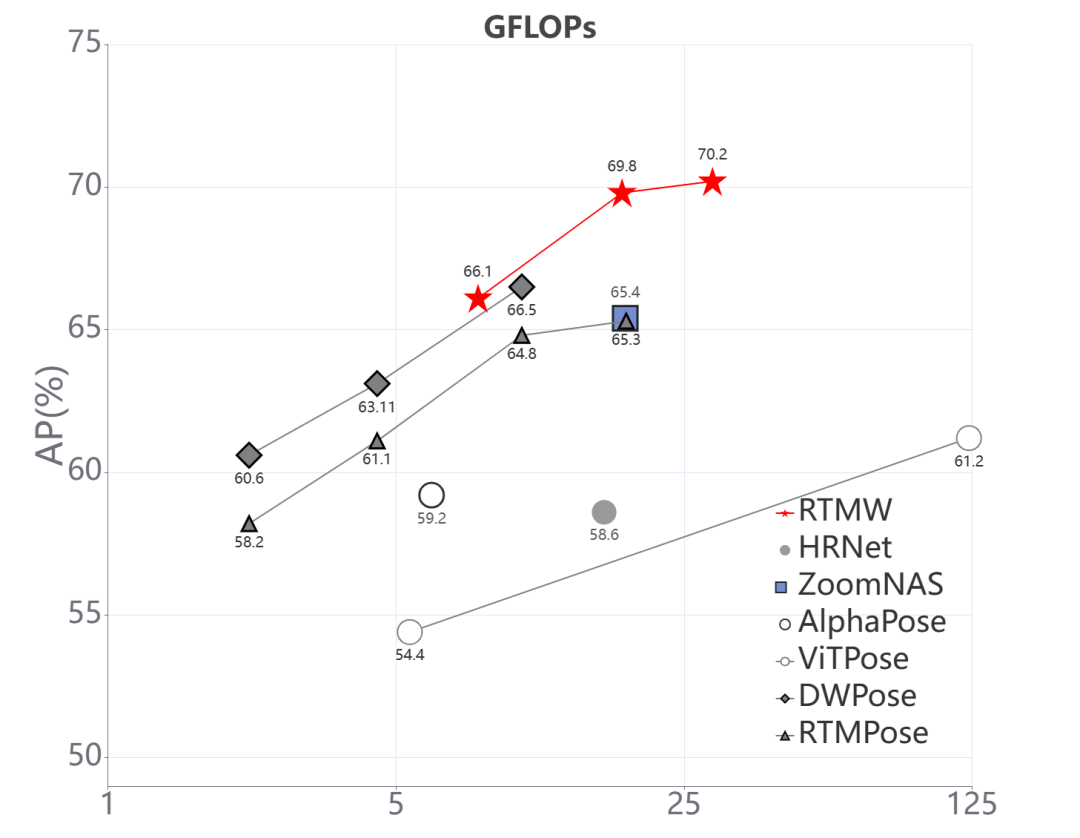

高性能全身姿态估计:SOTA 精度,实时推理

OpenMMLab 自研高性能感知模型 RTM 系列迎来新成员——全身关键点模型 RTMW。

RTMW 模型效果展示

全身关键点检测提供了对人体姿态、表情、手势的全面且精细的刻画,对下游任务如动作捕捉、运动分析、人机交互、AI 图像生成(如 ControlNet)等有非常重要的意义。此次发布的 RTMW 模型,对精度和推理速度做了深度优化:

-

首个在 COCO-Wholebody 上突破 70 AP 的开源模型

-

更加精准的手部细节,实时推理,满足应用场景需求

-

完整的模型部署工具链,开箱即用的 SDK

-

在线试玩 Demo:https://openxlab.org.cn/apps/detail/mmpose/RTMPose

RTMW 模型性能

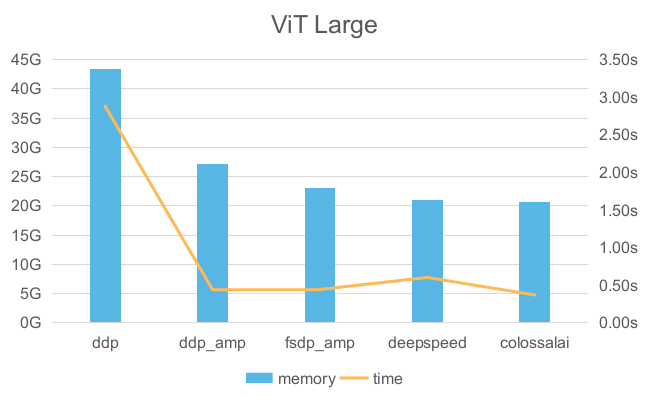

训练框架升级,大模型一样“玩得转”

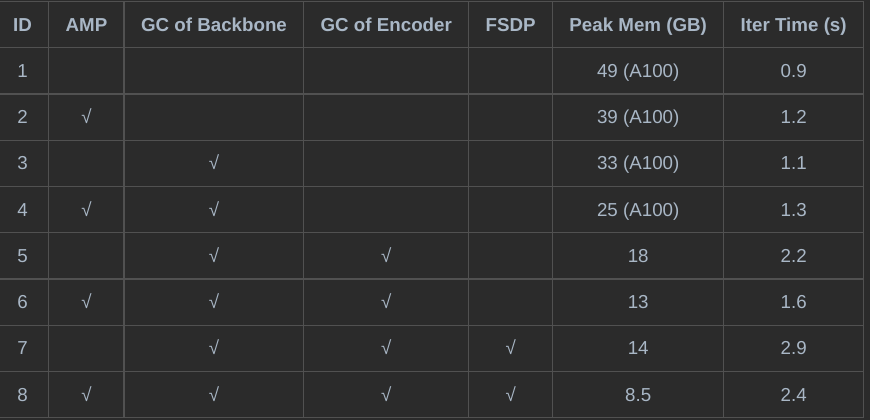

前沿视觉模型在复杂任务和困难场景上不断取得突破,但随之而来的模型参数量和数据规模增加,也给训练框架提出了新的挑战。MMEngine 全面支持了 ColossalAI、FSDP、DeepSpeed 等高性能大模型训练框架,带来极致的训练速度提升和显存优化。

基于新版本的 MMEngine,我们也在 MMDetection 中提供了训练检测大模型的应用案例。

MMEngine 支持 ColossalAI,

优化大模型训练速度和显存开销

02

算法库重要更新

MMCV

-

支持 PyTorch2.1.0

-

添加 PointsInPolygons 和 BoxIouRotated 算子对华为昇腾芯片的支持

MMEngine

-

支持大模型训练框架 ColossalAI,极致提升训练速度并降低显存占用

-

支持梯度检查点 Gradient Checkpoint ,一行配置即可减少模型显存占用

-

支持多种可视化后端,包括 NeptuneVisBackend、DVCLiveVisBackend 和 AimVisBackend

MMDetection

-

检测 Transformer SOTA 模型大合集

-支持了 DDQ、CO-DETR、AlignDETR 和 H-DINO 4 个更新更强的 SOTA Transformer 模型

-基于 CO-DETR, MMDet 中发布了 COCO 性能为 64.1 mAP 的模型

-DINO 等算法支持 AMP/Checkpoint/FrozenBN,可以有效降低显存

-

提供了全面的 CNN 和 Transformer 的性能对比

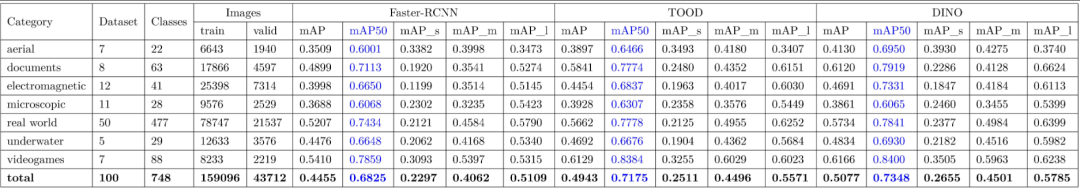

-RF100 是由 100 个现实收集的数据集组成,包括 7 个域,可以验证 DINO 等 Transformer 模型和 CNN 类算法在不同场景不同数据量下的性能差异。用户可以用这个 Benchmark 快速验证自己的算法在不同场景下的鲁棒性

CNN vs Transformer

检测模型性能 benchmark

-

支持了 GLIP 和 Grounding DINO 微调,性能均优于官方结果

-值得一提的是,MMDetection 也是目前唯一支持 GroundingDINO 微调的开源代码库。此外,我们还提供了详细的 Grounding DINO 在自定义数据集上训练评估的流程,欢迎大家试用

-

支持开放词汇检测算法 Detic 并提供多数据集联合训练可能

-

支持使用 FSDP 和 DeepSpeed 训练检测模型

使用 FSDP 优化检测模型训练速度和内测开销

-

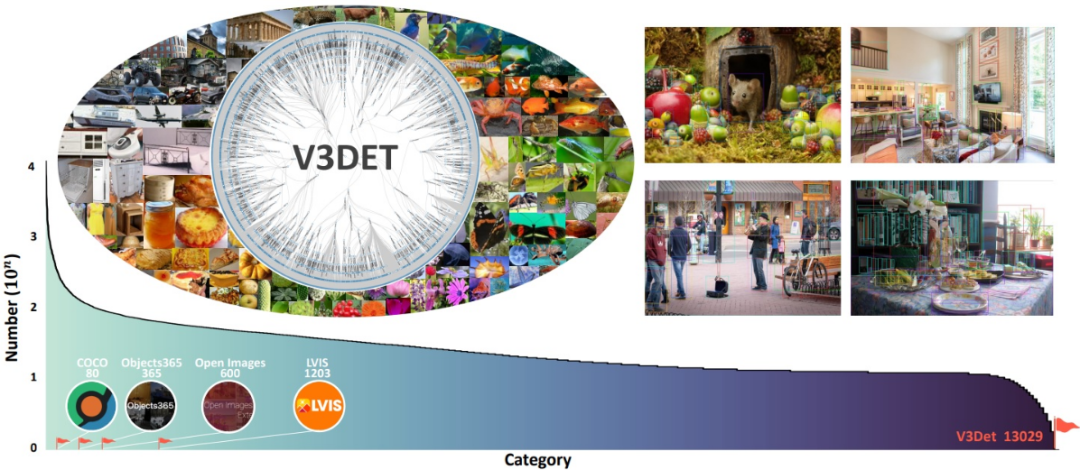

支持了 V3Det 1.3w+ 类别的超大词汇检测数据集

支持 V3Det 数据集:

超过 1.3w 类别的超大词汇目标检测

MMDetection3D

-

支持 DSVT,Waymo 数据集上纯 LiDAR 3D Object Detection SOTA 算法

-

新增点云检测、分割,单目检测及多模态 Inferencer 的 demo 演示

-

重构 Waymo 数据集支持,加速数据集处理、训练启动、验证

MMSegmentation

-

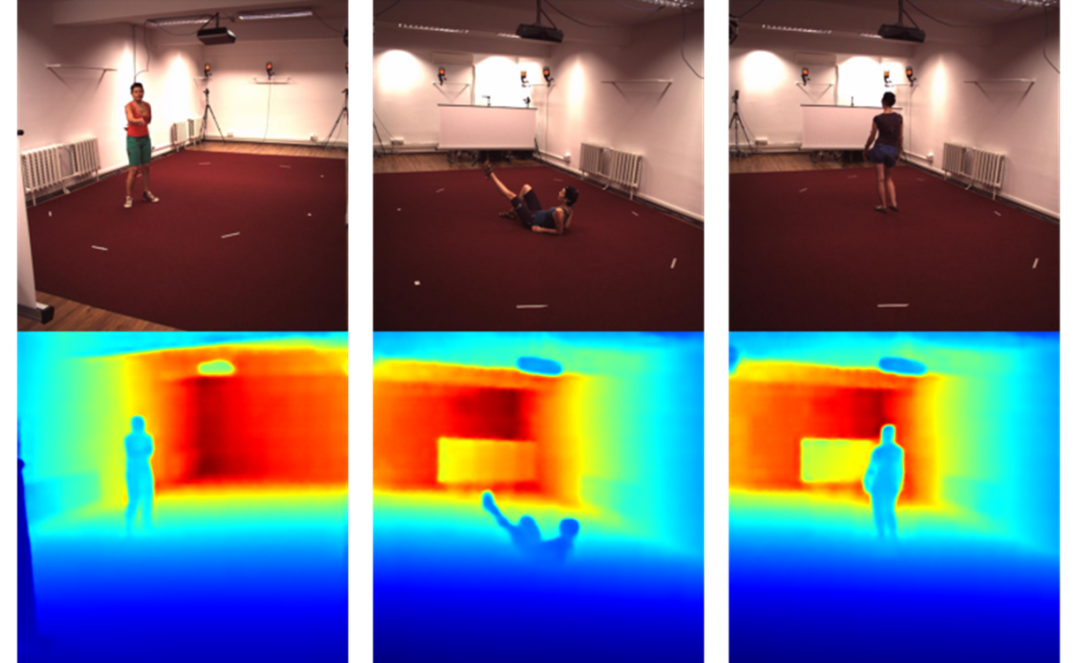

支持深度估计任务,新增 VPD 算法和 NYU 数据集,并支持深度图可视化

-

支持 SAN 开放集语义分割算法

-

新增 RSInferencer API,支持遥感图像快速推理

MMSegmentation 支持深度估计任务

开放词汇分割算法 SAN(CVPR23)

MMPreTrain

-

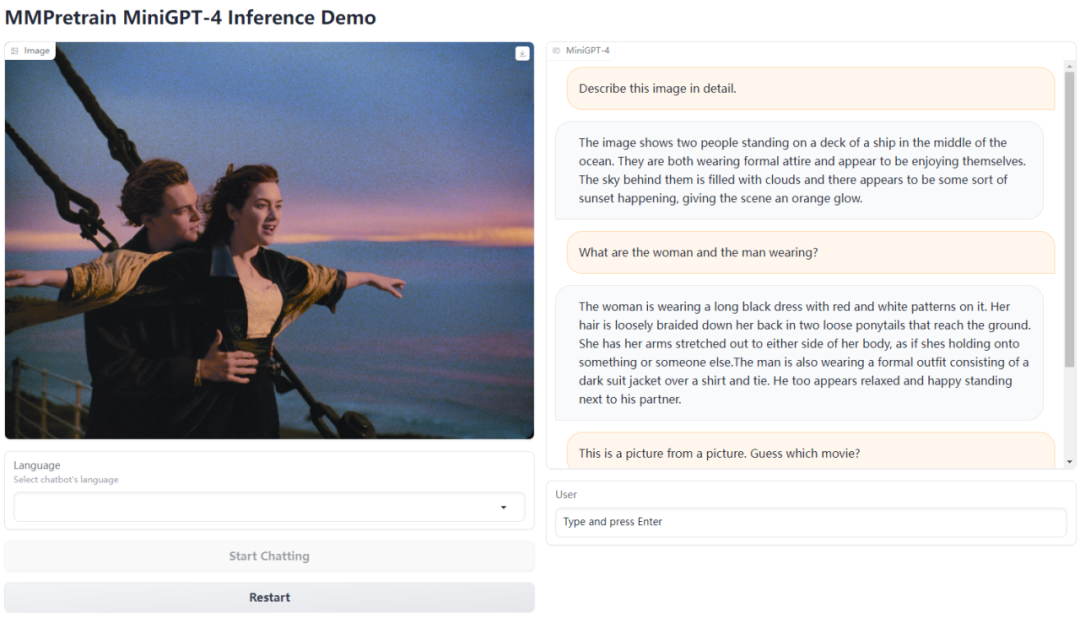

支持 MiniGPT-4 训练及推理,并额外提供中文支持

图文多模态算法 MiniGPT-4

-

支持 DINO 自监督学习

-

支持 CLIP zero-shot 分类

MMPose

-

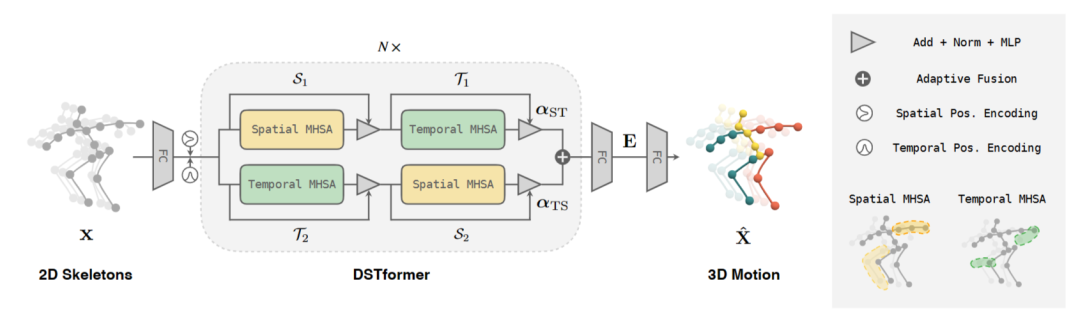

支持 MotionBERT、DWPose、YOLOX-Pose、InterNet 算法的训练,支持 EDPose、Uniformer、Associate Embedding 算法推理

-

支持 Ubody、InterHand2.6M、300W-LP 数据集

-

支持 BadCase 可视化分析、多数据集评测、关键点可见性预测

-

发布 RTMPose 系列全身姿态估计模型 RTMW 的 alpha 版本,精度相比于 SOTA 方案有 3.7 AP 提升,算法当前还在不断迭代优化中,欢迎用户探索和试用

3D 姿态估计算法 MotionBERT(ICCV 23)

MMAction2

-

支持了 VindLU 视频-语言多模态训练

-

支持了 Dense Regression Network, 一种Video Grounding 方法

-

支持了 ASFormer,一种用于动作分割的 transformer

MMagic

-

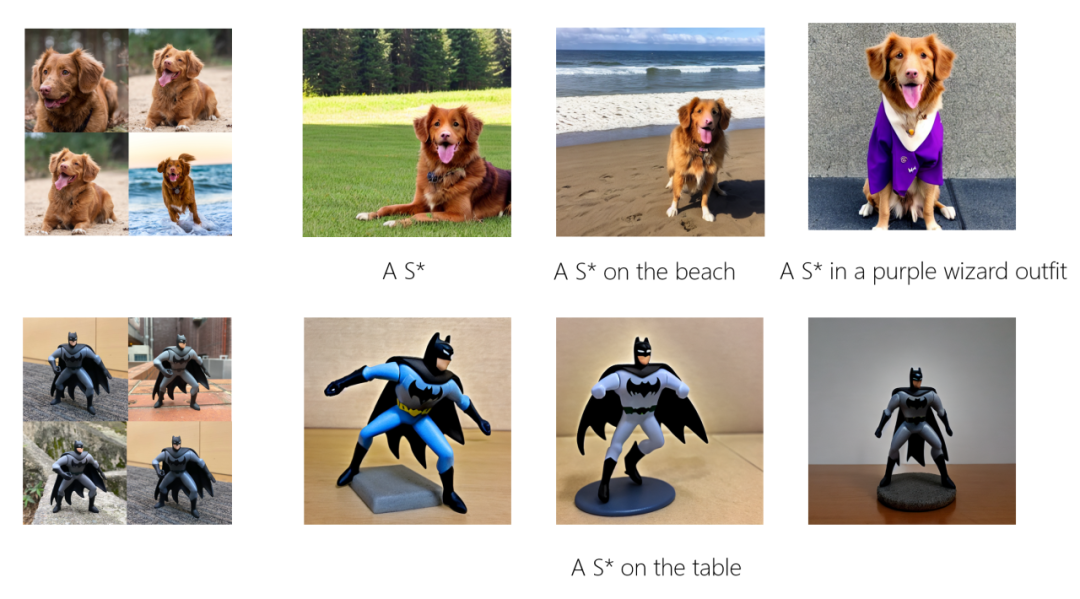

支持了新算法 ViCo, 一种新的 SD personalization 方法

MMagic 支持扩散模型个性化生成算法 ViCo

-

支持了新算法 AnimateDiff, 一种流行的文本转动画方法

AnimateDiff,从文本生成动画

-

支持了新算法 SDXL

-

支持了基于 MMagic 实现的 DragGAN

-

支持了新算法 FastComposer

MMDeploy

-

支持 DINO 等 DETR 系列检测模型的部署

-

支持 Mask2Former 等全景分割模型的部署

-

升级 Docker 镜像和预编译包至 cuda=11.8, tensorrt=8.6.1, onnxruntime=1.15.1

03

社区组织与活动回顾

贡献组织 MMSIG

MMSIG 社区在第三季度不断壮大和完善,认证 40 余位社区 Committer 和 Active Contributor, 举办贡献者线下沙龙和 10 余次线上分享圆桌会。目前 OpenMMLab 贡献者总数已超过 2000 人,吸引来自清北交复等顶尖高校、抖音阿里等头部互联网企业超过 200 位贡献者。社区正在不断丰富活动奖池和激励机制,为社区成员提供更多升级福利,敬请期待!

OpenMMLab 线下沙龙

8 月 19 日,由 OpenMMLab 社区举办的贡献者线下沙龙在上海徐汇西岸智塔圆满举办,吸引来自全国各地的 50 多位社区开发者。活动期间,OpenMMLab 算法研究员和核心开发者现场分享最新的研究进展和未来规划,更有社区开发者分享自己的贡献经历和个人成长的故事。未来 OpenMMLab 会创造更多合作和交流的机会,期待有更多贡献者参与到我们的线下活动中来!

贡献者新动态

经过 3 个月紧锣密鼓的开发, 12 名同学在 OpenMMLab 夏令营中顺利结项,项目成果已随相关 PR 的合并陆续合入社区。每年均有学生通过夏令营深入社区贡献,在社区内进一步成长。

第二期超级视客营发布后,社区响应十分热烈,历经两个多月的时间,共有 111 个任务完成开发,40 余名新同学荣升贡献者。

开源的星星之火,愈燃愈旺,期待有更多开发者加入 OpenMMLab 开源生态,与我们一同前行。

OpenMMLab 技术写作训练营

OpenMMLab 技术写作训练营第 2 期成功举办,共有 200+ 社区成员报名参与了此次训练营。专业老师提供全方位系统性教学,再度献上了一场技术写作盛宴,学员们围绕着 AI、计算机视觉、学习、职场等众多主题展开写作实践,参与者纷纷表示“收获颇丰”,更有佳作在 OpenMMLab 官方渠道亮相,受到读者们的喜爱!

第四季度活动预告

【1024 AI 小故事创作活动】已在火热进行中,欢迎大家参加!除此之外,我们还将举办 AI 实战营第 3 期、大模型专题直播等活动,敬请期待哦!

最后,感谢社区小伙伴们一直以来的支持和关注,OpenMMLab 的成长和发展,离不开每一个小伙伴的支持和贡献,谢谢大家!

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง