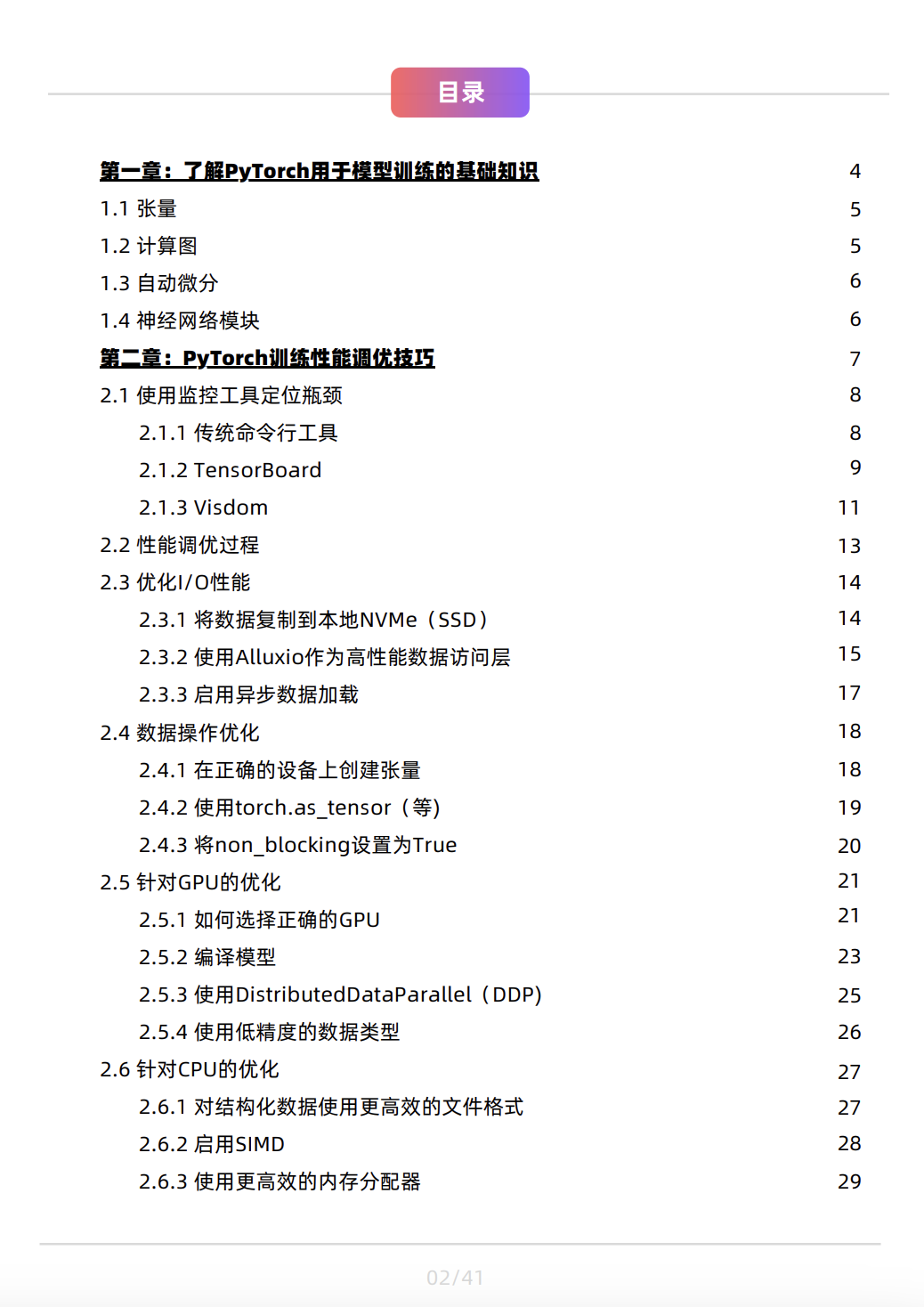

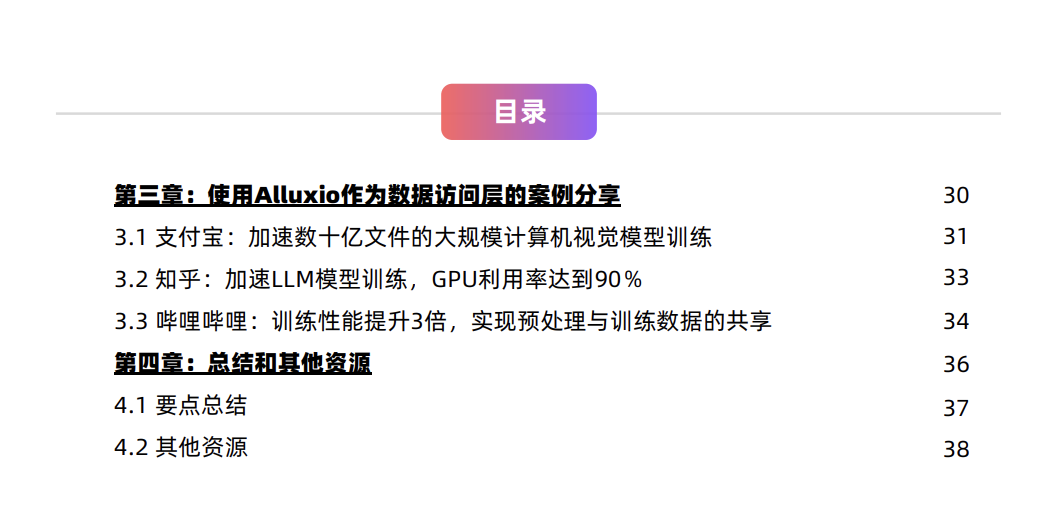

相比普通的分布式训练,大规模训练技术考虑的问题更加复杂。 首先,面对单卡无法装载的大模型,如何利用多卡来突破显存瓶颈是个问题; 其次,大规模训练会用到大量的计算资源,大量计算资源间如何通信、协作是另一个难题; 最后,如何 balance 各类层出不穷的大规模训练技术,使得众多技术形成一个完整高效的训练方案,更是一大学问。针对企业/机构进行模型训练时效率低、成本高、可靠性低,可扩展性差等诸多难题,Alluxio推出了第四期宝典《PyTorch模型训练性能调优宝典》,本电子书是解决PyTorch训练性能和效率问题的首选宝典。资料目录:

扫码即可免费下载

本宝典中介绍的技术适用于对PyTorch的基础设施及其使用的资源进行调优。这些调优技巧适用于所有模型算法,包括CNNs、RNNs、GANs、transformers(如GPT、BERT)等,且适用于所有领域,如计算机视觉、自然语言处理等。

核心要点:📌

✓

PyTorch的基础知识,包括张量、计算图、自动微分以及神经网络模块的工作原理;

✓

影响机器学习流程中模型训练性能的因素;

✓

优化PyTorch模型训练的分步过程;

✓

在数据加载、数据操作、GPU处理和CPU处理方面的最佳调优技巧,附有代码示例。通过这些技巧,平均训练epoch时长可缩短至原先的1/5-1/10;

✓

在真实生产环境中使用Alluxio作为数据访问层为模型训练赋能的案例研究。

面向人群:🧐

适用对象包括AI/ML平台工程师、数据平台工程师、后端软件工程师、MLOps工程师、站点可靠性工程师、架构师、机器学习工程师以及任何希望掌握PyTorch性能调优技巧的专业人士。

扫码免费下载

特别感谢!

翻译支持:Roise,熊迪,Polarish,曹明

特别感谢以上4位Alluxio社区志愿者对《PyTorch模型训练性能调优宝典》翻译工作的支持!

鸣谢

”

👇点击“阅读原文”亦可下载

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง