Beyond Words: A Mathematical Framework for Interpreting Large Language Models

J González, A V. Nori

[Microsoft Research]

解读大型语言模型的数学框架

- 提出Hex数学框架来形式化大型语言模型(LLM)中的幻觉、对齐等概念。

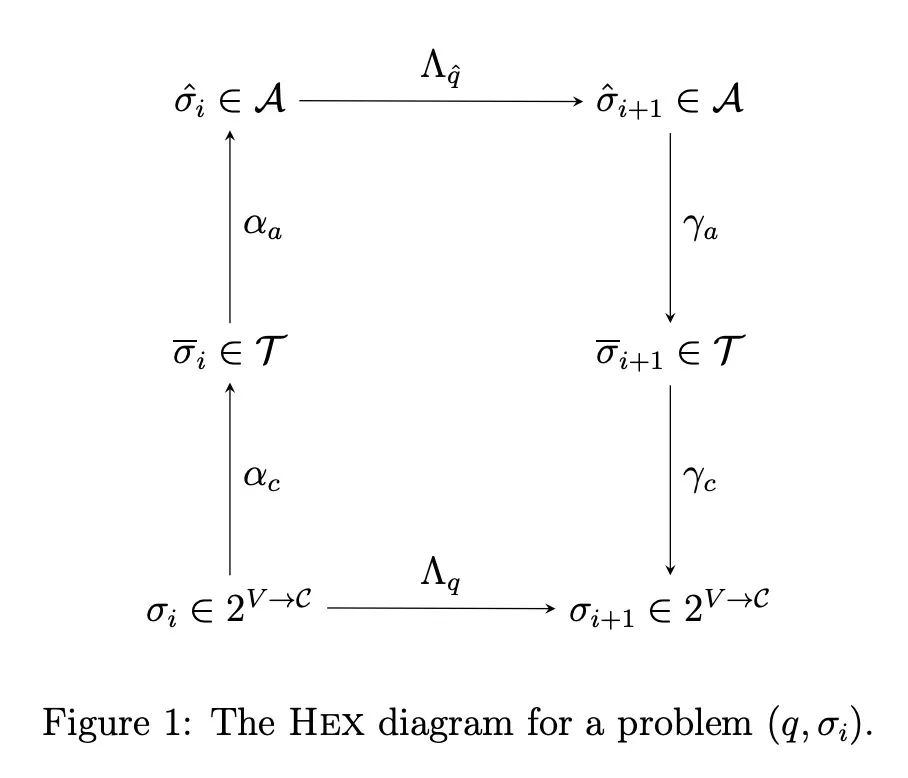

- Hex使用交换图联系LLM中的不同抽象层次和计算,将LLM表示为具有自然语言接口的抽象执行机。

- Hex阐明自我验证和提示编程等方法的假设,显示思维提示并不能保证思维推理。

- 定义基于预期答案距离的指标来评估LLM的输出,允许系统地比较不同LLM的行为。

- 目标是提供共同的术语和推理工具,来探索使用LLM构建可靠、鲁棒AI系统的新研究方向。

动机:目前,大型语言模型(LLM)在生成和理解自然语言文本等复杂信息方面表现出强大的能力,但该领域缺乏一个数学框架来系统地描述、比较和改进LLM。本文提出一个名为Hex的框架,用于澄清LLM研究中的关键术语和概念,并提供一种精确和一致的方式来描述LLM、识别其优势和劣势,并整合新的发现。

方法:使用一个名为Hex的框架来形式化和概括LLM的关键概念,如幻觉、对齐、自我验证和思维链推理。该框架基于交换图,将LLM中不同抽象级别和计算之间的关系进行关联和描述。同时,论文还使用距离度量和兼容性关系对LLM的输出进行形式化和评估。

优势:提供了一个形式化的框架,可以帮助研究人员和实践者探索生成型人工智能的新可能性。该框架能帮助理解现有LLM研究的共识,并为探索新问题和挑战提供基础。通过提供精确的定义和结果,论文对于构建安全、可靠、公平和强大的生成型人工智能系统的讨论具有重要意义,尤其是在医疗保健和软件工程等领域。

提出一个名为Hex的数学框架,用于形式化和概括大型语言模型(LLM)的关键概念,帮助研究人员和实践者探索生成型人工智能的新可能性,推动构建安全、可靠、公平和强大的生成型人工智能系统的讨论。

https://arxiv.org/abs/2311.03033

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง