编译 | 曾全晨

审稿 | 王建民

今天为大家介绍的是来自James Zou 团队的一篇论文。公开可用的医学图像缺乏注释,成为计算研究和教育创新的主要障碍。与此同时,许多医生在医学Twitter等公共论坛上分享了匿名化的图像和大量知识。在这里,作者利用这些群体平台来策划OpenPath,这是一个包含208,414张病理图像与自然语言描述配对的大型数据集。通过开发病理语言-图像预训练(PLIP)来展示这个数据资源的价值,这是一个具有图像和文本理解能力的多模式人工智能,它在OpenPath上进行了训练。

在计算病理学中,人工智能(AI)算法可以帮助区分细胞或组织类型,生成诊断结果,并从常规染色的血红素和伊红染色(H&E)图像中检索相关图像。尽管存在几个高质量的专项机器学习数据集,如Pan-Nuke、Lizard和NuCLS等,但计算病理学的进展受到了需要包含自然语言中良好注释标签的更多样化数据集的限制。与此同时,许多匿名的病理图像在互联网上被分享,特别是在社交媒体上,在这些平台上,临床医生与同事们讨论匿名的医学图像。这些公共数据和讨论提供了重要价值,促进了知识共享和教育目的。特别是,在Twitter社区中,有一个全面的病理学分专业特定的标签集,这些标签是由2016年美国和加拿大病理学会(USCAP)会议的参与者自动生成并系统安排的。这组数据包括常见和罕见的病理学病例化。在这项研究中,作者使用了流行的病理学Twitter标签来收集了243,375张公开的病理图像。作者还扩展了这个集合,从互联网上的其他网站收集了病理数据,经过严格的数据质量过滤,最终创建了一个包含208,414个病理图像-文本对的数据集,称为OpenPath。OpenPath是迄今为止最大的公开可用的病理图像集,带有文本描述的注释。然后,作者利用这个大规模的结构化病理图像-文本对集,开发了一个多功能的病理图像和语言人工智能基础模型。

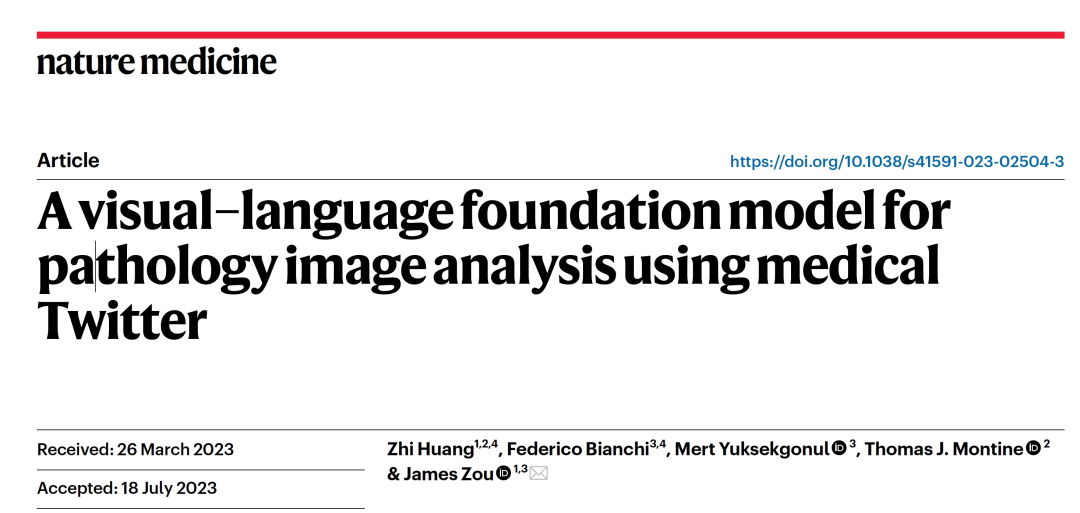

图 1

数据来源

美国病理学和病理学标签项目推荐了32个Twitter病理学专业特定的标签。作者使用这32个标签从2006年3月21日(第一条Twitter帖子的日期)到2022年11月15日检索相关的推文(如图1a所示),以建立迄今为止带有每个图像的自然语言描述的最大的公开病理学数据集:OpenPath。作者在检索数据时遵循了Twitter和其他实体的使用政策和指南。为了确保数据质量,OpenPath遵循了严格的队列包含和排除协议,包括删除转发、敏感推文和非病理图像,以及额外的文本清理(如图1a)。最终的OpenPath数据集(如图1b所示)包括:(1)推文:来自32个病理学专业特定标签(如图1c所示)的116,504个图像-文本对,来自Twitter帖子;(2)回复:来自与推文相关的回复中得到最多赞的回复的59,869个图像-文本对(如图1c所示);以及(3)PathLAION:从互联网和LAION数据集中获取的32,041个额外的图像-文本对。OpenPath中的标题使用中位数17个单词(如图1d)来描述相应图像中的医疗情况。

模型训练

与其他仅基于分类标签训练的监督学习和分割病理模型不同,自然语言文本富含语义和相关知识,这可以进一步增强对图像的理解并促进多个下游应用。在研究中,作者使用对比学习将预训练的对比语言-图像预训练(CLIP)模型在OpenPath上进行微调。在训练阶段,PLIP模型从文本编码器和图像编码器生成两个嵌入向量(如图1e所示)。然后,通过对比学习(如图1f所示和方法中所述),这些向量被优化为每对图像和文本向量之间相似,并且在非配对图像和文本之间不相似。PLIP可以处理广泛范围内的多种类型推断,而不需要显式训练。

PLIP泛化能力

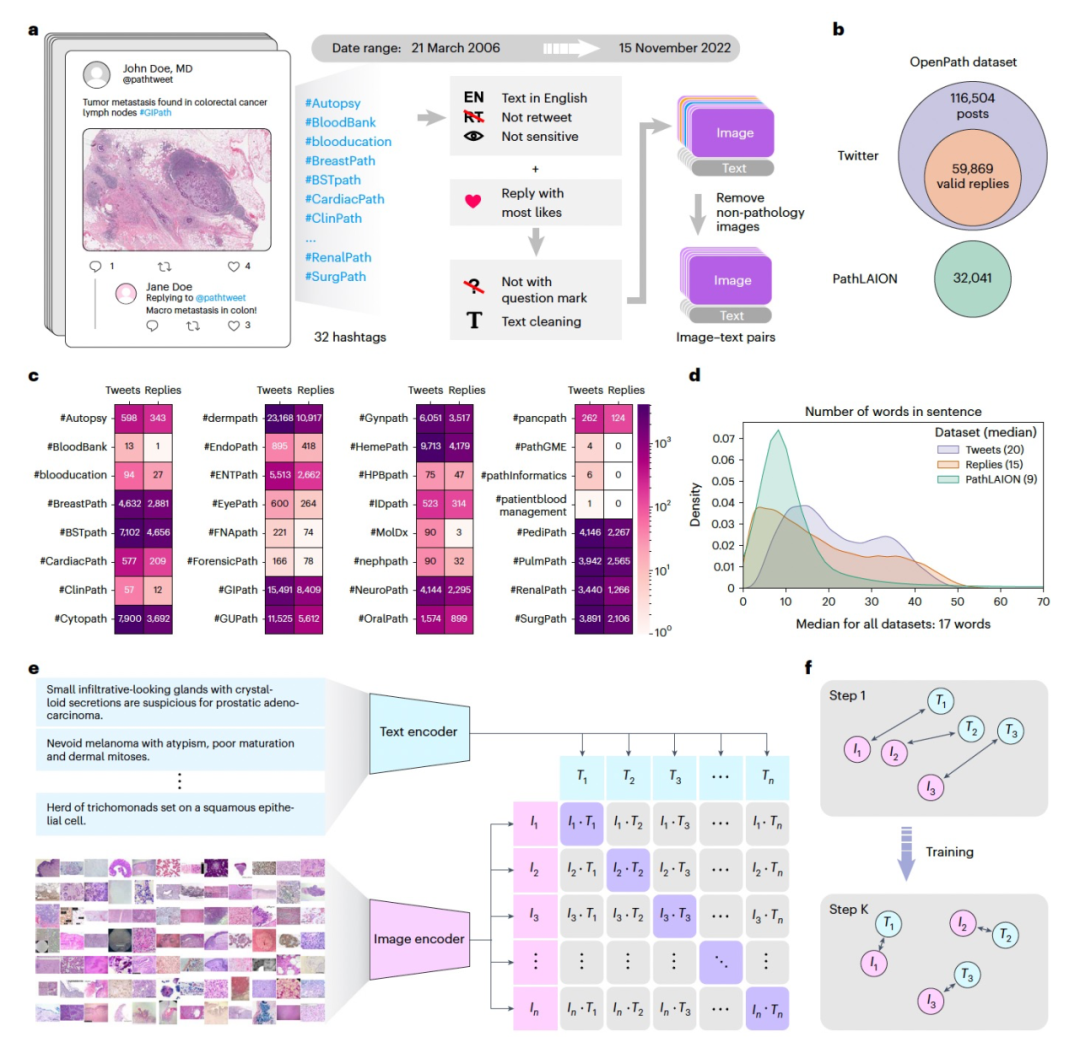

图 2

作者对PLIP的零样本能力进行了系统评估,该能力使其能够在大规模范围内学习新的类别,无需重新训练(图2a)。评估是在四个外部验证数据集上进行的:(1)Kather结肠数据集,包含九种不同的组织类型;(2)PanNuke数据集(良性和恶性);(3)DigestPath数据集(良性和恶性);(4)WSSS4LUAD数据集(肿瘤和正常)(图2b)。在这些数据集上,作者通过将标签转换为句子来评估PLIP。通过评估加权F1分数,这是综合考虑了精度和召回率的度量,同时考虑了类别不平衡性,分析显示,PLIP始终优于基线CLIP模型(图2c)。例如,在Kather结肠数据集(九个类别)上,PLIP实现了F1 = 0.565(95%置信区间(CI)= 0.559–0.572)。在PanNuke数据集(良性与恶性)中,PLIP实现了F1 = 0.656(95% CI = 0.639–0.667)。在DigestPath数据集(良性与恶性)中,PLIP实现了F1 = 0.832(95% CI = 0.829–0.834)。在WSSS4LUAD(肿瘤与正常)中,PLIP实现了F1 = 0.734(95% CI = 0.723–0.745)。此外,图2d显示了Kather结肠数据集的混淆矩阵,其中包括地面真实标注和预测标注。与其他模型相比PLIP对于这个复杂的任务表现出了合理的零样本学习能力,可以准确区分多种关键组织类型,包括脂肪组织(ADI)、背景(BACK)、结肠癌上皮和淋巴细胞(LYMs)。然而,在处理粘液(MUC)和碎片(DEB)等其他组织类型时,可能会面临挑战。这个观察可能是因为MUC、DEB和平滑肌(MUS)有时被认为是癌相关的间质(STR)所致。此外对19个不同器官中的良性与恶性样本进行了更深入的零样本性能调查,这些样本来自PanNuke数据集。与图2e中的基线CLIP相比,作者发现PLIP在19个器官中的14个上取得了更优越的加权F1分数(补充表3)。其中,有七个亚专业领域(肾上腺、食管、肝脏、卵巢、胃、睾丸和子宫)的F1分数较高(>0.8),而基线CLIP仅在F1 = 0.3–0.6之间。然而,在一些器官的样本中观察到类别不平衡,例如肾脏、肺和前列腺,这可能导致PLIP的表现较差。

PLIP提高了图像表征能力

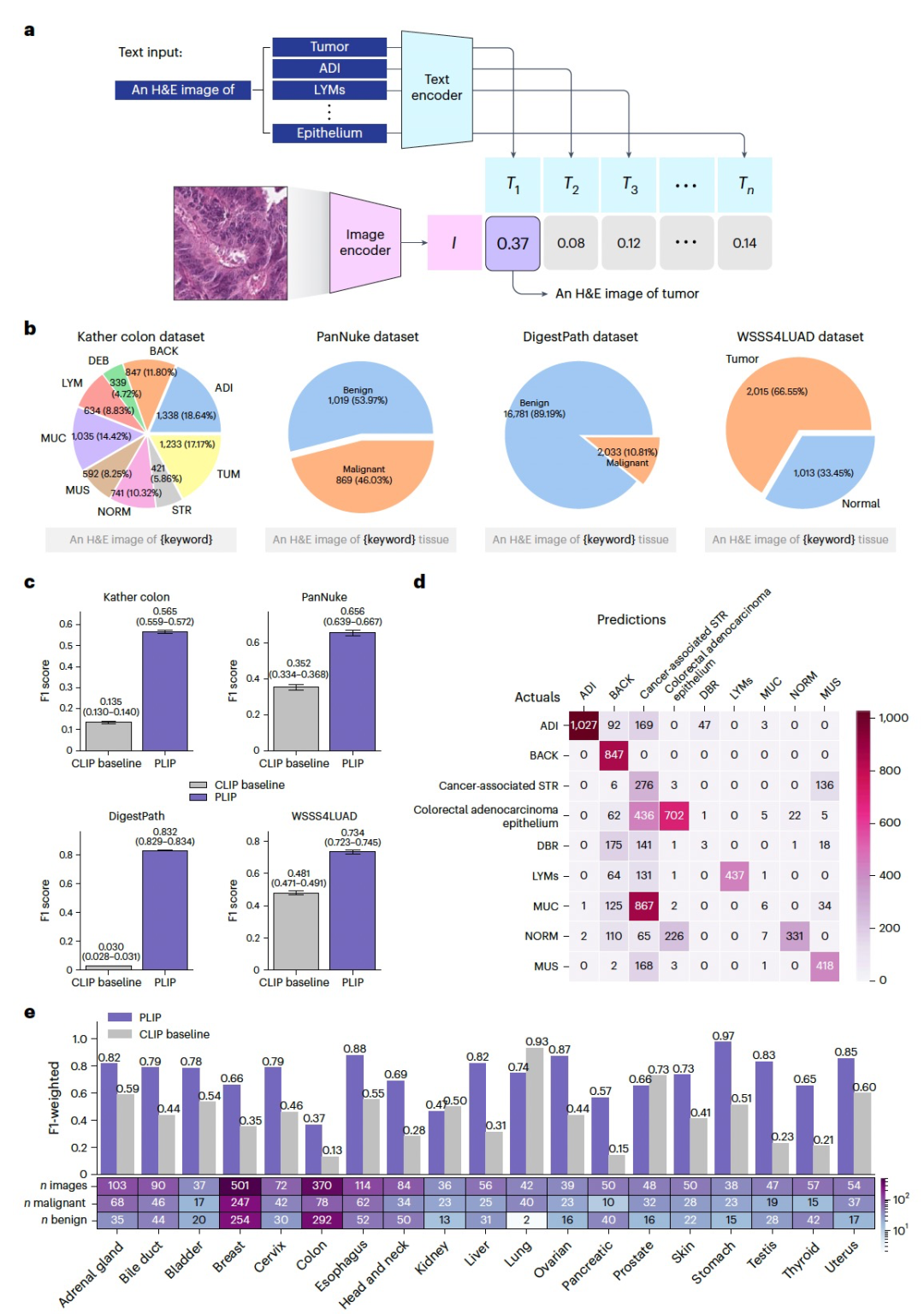

图 3

为了更深入地了解PLIP图像编码器的能力,作者使用了四个不同的测试数据集(Kather结肠、PanNuke、DigestPath和WSSS4LUAD)来评估图像表示的能力。首先,通过PLIP图像编码器计算图像嵌入向量,然后进行降维(图3a-d)。在没有在这些数据集上进行训练的情况下,可以发现PLIP仍然能够有效地区分Kather结肠数据集中的不同组织亚型(图3a)。与其他基线模型的性能进行比较,PLIP有效地区分了正常结肠黏膜(NORM)和结肠腺癌上皮(TUM),尽管它们都具有相似的形态和纹理模式。在PanNuke数据集中,PLIP揭示了有趣的器官特异性分离,结肠子集形成了两个相对清晰的子簇,其中一个富集了恶性组织图像(图3b)。

作者在四个不同数据集(Kather、PanNuke、DigestPath和WSSS4LUAD;图2b)的图像嵌入向量上训练了一个简单的线性分类器(图3e),并将其与两个基线模型进行了比较:原始CLIP模型的图像编码器和深度神经网络的多任务预训练(MuDiPath)。通过考虑自然语言中的文本描述, PLIP模型与其他模型有所不同,并在所有四个测试数据集上展现出卓越的性能(平均F1:PLIP = 0.891,CLIP = 0.813,MuDiPath = 0.866;图3f)。在有九个类别的Kather结肠数据集中,PLIP实现了F1 = 0.877,超越了第二好的模型MuDiPath(F1 = 0.825),提高了6.30%(P = 9.4 × 10−12)。在二分类的PanNuke数据集中,PLIP实现了F1 = 0.902,在所有比较的模型中得分最高。在DigestPath数据集中,与第二好的模型相比,PLIP的F1 = 0.856提高了3.5%(P = 6.2 × 10−4)。最后,在WSSS4LUAD数据集中,PLIP实现了最高的F1 = 0.927。

结论

计算机视觉和自然语言处理领域机器学习的快速进展依赖于标注数据。与其他领域不同,标注病理图像非常昂贵且繁琐,需要高水平的领域专业知识和多年的专业教育。这阻碍了人工智能在理解和解释组织病理学特征、解读解剖学和疾病异质性,以及识别不同疾病亚型以实现精准医学方面的发展。社交媒体上分享的大量数据为医学人工智能提供了宝贵而未被充分利用的机会。特别是Twitter已成为病理学家的活跃社区。通过筛选这些公开共享的知识,图像-文本配对的OpenPath数据集可以帮助人工智能理解全局和局部的病理学特征。在这项研究中,作者基于OpenPath开发了PLIP,通过微调视觉-语言表示和学习的最新模型。与数字病理学中的经典机器学习方法不同,PLIP模型是一个通用解决方案,可以应用于广泛的任务,包括适应新数据并在给定任何图像输入的情况下进行零样本预测。

参考资料

Huang, Z., Bianchi, F., Yuksekgonul, M. et al. A visual–language foundation model for pathology image analysis using medical Twitter. Nat Med (2023).

https://doi.org/10.1038/s41591-023-02504-3

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง