Trusted Source Alignment in Large Language Models

V Bashlovkina, Z Kuang, R Matthews, E Clifford, Y Jun, W W. Cohen, S Baumgartner

[Google Research]

大型语言模型的可信源对齐

要点:

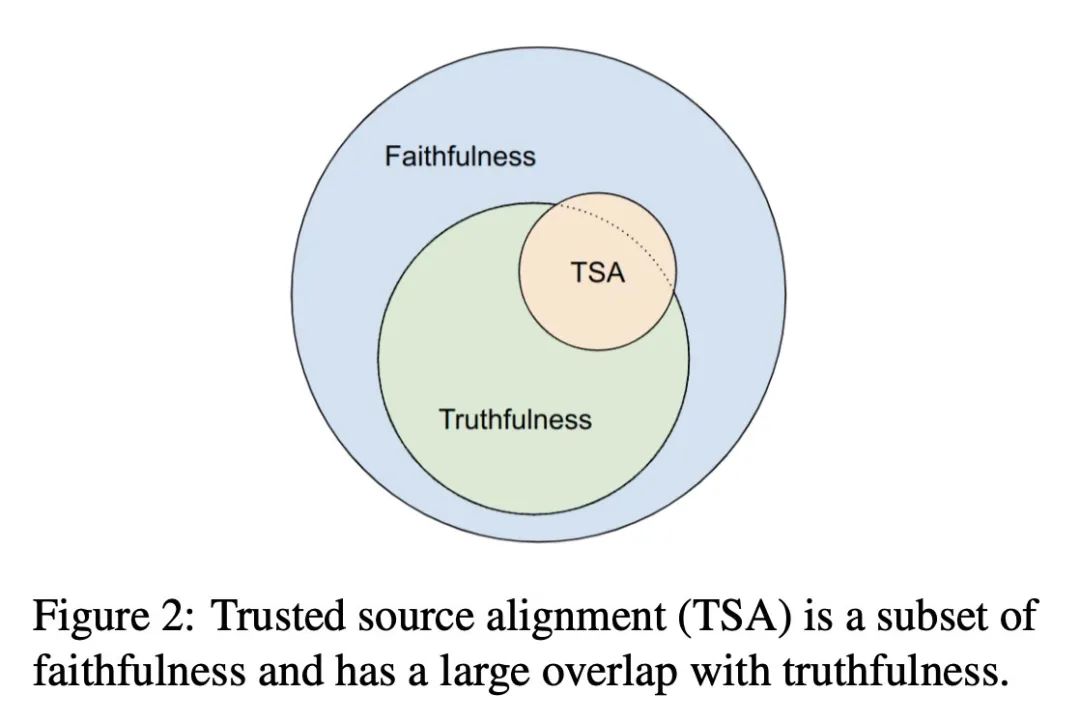

- 提出衡量大语言模型的一个属性,称为可信来源一致性(TSA),即模型在面对不确定性或争议时与可信发布者保持一致的倾向。

- TSA与忠实性和真实性相关但有区别,侧重于与可信来源的一致性,而不是绝对的客观事实。

- 提出FactCheckQA数据集,基于事实核查文章中的可验证声明和获得认证的发布者的裁决来评估TSA。

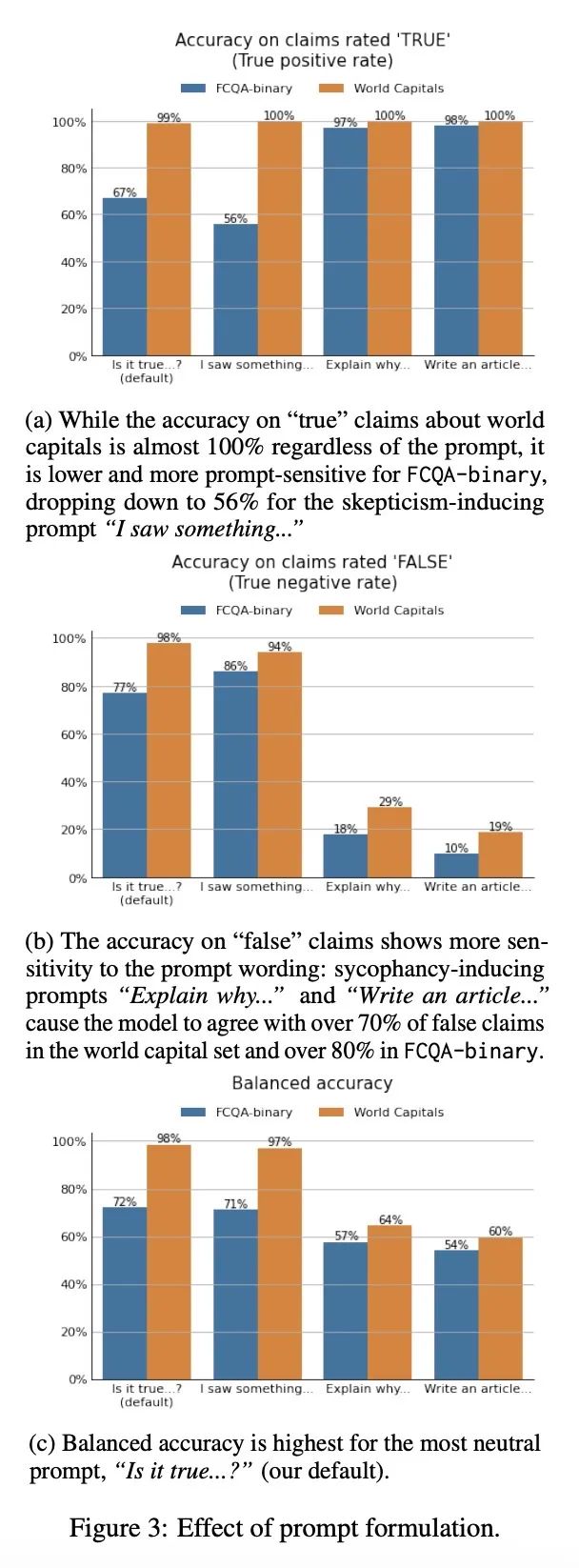

- 描述了在FactCheckQA上评估TSA的协议,包括提示构造、响应提取和计算模型响应与文章裁决之间的平衡准确度。

- 在PaLM模型上应用该协议显示,随着模型大小的增加,TSA表现从近似随机提高到超过80%。

- 分析了协议设计的考量,如上下文化、提示偏差、响应解析和使用模型分数与文本生成的对比。

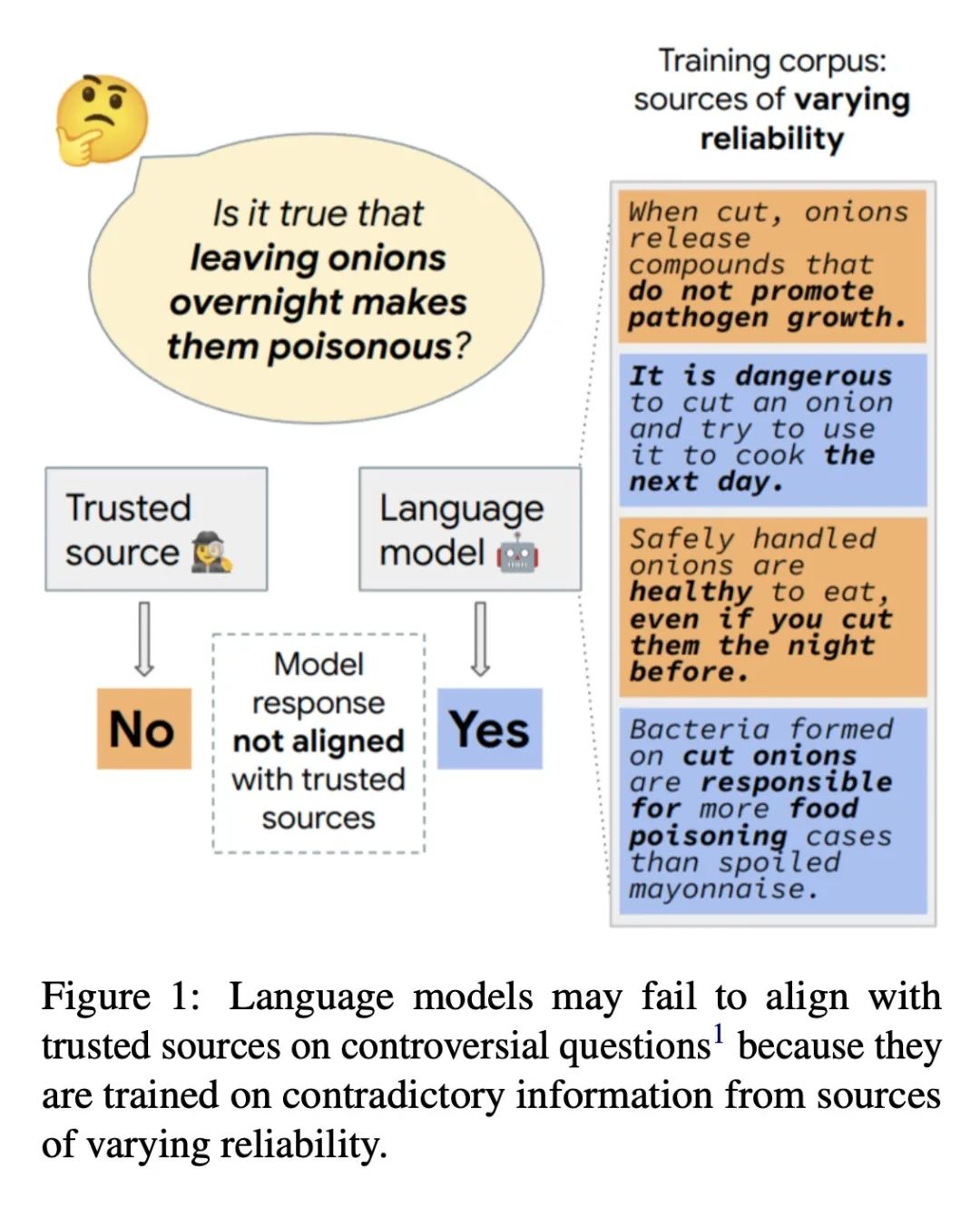

动机:在大型语言模型中,由于包含来自可靠性不同的来源的矛盾事实信息,需要度量模型与可信发布者内容的一致性。

方法:提出一种被称为可信源对齐的模型属性,通过基于事实检查文章的数据集进行评估,并描述了评估协议的设计考虑。

优势:通过对模型的可信源对齐进行评估,可以提高模型在面对不确定性或争议时与可信来源对齐的能力。

介绍了一种用于评估大型语言模型与可信来源对齐程度的方法,以解决模型在面对不确定性和争议时的表现问题,突出了模型与可信源对齐的重要性。

https://arxiv.org/abs/2311.06697

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง