新智元报道

编辑:LRS

【新智元导读】ACM MM 2023上中国团队获三项大奖,多媒体领域再获新突破。

近日,2023 ACM MultiMedia会议落下帷幕,中国大陆团队在这次国际会议上收获满满。

其中,浙江大学团队、南京航空航天大学团队和清华大学团队的成果在3072篇投稿的论文(录用902篇,录用率为29.3%)中脱颖而出,分别获得最佳论文奖(Best Paper Award)、荣誉提名奖(Honorable Mention Award)和创新创意奖(Brave New Idea Award)!

ACM 国际多媒体会议(ACM International Conference on Multimedia)是计算机科学领域中多媒体领域的首屈一指的国际会议。

会议专注于推进许多媒体的研究和应用,其研讨范围涵盖了多个新兴领域,包括但不限于触觉、视频、VR/AR、音频、语音、音乐、传感器和社交数据等。

荣誉提名奖

论文链接:https://dl.acm.org/doi/10.1145/3581783.3611872

该论文针对传统动作检测方法无法得到精确时序边界的问题,提出了一种具有普适性和易用性的定位优化框架,将定位细化过程与传统动作检测方法进行解耦,在每个时间点生成多尺度的定位细化信息,并且提出一种偏移聚焦策略,以由粗到精的方式逐步增强模型的检测效果。

该方法不仅可与任意动作检测模型无缝集成,而且能在保持较低计算开销的情况下显著提升动作边界定位的精度。

创新创意奖

论文链接:https://arxiv.org/abs/2308.05920

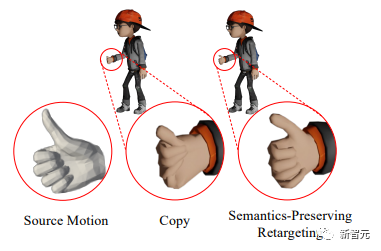

人类的手是「非语言交流」的主要手段,可以在各种情况下传达复杂的语义。

由于个体对手部运动的高度敏感性,手部运动中的即使是微小的错误也会显著影响用户体验;而真实场景下的应用往往包括多个人物的不同手部手部形状,如何在不同人物间保持手部动作的复杂语义是很重要的。

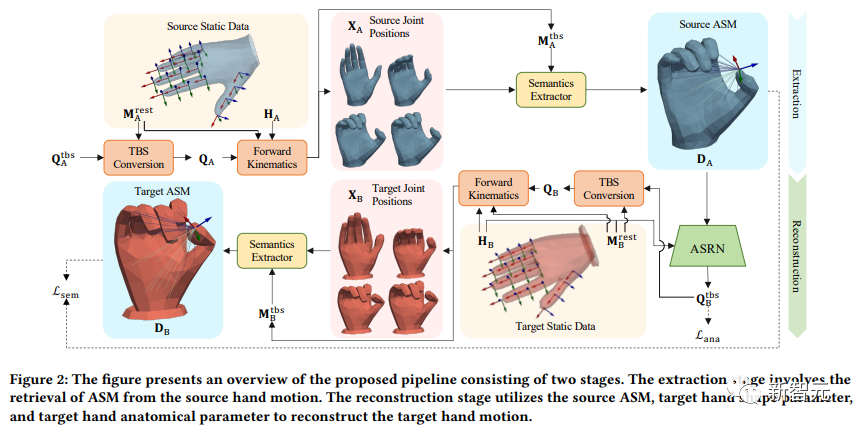

这篇论文主要解决的问题是在不同人物的手部模型间对运动语义进行迁移,提出了一种新的基于解剖结构的语义矩阵(ASM)对手部动作的语义进行编码。

ASM对手掌和其他关节相对于相应关节的局部帧的位置进行量化,从而实现手部运动的精确重定向。

随后通过采用基于解剖结构的语义重建网络(ASRN)获得从源ASM到目标手关节旋转的映射函数。

研究人员在Mixamo和InterHand2.6M数据集上使用半监督学习策略训练ASRN,在域内和跨域手部运动重定向任务中对模型进行评估:定性和定量的结果表明,文中提出的ASRN相比其他sota模型也具有显著优越性。

最佳论文奖

论文链接:https://arxiv.org/abs/2309.09709

任务背景与挑战

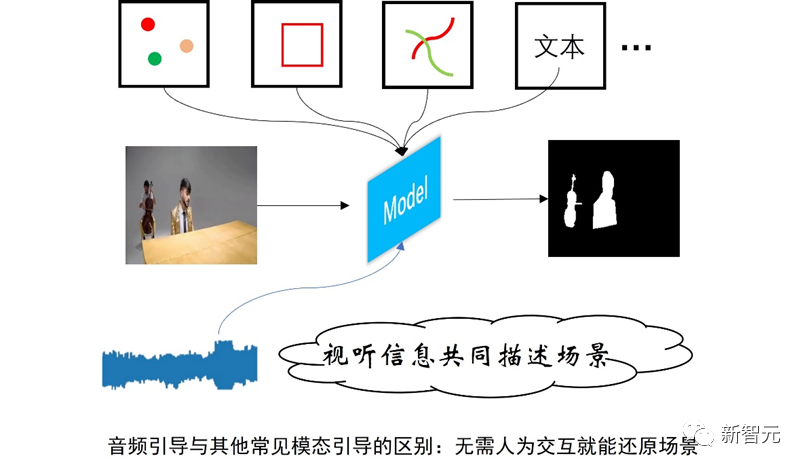

众所周知,由跨模态信息引导的视频分割已经在很多应用领域大展身手,尤其是用点击、外接框、笔画线以及文字来做引导的任务和模型。

这些引导模态有一个共同的特点,就是需要人去进行交互,并提供人为的判断和指示。

与上面这些模态不同,音频是一种特殊的模态,其特殊之处在于,音频常常是与视频共生的,日常生活中的很多视频大多是同时伴随着声音和视觉画面。

并且,许多心理学和大脑认知研究表明,视觉和听觉是人类感知世界最重要的两种感官。

因此,使用音频来引导视频的分割往往能更好地还原当时的场景。

尽管音频引导的视频分割任务非常重要,但是现有的对于这个领域的研究仍然是不充分的,主要是因为,与常见的文本引导的任务相比,音频引导的视频分割存在以下两个难点:

1. 音频的语义模糊性。由于一些物体的声音比较相似,比如猫叫声和小孩的哭声,当声音相似的两个物体同时出现在画面中时,可能难以根据这个声音来确定具体指代的目标物体。

2. 建立音频与像素级预测的关联。此任务要求将像素级的信息与音频在时间和空间维度上进行一一对应。

解决方案与模型设计

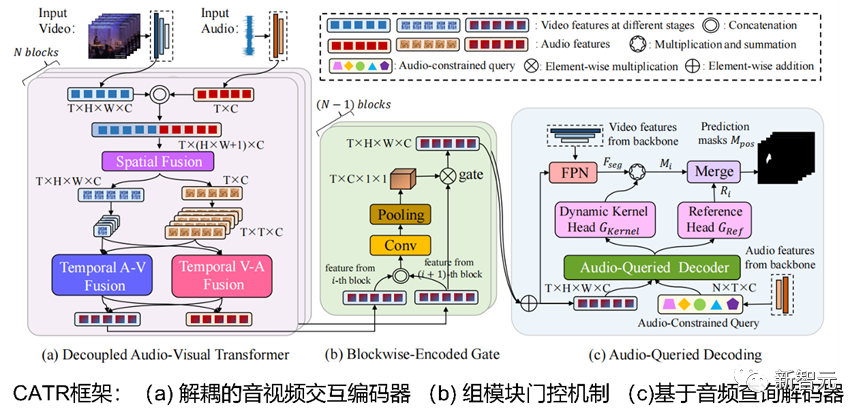

为了解决上述难点,论文中提出了一种基于组合依赖和音频查询的视频分割框架(CATR)。

1. 解耦的音视频交互编码器

在音视频编码阶段,以前的方法只考虑了视频的时序特征,以及音频与视频的交互特征,这样的做法是非常粗粒度的,不利于音频特征与视频特征的深度交互。

因此,论文中提出了一种更细粒度的音视频特征融合的模块,该模块充分刻画了多种场景的需求。

当发声物体从远处进入画面时,属于「先闻其声」,此时会利用该声音来辅助后续的物体分割。

当视频画面中的物体没有发出声音时,属于「不见其声」,此时会加强当前视频帧中的物体与静音片段的联系,避免模型错误地分割出不发声物体。

总体来说,该模块将音频特征和视频特征分别从时间维度和空间维度进行多种组合化的交互,通过堆叠这个模块,可以在节约内存的基础上对音视频进行更细粒度的交互。

2. 组模块门控机制

现有的方法通常仅采用最后一个编码器块的输出特征作为解码器的输入,由于每个编码器块的输出特征都包含了不同程度的多模态交互信息。

因此,论文中设计了门控机制,充分利用每个编码器块抽取的视频特征,这样的做法可以平衡多个编码器块中交互特征的贡献。

3. 基于音频查询的解码器

以前的方法在有效捕获像素级细节和为跨模态推理提供约束信息方面存在不足,时常造成错误地定位与分割目标物体。

因此,论文中提出了基于音频查询的解码模块,该模块在解码阶段引入了音频的约束。

具体来说,论文设计了一组可学习的查询头,并使用动态解码核为每个查询头生成相应的分割掩码,最后从多个查询头中匹配出最佳的分割结果。总体来说,论文设计的基于音频查询的解码器通过将音频信号纳入解码过程来增强物体识别,从而更准确地定位到目标分割对象。

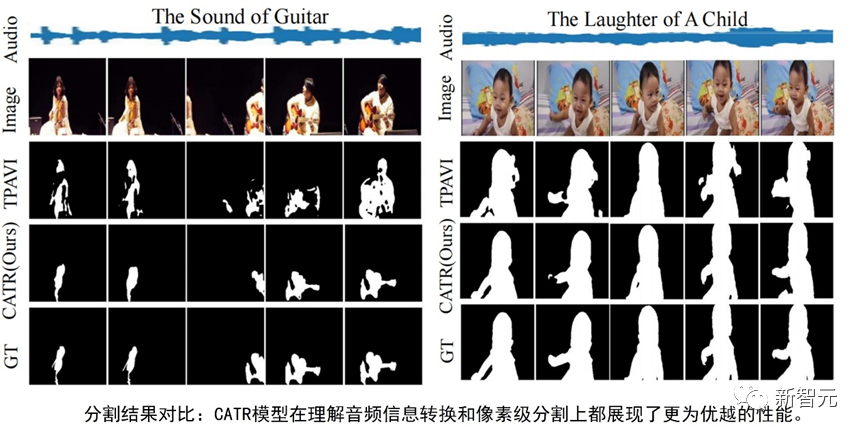

实验结果

该模型在三个主流的数据集上进行了充分的定性和定量的实验,并达到了最佳性能。

其中,模型在多源音频的数据集上提升最为显著(在Jaccard index指标上提升了4.9个点,在F-score指标上提升了7.5个点)。

这是因为多源音频数据集中包含了多个种类的音频,音频种类越多,根据音频去定位发声物体就更困难,而CATR中提出的基于音频查询的解码器可以更好地引入音频约束信息,从而准确地定位到多个发声物体。

该模型的卓越性能使得用音频引导视频分割为实际应用落地展现了更多的可能,包括在实时监控录像中提供监察反馈、在增强现实的应用中提供更生动的体验感等。

主要作者介绍

李可欣,本文第一作者。浙江大学2022级在读博士生,导师为肖俊教授。主要研究方向为跨媒体视频理解和交互式视频分割。

杨宗鑫,本文通讯作者。浙江大学计算机学院博士后研究员。主要研究方向为视频理解、视觉内容生成、三维视觉等。

杨易教授,浙江大学求是讲席教授、博士生导师。主要研究领域为人工智能、计算机视觉、多媒体大数据分析、自然语言处理等。

肖俊教授,浙江大学教授、博士生导师。主要研究领域为视觉内容分析与理解,包括视觉注意力机制、图像描述、视觉问答、视觉场景图等。

参考资料:https://www.acmmm2023.org/

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง