关键词:深度学习,神经标度律,大语言模型,图神经网络

论文题目:Neural scaling of deep chemical models期刊来源:Nature Machine Intelligence斑图地址:https://pattern.swarma.org/paper/ebba33f4-71f7-11ee-a391-0242ac17000d论文地址:https://www.nature.com/articles/s42256-023-00740-3

论文题目:Neural scaling of deep chemical models期刊来源:Nature Machine Intelligence斑图地址:https://pattern.swarma.org/paper/ebba33f4-71f7-11ee-a391-0242ac17000d论文地址:https://www.nature.com/articles/s42256-023-00740-3

大规模,无论是从数据可用性还是计算而言,都为深度学习的关键应用领域(如自然语言处理和计算机视觉)带来了重大突破。有最新证据表明,规模可能是科学深度学习的关键因素,但科学领域中物理先验的重要性使得扩展策略和效益变得不确定。

这项发表于 Nature Machine Intelligence 的最新研究通过在大型化学模型中改变模型和数据集的大小,跨多个数量级考察了神经标度行为(neural-scaling behaviour),研究了在多达一千万数据点的数据集上进行预训练的、具有超过十亿参数的模型。

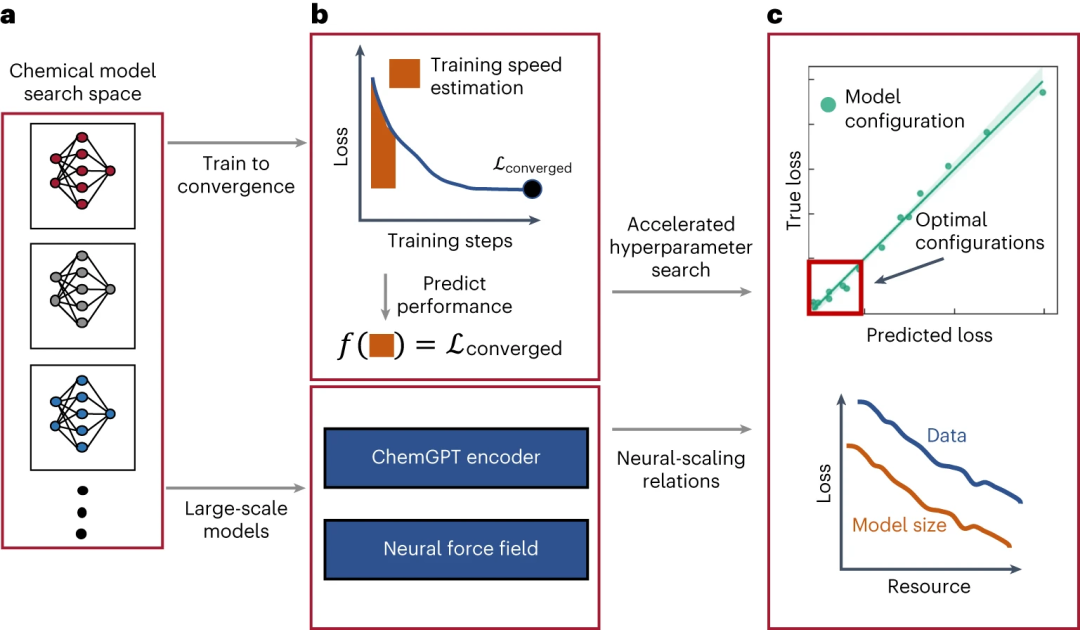

研究者考察了用于生成化学和用于机器学习原子间势的大语言模型和图神经网络,并研究了物理先验与规模之间的相互作用,并发现化学语言模型的经验神经标度关系,其中最大数据集的缩放指数为0.17,对于等变图神经网络原子间势,缩放指数为0.26 。 图1. 在深度化学模型中发现神经标度律的流程概览。

图1. 在深度化学模型中发现神经标度律的流程概览。

编译|梁金

AI+Science 读书会

详情请见:人工智能和科学发现相互赋能的新范式:AI+Science 读书会启动

推荐阅读

1. 大模型热潮之后的未来新方向:图神经网络与组合优化 | 文献汇总2. 一作解读:深度学习中的Neural Scaling Law (神经标度律)和对AI+Science的启发3. 图神经网络概述4. 张江:第三代人工智能技术基础——从可微分编程到因果推理 | 集智学园全新课程5. 成为集智VIP,解锁全站课程/读书会6. 加入集智,一起复杂!

点击“阅读原文”,报名读书会

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง