图注:Illustration: Justin Jay Wang × DALL·E

导语

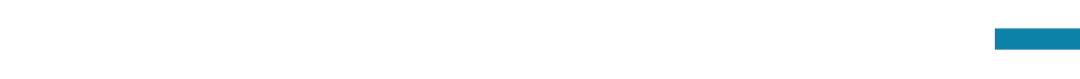

近期,OpenAI的风波掀起对于AGI(通用人工智能)安全及其实现路径的讨论。在开发AGI的过程中,如何确保其目标与人类的价值观和目标“对齐”?如何防止“对齐”过程中出现不可预见的副作用?当AGI任务逐渐超越人类已有知识范畴,如何维持和提升AGI的泛化能力?如何当AGI超越人类智能后,我们如何保证它的行为仍然符合人类社会的利益?如何通过技术手段,及时、有效、前瞻性地治理AGI?一系列问题亟待回应。

本周,我们邀请了三位嘉宾从不同角度为我们解析AGI安全与治理领域的关键问题。邱天异(北京大学计算机图灵班)将基于《AI Alignment: A Comprehensive Survey》,深入探讨AI对齐的研究方向和目标,为我们提供实现AGI安全的重要途径;钟瑞麒(加州伯克利分校博士候选人)将分享如何利用可扩展监督解决对齐难题,以提高AI的安全性和可控性;段雅文(安远AI高级技术经理,剑桥大学机器学习硕士)则关注前沿大模型的风险、安全与治理,为建立负责任和包容的全球人工智能安全和治理体系提供思路。

本次活动由集智俱乐部的AI+Science社区、AGI社区联合安远AI联合发起,希望为大家提供一个全面了解AGI安全的契机,共同关注并探讨如何确保AGI的安全发展这一迫切议题。线上和线下均可免费报名,期待大家的参与!

邱天异:AI对齐有哪些研究方向、研究目标?

AI的发展使许多现有或潜在的安全问题浮出水面,而AI对齐(即AI alignment,“让AI的行为符合人类意图和人类价值观”)是解决这些安全问题的重要途径之一。然而,AI对齐到底包含哪些研究方向、有哪些研究目标,围绕这一问题存在诸多困惑。这次报告将基于《AI Alignment: A Comprehensive Survey》这份综述,试着解答这一问题,并给出AI对齐领域从动机到问题到方法的概览。(详情请见:四万字详解AI对齐:北大联合多高校团队发布对齐全面性综述)

大纲:

- AI对齐的定义和动机

- 围绕AI对齐的常见困惑

- AI对齐当前的主要研究方向和实践内容

- 从反馈学习(Learning from Feedback)

- 在分布偏移下学习(Learning under Distribution Shift)

- 对齐保证(Assurance)

- 治理(Governance)

邱天异是北京大学计算机图灵班的三年级本科生,北大对齐小组 (PKU-Alignment) 成员,在北大PAIR-Lab进行AI对齐研究,关注对齐与道德价值的交叉,并撰写AI Alignment: A Comprehensive Survey,综述主页:www.alignmentsurvey.com。他曾获John Hopcroft奖学金、NOI 2020金牌。

钟瑞麒:如何利用可扩展监督来解决对齐难题?

随着AI不断进步,RLHF可能会逐渐失效,人类评估模型的能力遭遇瓶颈。如何判断可扩展监督正在发挥作用?可扩展监督的目标是什么?在这个报告中,我将介绍两个自然语言处理任务:1)自动在大型文本数据集中找到规律,并用自然语言解释它们;2)使用非程序员在人工智能系统的帮助下对复杂的SQL程序进行标记,并达到与数据库专家相当的准确率。我们帮助人类以高效但低成本的方式间接监督人工智能,并利用它们产生了此前甚至专家都没注意到的发现。

大纲:

-

可扩展监督的定义

-

可扩展监督的技术路线

-

在大型文本数据集中发掘规律

-

非程序员在AI帮助下对复杂SQL程序进行标记

钟瑞麒是加州大学伯克利分校五年级的计算机系博士生,师从Jacob Steinhardt和Dan Klein,他专注于自然语言处理和人工智能对齐(AI alignment)问题的研究。于2019年哥伦比亚大学本科毕业。

钟瑞麒是加州大学伯克利分校五年级的计算机系博士生,师从Jacob Steinhardt和Dan Klein,他专注于自然语言处理和人工智能对齐(AI alignment)问题的研究。于2019年哥伦比亚大学本科毕业。

段雅文:前沿大模型的风险、安全与治理

前沿大模型 (Frontier Large Model) 是“能执行广泛的任务,并达到或超过当前最先进现有模型能力的大规模机器学习模型”,是目前最常见的前沿AI,提供了最多的机遇但也带来了新的风险。AI如何对齐,如何预测和防范AI带来的风险,报告希望可在促进对相关问题的认知与讨论,希望能为建立负责任和包容的全球人工智能安全和治理体系作出贡献。

大纲:

-

一 前沿大模型的趋势预测:技术解读|扩展预测

-

二 前沿大模型的风险分析:风险态度|风险解读

-

三 前沿大模型的安全技术:对齐|监测|鲁棒性|系统性安全

-

四 前沿大模型的治理方案:技术治理|政府监管|国际治理

- 五 总结和展望

段雅文目前在安远AI担任技术项目经理,致力于AI安全技术社区建设。他也是未来生命研究所AI Existential Safety PhD学者,即将就读于剑桥大学机器学习工程博士项目,专注于大模型安全研究。他曾在UC Berkeley的Stuart Russell组和剑桥大学David Krueger实验室进行AI安全和对齐研究,他拥有剑桥大学机器学习硕士学位和香港大学理学士学位。

段雅文目前在安远AI担任技术项目经理,致力于AI安全技术社区建设。他也是未来生命研究所AI Existential Safety PhD学者,即将就读于剑桥大学机器学习工程博士项目,专注于大模型安全研究。他曾在UC Berkeley的Stuart Russell组和剑桥大学David Krueger实验室进行AI安全和对齐研究,他拥有剑桥大学机器学习硕士学位和香港大学理学士学位。

主持人介绍

吉嘉铭是北京大学人工智能学院的一年级在读博士生,导师为杨耀东助理教授,研究方向聚焦于AI Safety 和 Safety Alignment,目前他专注于大语言模型的安全对齐。个人主页: www.jijiaming.com

吉嘉铭是北京大学人工智能学院的一年级在读博士生,导师为杨耀东助理教授,研究方向聚焦于AI Safety 和 Safety Alignment,目前他专注于大语言模型的安全对齐。个人主页: www.jijiaming.com

讨论问题列表

【前沿AI的对齐难度】

- 主流的RLHF对齐方法可能难以拓展到更高级的系统,未来的前沿AI可能存在具备态势感知和长期推理的能力,当前的对齐方法多大程度上会因为涌现能力的产生而失效?

- RLHF有哪些的开放问题与根本局限?

- 如何看待欺骗性对齐(Deceptive Alignment)可能带来的挑战?

【生物医药视角】

- 有学者提出前沿大模型可能成为生物安全风险的潜在推动者,能够降低生物滥用的门槛。用于药物发现的AI,也可能用于设计生化武器。此类挑战如何应对?

【演化动力学视角】

- 自然选择会偏向选择适应环境并能取得最大回报的AI系统,然而不一定是对人类最有益的AI系统。此类问题是否有根本解决的方法?

【AI竞赛】

- AI安全问题其中一个根本推手来自于多个AI研发机构的竞争压力。遵循伦理安全的开发者选择谨慎行动,可能会导致落后于竞争对手。因此,AI竞赛有可能导致以牺牲安全为代价,而使机构尽早部署不安全的AI。如何解决这个问题?

参与方式

活动时间

2023年11月25日(本周六)上午 9:00-12:00

线上会议室

扫码报名可以获取活动会议号信息,并了解集智更多其他读书会主题的活动。

线下报名

我们同时也邀请希望更深入的讨论和分享的朋友参与线下的活动,地点是在五道口的MetaSpace咖啡店。

特别鸣谢

大模型与生物医学:

AI + Science第二季读书会启动

生物医学是一个复杂且富有挑战性的领域,涉及到大量的数据处理、模式识别、理论模型建构和实验验证等问题。AI基础模型的引入,使得我们能够从前所未有的角度去观察和理解这个领域的问题,加速科学研究的步伐,提高医疗服务的效率和效果。这种交叉领域的合作,标志着我们正在向科技与生物医学深度融合的新时代迈进,对于推动科学研究、优化医疗服务、促进人类健康有着深远的影响。

集智俱乐部联合西湖大学助理教授吴泰霖、斯坦福大学计算机科学系博士后研究员王瀚宸、博士研究生黄柯鑫、黄倩,华盛顿大学博士研究生屠鑫明,共同发起以“大模型与生物医学”为主题的读书会,共学共研相关文献,探讨基础模型在生物医学等科学领域的应用、影响和展望。读书会从2023年8月20日开始,每周日早上 9:00-11:00 线上举行,持续时间预计8周。欢迎对探索这个激动人心的前沿领域有兴趣的朋友报名参与。

详情请见:

AGI读书会启动

为了深入探讨 AGI 相关话题,集智俱乐部联合集萃深度感知技术研究所所长岳玉涛、麻省理工学院博士沈马成、天普大学博士生徐博文,共同发起 AGI 读书会,涵盖主题包括:智能的定义与度量、智能的原理、大语言模型与信息世界的智能、感知与具身智能、多视角下的人工智能、对齐技术与AGI安全性、AGI时代的未来社会。读书会从2023年9月21日开始,每周四晚上 19:00-21:00,预计持续7-10周。欢迎感兴趣的朋友报名参与!

详情请见:

点击“阅读原文”,报名读书会

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง