点击下方卡片,关注「集智书童」公众号

错误的曝光照片的校正已经被广泛使用深度卷积神经网络或Transformer进行广泛修正。尽管这些方法具有令人鼓舞的表现,但它们通常在高分辨率照片上具有大量的参数数量和沉重的计算浮点运算(FLOPs)。

在本文中,作者提出了一个极轻量级(仅有约8K参数)的多尺度线性变换(MSLT)网络,该网络采用多层感知架构,可以在125帧每秒(FPS)的速度下,使用泰坦RTX GPU处理4K分辨率sRGB图像。

具体来说,提出的MSLT网络首先使用拉普拉斯金字塔技术将输入图像分解为高和低频层,然后依次通过像素自适应线性变换来纠正不同层,这种实现方式是通过高效的双边网格学习或1×1卷积来实现的。在两个基准数据集上的实验表明,作者的MSLT在照片曝光校正方面与最先进的水平相比具有高效性。大量的消融实验验证了作者的贡献的有效性。

代码:https://github.com/Zhou-Yijie/MSLTNet

1 Introduction

智能手机摄像头的普及使人们像摄影师一样捕捉日常生活场景。然而,快门速度、焦距光圈比和/或ISO值设置不准确可能导致捕捉到的照片曝光不正确,视觉质量下降。为了以视觉上可取的方式正确调整照片曝光,对于边缘设备开发高效的曝光校正方法至关重要。

在过去的几十年里,提出了低光增强方法和过曝校正方法来分别调整欠曝和过曝图像的亮度。然而,低光增强方法在矫正过曝图像时几乎无法实现,而过曝校正方法在矫正欠曝图像时则无法正常工作。

高动态范围(HDR)调色映射方法也可以在一定程度上调整内容的不正确曝光,但主要是通过在曝光不正确区域的局部细节增强以及动态范围减少来实现。最后,所有这些方法都不适合曝光校正,因为曝光校正需要在图像中的不正确曝光进行全局调整。

近年来,基于卷积神经网络(CNN)或Transformer的曝光校正方法或也出现了几种。例如,多尺度曝光校正(MSEC)使用拉普拉斯金字塔技术和UNet架构进行层次曝光校正。后来,[48]的工作利用局部颜色分布先验(LCDP)来定位和增强不正确曝光区域。

基于注意力的照明自适应Transformer(IAT)在Transformer架构下估计与图像信号处理器(ISP)相关的参数。尽管这些曝光校正的卷积神经网络或Transformer具有令人鼓舞的表现,但它们通常受到大量参数数量和计算成本的限制。

为了在提高模型效率的同时产生视觉上令人满意的结果,本文提出了一种极轻量级的多尺度线性变换(MSLT)网络,用于高分辨率图像曝光校正。具体来说,作者首先通过拉普拉斯金字塔技术将输入图像分解为高频和低频层,以实现从粗到细的曝光校正。然后作者设计简单的线性变换网络逐步校正这些层,消耗较少的参数数量和计算成本。对于低频层,作者采用双边网格学习(BGL)框架,在不良曝光和正确曝光图像对之间学习像素级仿射变换。

为了在BGL中学习上下文感知的变换系数,作者提出了一种无参数的上下文感知特征分解(CFD)模块,并将其扩展为多尺度仿射变换。对于高频层,作者通过两个通道的1×1卷积层简单地学习像素级校正Mask。

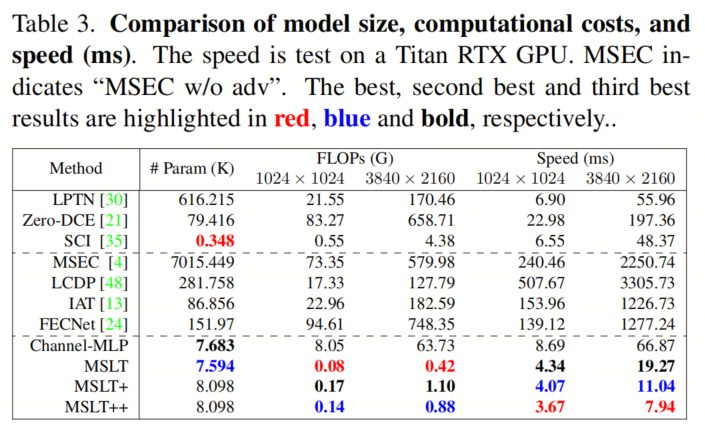

得益于使用多层感知(MLP)进行从粗到细的曝光校正,作者的最大网络MSLT++有8098个参数,只需要0.14G和3.67ms来处理一个的图像,使用RTX GPU。

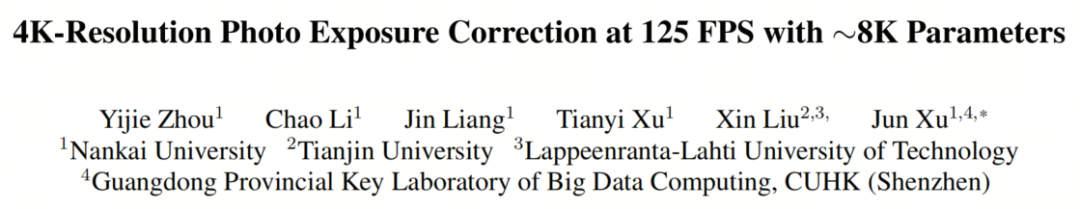

作为比较,基于CNN的MSEC、LCDP和基于Transformer的IAT的参数数量分别为约7015K、约282K和约86.9K,对应的FLOPs/速度分别为73.35G/240.46ms、17.33G/507.67ms和22.96G/153.96ms。在两个基准数据集上的实验表明,作者的MSLTs在定量和定性方面都优于最先进的曝光校正方法。如图1所示,在ME数据集上的性能比较结果。

作者主要的贡献可以总结如下:

- 开发了具有最多8098个参数的多尺度线性变换网络,在运行4K分辨率()图像时,最多可达到125 FPS,并具有有效的曝光校正性能。

- 为了加速多尺度分解,设计了一个双边网格网络(BGN)来像素级校正低频层的曝光。

- 通过使用通道级MLP而不是CNN或Transformer来实现BGN,以赋予作者的MSLTs较小的参数数量和计算成本。

- 提出了一种上下文感知特征分解(CFD)模块,用于在作者的BGN中学习层次变换系数,以实现有效的曝光校正。

2 Related Work

Image Exposure Correction Methods

曝光校正任务类似于低光图像增强、过曝校正和HDR调色映射等任务,但又有不同。据作者所知,MSEC是第一个基于深度学习的曝光校正方法。该方法将图像分解为高频和低频部分,并逐步校正曝光错误。然而,MSEC有超过700万个参数,在高分辨率图像上的效率不足。

Local Color Distributions Prior(LCDP)利用局部颜色分布来统一处理欠曝和过曝,大约有282K个参数,需要巨大的计算成本,17.33G FLOPs,处理一个的图像。基于Transformer的照明自适应Transformer(IAT)有大约86.9K个参数,但在高分辨率图像上存在巨大的计算成本和缓慢的推理速度。

在本文中,作者提出了一种轻量级和高效的Multi-Scale Linear Transformation(MSLT)网络,其参数数量最多为8098个,并且可以在125 FPS的速度下运行,用于校正不正确的4K分辨率图像曝光。

Image Processing MLPs

在卷积神经网络(CNNs)和Transformer的繁荣之前,多层感知(MLPs)在视觉任务中起着重要的作用。MLP为基础的网络再次引起了研究人员注意,因为它们具有简单性。MLP-Mixer是一种纯粹基于MLP的网络,没有卷积或自注意力。后来,ResMLP被提出,它只使用线性层和GELU非线性。gMLP的工作利用具有gating的MLP来实现与Transformer在图像分类上相似的结果。Ding等人提出了一种再参数化技术来提高MLP在图像分类上的能力。最近开发的MAXIM是一种多轴MLP为基础的网络,用于通用图像处理任务。

在本文中,作者开发了一种非常高效的曝光校正网络,该网络主要利用通道MLPs(而不是空间MLPs)来全局感知图像的曝光信息。

Light-weight Image Enhancement Networks

为了追求轻量级和高效的模型,一种简单的方法是将模型应用于低分辨率输入,然后将输出放大到高分辨率。但高频细节会丢失。为此,Laplacian Pyramid分解被用来保留高频信息。另一种方法是学习一个近似算子,并将其应用于下采样输入,然后将这个算子应用于原始图像。这样的近似算子通常简单且高效。后来,这个近似洞察也被研究了,用于加速图像处理方法在图像增强、图像去雾和立体匹配等任务上的应用。

在本文中,作者设计了使用拉普拉斯金字塔技术和双边网格学习框架的轻量级和高效的图像曝光校正网络。与CNN和Transformer不同,作者的双边网格网络纯粹由通道MLP实现,消耗的参数和计算成本比CNN和Transformer少得多。

3 Proposed Method

Network Overview

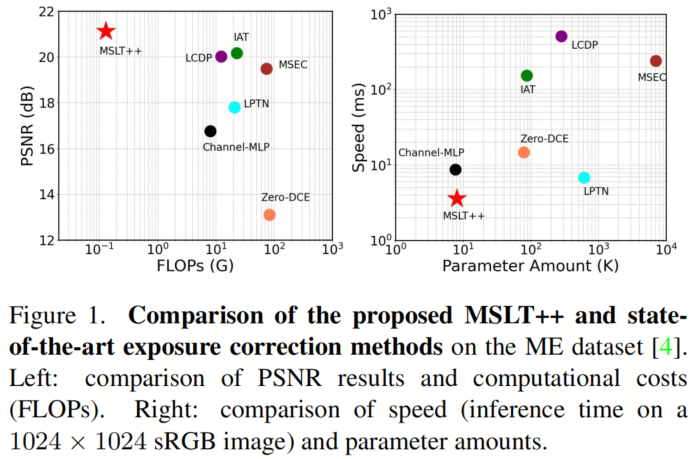

如图2所示,作者的多尺度线性变换(MSLT)曝光校正网络由以下四个紧密相关的部分组成:

多尺度图像分解。正如[4]中所述,从粗到细的结构对于曝光校正任务是有效的。

对于输入图像,作者使用拉普拉斯金字塔技术将其分解为一系列从粗到细的高频层和低频层。

低频层校正是在双边网格学习框架下,学习像素自适应的曝光校正。为了学习有意义的不变对角线网格的仿射系数,作者提出了一种无参数的上下文感知特征分解(CFD)模块,并将其扩展为层次版本以获得更好的性能。

高频层校正是通过每个层像素乘以一个舒适的Mask,该Mask由两个连续的卷积预测得到。

最终重构是在不同频率的曝光校正层上应用拉普拉斯重构,输出一个曝光良好的。

Low-Frequency Layer Correction

照明信息主要存在于低频中,因此作者更关注低频层的有效曝光校正。受到在高效图像处理上的成功启发,作者采用双边网格学习来校正低频层的曝光。

如图2所示,作者的双边网格网络包含三个部分:

- 学习引导图;

- 估计仿射系数的双边网格;

- 系数变换。

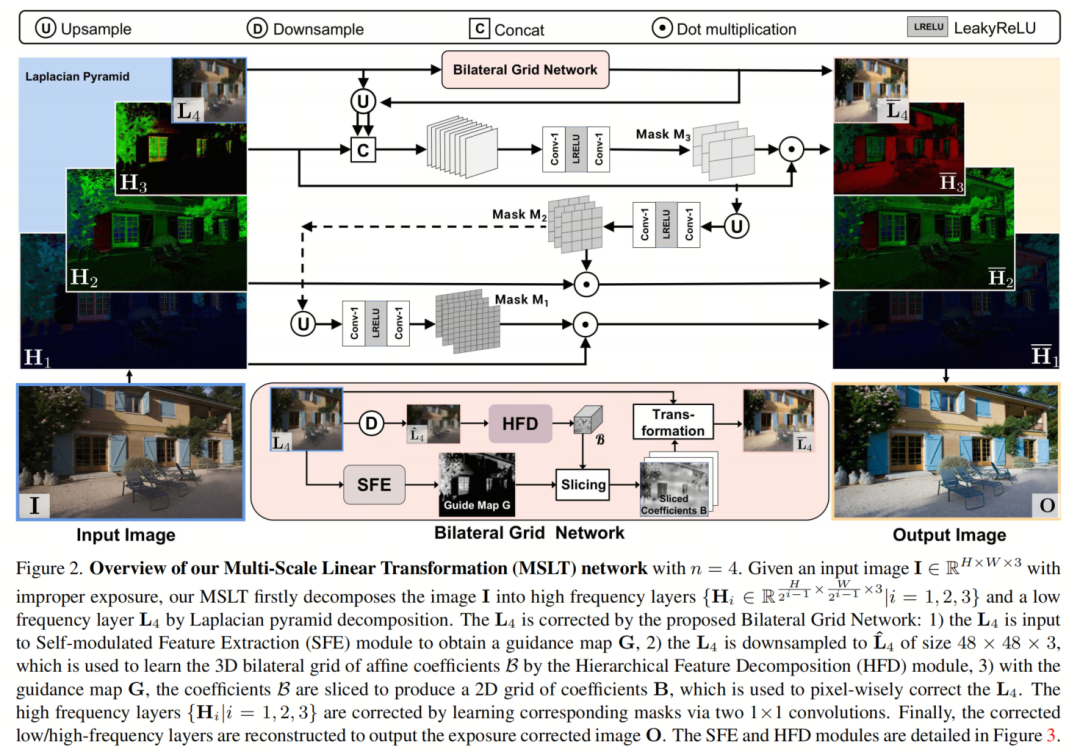

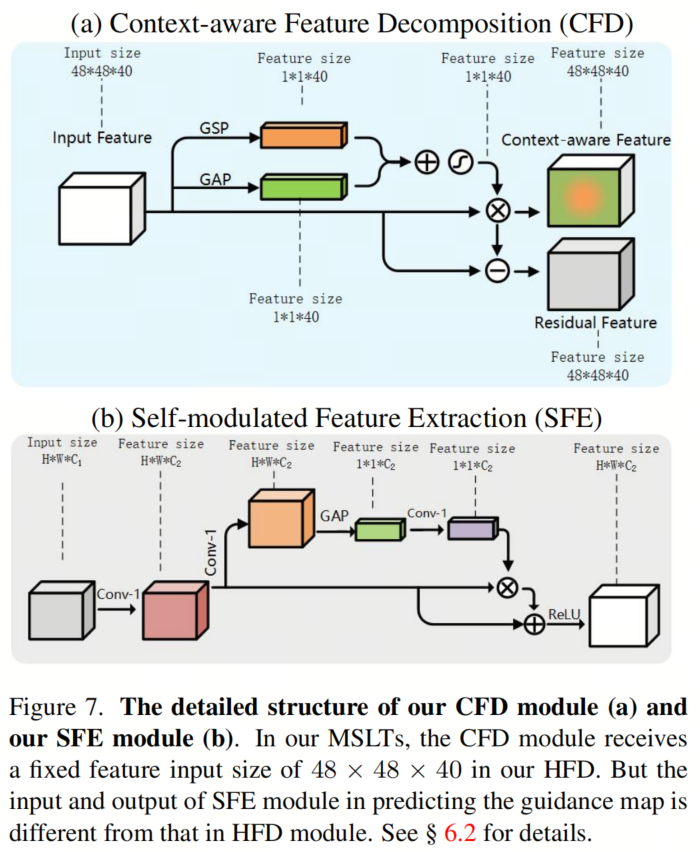

学习引导图。作者提出一个自调制特征提取(SFE)模块来学习与大小相同的引导图。如图3(b)所示,SFE模块使用两个卷积和全局平均池化(GAP)来调节提取的特征图。

估计仿射系数双边网格。作者首先将低频层下采样到和,然后对特征图进行归一化,得到和。

然后,作者对特征图进行归一化,得到和,再对特征图进行归一化,得到和。

。每个通道的平均值(mean)和标准差(std)大致反映了特征图的亮度和对比度,利用这些信息可以用来估计曝光校正的双边网格仿射系数。为此,作者提出一个无参数的上下文感知特征分解(CFD)模块来提取上下文感知特征和残差特征。

如图3(a)所示,上下文感知特征是通过将原始特征通道乘以全局平均池化和全局标准池化计算的平均值和标准差得到的。作者将CFD扩展为一个层次化的特征分解(HFD)模块,通过将三个共享参数的CFD和SFE模块堆叠在一起,如图3(c)所示。

目标是学习一个16x16x72的仿射系数3D双边网格,其中每个12个通道表示一个3×4仿射矩阵。作者通过通道级的1×1卷积来实现层次化的特征分解(HFD)模块,以进行空间一致性和像素自适应亮度调整。在ReLU之前,三个共享参数的1×1卷积(如图3(c)所示),具有较少的参数数量和计算成本。

系数变换。作者使用引导图将3D双边网格的仿射系数上采样到2D双边网格的系数,并通过三线性插值[11]校正低频层。

网格中的每个单元格包含一个3×4矩阵用于像素自适应仿射变换。最后,中的仿射变换将逐像素地作用于低频层,以获得曝光校正的低频层。

High-Frequency Layers Correction

有了校正后的低频层,现在作者按照从到1的顺序校正高频率层。校正通过将每个高频率层与一个舒适的Mask元素相乘来实现。每个Mask都由一个包含两个卷积层(它们之间有一个LeakyReLU)的小MLP预测。

为了校正高频层,作者首先将它与上采样低频层和上采样校正层沿着通道维度进行拼接。然后,将拼接的层输入到小MLP中,以预测Mask。

由于拼接的层有9个通道,作者将小MLP中的第一个卷积层输入和输出通道都设置为9,而第二个卷积层的输入和输出通道分别设置为9和3。通过逐元素地与Mask相乘,作者得到曝光校正的高频层。此外,预测的Mask将被用作下一个高频层校正的输入,用于Mask预测。

对于,作者将上一层输出的Mask上采样到当前层的MLP中,以预测一个新的Mask。与预测的MLP不同,预测的MLP具有两个输入和两个输出通道,由两个卷积层组成。类似地,每个Mask都逐元素地与高频层相乘,以输出曝光校正的高频层。最后,作者从曝光校正的低频/高频层中重构输出图像。在这里,作者为作者的MSLT设置。

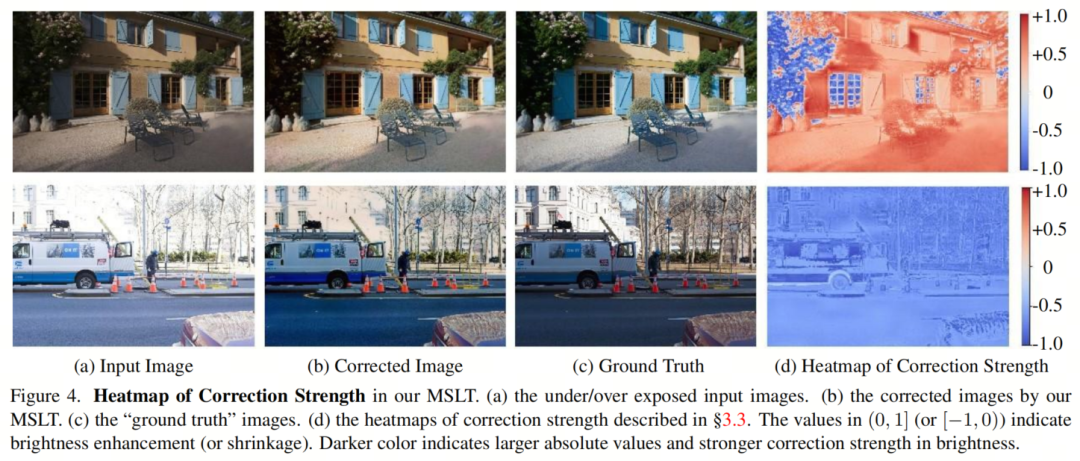

为了研究作者的MSLT对曝光校正的影响,作者将输入图像和输出图像从sRGB颜色空间转换到CIELAB颜色空间。作者分别将和的亮度通道表示为和。分别表示为和,并计算它们的差值残差。作者将归一化到,即,以表示像素级的校正强度,其中(或)表示亮度增强(或缩小)。

如图4所示的校正强度热图与输入图像的上下文密切相关。这表明作者的MSLT确实实现了像素自适应的曝光校正。

Network Acceleration

所提出的MSLT网络通过使用标准高斯核实现Laplacian金字塔分解,而当前的深度学习框架并未对其进行优化。为了加速作者的MSLT,作者将高斯核替换为可学习的卷积核,该核由PyTorch框架高度优化。通过将卷积核引入到作者的MSLT中,作者破坏了其完全MLP架构,该架构具有更多的参数和计算成本。

从实验结果可以看出,作者的MSLT在 sRGB图像上的速度从4.34ms提高到4.07ms,在 sRGB图像上的速度从19.27ms提高到11.04ms。作者将这个变体网络称为MSLT+。作者还观察到,可学习的卷积核可以对每个图像进行自适应分解,以更好地校正不同层的曝光。

考虑到高频层具有所有层中最大的分辨率和最精细的信息,研究是否可以避免对这一层的校正以进一步提高模型速度是有价值的。事实上,即使不对进行校正,MSLT+中的可学习卷积核仍然可以产生自适应Laplacian金字塔分解,以补偿整体曝光校正性能。

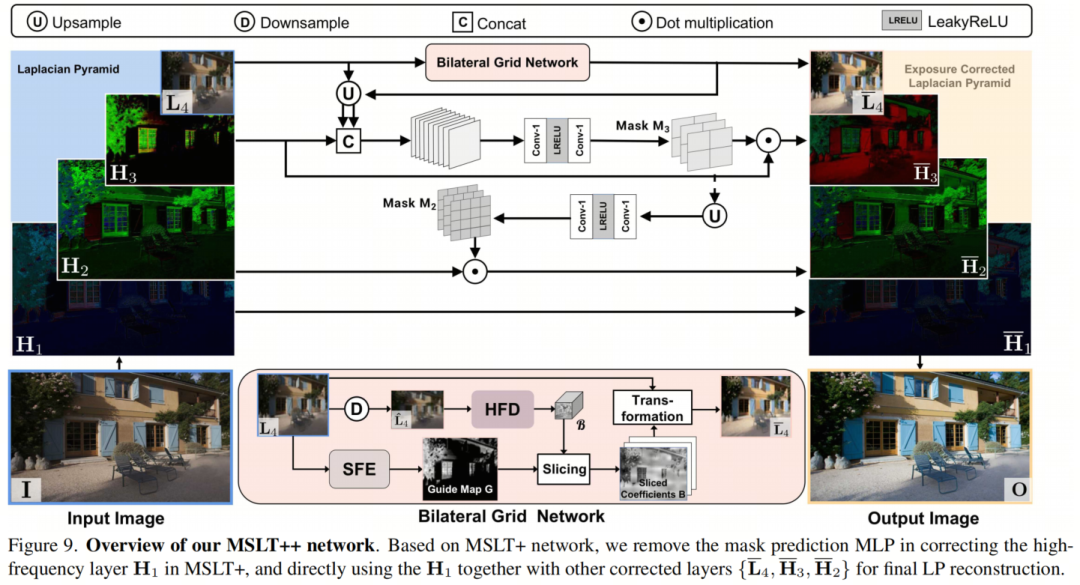

为了说明这一点,作者在MSLT+中删除了校正高频层的Mask预测MLP,并直接使用以及已校正的其他层进行最终重构。作者将这个变体网络称为MSLT++。

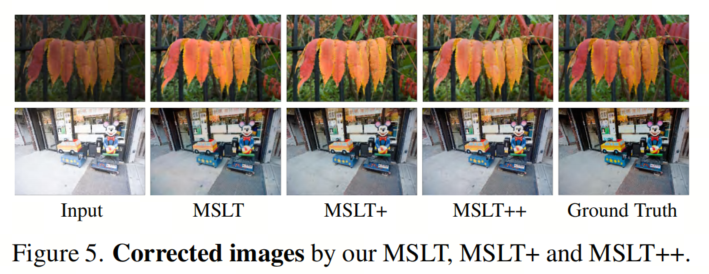

如图5所示,在两张欠曝和过曝图像上,作者观察到MSLT、MSLT+和MSLT++校正后的图像具有相似的视觉质量。这表明,删除高频层的校正可能对作者MSLT++在曝光校正方面的影响很小,同时带来额外的计算成本和推理时间的减少。例如,作者的MSLT++将MSLT+在 sRGB图像上的速度从4.07ms提高到3.67ms,在(4K)sRGB图像上的速度从11.04ms提高到7.94ms。

Implementation Details

作者的MSLT网络使用Adam[26]优化,其中=0.9,=0.999,使用均方误差(MSE)损失函数。初始学习率设置为,并使用余弦退火计划从衰减到0,每5个Epoch进行一次。批量大小为32。对于训练集,作者将图像随机裁剪成512512的块。

在这里,作者使用4个Laplacian金字塔层,将6464的低频层下采样到4848,以便学习精确的3D双边网格的仿射系数。作者的MSLT网络由PyTorch和MindSpore实现,在Titan RTX GPU上训练200个Epoch,大约需要18小时。

4 Experiments

Dataset and Metric

数据集。作者在两个基准数据集上评估作者的MSLT网络:ME数据集和SICE数据集。

ME数据集。该数据集基于MIT-Adobe FiveK数据集,其中每个原始sRGB图像通过五个相对曝光值{-1.5,-1,0,+1,+1.5}渲染,以模拟不正确的曝光图像。五名专家摄影师(A-E)手动修复了原始sRGB图像,生成了正确曝光的图像(”GT值”)。作者使用专家C修复的图像作为训练目标。该数据集包含17,675个训练图像,750个验证图像和5,905个测试图像。

SICE数据集。该数据集随机划分为412、44和100个序列作为训练、验证和测试集。作者按照[23]的建议,将每个序列的第二和最后一个第二图像设为欠曝或过曝输入。对于训练集中的每个图像,作者随机裁剪30个大小为的块进行训练。

评估指标。作者使用三个评估指标:峰值信噪比(PSNR)、结构相似性指数(SSIM)和学习的感知图像块相似性(LPIPS)来测量曝光校正图像与”GT值”之间的距离。对于LPIPS,作者使用AlexNet来提取特征图。

Comparison Results

作者将作者的MSLT与四种曝光校正方法(MSEC,LCDP,FECNet和IAT,两种增强方法(Zero-DCE和SCI,以及一种图像转换方法(LPTN进行比较。为了验证作者的MSLTs设计,作者还将与具有7,683参数的简单通道MLP进行比较(更多详细信息见补充文件)。

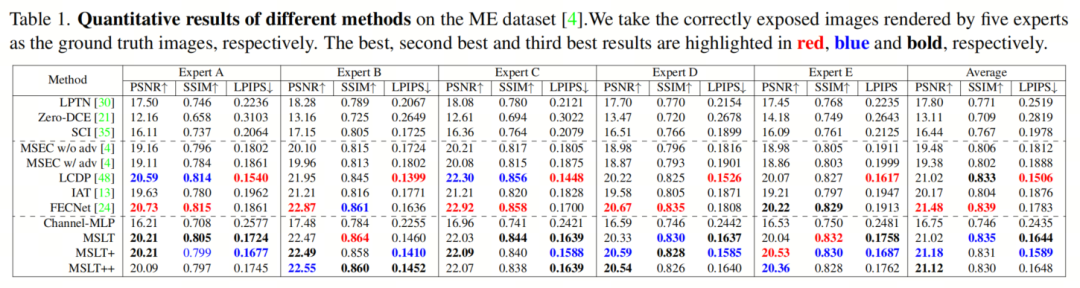

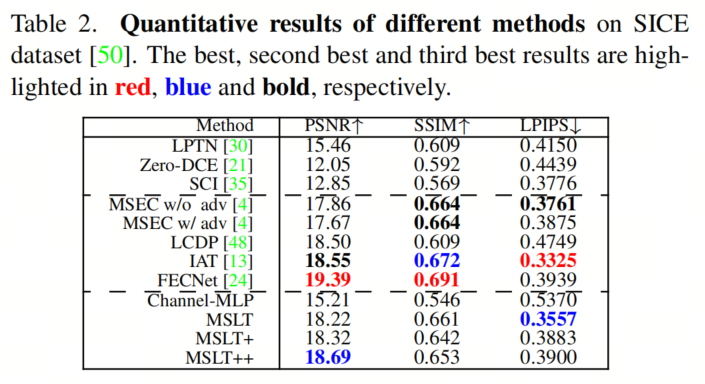

目标结果。对于ME和SICE数据集,如表1和表2所示,作者的MSLTs在PSNR,SSIM和LPIPS方面都优于LPTN,Zero-DCE,SCI和Channel-MLP。在ME上,作者的MSLTs比MSEC和IAT取得更好的结果,与LCDP和FECNet相当。

在SICE上,作者的MSLTs与MSECs具有可比性能,但比IAT和FECNet稍逊一筹。然而,作者的MSLTs在效率方面优于所有比较方法,如表3所示。

速度。为了实际应用,作者提出了对模型推理速度的高要求。为了衡量模型速度,作者随机生成一个大小为或的”图像”,重复推理测试100次,并平均结果作为比较方法的速度。所有速度测试都在Titan RTX GPU上运行。结果如表3所示。

可以看出,在作者的MSLT++在张量上的推理速度为3.67 ms,比所有其他方法都要快得多。在作者的高分辨率张量上,作者的MSLT++达到推理速度7.94 ms,也比其他比较方法快。

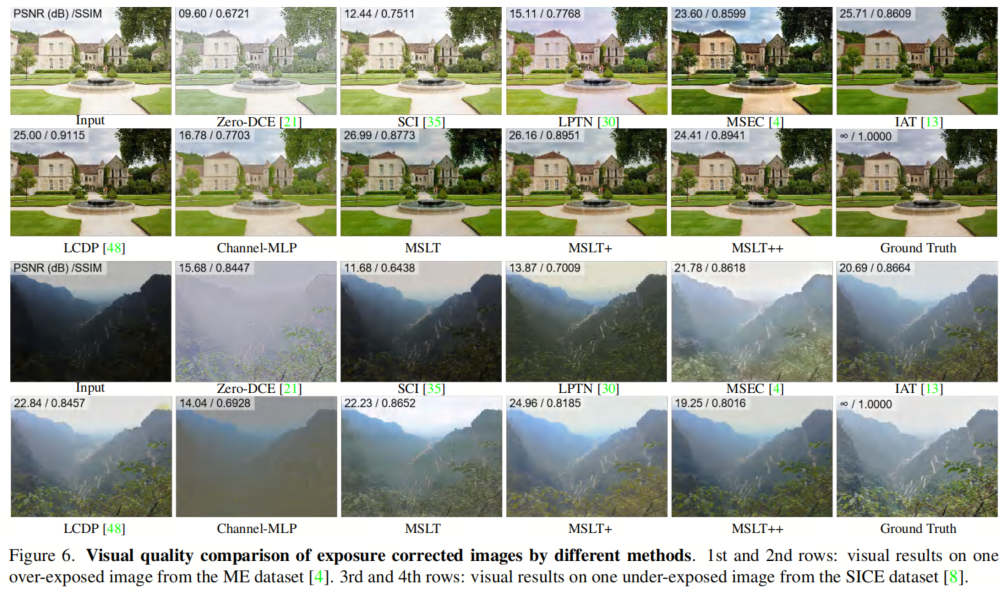

图像质量。曝光校正任务的最终目标是恢复更真实的图像并提高观察者的视觉体验,因此图像质量也是考虑的重要因素。

在图6中,作者提供了ME数据集中的”Manor”和SICE数据集中的”Mountain”的校正图像,分别由比较方法生成。更多视觉比较结果可参见补充文件。

在过曝的”Manor”图像上,可以看出Zero-DCE,SCI,LPTN和Channel-MLP很难减弱曝光。作者的MSLTs在云、墙壁和草坪的细节上比LCDP和IAT更好。校正后的MSEC图像对比度过高,不够真实。在欠曝的”Mountain”图像上,作者的MSLTs在整体亮度和绿叶细节方面都优于其他方法。

Ablation Study

在这里,作者提供关于作者的MSLT在曝光校正方面的详细实验,以研究:

- MSLT中的Laplacian金字塔层数量

- 如何设计上下文感知特征分解(CFD)模块

- HFD中的CFD模块数量

- 如何开发双边网格网络中的层次特征分解(HFD)模块

- 高频层校正如何影响作者的MSLT和MSLT+

所有实验都在ME数据集上进行。五个专家修复的图像被分别认为是”GT值”图像,用于计算平均PSNR,SSIM和LPIPS值。作者在10241024 sRGB图像上计算FLOPs和速度。带有轻阴影的行表示作者的MSLT网络在曝光校正方面的结果。

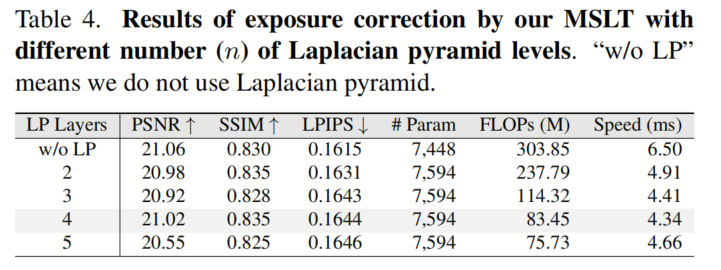

1)在作者的MSLT中,Laplacian金字塔(LP)层的数量。作者将在MSLT网络中部署Laplacian金字塔结构以降低计算成本和推理时间(速度)。

如表4所示,通常情况下,具有更多层的Laplacian金字塔会产生较小的低频层。由于主要成本都支付给这一层,作者的MSLT将更快。然而,当LP层数为5时,低频层较小,这降低了作者的MSLT网络。此外,5层LP分解抵消了整体加速,使作者的MSLT在曝光校正方面的速度变慢。考虑到作者的MSLT的性能和推理速度,作者在MSLT网络中的LP分解中设置n=4。

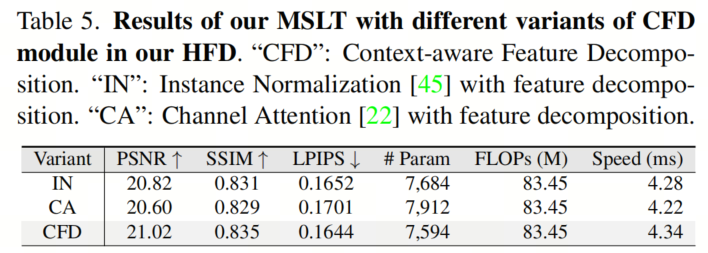

2)如何设计上下文感知特征分解(CFD)模块?在作者的CFD中,作者使用每个通道的平均值和标准差来学习上下文感知特征。为了展示其效果,作者将这部分替换为实例归一化(IN)或通道注意力(CA),并保持作者的MSLT其余部分。

如表5所示,作者的CFD在三种方法中实现了最高的PSNR和LPIPS,并与“IN”版本具有可比的SSIM。这表明使用每个通道的平均值和标准差信息的方法是有效的。

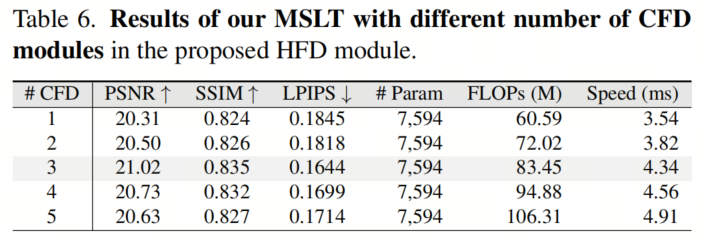

3) HFD中的CFD模块数量。为了更好地学习仿射系数双边网格,作者将上下文感知特征分解(CFD)模块扩展为层次结构。作为比较,作者将不同的CFD模块数量作为层次特征分解(HFD)的组成部分。

从表6可以看出,当HFD中的CFD模块数量从1增加到5时,作者的MSLT性能提高,然后降低,达到最佳结果需要三个CFD。这表明上下文转换的多模块增强。然而,提取冗余特征没有必要使用太多CFD模块。因此,在作者的HFD模块中,作者使用了三个CFD模块。

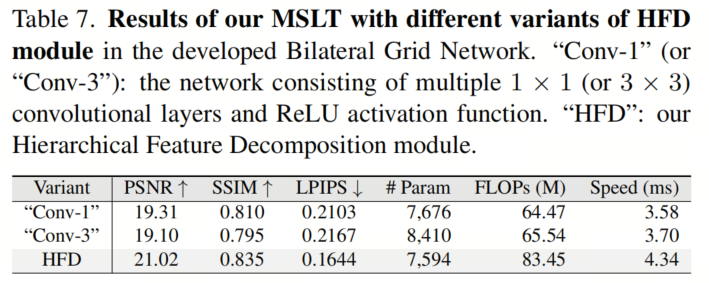

4)如何开发双边网格网络中的层次特征分解(HFD)模块?为了回答这个问题,作者应用了与作者的HFD模块具有可比参数的各种网络进行实验。为了便于展示,作者将包含多个卷积层和ReLU激活层的网络称为”卷积-1″。同样,当只使用卷积时,网络被称为”卷积-3″。

如表7所示,尽管”卷积-1″和”卷积-3″也实现了快速速度,但作者的MSLT与HFD在PSNR,SSIM和LPIPS方面实现了更好的定量结果。这表明作者的HFD模块很好地估计了用于曝光校正的3D双边网格的仿射系数。

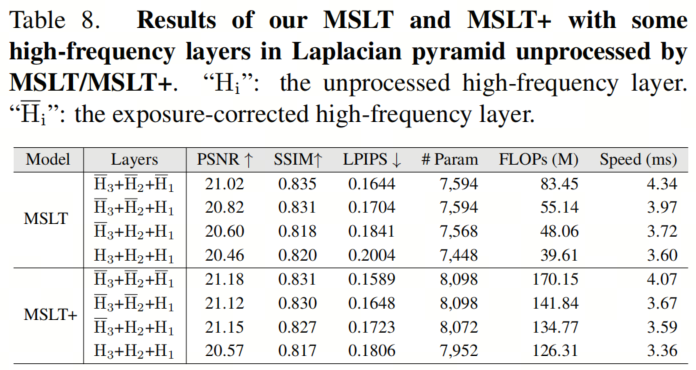

5) 高频层校正如何影响作者的MSLT和MSLT+?为了回答这个问题,作者对MSLT和MSLT+使用部分而不是全部校正的高频层进行LP重构。具体来说,作者的实验设置如表8所示。表示作者使用校正的高频层进行LP重构。这些高频层用于与一起进行LP重构。

类似地,表示作者直接使用未经处理的高频层进行LP重构。如表8所示,从++到++,作者明显降低了作者的MSLT和MSLT+的FLOPs和推理时间(速度),对目标指标的影响很小。

在作者的MSLT+中,由可学习的卷积生成,可以部分补偿不处理的影响。这就是为什么作者的加速策略对MSLT+的目标结果影响很小。所有这些结果表明,作者应用在MSLT+上的加速策略对目标指标影响很小,但可以明显降低计算成本和推理速度。

5 Appendix

Detailed implementation of Laplacian Pyramid (LP) decomposition and reconstruction

在作者的MSLT中,作者使用传统的Gaussian核进行Laplacian Pyramid(LP)分解和重构。在分解阶段,作者首先使用一个固定的 Gaussian核(等式1)对输入图像进行卷积,步长=2,填充=2,以获得。然后,作者对(,注意在作者的MSLTs中)执行相同的卷积操作,以生成。

首先,作者得到Laplacian金字塔序列,然后通过在每两行和每两列之间插入舒适的全零向量,上采样Gaussian金字塔(),得到Laplacian金字塔的high-frequency层。上采样操作通过卷积与Gaussian核(等式1)进行,然后从中减去。

对于,作者直接将视为低频层。这样,作者得到了Laplacian金字塔和。在重构阶段,对于处理过的Laplacian金字塔中的每一层,作者使用相同的上采样方法,并将结果加到上一层。最后,作者得到重构图像。

在作者的MSLT+和MSLT++中,作者引入可学习的卷积核,步长为2用于Laplacian金字塔分解中的下采样,以及步长为1的卷积核 followed by 双线性插值用于Laplacian金字塔重构中的上采样。

Channel dimension of the features in our SFE module

对于作者的自适应特征提取(SFE)模块,如图7(b)所示,作者描述了SFE模块的特定输入和输出通道数量,该模块用于在作者的双边网格网络中预测引导图以及在作者的层次特征分解(HFD)模块中进行特征提取,如图1和2在主论文中。

对于引导图预测,通道数和分别为3和8,为了生成灰度引导图,作者在SFE的最后阶段从8个通道减至1个通道进行1×1卷积。在作者的HFD中进行特征提取时,和都等于40。

Details of coefficient transformation in our bilateral grid network

在作者的MSLT中,作者详细说明双边网格网络中的系数变换。作者使用仿射变换系数3D双边网格和引导图进行切片。作者使用三线性插值计算一个2D系数网格,该网格使用和来自网格的像素位置进行计算。

其中,是线性插值核,和是网格的空间形状。作者将和固定为16,并将的深度设置为。网格中的每个单元格包含12个通道。对于低频层中的每个像素,作者将该像素在网格中对应的第一到第三通道的RGB值与该像素的第四通道值相乘并求和,再加上偏置得到像素的校正R通道值。同样地,该像素的G和B通道也进行校正。

More details of high-frequency layers correction

对于高频层的处理,作者使用一个小MLP,由两个1×1卷积层组成,中间有一个LeakyReLU。对于高频层,在预测Mask时,输入是一个9通道的特征图,由,上采样低频层和上采样校正低频层沿通道维度拼接而成。

所以作者将输入和输出通道数都设置为第一个1×1卷积层的首个通道数为9,第二个1×1卷积层的首个通道数为9和3,分别对应输入和输出的通道数。对于其他每个高频层(),作者将输入和输出通道数都设置为两个1×1卷积层的首个通道数为3,用于预测Mask。

此外,在作者的MSLT++网络中,作者直接使用高频层进行Laplacian金字塔重构,而不是经过高频层校正处理的高频层,以加速推理速度。MSLT++的具体结构如图9所示。

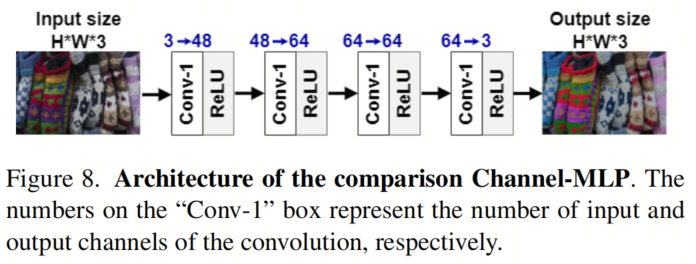

Architecture of the Channel-MLP network in our main paper

为了减少参数数量和计算成本,作者在作者的MSLT中广泛使用通道MLP。与MLPs相比,作者在主论文中的表1-3和图6中设计了一个简单的Channel-MLP网络,用于进行曝光校正。

如图8所示,该简单的Channel-MLP网络包含四个连续的1×1卷积层,每个层后跟一个ReLU激活层。

More Ablation Studies

在本节中,作者提供更多实验结果来研究:

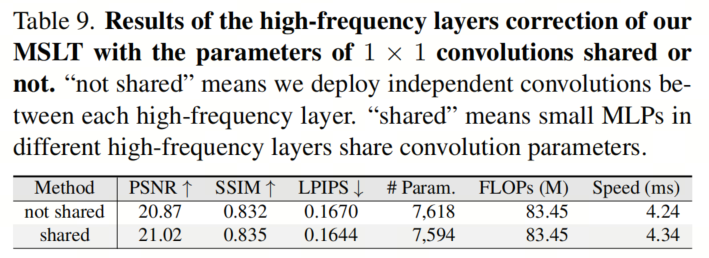

- 高频层校正中参数共享如何影响MSLT性能?

- GAP和GSP如何影响作者的CFD模块?

- 如何在HFD模块中设计使用SFE模块?

- CFD模块中特征分离顺序的影响。

1) 高频层校正中参数共享如何影响作者的MSLT性能?在高频层校正中,作者使用由两个1×1卷积层组成的小MLP来预测Mask。如SS 6.4所述,用于预测的卷积具有3个输入和输出通道。

因此,作者设计了一个比较实验,研究高频层校正中使用的小MLP是否共享参数。如表9所示,高频层校正中使用的小MLP是否共享参数对作者的MSLT性能影响很小。对于较少的参数,作者选择在作者的MSLT中共享参数。

实现了最佳数值结果,而单GAP的表现优于单GSP。这表明在作者的CFD模块中添加每个通道的均值和标准差确实是有效的。此外,均值起着主要作用。

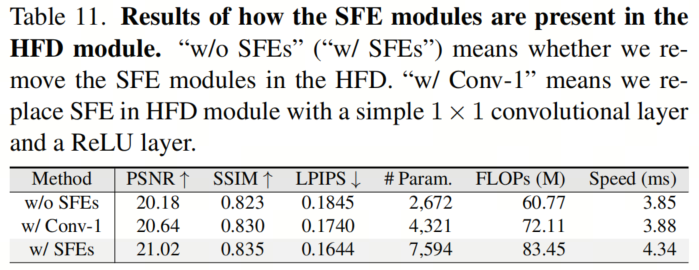

3) 如何设计和使用SFE模块在HFD中?。为了研究这个问题,作者在HFD中移除SFE模块或者只保留一个卷积和ReLU在SFE,分别表示为”不含SFE模块”和”含卷积1″。

如表11所示,虽然移除SFE模块或其中的一部分可以减少参数和计算成本,但PSNR,SSIM和LPIPS的性能不如保留作者的SFE模块。

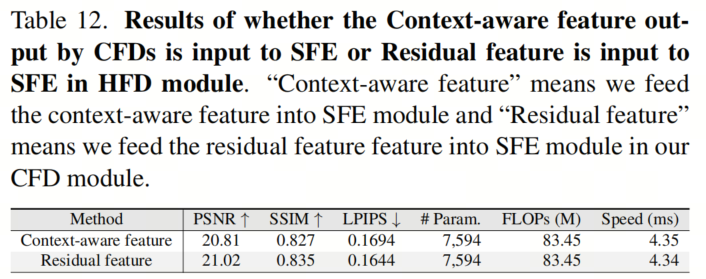

4) 特征分解顺序的影响。作者的CFD模块通过特征减法将上下文感知特征和残差特征进行分解。在这里,作者对比了将上下文感知特征或残差特征作为下一个SFE模块的输入的情况。

如表12所示,当SFE模块接收到上下文感知特征或残差特征时,作者的模型表现相当。得出结论,CFD模块中的特征分解顺序不会影响HFD模块的性能。

More visual comparisons of our MSLT with the other comparison methods

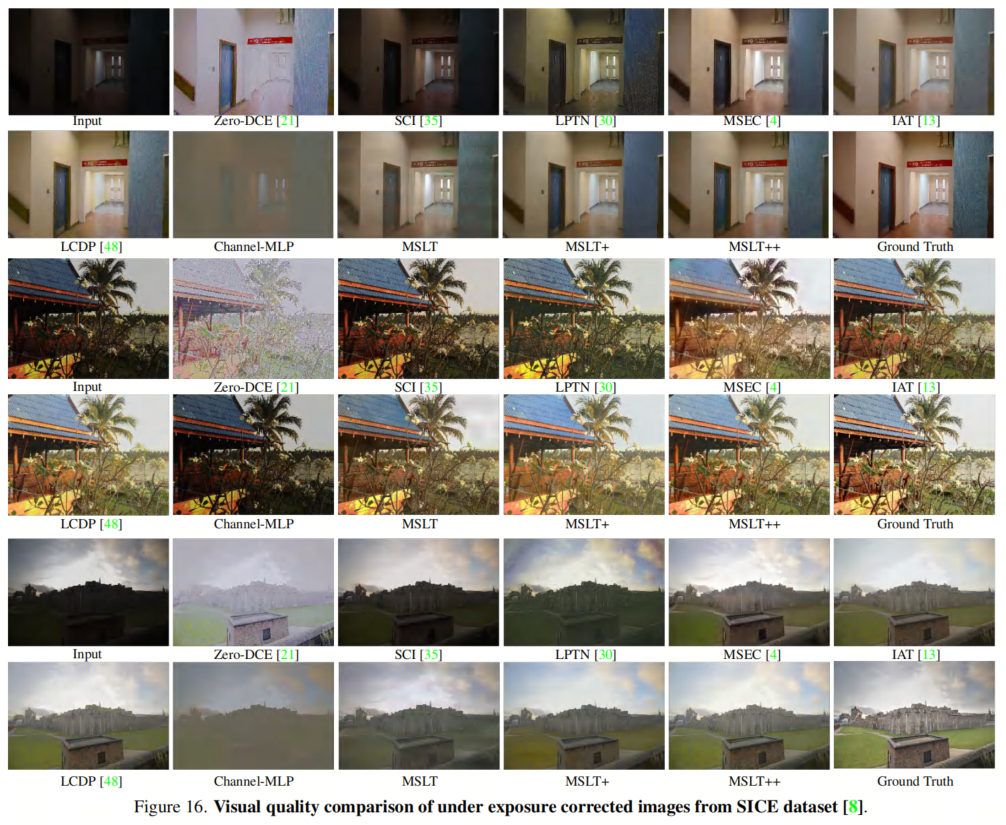

在这里,作者在ME数据集和SICE数据集上呈现与其他竞争方法进行更多视觉比较的结果。对于ME数据集,作者在每个相对曝光值{-1.5,-1,0,+1,+1.5}下呈现了两组比较图像,分别如图11所示。

对于SICE数据集,作者在过曝和欠曝输入下各呈现了三组比较图像,分别如图16所示。

所有这些结果都表明,作者的MSLT网络(MSLT,MSLT+和MSLT++)在曝光校正后的图像上达到可比或甚至优于具有较大参数数量和计算成本的竞争方法。

6 Conclusion

在本文中,作者提出了一种轻量级和高效的Multi-Scale Linear Transformation(MSLT)网络用于曝光校正。所提出的MSLT网络依次校正由Laplacian金字塔技术分解的多尺度低/高频率层。对于低频层,作者开发了一个双边网格网络来学习上下文感知仿射变换以进行像素自适应校正。

高频层按元素逐个方式乘以由通道MLP学习的舒适Mask。作者还通过可学习的多尺度分解和移除最大高频层校正加速了作者的MSLT。所得的MSLT++网络有8098个参数,在仅0.88G FLOPs的情况下,可以以125 FPS的速度处理4K分辨率图像。实验结果表明,作者的MSLT网络非常高效,并展现出良好的曝光校正性能。

参考

[1].4K-Resolution Photo Exposure Correction at 125 FPS with ∼8K Parameters.

扫码加入👉「集智书童」交流群

(备注:方向+学校/公司+昵称)

想要了解更多:

想要了解更多:

前沿AI视觉感知全栈知识👉「分类、检测、分割、关键点、车道线检测、3D视觉(分割、检测)、多模态、目标跟踪、NerF」

行业技术方案👉「AI安防、AI医疗、AI自动驾驶」AI模型部署落地实战👉「CUDA、TensorRT、NCNN、OpenVINO、MNN、ONNXRuntime以及地平线框架」

欢迎扫描上方二维码,加入「集智书童-知识星球」,日常分享论文、学习笔记、问题解决方案、部署方案以及全栈式答疑,期待交流!

免责声明凡本公众号注明“来源:XXX(非集智书童)”的作品,均转载自其它媒体,版权归原作者所有,如有侵权请联系我们删除,谢谢。

点击下方“阅读原文”,了解更多AI学习路上的「武功秘籍」

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง